AIエージェントメモリ

メモリにより、AI エージェントは会話の前の部分や以前の会話の情報を記憶できます。これにより、エージェントはコンテキストに応じた応答を提供し、時間の経過とともにパーソナライズされたエクスペリエンスを構築できるようになります。フルマネージド Postgres OLTP データベースであるDatabricks Lakebase を使用して、会話の状態と履歴を管理します。

要件

- ワークスペースでDatabricks Apps有効にします。 Databricks Appsワークスペースと開発環境をセットアップするを参照してください。

- Lakebase インスタンスについては、 「データベース インスタンスの作成と管理」を参照してください。

短期記憶と長期記憶

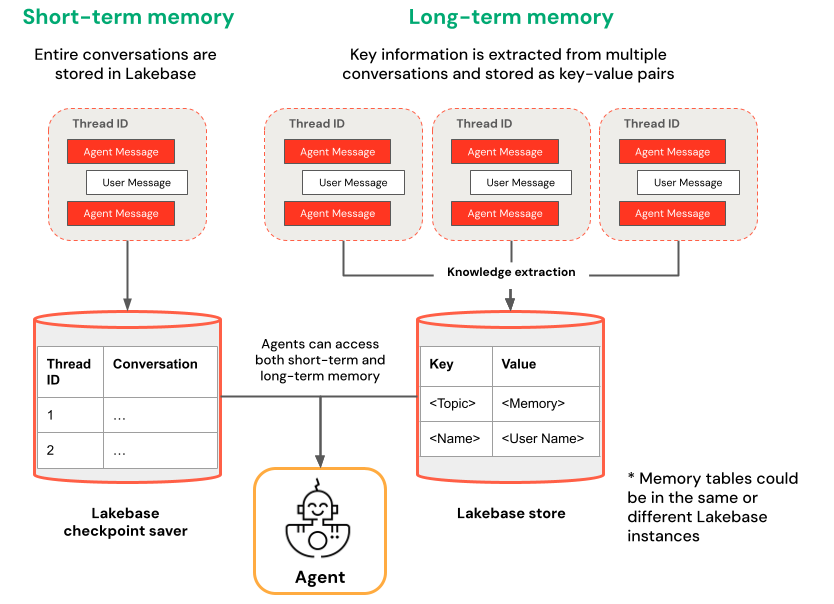

短期記憶は単一の会話セッション内のコンテキストをキャプチャしますが、長期記憶は複数の会話にわたる重要な情報を抽出して保存します。どちらか一方または両方のタイプのメモリを使用してエージェントを構築できます。

短期記憶 | 長期記憶 |

|---|---|

スレッドIDとチェックポイントを使用して、単一の会話セッションでコンテキストをキャプチャします。 セッション中のフォローアップの質問の文脈を維持する | 複数のセッションにわたって重要な知識を自動的に抽出して保存 過去の好みに基づいてやり取りをパーソナライズする 時間の経過とともに応答を改善するユーザーに関する知識ベースを構築する |

始めましょう

Databricks Appsでメモリを備えたエージェントを作成するには、事前に構築されたアプリ テンプレートを複製し、 「 AIエージェントを作成してアプリにデプロイする」で説明されている開発ワークフローに従います。 次のテンプレートは、一般的なフレームワークを使用してエージェントに短期および長期のメモリを追加する方法を示しています。

LangGraph

次の LangGraph ベースのテンプレートを使用して、エージェントにメモリを追加します。これらのテンプレートは、永続的な状態管理のために、Lakebase を使用した LangGraph の組み込みチェックポイントを使用します。

-

短期記憶 : agent-langgraph-short-term-memoryテンプレートを複製して、セッション内の会話コンテキストを維持する LangGraph エージェントを構築します。テンプレートは、スレッド ID と、Lakebase に裏打ちされた LangGraph チェックポイントを使用して会話の状態を保持します。

Bashgit clone https://github.com/databricks/app-templates.git

cd app-templates/agent-langgraph-short-term-memory -

長期記憶 : agent-langgraph-long-term-memoryテンプレートを複製して、複数の会話にわたる重要な情報を記憶する LangGraph エージェントを構築します。テンプレートは、ユーザーの知見を自動的に抽出して Lakebase に保存し、時間の経過とともにパーソナライズされたインタラクションを可能にします。

Bashgit clone https://github.com/databricks/app-templates.git

cd app-templates/agent-langgraph-long-term-memory

OpenAI エージェント SDK

エージェントにメモリを追加するには、次の OpenAI Agents SDK ベースのテンプレートを使用します。このテンプレートは、永続的な状態管理のために Lakebase との OpenAI Agents SDK セッションを使用します。

-

短期記憶 : agent-openai-agents-sdk-short-term-memoryテンプレートを複製し、自動会話履歴管理機能を備えた OpenAI Agents SDK を使用してエージェントを構築します。テンプレートはセッション データを Lakebase に保持し、手動でメモリを処理することなくステートフルなマルチターンの会話を可能にします。

Bashgit clone https://github.com/databricks/app-templates.git

cd app-templates/agent-openai-agents-sdk-short-term-memory

エージェントをデプロイしてクエリする

エージェントにメモリを構成したら、 「 AIエージェントを作成してアプリにデプロイする」の手順に従ってエージェントをローカルで実行し、評価して、 Databricks Appsにデプロイします。