コンピュートの管理

Lakebase オートスケールは次のリージョンで利用できます: us-east-1 、 us-east-2 、 us-west-2 、 eu-central-1 、 eu-west-1 、 ap-south-1 、 ap-southeast-1 、 ap-southeast-2 。

Lakebase オートスケールは、オートスケール コンピュート、ゼロへのスケール、分岐、即時復元を備えた Lakebase の最新バージョンです。 Lakebase プロビジョニングとの機能の比較については、 「バージョン間の選択」を参照してください。

コンピュートは、Lakebase プロジェクト用に Postgres を実行する仮想化サービスです。 各ブランチには 1 つのプライマリ (読み取り/書き込み) コンピュートがあります。 ブランチに接続してそのデータにアクセスするには、コンピュートが必要です。

コンピュートを理解する

コンピュートの概要

コンピュート リソースは、クエリの実行、接続の管理、データベース操作の処理に必要な処理能力とメモリを提供します。 各プロジェクトには、そのデフォルトブランチ用のプライマリ読み取り/書き込みコンピュートがあります。

ブランチ内のデータベースに接続するには、そのブランチに関連付けられたコンピュートを使用する必要があります。 コンピュートが大きいほど、同じアクティブ時間内でコンピュートが小さい場合よりも多くのコンピュート時間を消費します。

コンピュートのサイジング

利用可能なコンピュート サイズ

Lakebase Postgres は、次のコンピュート サイズをサポートしています。

- オートスケールコンピュート : 0.5 CU ~ 32 CU (0.5、その後整数増分: 1、2、3...16、その後 24、28、32)

- より大きな固定サイズのコンピュート : 36 CU ~ 112 CU (36、40、44、48、52、56、60、64、72、80、88、96、104、112)

コンピュートユニットには何が含まれていますか?

各コンピュート ユニット (CU) は、関連するすべての CPU およびローカルSSDリソースとともに、約 2 GB の RAM をデータベース インスタンスに割り当てます。 スケールアップすると、これらのリソースは直線的に増加します。Postgres は割り当てられたメモリを複数のコンポーネントに分散します。

- データベースキャッシュ

- ワーカーの記憶

- 固定メモリ要件を持つその他のプロセス

パフォーマンスはデータ サイズとクエリの複雑さによって異なります。スケーリングする前に、クエリをテストして最適化します。ストレージは自動的に拡張されます。

Lakebase プロビジョニングとオートスケール : Lakebase プロビジョニングでは、各コンピュート ユニットに約 16 GB の RAM が割り当てられました。 Lakebase オートスケールでは、各 CU に 2 GB の RAM が割り当てられます。 この変更により、よりきめ細かいスケーリング オプションとコスト管理が可能になります。

コンピュート仕様

コンピュート単位 | ラム | 最大接続数 |

|---|---|---|

0.5 CU | 約1GB | 104 |

1 CU | 約2GB | 209 |

2 CU | 約4GB | 419 |

3 CU | 約6GB | 629 |

4 CU | 約8GB | 839 |

5 CU | 約10GB | 1049 |

6 CU | 約12GB | 1258 |

7 CU | 約14GB | 1468 |

8 CU | 約16GB | 1678 |

9 CU | 約18GB | 1888 |

10 CU | 約20GB | 2098 |

12 CU | 約24GB | 2517 |

14 CU | 約28GB | 2937 |

16 CU | 約32GB | 3357 |

24 CU | 約48GB | 4000 |

28 CU | 約56GB | 4000 |

32 CU | 約64GB | 4000 |

36 CU | 約72GB | 4000 |

40 CU | 約80GB | 4000 |

44 CU | 約88GB | 4000 |

48 CU | 約96GB | 4000 |

52 CU | 約104GB | 4000 |

56 CU | 約112GB | 4000 |

60 CU | 約120GB | 4000 |

64 CU | 約128GB | 4000 |

72 CU | 約144GB | 4000 |

80 CU | 約160GB | 4000 |

88 CU | 約176GB | 4000 |

96 CU | 約192GB | 4000 |

104 CU | 約208GB | 4000 |

112 CU | 約224GB | 4000 |

オートスケール コンピュートの接続制限 : オートスケールが有効な場合、最大接続数はオートスケール範囲内の最大 CU サイズによって決まります。 たとえば、オートスケールを 2 ~ 8 CU の間で設定した場合、接続制限は 1,678 (8 CU の制限) になります。

リードレプリカ接続制限 : リードレプリカ コンピュート接続制限は、プライマリの読み取り/書き込みコンピュート設定と同期されます。 詳細については、 「読み取りレプリカの管理」を参照してください。

一部の接続はシステムおよび管理用に予約されています。このため、 SHOW max_connectionsには、上記の表または Lakebase アプリの [編集] コンピュート ドロワーに表示されている 最大接続 数よりも高い値が表示される場合があります。 テーブルとドロワーの値は直接使用できる実際の接続数を反映していますが、 SHOW max_connectionsには予約済みの接続が含まれます。

サイズガイド

コンピュートのサイズを選択するときは、次の要素を考慮してください。

要素 | 推奨事項 |

|---|---|

クエリの複雑さ | 複雑な分析クエリは、コンピュート サイズを大きくするとメリットが得られます |

つながり | 接続数が増えるとCPUとメモリの追加が必要になります |

データ量 | データセットが大きい場合、最適なパフォーマンスを得るためにより多くのメモリが必要になる場合があります |

応答時間 | クリティカルなアプリケーションでは、一貫したパフォーマンスを得るためにより大きなコンピュートが必要になる場合があります |

最適なサイズ戦略

データ要件に基づいてコンピュート サイズを選択します。

- メモリ内の完全なデータセット : 最高のパフォーマンスを得るために、データセット全体をメモリ内に保持できるコンピュート サイズを選択します。

- メモリ内のワーキングセット : 大規模なデータセットの場合、頻繁にアクセスされるデータがメモリに収まるようにしてください。

- 接続制限 : 予想される最大同時接続数をサポートするサイズを選択します

オートスケール

Lakebase は、固定サイズ構成とオートスケール コンピュート構成の両方をサポートしています。 オートスケールは、ワークロードの需要に基づいてコンピュート リソースを動的に調整し、パフォーマンスとコストの両方を最適化します。

構成タイプ | 説明 |

|---|---|

固定サイズ(0.5~32 CU) | ワークロードの需要に合わせて拡張しない、固定のコンピュート サイズを選択します。 0.5 CUから32 CUまでのコンピュートに利用可能 |

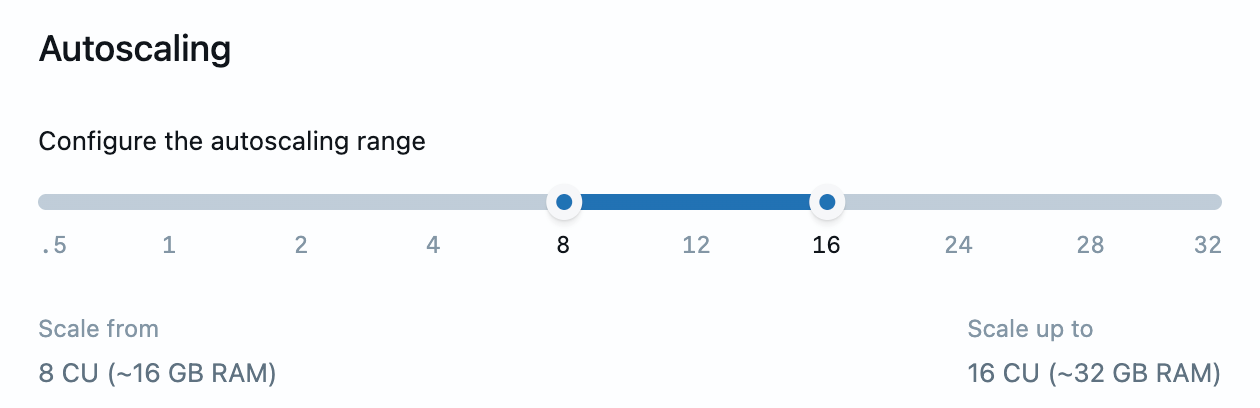

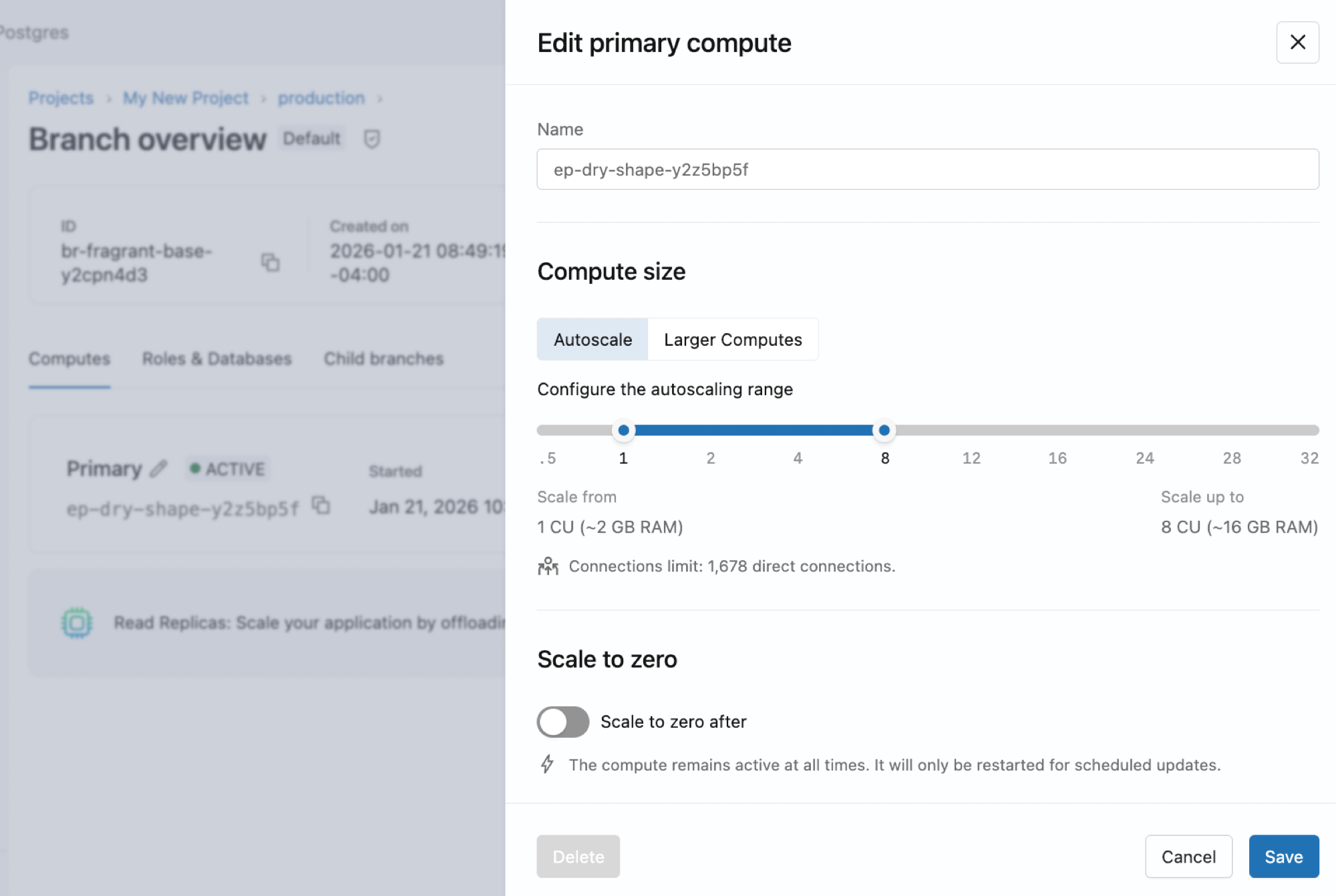

オートスケール(0.5-32CU) | スライダーを使用して、コンピュートの最小サイズと最大サイズを指定します。 Lakebase は、現在の負荷に基づいてこれらの境界内でスケールアップおよびスケールダウンします。最大32CUまでのコンピュートに利用可能 |

より大きな固定サイズのコンピュート (36-112 CU) | 36 CU ~ 112 CU のより大きな固定サイズ コンピュートを選択します。 これらの大きなコンピュートは固定サイズとしてのみ利用可能であり、オートスケールには対応していません |

オートスケール制限: オートスケールはコンピュート32 CUまでサポートされます。 32 CU を超えるワークロードを必要とする場合は、36 CU ~ 112 CU のより大きな固定サイズのコンピュートが利用可能です。

オートスケールの設定

コンピュートのオートスケールを有効または調整するには、コンピュートを編集し、スライダーを使用してコンピュートの最小サイズと最大サイズを設定します。

オートスケールの仕組みの概要については、 「オートスケール」を参照してください。

オートスケールの考慮事項

オートスケールの最適なパフォーマンスのために:

- 最小コンピュート サイズをメモリ内にワーキング セットをキャッシュできる十分な大きさに設定します。

- コンピュートがスケールアップしてデータをキャッシュするまでは、パフォーマンスの低下が発生する可能性があることを考慮してください。

- 接続制限は、オートスケール範囲内の最大コンピュート サイズに基づいています。

オートスケール範囲の制約 : コンピュートの最大サイズと最小サイズの差は 8 CU (つまり、 max - min ≤ 8 CU ) を超えることはできません。 たとえば、オートスケールを 8 ~ 16 CU、または 16 ~ 24 CU に設定できますが、0.5 ~ 32 CU (31.5 CU の範囲) に設定することはできません。 この制約により、柔軟性を維持しながら、管理可能なスケーリング動作が保証されます。Lakebase アプリのスライダーは、オートスケール範囲を設定するときにこの制約を自動的に適用します。 32 CU を超えるワークロードを必要とする場合は、より大きな固定サイズのコンピュートを使用してください。

ゼロにスケール

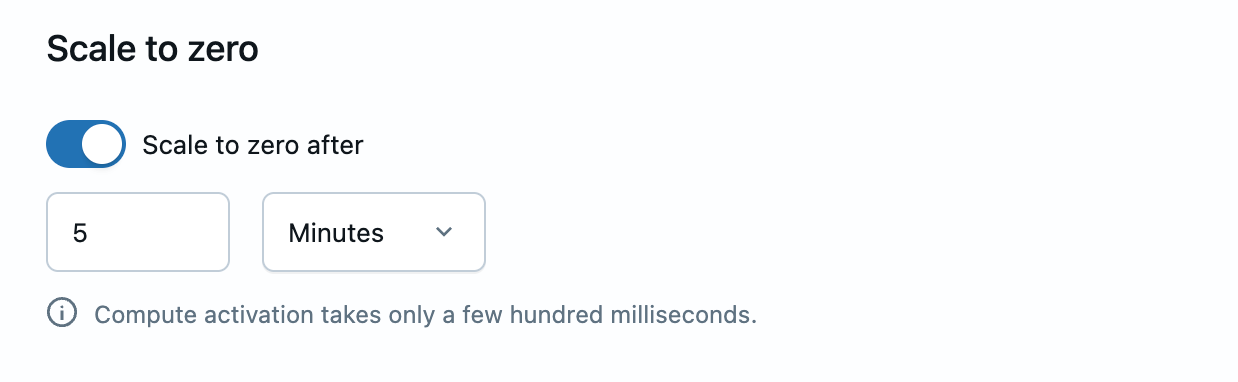

Lakebase のスケール ツー ゼロ機能は、一定期間の非アクティブ期間後にコンピュートを自動的にアイドル状態に移行し、継続的にアクティブではないデータベースのコストを削減します。

構成 | 説明 |

|---|---|

ゼロスケールが有効 | コンピュートはコストを削減するために非アクティブな状態になると自動的に一時停止します |

ゼロスケールが無効 | 起動遅延を排除する「常にアクティブな」コンピュートを維持します。 |

スケールをゼロに設定する

コンピュートのスケールをゼロに調整するには、コンピュートを編集し、スケールをゼロに設定を切り替えます。 有効にすると、非アクティブ タイムアウトを設定できます。

プロジェクトを作成すると、スケール トゥ ゼロが無効になったコンピュートを使用してproductionブランチが作成されます。つまり、コンピュートは常にアクティブなままになります。 必要に応じて、このコンピュートのゼロへのスケールを有効にすることができます。

ゼロにスケールする方法の概要については、 「ゼロにスケール」を参照してください。

コンピュートの作成と管理

コンピュートを見る

UIで表示

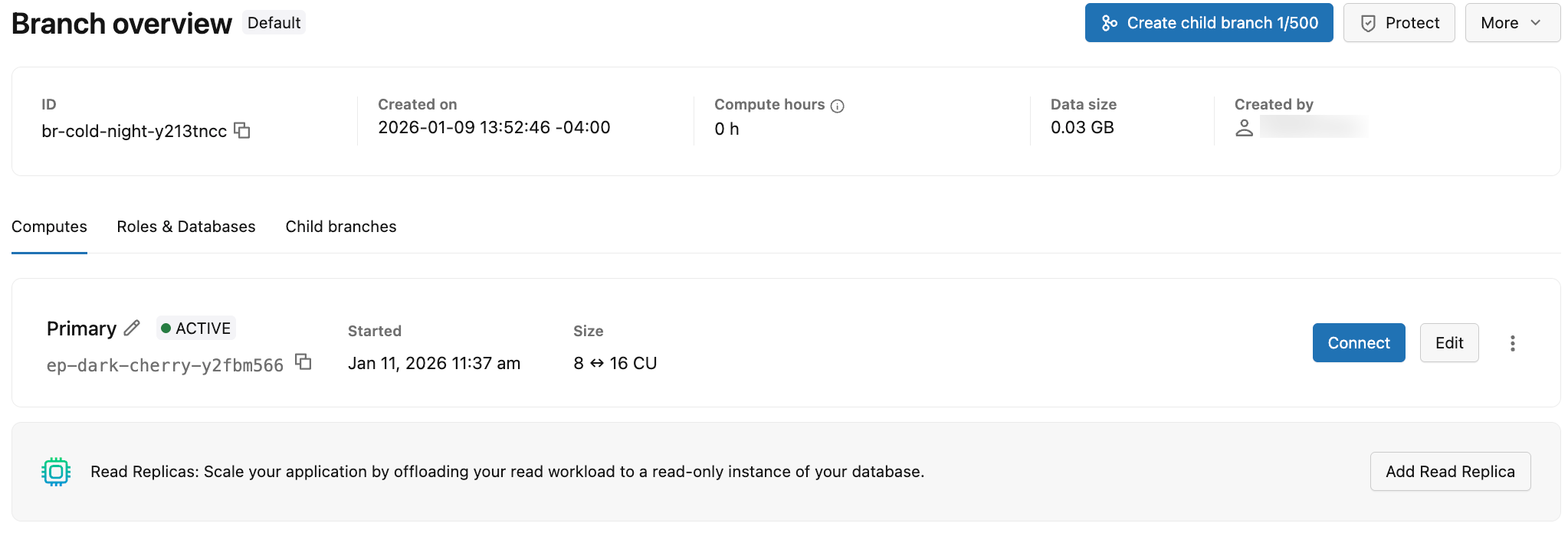

ブランチのコンピュートを表示するには、Lakebase アプリでプロジェクトの [ブランチ] ページに移動し、ブランチを選択してその コンピュート タブを表示します。

[コンピュート] タブには、ブランチに関連付けられたすべてのコンピュートに関する情報が表示されます。 [コンピュート] タブに表示される情報の概要を次の表に示します。

詳細 | 説明 |

|---|---|

クラスタータイプ | コンピュート タイプは、プライマリ (読み取り/書き込み) またはリード レプリカ(読み取り専用) のいずれかです。 ブランチには、単一のプライマリ (読み取り/書き込み) と複数のリード レプリカ (読み取り専用) コンピュートを含めることができます。 |

ステータス | 現在のステータス: アクティブまたは一時停止 (コンピュートがゼロにスケールされたために一時停止されている場合)。 コンピュートが一時停止された日時を表示します。 |

エンドポイントID |

|

サイズ | コンピュート単位 (CU)で表されるコンピュート サイズ。 固定サイズのコンピュートの単一の CU 値 (たとえば、8 CU) を表示します。 オートスケールが有効な場合のコンピュートの範囲 (たとえば、8 ~ 16) を表示します。 |

最終アクティブ | コンピュートが最後にアクティブだった日時。 |

コンピュートごとに、次のことができます。

- 「接続」 をクリックすると、コンピュートに関連付けられたブランチの接続詳細を示す接続ダイアログが開きます。 「データベースへの接続」を参照してください。

- [編集] をクリックしてコンピュート サイズ (固定またはオートスケール範囲) を変更し、スケールからゼロまでの設定を構成します。 「コンピュートの編集」を参照してください。

- 追加のオプションにアクセスするには、メニュー アイコンをクリックします。

- アクティビティの監視 : コンピュートのアクティビティとパフォーマンスのメトリクスを表示します。 「データベースを監視する」を参照してください。

- コンピュートの再起動 : 接続の問題を解決するか、構成の変更を適用するには、コンピュートを再起動します。 「コンピュートの再起動」を参照してください。

- コンピュートの削除 : ブランチからコンピュートを完全に削除します。 「コンピュートの削除」を参照してください。

リードレプリカ コンピュートをブランチに追加するには、 [リードレプリカの追加] をクリックします。 リードレプリカは読み取り専用コンピュートであり、プライマリ コンピュートから読み取りワークロードをオフロードできるようにすることで、水平スケーリングを可能にします。 「読み取りレプリカ」および「読み取りレプリカの管理」を参照してください。

プログラムでコンピュートを取得する

Postgres APIを使用して特定のコンピュートに関する詳細を取得するには:

- Python SDK

- Java SDK

- CLI

- curl

from databricks.sdk import WorkspaceClient

w = WorkspaceClient()

# Get endpoint details

endpoint = w.postgres.get_endpoint(

name="projects/my-project/branches/production/endpoints/my-compute"

)

print(f"Endpoint: {endpoint.name}")

print(f"Type: {endpoint.status.endpoint_type}")

print(f"State: {endpoint.status.current_state}")

print(f"Host: {endpoint.status.hosts.host}")

print(f"Min CU: {endpoint.status.autoscaling_limit_min_cu}")

print(f"Max CU: {endpoint.status.autoscaling_limit_max_cu}")

SDK では、 endpoint.status.hostではなくendpoint.status.hosts.host経由でホストにアクセスします。

import com.databricks.sdk.WorkspaceClient;

import com.databricks.sdk.service.postgres.Endpoint;

WorkspaceClient w = new WorkspaceClient();

// Get endpoint details

Endpoint endpoint = w.postgres().getEndpoint(

"projects/my-project/branches/production/endpoints/my-compute"

);

System.out.println("Endpoint: " + endpoint.getName());

System.out.println("Type: " + endpoint.getStatus().getEndpointType());

System.out.println("State: " + endpoint.getStatus().getCurrentState());

System.out.println("Host: " + endpoint.getStatus().getHosts().getHost());

System.out.println("Min CU: " + endpoint.getStatus().getAutoscalingLimitMinCu());

System.out.println("Max CU: " + endpoint.getStatus().getAutoscalingLimitMaxCu());

# Get endpoint details

databricks postgres get-endpoint projects/my-project/branches/production/endpoints/my-compute --output json | jq

curl "$WORKSPACE/api/2.0/postgres/projects/my-project/branches/production/endpoints/my-compute" \

-H "Authorization: Bearer ${DATABRICKS_TOKEN}" | jq

プログラムによるリストコンピュート

Postgres APIを使用してブランチのすべてのコンピュート レプリカとリード レプリカを一覧表示するには、次のようにします。

- Python SDK

- Java SDK

- CLI

- curl

from databricks.sdk import WorkspaceClient

w = WorkspaceClient()

# List all endpoints for a branch

endpoints = list(w.postgres.list_endpoints(

parent="projects/my-project/branches/production"

))

for endpoint in endpoints:

print(f"Endpoint: {endpoint.name}")

print(f" Type: {endpoint.status.endpoint_type}")

print(f" State: {endpoint.status.current_state}")

print(f" Host: {endpoint.status.hosts.host}")

print(f" CU Range: {endpoint.status.autoscaling_limit_min_cu}-{endpoint.status.autoscaling_limit_max_cu}")

print()

SDK では、 endpoint.status.hostではなくendpoint.status.hosts.host経由でホストにアクセスします。

import com.databricks.sdk.WorkspaceClient;

import com.databricks.sdk.service.postgres.*;

WorkspaceClient w = new WorkspaceClient();

// List all endpoints for a branch

for (Endpoint endpoint : w.postgres().listEndpoints("projects/my-project/branches/production")) {

System.out.println("Endpoint: " + endpoint.getName());

System.out.println(" Type: " + endpoint.getStatus().getEndpointType());

System.out.println(" State: " + endpoint.getStatus().getCurrentState());

System.out.println(" Host: " + endpoint.getStatus().getHosts().getHost());

System.out.println(" CU Range: " + endpoint.getStatus().getAutoscalingLimitMinCu() +

"-" + endpoint.getStatus().getAutoscalingLimitMaxCu());

System.out.println();

}

# List endpoints for a branch

databricks postgres list-endpoints projects/my-project/branches/production --output json | jq

curl "$WORKSPACE/api/2.0/postgres/projects/my-project/branches/production/endpoints" \

-H "Authorization: Bearer ${DATABRICKS_TOKEN}" | jq

一般的なブランチ構成:

- 1 エンドポイント: プライマリ読み取り/書き込みコンピュートのみ

- 2 つ以上のエンドポイント: プライマリ コンピュートと 1 つ以上のリードレプリカ

コンピュートを作成する

プライマリ読み取り/書き込みコンピュートを持たないブランチに対して、プライマリ読み取り/書き込みコンピュートを作成できます。 Lakebase UI で作成されたブランチは、デフォルトで、読み書き可能なコンピュートを使用して自動的に作成されます。 コンピュートを削除した場合、または別の方法でブランチを作成した場合にのみ、コンピュートを手動で作成する必要があります。

各ブランチは、読み取り/書き込みコンピュートを 1 つだけ持つことができます。 ブランチにすでに読み取り/書き込みコンピュートがある場合は、代わりに読み取りレプリカを追加するオプションが表示されます。 リードレプリカは、水平スケーリングやその他のユースケースを可能にする読み取り専用のコンピュートです。 詳細:リードレプリカ|リードレプリカの管理

コンピュートを作成するには:

- UI

- Python SDK

- Java SDK

- CLI

- curl

- Lakebase アプリでブランチの コンピュート タブに移動します。

- [コンピュートの追加] をクリックし、コンピュート設定を構成して、 [追加] をクリックします。

from databricks.sdk import WorkspaceClient

from databricks.sdk.service.postgres import Endpoint, EndpointSpec, EndpointType

w = WorkspaceClient()

# Create compute endpoint (READ_WRITE)

endpoint_spec = EndpointSpec(

endpoint_type=EndpointType.ENDPOINT_TYPE_READ_WRITE,

autoscaling_limit_max_cu=4.0

)

endpoint = Endpoint(spec=endpoint_spec)

result = w.postgres.create_endpoint(

parent="projects/my-project/branches/production",

endpoint=endpoint,

endpoint_id="my-compute"

).wait()

print(f"Endpoint created: {result.name}")

print(f"Host: {result.status.hosts.host}")

import com.databricks.sdk.WorkspaceClient;

import com.databricks.sdk.service.postgres.*;

WorkspaceClient w = new WorkspaceClient();

// Create compute endpoint (READ_WRITE)

EndpointSpec endpointSpec = new EndpointSpec()

.setEndpointType(EndpointType.ENDPOINT_TYPE_READ_WRITE)

.setAutoscalingLimitMaxCu(4.0);

Endpoint endpoint = new Endpoint().setSpec(endpointSpec);

Endpoint result = w.postgres().createEndpoint(

new CreateEndpointRequest()

.setParent("projects/my-project/branches/production")

.setEndpoint(endpoint)

.setEndpointId("my-compute")

).waitForCompletion();

System.out.println("Endpoint created: " + result.getName());

System.out.println("Host: " + result.getStatus().getHosts().getHost());

# Create a read-write compute for a branch

databricks postgres create-endpoint projects/my-project/branches/production my-compute \

--json '{

"spec": {

"endpoint_type": "ENDPOINT_TYPE_READ_WRITE",

"autoscaling_limit_min_cu": 0.5,

"autoscaling_limit_max_cu": 4.0

}

}'

curl -X POST "$WORKSPACE/api/2.0/postgres/projects/my-project/branches/production/endpoints?endpoint_id=my-compute" \

-H "Authorization: Bearer ${DATABRICKS_TOKEN}" \

-H "Content-Type: application/json" \

-d '{

"spec": {

"endpoint_type": "ENDPOINT_TYPE_READ_WRITE",

"autoscaling_limit_min_cu": 0.5,

"autoscaling_limit_max_cu": 4.0

}

}' | jq

各ブランチは、読み取り/書き込みコンピュートを 1 つだけ持つことができます。 同じブランチ上に 2 番目の読み取り/書き込みコンピュートを作成しようとすると、操作は失敗します。 クエリ容量をさらに追加するには、代わりに読み取りレプリカを作成します。

コンピュートを編集する

コンピュートを編集して、そのサイズ、オートスケール設定、またはゼロスケール設定を変更できます。

コンピュートを編集するには:

- UI

- Python SDK

- Java SDK

- CLI

- curl

- Lakebase アプリでブランチの コンピュート タブに移動します。

- コンピュートの [編集] を クリックし、設定を調整して、 [保存] をクリックします。

from databricks.sdk import WorkspaceClient

from databricks.sdk.service.postgres import Endpoint, EndpointSpec, FieldMask

w = WorkspaceClient()

# Update a single field (max CU)

endpoint_spec = EndpointSpec(autoscaling_limit_max_cu=6.0)

endpoint = Endpoint(

name="projects/my-project/branches/production/endpoints/my-compute",

spec=endpoint_spec

)

result = w.postgres.update_endpoint(

name="projects/my-project/branches/production/endpoints/my-compute",

endpoint=endpoint,

update_mask=FieldMask(field_mask=["spec.autoscaling_limit_max_cu"])

).wait()

print(f"Updated max CU: {result.spec.autoscaling_limit_max_cu}")

複数のフィールドを更新するには、それらを仕様と更新マスクの両方に含めます。

# Update multiple fields (min and max CU)

endpoint_spec = EndpointSpec(

autoscaling_limit_min_cu=1.0,

autoscaling_limit_max_cu=8.0

)

endpoint = Endpoint(

name="projects/my-project/branches/production/endpoints/my-compute",

spec=endpoint_spec

)

result = w.postgres.update_endpoint(

name="projects/my-project/branches/production/endpoints/my-compute",

endpoint=endpoint,

update_mask=FieldMask(field_mask=[

"spec.autoscaling_limit_min_cu",

"spec.autoscaling_limit_max_cu"

])

).wait()

print(f"Updated min CU: {result.spec.autoscaling_limit_min_cu}")

print(f"Updated max CU: {result.spec.autoscaling_limit_max_cu}")

import com.databricks.sdk.WorkspaceClient;

import com.databricks.sdk.service.postgres.*;

import com.google.protobuf.FieldMask;

WorkspaceClient w = new WorkspaceClient();

// Update a single field (max CU)

EndpointSpec endpointSpec = new EndpointSpec()

.setAutoscalingLimitMaxCu(6.0);

FieldMask updateMask = FieldMask.newBuilder()

.addPaths("spec.autoscaling_limit_max_cu")

.build();

w.postgres().updateEndpoint(

new UpdateEndpointRequest()

.setName("projects/my-project/branches/production/endpoints/my-compute")

.setEndpoint(new Endpoint().setSpec(endpointSpec))

.setUpdateMask(updateMask)

);

System.out.println("Update initiated");

複数のフィールドを更新するには、それらを仕様と更新マスクの両方に含めます。

// Update multiple fields (min and max CU)

EndpointSpec endpointSpec = new EndpointSpec()

.setAutoscalingLimitMinCu(1.0)

.setAutoscalingLimitMaxCu(8.0);

FieldMask updateMask = FieldMask.newBuilder()

.addPaths("spec.autoscaling_limit_min_cu")

.addPaths("spec.autoscaling_limit_max_cu")

.build();

w.postgres().updateEndpoint(

new UpdateEndpointRequest()

.setName("projects/my-project/branches/production/endpoints/my-compute")

.setEndpoint(new Endpoint().setSpec(endpointSpec))

.setUpdateMask(updateMask)

);

System.out.println("Update initiated");

# Update a single field (max CU)

databricks postgres update-endpoint projects/my-project/branches/production/endpoints/my-compute spec.autoscaling_limit_max_cu \

--json '{

"spec": {

"autoscaling_limit_max_cu": 6.0

}

}'

# Update multiple fields (min and max CU)

databricks postgres update-endpoint projects/my-project/branches/production/endpoints/my-compute "spec.autoscaling_limit_min_cu,spec.autoscaling_limit_max_cu" \

--json '{

"spec": {

"autoscaling_limit_min_cu": 1.0,

"autoscaling_limit_max_cu": 8.0

}

}'

# Update a single field (max CU)

curl -X PATCH "$WORKSPACE/api/2.0/postgres/projects/my-project/branches/production/endpoints/my-compute?update_mask=spec.autoscaling_limit_max_cu" \

-H "Authorization: Bearer ${DATABRICKS_TOKEN}" \

-H "Content-Type: application/json" \

-d '{

"name": "projects/my-project/branches/production/endpoints/my-compute",

"spec": {

"autoscaling_limit_max_cu": 6.0

}

}' | jq

# Update multiple fields (min and max CU)

curl -X PATCH "$WORKSPACE/api/2.0/postgres/projects/my-project/branches/production/endpoints/my-compute?update_mask=spec.autoscaling_limit_min_cu,spec.autoscaling_limit_max_cu" \

-H "Authorization: Bearer ${DATABRICKS_TOKEN}" \

-H "Content-Type: application/json" \

-d '{

"name": "projects/my-project/branches/production/endpoints/my-compute",

"spec": {

"autoscaling_limit_min_cu": 1.0,

"autoscaling_limit_max_cu": 8.0

}

}' | jq

コンピュート設定への変更はすぐに反映され、再起動中に接続が短時間中断される場合があります。

コンピュートを再起動する

コンピュートを再起動して、アップデートを適用したり、パフォーマンスの問題を解決したり、構成の変更を取得したりします。

コンピュートを再起動するには:

- Lakebase アプリでブランチの コンピュート タブに移動します。

- クリック

コンピュートのメニューから 「再起動」 を選択し、動作を確認します。

コンピュートを再起動すると、アクティブな接続が中断されます。 長時間の中断を避けるために、アプリケーションが自動的に再接続するように構成します。

コンピュートを削除する

ブランチからプライマリ コンピュートを削除できます。 ただし、ブランチに接続してそのデータにアクセスするには、コンピュートが必要です。

コンピュートを削除するには:

- UI

- Python SDK

- Java SDK

- CLI

- curl

- Lakebase アプリでブランチの コンピュート タブに移動します。

- コンピュートの 「編集」 をクリックし、ダイアログの下部にある 「コンピュートの削除」 をクリックします。

from databricks.sdk import WorkspaceClient

w = WorkspaceClient()

# Delete endpoint

w.postgres.delete_endpoint(

name="projects/my-project/branches/production/endpoints/my-compute"

).wait()

print("Endpoint deleted")

削除操作は非同期です。.wait()メソッドは削除が完了するまでブロックします。

import com.databricks.sdk.WorkspaceClient;

WorkspaceClient w = new WorkspaceClient();

// Delete endpoint

w.postgres().deleteEndpoint(

"projects/my-project/branches/production/endpoints/my-compute"

);

System.out.println("Delete initiated");

# Delete a compute

databricks postgres delete-endpoint projects/my-project/branches/production/endpoints/my-compute

curl -X DELETE "$WORKSPACE/api/2.0/postgres/projects/my-project/branches/production/endpoints/my-compute" \

-H "Authorization: Bearer ${DATABRICKS_TOKEN}" | jq

応答:

{

"name": "projects/my-project/branches/production/endpoints/my-compute/operations/...",

"done": true,

"response": {

"@type": "type.googleapis.com/google.protobuf.Empty"

}

}