Configurar o ambiente serverless

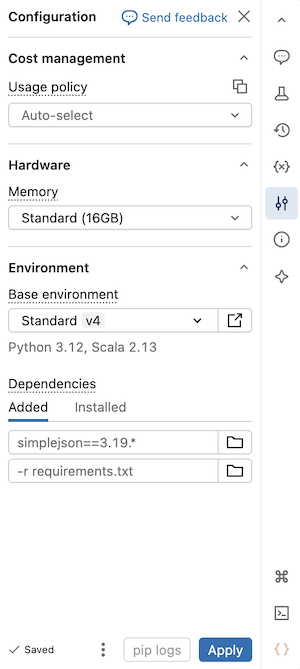

Esta página explica como usar o painel lateral Ambiente de um Notebook serverless para configurar dependências, políticas de uso de recursos serverless , memória e ambiente base. Este painel oferece um local centralizado para gerenciar as configurações serverless do Notebook. As configurações definidas neste painel só se aplicam quando o Notebook está conectado a compute serverless .

Para expandir o painel lateral Environment , clique no botão à direita do Notebook.

Use serverless GPU compute

Beta

GPU sem servidor compute está em Beta.

Siga as etapas a seguir para usar a GPU serverless compute em seu notebook Databricks:

- Em um notebook, clique no menu suspenso Conectar na parte superior e selecione GPU sem servidor .

- Clique no

Para abrir o painel lateral Ambiente .

- Selecione A10 ou H100 no campo Acelerador .

- Em Ambiente base , selecione Padrão para o ambiente default ou AI para o ambiente otimizado para AIcom biblioteca de machine learning pré-instalada.

- Clique em Aplicar e, em seguida, confirme que deseja aplicar o compute de GPU serverless ao seu ambiente de notebook.

Para obter mais detalhes, consulte GPU sem servidor compute.

Use memória alta serverless compute

Visualização

Esse recurso está em Public Preview.

Se o senhor se deparar com erros de falta de memória no Notebook, poderá configurar o Notebook para usar um tamanho de memória maior. Essa configuração aumenta o tamanho da memória do REPL usada ao executar o código no Notebook. Isso não afeta o tamanho da memória da sessão do Spark. O uso sem servidor com memória alta tem uma taxa de emissão de DBU mais alta do que a memória padrão.

As opções de memória disponíveis são:

- Padrão : 16 GB de memória total.

- Alta : 32 GB de memória total.

Para configurar as definições de memória do Notebook:

- Na interface do usuário do Notebook, clique no painel lateral Environment (Ambiente)

.

- Em Memória , selecione Memória alta .

- Clique em Aplicar .

Essa configuração também se aplica à tarefa do Notebook Job, que é executada usando as preferências de memória do Notebook. A atualização da preferência de memória no Notebook afeta a execução do próximo trabalho.

Selecione uma política de uso serverless

Visualização

Esse recurso está em Public Preview.

As políticas de uso de serviços sem servidor permitem que sua organização aplique tags personalizadas ao uso de serviços serverless para uma atribuição de faturamento granular.

Se o seu workspace utiliza políticas de uso serverless para atribuir o uso serverless , você pode selecionar a política de uso serverless que deseja aplicar ao Notebook. Se um usuário estiver atribuído a apenas uma política de uso serverless , essa política será selecionada por default.

Você pode selecionar a política de uso serverless depois que seu Notebook estiver conectado à compute serverless , usando o painel lateral Ambiente :

- Na interface do usuário do Notebook, clique no painel lateral Environment (Ambiente)

.

- Em Política de uso, selecione a política de uso serverless que deseja aplicar ao seu Notebook.

- Clique em Aplicar .

Quando essa configuração estiver concluída, todo o uso do Notebook herdará as tags personalizadas da política de uso serverless .

Se o seu Notebook for originário de um repositório Git ou não tiver uma política de usoserverless atribuída, ele usará por padrão a última política de uso serverless escolhida quando for conectado à compute serverless .

Selecione um ambiente base

Um ambiente base determina a biblioteca pré-instalada e a versão do ambiente disponível para seu Notebook serverless . O seletor de ambiente Base no painel lateral Ambiente fornece uma interface unificada para selecionar seu ambiente. Para ver detalhes sobre cada versão de ambiente, consulte Versões de ambiente sem servidor. Databricks recomenda o uso da versão mais recente para obter o recurso Notebook mais atualizado.

O seletor de ambiente Base inclui as seguintes opções:

-

Padrão : O ambiente base default com a biblioteca fornecida Databricks .

-

AI : Um ambiente base otimizado AIcom biblioteca de machine learning pré-instalada. Essa opção aparece somente quando um acelerador (GPU) está selecionado.

-

Mais : Expande para mostrar opções adicionais:

- Versões anteriores dos ambientes Standard e AI.

- Personalizado : Permite especificar um ambiente personalizado usando um arquivo YAML.

-

Ambientes de espaço de trabalho : Lista todos os ambientes base compatíveis configurados para seu workspace por um administrador.

Para selecionar um ambiente base:

- Na interface do usuário do Notebook, clique no painel lateral Environment (Ambiente)

.

- Em Ambiente base , selecione um ambiente no menu dropdown .

- Clique em Aplicar .

Adicionar dependências ao Notebook

Como o site serverless não é compatível com as políticas ou o script de inicialização do compute, o senhor deve adicionar dependências personalizadas usando o painel lateral Environment . Você pode adicionar dependências individualmente ou usar um ambiente básico compartilhável para instalar várias dependências.

Para adicionar uma dependência individualmente:

-

Na interface do usuário do Notebook, clique no painel lateral Environment (Ambiente)

.

-

Na seção Dependências , clique em Adicionar dependência e insira o caminho da dependência no campo. Você pode especificar uma dependência em qualquer formato que seja válido em um arquivo requirements.txt. Python wheel ou projetos Python (por exemplo, o diretório que contém um

pyproject.tomlou umsetup.py) podem estar localizados em arquivos workspace ou volumes Unity Catalog.- Se estiver usando um arquivo workspace, o caminho deve ser absoluto e começar com

/Workspace/. - Se estiver usando um arquivo em um volume do Unity Catalog, o caminho deve estar no seguinte formato:

/Volumes/<catalog>/<schema>/<volume>/<path>.whl.

- Se estiver usando um arquivo workspace, o caminho deve ser absoluto e começar com

-

Clique em Aplicar . Isso instala as dependências no ambiente virtual do notebook e reinicia o processo do Python.

Não instale o PySpark ou qualquer biblioteca que instale o PySpark como uma dependência do seu notebook serverless. Isso interromperá sua sessão e resultará em um erro. Se isso ocorrer, remova a biblioteca e reinicie seu ambiente.

Para view as dependências instaladas, clique em Installed tab no painel lateral Environments (Ambientes ). A instalação do pip logs para o ambiente do Notebook também está disponível clicando em pip logs na parte inferior do painel.

Crie uma especificação de ambiente personalizada

Você pode criar e reutilizar especificações de ambiente personalizadas.

- Em um Notebook serverless, selecione uma versão do ambiente e adicione as dependências que deseja instalar.

- Clique no ícone do menu kebab

na parte inferior do painel do ambiente e clique em Exportar ambiente.

- Salve a especificação como um arquivo de espaço de trabalho ou em um volume Unity Catalog.

Para usar sua especificação de ambiente personalizada em um Notebook, selecione Personalizado no menu dropdown Ambiente base e, em seguida, use o ícone de pasta. Para selecionar seu arquivo YAML.

Crie utilidades comuns para compartilhar em toda a sua workspace

O exemplo a seguir mostra como armazenar um utilitário comum em um arquivo workspace e adicioná-lo como uma dependência no Notebook serverless:

-

Crie uma pasta com a estrutura a seguir. Verifique se os consumidores do seu projeto têm acesso adequado ao caminho do arquivo:

Shellhelper_utils/

├── helpers/

│ └── __init__.py # your common functions live here

├── pyproject.toml -

Preencha

pyproject.tomlassim:Python[project]

name = "common_utils"

version = "0.1.0" -

Adicione uma função ao arquivo

init.py. Por exemplo:Pythondef greet(name: str) -> str:

return f"Hello, {name}!" -

Na interface do usuário do Notebook, clique no painel lateral Environment (Ambiente)

.

-

Na seção Dependências , clique em Adicionar dependência e insira o caminho do seu arquivo util. Por exemplo:

/Workspace/helper_utils. -

Clique em Aplicar .

Agora o senhor pode usar a função em seu Notebook:

from helpers import greet

print(greet('world'))

Isso resulta como:

Hello, world!

Reset as dependências do ambiente

Se o Notebook estiver conectado ao site serverless compute, o site Databricks armazena automaticamente em cache o conteúdo do ambiente virtual do Notebook. Isso significa que, em geral, o senhor não precisa reinstalar as dependências do Python especificadas no painel lateral Environment ao abrir um Notebook existente, mesmo que ele tenha sido desconectado devido à inatividade.

Python O cache de ambiente virtual também se aplica ao Job. Quando um trabalho é executado, qualquer tarefa do trabalho que compartilhe o mesmo conjunto de dependências que uma tarefa concluída nessa execução é mais rápida, pois as dependências necessárias já estão disponíveis.

Se o senhor alterar a implementação de um pacote Python personalizado usado em um trabalho no site serverless, também deverá atualizar o número da versão para que o trabalho possa pegar a implementação mais recente.

Para limpar o cache do ambiente e realizar uma nova instalação das dependências especificadas no painel lateral Ambiente de um Notebook anexado a serverless compute, clique na seta ao lado de Aplicar e, em seguida, clique emReset para definir como padrão .

Se o senhor instalar um pacote que interrompa ou altere o ambiente principal do Notebook ou do site Apache Spark, remova o pacote problemático e, em seguida, redefina o ambiente. Iniciar uma nova sessão não limpa todo o cache do ambiente.

Configure os repositórios default Python pacote

Os administradores do workspace podem configurar repositórios pacote privados ou autenticados dentro do workspace como a configuração default pip para serverless Notebook e serverless Job. Isso permite que os usuários instalem o pacote a partir dos repositórios internos Python sem definir explicitamente index-url ou extra-index-url.

Para obter instruções, os administradores do site workspace podem consultar Configure default Python pacote repositories.

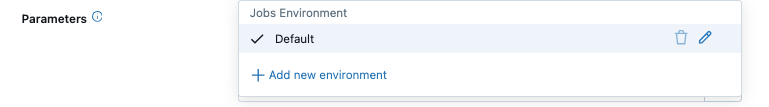

Configurar o ambiente para a tarefa de trabalho

Para tipos de tarefas como Notebook, script Python , Python wheel, JAR ou tarefa dbt , as dependências da biblioteca são herdadas da versão do ambiente serverless . Para view a lista de bibliotecas instaladas, consulte a seção Bibliotecas Python instaladas ou Bibliotecas Java e Scala instaladas da versão do ambiente que você está usando. Se uma tarefa exigir uma biblioteca que não esteja instalada, você poderá instalá-la a partir dos arquivosworkspace, dos volumes Unity Catalog ou dos repositórios de pacotes públicos.

Para notebooks com um ambiente existente, você pode executar a tarefa usando o ambiente do notebook ou substituí-lo selecionando um ambiente em nível de tarefa.

Visualização

O uso de compute serverless para tarefas JAR está em Pré-visualização Pública.

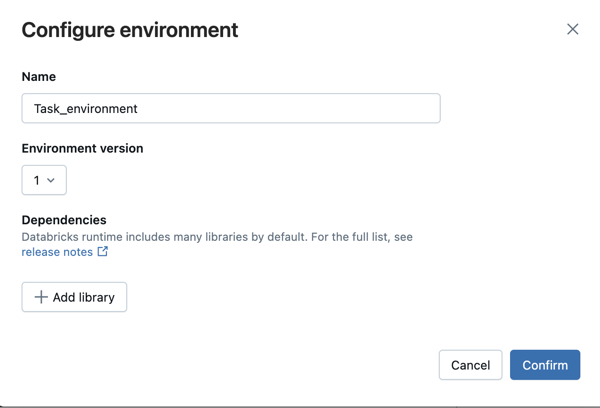

Para adicionar uma biblioteca quando o senhor criar ou editar uma tarefa de trabalho:

-

No menu suspenso "Ambiente e biblioteca" , clique em

Ao lado do ambiente padrão ou clique em + Adicionar novo ambiente .

-

Selecione a versão do ambiente no menu suspenso Versão do ambiente . Consulte as versões do ambiente sem servidor. Databricks recomenda escolher a versão mais recente para obter o recurso mais atualizado.

-

Na caixa de diálogo Configurar ambiente , clique em + Adicionar biblioteca .

-

Selecione o tipo de dependência no menu dropdown em biblioteca .

-

Na caixa de texto File Path (Caminho do arquivo ), digite o caminho para a biblioteca.

-

Para um Python wheel em um arquivo workspace, o caminho deve ser absoluto e começar com

/Workspace/. -

Para um Python wheel em um volume Unity Catalog, o caminho deve ser

/Volumes/<catalog>/<schema>/<volume>/<path>.whl. -

Para um arquivo

requirements.txt, selecione PyPI e insira-r /path/to/requirements.txt.

- Clique em Confirm (Confirmar ) ou + Add library (Adicionar biblioteca ) para adicionar outra biblioteca.

- Se estiver adicionando uma tarefa, clique em Create task (Criar tarefa ). Se estiver editando uma tarefa, clique em Save task (Salvar tarefa ).

Ambientes base para tarefas de trabalho

O Serverless Job oferece suporte a ambientes base personalizados definidos com arquivos YAML para tarefas Python, Python wheel e Notebook. Para tarefas de Notebook, você pode selecionar um ambiente base personalizado na configuração de ambiente da tarefa ou usar as configurações de ambiente do próprio Notebook, que oferecem suporte tanto a ambientes workspace quanto a ambientes base personalizados. Em todos os casos, apenas as dependências necessárias para a tarefa são instaladas em tempo de execução.