Pacotes de autores no workspace

Databricks Os pacotes ativos podem ser criados e modificados diretamente no site workspace.

Para saber os requisitos para o uso de pacotes no site workspace, consulte Databricks ativo Bundles in the workspace requirements.

Para obter mais informações sobre pacotes, consulte What are Databricks ativo Bundles?

Crie um pacote

Para criar um pacote no site Databricks workspace:

-

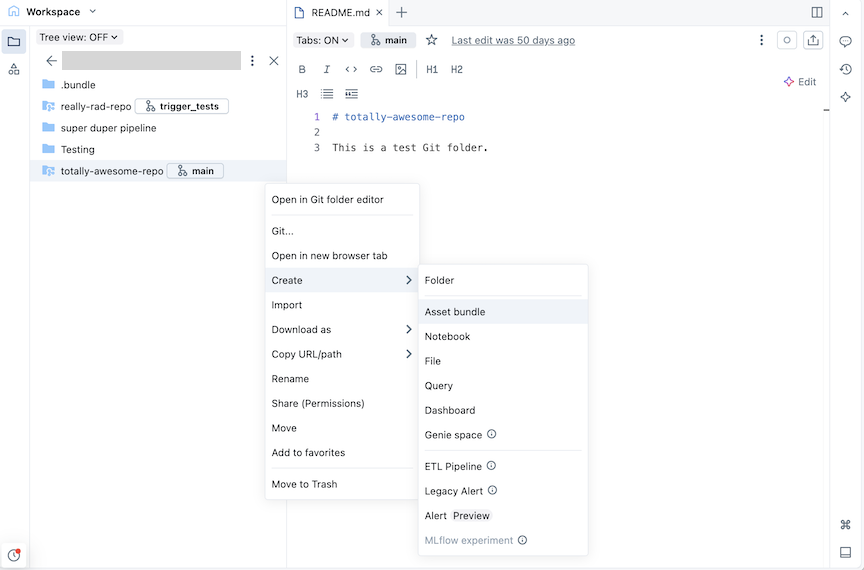

Navegue até a pasta Git onde deseja criar o pacote.

-

Clique no botão Create e, em seguida, clique em ativo bundle . Como alternativa, clique com o botão direito do mouse na pasta Git ou em seu kebab associado na árvore workspace e clique em Create > ativo bundle :

-

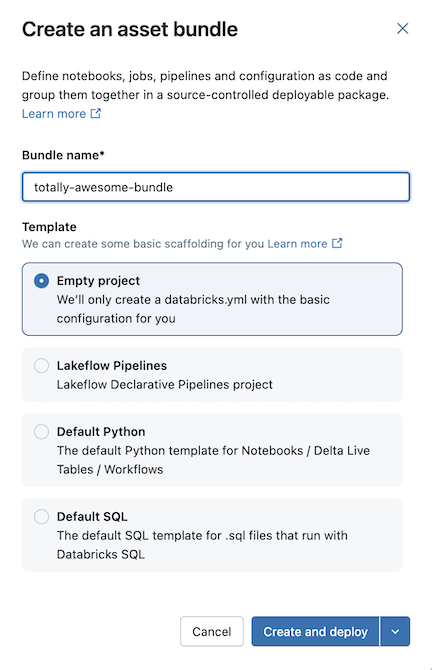

Na caixa de diálogo Create an ativo bundle (Criar um pacote ativo ), dê um nome ao pacote ativo, como totally-awesome-bundle (pacote totalmente incrível) . O nome do pacote só pode conter letras, números, traços e sublinhado.

-

No padrão , escolha se o senhor deseja criar um pacote vazio, um pacote que executa uma amostra do Python Notebook ou um pacote que executa o SQL. Se o EditorLakeFlow Pipelines estiver ativado, o senhor também verá uma opção para criar um projeto ETL pipeline .

-

Alguns padrões exigem configuração adicional. Clique em Avançar para finalizar a configuração do projeto.

Template | Opções de configuração |

|---|---|

Pipeline declarativo LakeFlow Spark |

|

padrão Python |

|

padrão SQL |

|

- Clique em Create and implantado .

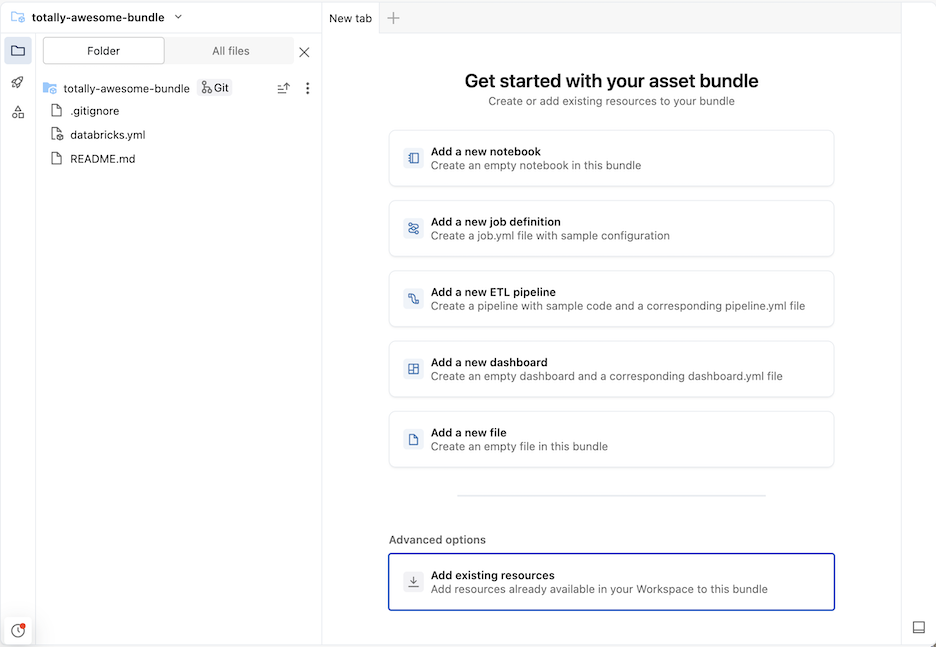

Isso cria um pacote inicial na pasta Git, que inclui os arquivos do projeto padrão que o senhor selecionou, um arquivo de configuração .gitignore Git e o arquivo Databricks ativo Bundles databricks.yml necessário. O arquivo databricks.yml contém a configuração principal do pacote. Para obter detalhes, consulte Databricks ativo Bundle configuration.

Todas as alterações feitas nos arquivos do pacote podem ser sincronizadas com o repositório remoto associado à pasta Git. Uma pasta Git pode conter muitos pacotes.

Adicionar novos arquivos a um pacote

Um pacote contém o arquivo databricks.yml que define as configurações de implantação e workspace , arquivos de origem, como Notebook, arquivos Python e arquivos de teste, e definições e configurações para recursos Databricks , como LakeFlow Jobs e pipeline declarativo LakeFlow Spark . Assim como em qualquer pasta workspace , você pode adicionar novos arquivos ao seu pacote.

Para abrir um novo tab no pacote view que permite modificar os arquivos do pacote, navegue até a pasta do pacote em workspace e clique em Open in editor (Abrir no editor ) à direita do nome do pacote.

Adicionar arquivos de código-fonte

Para adicionar um novo Notebook ou outros arquivos a um pacote na interface do usuário do workspace, navegue até a pasta do pacote e, em seguida, clique em

- Clique em Create (Criar ) no canto superior direito e escolha um dos seguintes tipos de arquivo para adicionar ao seu pacote: Notebook, File (Arquivo), Query (Consulta), Dashboard (Painel).

- Como alternativa, clique no kebab à esquerda de Compartilhar e importe um arquivo.

Para que o arquivo faça parte da implementação do pacote, depois de adicionar um arquivo à pasta do pacote, o senhor deve adicioná-lo à configuração do pacote databricks.yml ou criar um arquivo de definição de trabalho ou pipeline que o inclua. Consulte Adicionar um recurso existente a um pacote.

Criar uma definição de recurso

Os pacotes contêm definições de recursos, como tarefas e pipelines, para inclusão em uma implantação. Quando o pacote é implantado, os recursos definidos no pacote são criados no workspace (ou atualizados, caso já tenham sido implantados). Essas definições são especificadas em YAML ou Python, e você pode criar e editar essas configurações diretamente na interface do usuário.

- Navegue até a pasta do pacote no workspace onde você deseja definir um novo recurso.

Se o senhor já tiver aberto o pacote no editor em workspace, poderá usar a lista de contextos de criação do navegador workspace para navegar até a pasta do pacote. Consulte Contextos de criação.

-

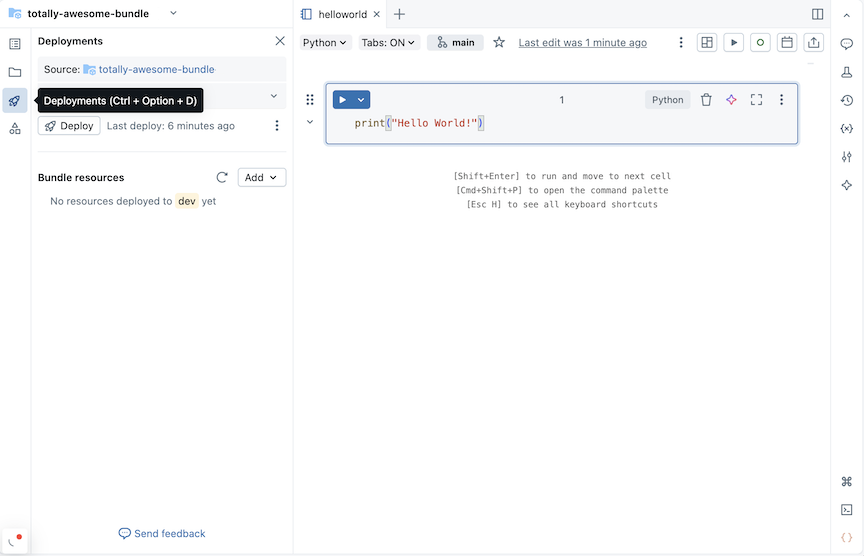

À direita do nome do pacote, clique em Open in editor (Abrir no editor ) para navegar até o editor de pacotes view.

-

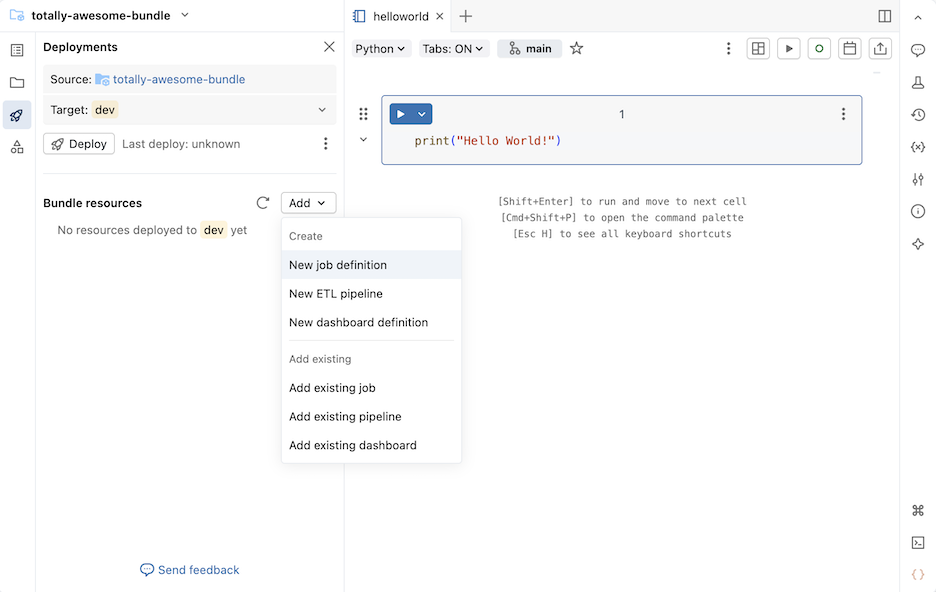

Clique no ícone de implantação do pacote para alternar para o painel Implantações.

-

Na seção "Recurso do pacote" , clique em "Adicionar" e, em seguida, escolha uma definição de recurso para criar.

Nova definição de emprego

Para criar um arquivo de configuração de pacote que define um trabalho:

-

Na seção Recursos do pacote do painel Implantações , clique em Adicionar e, em seguida, em Nova definição de trabalho .

-

Digite um nome para o trabalho no campo Job name da caixa de diálogo Create Job definition (Criar definição de trabalho ). Clique em Criar .

-

Adicione o código YAML ao arquivo de definição de tarefa que foi criado. O exemplo de YAML a seguir define um Job que executa um Notebook:

YAMLresources:

jobs:

run_notebook:

name: run-notebook

queue:

enabled: true

tasks:

- task_key: my-notebook-task

notebook_task:

notebook_path: ../helloworld.ipynb

Para obter detalhes sobre a definição de um trabalho em YAML, consulte Trabalho. Para obter a sintaxe YAML de outros tipos de tarefa de trabalho compatíveis, consulte Adicionar tarefa ao trabalho em Databricks ativo Bundles.

Nova definição pipeline

Se você habilitou o EditorLakeFlow Pipelines em seu workspace, consulte Novo pipeline ETL.

Para adicionar uma definição de pipeline ao seu pacote:

-

Na seção Recursos do pacote do painel Implantações , clique em Adicionar e, em seguida, em Nova definição pipeline .

-

Digite um nome para o pipeline no campo de nome do pipeline da caixa de diálogo Adicionar pipeline ao pacote existente .

-

Clique em Adicionar e instalado .

Para um pipeline com o nome test_pipeline que executa um Notebook, o seguinte YAML é criado em um arquivo test_pipeline.pipeline.yml:

resources:

pipelines:

test_pipeline:

name: test_pipeline

libraries:

- notebook:

path: ../test_pipeline.ipynb

serverless: true

catalog: main

target: test_pipeline_${bundle.environment}

Você pode modificar a configuração para executar um Notebook existente. Para obter detalhes sobre como definir um pipeline em YAML, consulte pipeline.

Novo pipeline ETL

Para adicionar uma nova definição de pipeline ETL:

-

Na seção Recursos do pacote do painel Implantações , clique em Adicionar e, em seguida, em Novo pipeline ETL .

-

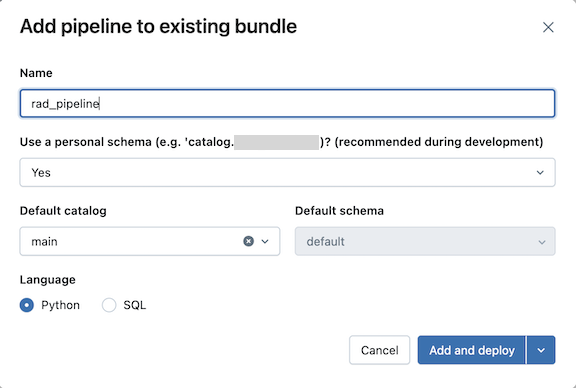

Digite um nome para o pipeline no campo Nome da caixa de diálogo Adicionar pipeline ao pacote existente . O nome deve ser único dentro do workspace.

-

No campo Usar esquema pessoal , selecione Sim para cenários de desenvolvimento e Não para cenários de produção.

-

Selecione um catálogo padrão e um esquema padrão para o site pipeline.

-

Escolha um idioma para o código-fonte do pipeline.

-

Clique em Adicionar e instalado .

-

Revise os detalhes na caixa de diálogo de confirmação de instalado para desenvolvimento e clique em instalado .

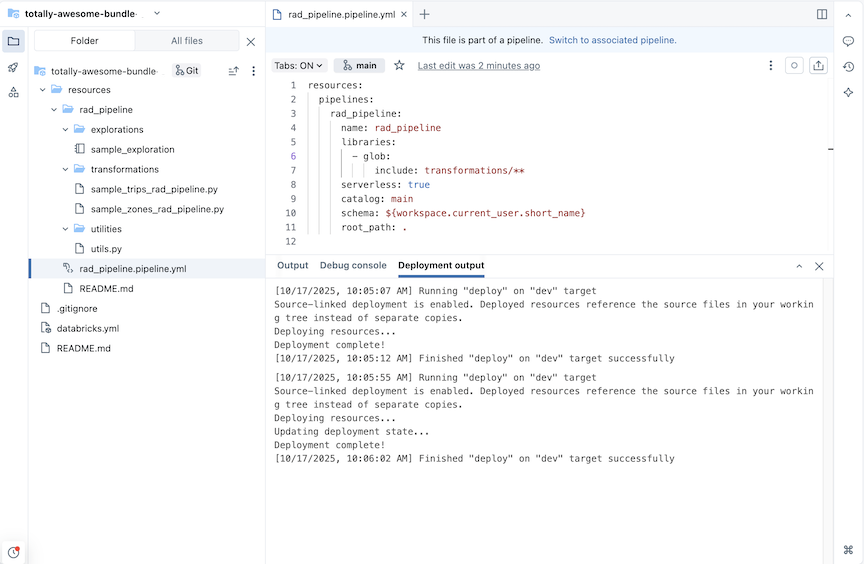

Um site ETL pipeline é criado com exemplos de tabelas de exploração e transformações.

Para um pipeline com o nome rad_pipeline, o seguinte YAML é criado em um arquivo rad_pipeline.pipeline.yml. Este pipeline está configurado para execução em compute serverless . Para obter informações sobre a configuração do pipeline, consulte pipeline.

resources:

pipelines:

rad_pipeline:

name: rad_pipeline

libraries:

- glob:

include: transformations/**

serverless: true

catalog: main

schema: ${workspace.current_user.short_name}

root_path: .

Nova definição de painel de controle

Para criar um arquivo de configuração de pacote que defina um painel de controle:

-

Na seção Recursos do pacote do painel Implantações , clique em Adicionar e, em seguida, em Nova definição de painel .

-

Digite um nome para o painel no campo Nome do painel da caixa de diálogo Adicionar painel a um pacote existente .

-

Selecione um armazém para o painel de controle. Clique em Adicionar e implantar .

Um novo painel vazio e um arquivo de configuração *.dashboard.yml são criados no pacote. O painel de controle é armazenado no repositório especificado no arquivo de configuração.

Para obter detalhes sobre painéis, consulte Painéis. Para obter informações sobre a sintaxe YAML para configuração do painel de controle, consulte painel de controle.

Adicionar um recurso existente a um pacote

Você pode adicionar recursos existentes ao seu pacote usando a interface do usuário workspace ou adicionando a configuração de recursos ao seu pacote.

Use a interface de usuário workspace do pacote.

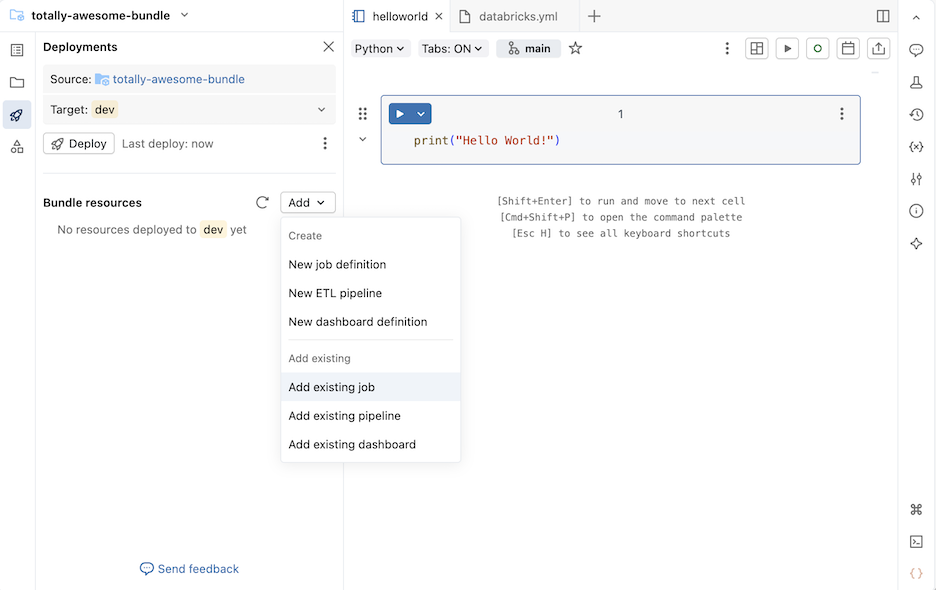

Para adicionar um Job, pipeline ou dashboard existente a um pacote:

- Navegue até a pasta do pacote no workspace onde você deseja adicionar um recurso.

Se o senhor já tiver aberto o pacote no editor em workspace, poderá usar a lista de contextos de criação do navegador workspace para navegar até a pasta do pacote. Consulte Contextos de criação.

-

À direita do nome do pacote, clique em Open in editor (Abrir no editor ) para navegar até o editor de pacotes view.

-

Clique no ícone de implantação do pacote para alternar para o painel Implantações.

-

Na seção Agrupar recursos , clique em Adicionar e, em seguida, clique em Adicionar tarefa existente , Adicionar pipelineexistente ou Adicionar painel existente .

-

Na caixa de diálogo Adicionar recurso existente... , selecione o recurso existente na lista suspensa.

-

Ao adicionar um recurso existente a um pacote, o Databricks cria uma definição para esse recurso em um arquivo de configuração do pacote. Como você pode modificar essa definição no pacote, o recurso definido no pacote pode divergir do recurso usado para criá-lo.

Escolha uma opção para lidar com as atualizações na configuração do recurso do pacote:

- Atualização na implantação de produção : O recurso existente torna-se vinculado ao recurso no pacote e quaisquer alterações que você fizer no recurso no pacote são aplicadas ao recurso existente quando você implanta no destino

prod. - Atualização sobre o desenvolvimento implantado : O recurso existente torna-se vinculado ao recurso no pacote e quaisquer alterações que você fizer no recurso no pacote serão aplicadas ao recurso existente quando você implantar no destino

dev. - (Avançado) Não atualizar : O recurso existente não está vinculado ao pacote. As alterações feitas no recurso dentro do pacote nunca são aplicadas ao recurso existente. Em vez disso, é criada uma cópia. Para obter mais informações sobre o recurso de pacote configurável de ligação ao seu recurso workspace correspondente, consulte databricks bundle implantação bind.

- Atualização na implantação de produção : O recurso existente torna-se vinculado ao recurso no pacote e quaisquer alterações que você fizer no recurso no pacote são aplicadas ao recurso existente quando você implanta no destino

-

Clique em Adicionar... para adicionar o recurso existente ao pacote.

Adicionar configuração de pacote

Um recurso existente também pode ser adicionado ao seu pacote definindo a configuração do pacote para incluí-lo na sua implantação. O exemplo a seguir adiciona um pipeline existente a um pacote.

Supondo que o senhor tenha um pipeline chamado taxifilter que executa o taxifilter.ipynb Notebook em seu workspace compartilhado:

-

Na barra lateral do site Databricks workspace, clique em Jobs & pipeline .

-

Opcionalmente, selecione os filtros pipeline e Owned by me .

-

Selecione o pipeline

taxifilterexistente. -

Na página do pipeline, clique no botão à esquerda do botão Modo de implantação de desenvolvimento . Em seguida, clique em view settings YAML .

-

Clique no ícone de cópia para copiar a configuração do pacote para o pipeline.

-

Navegue até seu pacote no espaço de trabalho .

-

Clique no ícone de implantação do pacote para alternar para o painel Implantações.

-

Na seção Bundle recurso , clique em Adicionar e depois em Nova definição pipeline .

Se, em vez disso, você vir um item de menu Novo pipeline ETL , então o EditorLakeFlow Pipelines está habilitado. Para adicionar um pipeline ETL a um pacote, consulte Criar um pipeline controlado por origem.

-

Digite

taxifilterno campo de nome do pipeline da caixa de diálogo Adicionar pipeline ao pacote existente . Clique em Criar . -

Cole a configuração do pipeline existente no arquivo. Este exemplo pipeline é definido para executar o

taxifilterNotebook:YAMLresources:

pipelines:

taxifilter:

name: taxifilter

catalog: main

libraries:

- notebook:

path: /Workspace/Shared/taxifilter.ipynb

target: taxifilter_${bundle.environment}

Agora, o senhor pode implantar o pacote e, em seguida, executar o recurso pipeline por meio da UI.