Arquitetura de alto nível

Este artigo fornece uma visão geral de alto nível da arquitetura Databricks, incluindo sua arquitetura empresarial, em combinação com AWS.

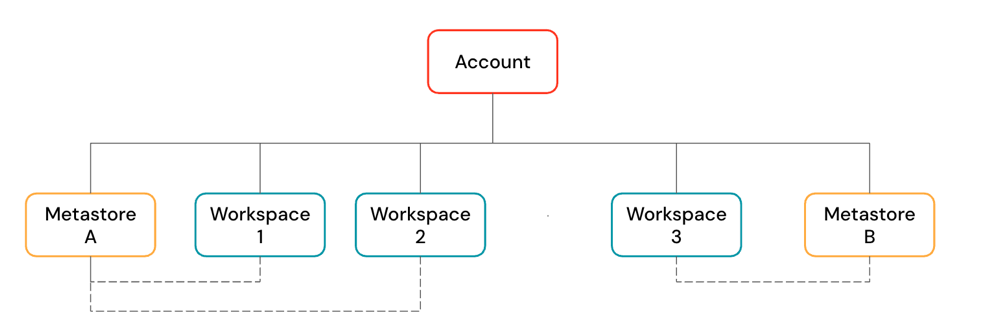

Objetos Databricks

Uma account Databricks é a construção de nível superior que você usa para gerenciar Databricks em toda a sua organização. No nível account , você gerencia:

-

Identidade e acesso: Usuários, grupos, entidade de serviço, provisionamento SCIM e configuração SSO .

-

gerenciamento de espaço de trabalho: crie, atualize e exclua espaços de trabalho em várias regiões.

-

Gerenciamento de metastore Unity Catalog : crie e anexe metastore ao espaço de trabalho.

-

Gerenciamento de uso: cobrança, compliance e políticas.

Uma account pode conter vários espaços de trabalho e metastores Unity Catalog .

-

O espaço de trabalho é o ambiente de colaboração onde os usuários executam cargas de trabalho compute , como ingestão, exploração interativa, tarefas agendadas e treinamento ML .

-

Os meta-storesUnity Catalog são o sistema de governança central para ativos de dados, como tabelas e modelos ML . Você organiza dados em um metastore sob um namespace de três níveis:

<catalog-name>.<schema-name>.<object-name>

Metastores são anexados ao espaço de trabalho. Você pode vincular um único metastore a vários espaços de trabalho Databricks na mesma região, dando a cada workspace a mesma view de dados. Os controles de acesso a dados podem ser gerenciados em todos os espaços de trabalho vinculados.

arquitetura do espaço de trabalho

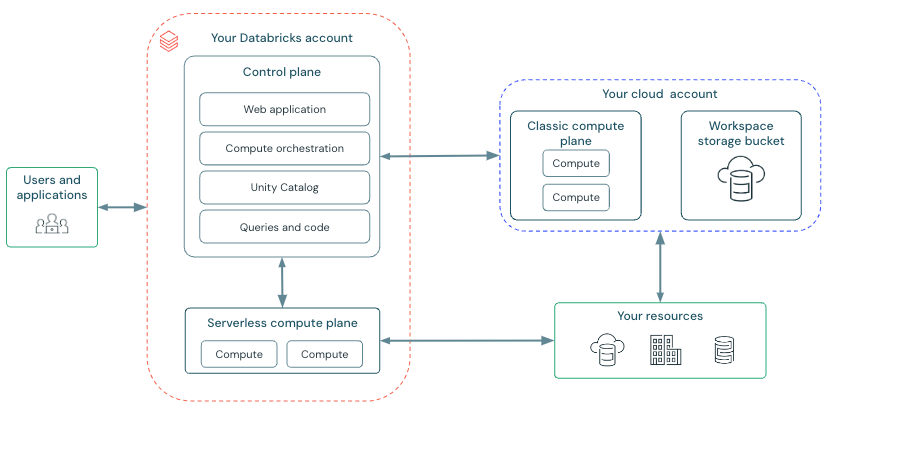

Databricks opera a partir de um plano de controle e de um planocompute .

-

O plano de controle inclui o serviço de backend que Databricks gerencia em sua account Databricks . O plano de controle está localizado na account Databricks , não na sua account cloud . A aplicação web está no plano de controle.

-

O planocompute é onde seus dados são processados. Há dois tipos de planos compute, dependendo do compute que o senhor estiver usando.

- Para serverless compute, o serverless compute recurso execução em um serverless compute plano em seu Databricks account.

- Para o clássico Databricks compute, o recurso compute está em seu AWS account no que é chamado de plano clássico compute . Isso se refere à rede em seu site AWS account e seu recurso.

Para saber mais sobre os sites clássicos compute e serverless compute, consulte computar.

Arquitetura clássica workspace

Os espaços de trabalho Databricks clássico possuem um bucket de armazenamento associado, conhecido como bucket de armazenamentoworkspace . O bucket de armazenamento workspace está na sua account AWS .

O diagrama a seguir descreve a arquitetura geral Databricks para o espaço de trabalho clássico.

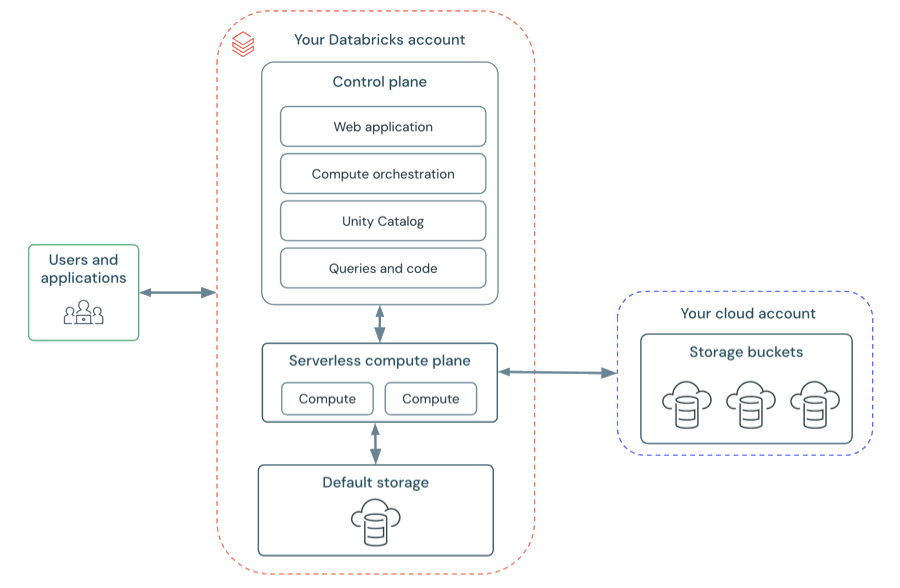

arquitetura workspace sem servidor

O armazenamento do espaço de trabalho no espaço de trabalho serverless é armazenado no armazenamento default do workspace. Você também pode se conectar à sua account de armazenamento cloud para acessar seus dados. O diagrama a seguir descreve a arquitetura geral do espaço de trabalho serverless .

sem servidor compute plane

No plano serverless compute , Databricks compute recurso execução em uma camada compute dentro do seu Databricks account. Databricks cria um plano serverless compute na mesma região AWS que o plano workspace clássico compute do senhor. O senhor seleciona essa região ao criar um workspace.

Para proteger os dados do cliente dentro do plano serverless compute , serverless compute execução dentro de um limite de rede para o workspace, com várias camadas de segurança para isolar diferentes espaços de trabalho do cliente Databricks e controles de rede adicionais entre clusters o mesmo cliente.

Para saber mais sobre a rede no plano serverless compute , a rede no plano compute sem servidor.

Clássico compute avião

No plano clássico compute, Databricks compute recurso execução em seu AWS account. Novos recursos compute são criados dentro de cada rede virtual workspace no site AWS account do cliente.

Um avião clássico compute tem isolamento natural porque é executado no próprio AWS account de cada cliente. Para saber mais sobre a rede no plano compute clássico, consulte Rede no plano compute clássico.

Para obter suporte regional, consulte Databricks clouds e regiões.

armazenamento de espaço de trabalho

O armazenamento do espaço de trabalho é tratado de forma diferente dependendo do tipo do seu workspace . Para obter mais informações sobre os tipos workspace , consulte Criar um workspace.

espaço de trabalho sem servidor

O espaço de trabalho sem servidor usa o armazenamento default , que é um local de armazenamento totalmente específico para dados internos do sistema workspace e dados ativos Unity Catalog . O espaço de trabalho sem servidor também oferece suporte à capacidade de se conectar aos seus locais de armazenamento cloud para seus próprios catálogos, tabelas e outros dados ativos. Veja o armazenamento padrão no Databricks.

Espaço de trabalho clássico

O espaço de trabalho clássico exige que você forneça um bucket S3 e um prefixo para usar como bucket de armazenamento workspace . Este bucket S3 conterá:

- dados do sistema de espaço de trabalho: os dados do sistema de espaço de trabalho são gerados conforme você usa vários recursos Databricks , como a criação do Notebook. Este bucket inclui revisões do Notebook, detalhes de execução do Job, resultados do comando e logs Spark

- Catálogo workspace Unity Catalog : se o seu workspace foi habilitado para Unity Catalog automaticamente, o bucket de armazenamento workspace contém o catálogo workspace default . Todos os usuários no seu workspace podem criar ativos no esquema default neste catálogo. Veja Comece com Unity Catalog.

- DBFS (legado): DBFS root e as montagens DBFS são legadas e podem estar desabilitadas no seu workspace. DBFS (Databricks File System) é um sistema de arquivos distribuído em ambientes Databricks acessível sob o namespace

dbfs:/. DBFS root e as montagens DBFS estão ambas no namespacedbfs:/. Armazenar e acessar o uso de dados DBFS root ou montagens DBFS é um padrão obsoleto e não recomendado pelo Databricks. Para mais informações, consulte O que é DBFS?.