O que é LakeFlow Connect?

LakeFlow Connect oferece conectores simples e eficientes para ingerir dados de arquivos locais, aplicativos corporativos populares, bancos de dados, armazenamento em nuvem, barramentos de mensagens e muito mais. Esta página descreve algumas das maneiras pelas quais a LakeFlow Connect pode melhorar o desempenho da ETL. Ele também abrange casos de uso comuns e a variedade de ferramentas de ingestão compatíveis, desde conectores totalmente gerenciados até estruturas totalmente personalizáveis.

Modelos flexíveis de serviços

LakeFlow Connect oferece uma ampla gama de conectores para aplicativos corporativos, armazenamento em nuvem, bancos de dados, barramentos de mensagens e muito mais. Também oferece a flexibilidade de escolher entre as seguintes opções:

Opção | Descrição |

|---|---|

Um serviço totalmente gerenciado | Conectores prontos para uso que democratizam o acesso aos dados com UIs simples e APIs avançadas. Isso permite que o senhor crie rapidamente um pipeline de ingestão robusto e, ao mesmo tempo, minimize os custos de manutenção de longo prazo. |

Um pipeline personalizado | Se você precisar de mais personalização, pode usar o pipeline declarativo LakeFlow Spark ou a transmissão estruturada. Em última análise, essa versatilidade permite que LakeFlow Connect atenda às necessidades específicas da sua organização. |

Unificação com as principais ferramentas do Databricks

LakeFlow Connect usa o núcleo Databricks recurso para fornecer gerenciamento abrangente de dados. Por exemplo, ele oferece governança usando Unity Catalog, orquestração usando LakeFlow Jobs e monitoramento holístico em todo o seu pipeline. Isso ajuda sua organização a gerenciar a segurança, a qualidade e o custo dos dados, unificando os processos de ingestão com outras ferramentas de engenharia de dados. LakeFlow Connect foi desenvolvido em uma plataforma de inteligência de dados aberta, com total flexibilidade para incorporar suas ferramentas preferidas de terceiros. Isso garante soluções personalizadas que se alinham à sua infraestrutura existente e às estratégias de dados futuras.

Ingestão rápida e escalável

LakeFlow Connect usa leituras e gravações incrementais para permitir uma ingestão eficiente. Quando combinado com transformações incrementais downstream, isso pode melhorar significativamente o desempenho do ETL.

Casos de uso comuns

Os clientes ingerem dados para resolver os problemas mais desafiadores de suas organizações. Exemplos de casos de uso incluem o seguinte:

Caso de uso | Descrição |

|---|---|

Medir o desempenho da campanha e a pontuação de leads de clientes | |

Maximizando o ROI com modelos históricos e de previsão | |

Personalizando as experiências de compra de seus clientes | |

Recurso humano centralizado | Apoiando a força de trabalho da sua organização |

Aumento da eficiência de fabricação | |

Criar chatbots para ajudar os usuários a entender políticas, produtos e muito mais |

Camadas da pilha ETL

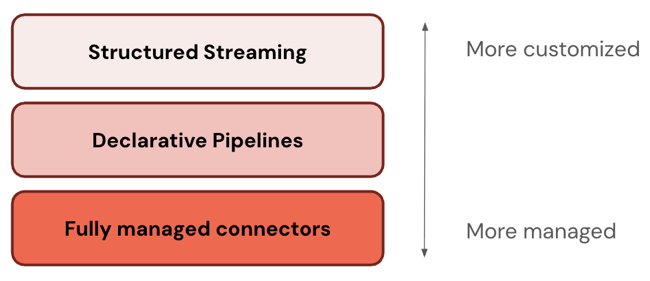

Alguns conectores operam em um nível da pilha ETL. Por exemplo, Databricks oferece conectores totalmente gerenciáveis para aplicativos corporativos como o Salesforce e bancos de dados como SQL Server. Outros conectores operam em múltiplas camadas da pilha ETL. Por exemplo, você pode usar conectores padrão tanto na transmissão estruturada para personalização completa quanto no pipeline declarativo LakeFlow Spark para uma experiência mais gerenciada. Da mesma forma, você pode escolher o nível de personalização para os dados de transmissão do Apache Kafka, Amazon Kinesis, Google Pub/Sub e Apache Pulsar.

Databricks recomenda começar com a camada mais gerenciável. Se ele não atender aos seus requisitos (por exemplo, se não for compatível com sua fonte de dados), passe para a próxima camada. A Databricks planeja expandir o suporte para mais conectores em todas as três camadas.

A tabela a seguir descreve as três camadas do produto de ingestão, ordenadas da mais personalizável para a mais gerenciável:

Camada | Descrição |

|---|---|

transmissão estructurada é um API para processamento de transmissão incremental em tempo quase real. Ele oferece excelente desempenho, escalabilidade e tolerância a falhas. | |

O pipeline declarativo LakeFlow Spark baseia-se na transmissão estruturada, oferecendo uma estrutura declarativa para a criação de pipeline de dados. Você pode definir as transformações a serem realizadas em seus dados, e o pipeline declarativo LakeFlow Spark gerencia orquestração, monitoramento, qualidade de dados, erros e muito mais. Portanto, oferece mais automação e menos custos indiretos do que a transmissão estruturada. | |

conectores gerenciados construídos no pipeline declarativo LakeFlow Spark , oferecendo ainda mais automação para a fonte de dados mais popular. Eles ampliam a funcionalidade do pipeline declarativo LakeFlow Spark para incluir também autenticação específica da fonte, CDC Detecção de Criptografia de Conteúdo), tratamento de casos extremos, manutenção API a longo prazo, novas tentativas automatizadas, evolução automatizada do esquema e assim por diante. Portanto, oferecem ainda mais automação para qualquer fonte de dados compatível. |

gerenciar conectores

O senhor pode usar conectores totalmente gerenciados para fazer a ingestão de aplicativos e bancos de dados corporativos.

Os conectores compatíveis incluem:

As interfaces suportadas incluem:

- IU da Databricks

- Databricks Asset Bundles

- APIs da Databricks

- SDKs da Databricks

- CLI do Databricks

Conectores padrão

Além dos conectores gerenciáveis, o site Databricks oferece conectores personalizáveis para armazenamento de objetos na nuvem e barramentos de mensagens. Consulte Conectores padrão em LakeFlow Connect.

Arquivo upload e download

O senhor pode ingerir arquivos que residem na sua rede local, arquivos que foram carregados em um volume ou arquivos que foram baixados de um local na Internet. Veja os arquivos.

Ingestão de parceiros

Muitas ferramentas de terceiros suportam a ingestão de lotes ou transmissão em Databricks. A Databricks valida várias integrações de terceiros, embora as etapas para configurar o acesso aos sistemas de origem e ingerir dados variem de acordo com a ferramenta. Consulte Parceiros de ingestão para obter uma lista de ferramentas validadas. Alguns parceiros tecnológicos também são apresentados no Databricks Partner Connectque tem uma interface de usuário que simplifica a conexão de ferramentas de terceiros aos dados da lakehouse.

Ingestão DIY

Databricks fornece uma plataforma compute geral. Como resultado, o senhor pode criar seus próprios conectores de ingestão usando qualquer linguagem de programação suportada pela Databricks, como Python ou Java. O senhor também pode importar e usar uma biblioteca de conectores de código aberto popular, como a ferramenta de carregamento de dados, o Airbyte e o Debezium.

Alternativas de ingestão

Databricks recomenda a ingestão para a maioria dos casos de uso porque ela se adapta a grandes volumes de dados, consultas de baixa latência e limites de API de terceiros. A ingestão copia dados de seus sistemas de origem para o Databricks, o que resulta em dados duplicados que podem se tornar obsoletos com o tempo. Se não quiser copiar dados, você pode usar as seguintes ferramentas:

Ferramenta | Descrição |

|---|---|

Federação lakehouse | Permite que o senhor consulte fontes de dados externas sem mover seus dados. |

Delta Sharing | Permite que você compartilhe dados com segurança entre plataformas, nuvens e regiões. |