Crie seu primeiro fluxo de trabalho com LakeFlow Jobs

Este artigo demonstra o uso do LakeFlow Jobs para orquestrar a tarefa de ler e processar uma amostra do dataset. Neste guia de início rápido, você:

- Cria um novo notebook e adiciona código para recuperar um conjunto de dados de amostra contendo nomes de bebês populares por ano.

- Salve a amostra dataset em Unity Catalog.

- Crie um novo Notebook e adicione um código para ler o site dataset de Unity Catalog, filtrá-lo por ano e exibir os resultados.

- Cria um novo job e configura duas tarefas utilizando os notebooks.

- Execute o job e veja os resultados.

Requisitos

Se o seu workspace estiver habilitado para o Unity Catalog e o serverless Jobs estiver habilitado, em default, a execução do Job no serverless compute. O senhor não precisa de permissão de criação de clustering para executar seu trabalho com o serverless compute.

Caso contrário, o senhor deve ter permissão de criação de clustering para criar o Job compute ou permissões para todos os fins do recurso compute.

O senhor deve ter um volume no Unity Catalog. Este artigo usa um volume de exemplo chamado my-volume em um esquema chamado default em um catálogo chamado main. O senhor deve ter as seguintes permissões no Unity Catalog:

READ VOLUMEeWRITE VOLUMEpara o volumemy-volumeUSE SCHEMApara o esquemadefaultUSE CATALOGpara o catálogomain

Para definir essas permissões, consulte o administrador do Databricks ou os privilégios e objetos protegidos do Unity Catalog.

Criar Notebook

Os passos a seguir criam dois Notebook para execução nesse fluxo de trabalho.

Recupere e salve dados

Para criar um Notebook que recupera a amostra dataset e a salva em Unity Catalog:

-

Clique em

New na barra lateral e, em seguida, clique em Notebook . Databricks cria e abre um Notebook novo e em branco na pasta default. O idioma default é o idioma usado mais recentemente, e o Notebook é automaticamente anexado ao recurso compute usado mais recentemente.

-

(Opcional) Renomear o Notebook Recuperar dados de nome .

-

Se necessário, altere o idioma default para Python.

-

Copie o seguinte código Python e cole-o na primeira célula do notebook.

Pythonimport requests

response = requests.get('https://health.data.ny.gov/api/views/jxy9-yhdk/rows.csv')

csvfile = response.content.decode('utf-8')

dbutils.fs.put("/Volumes/main/default/my-volume/babynames.csv", csvfile, True)

Leia e exiba dados filtrados

Para criar um Notebook que filtre e exiba seus dados:

-

Clique em

New na barra lateral e, em seguida, clique em Notebook .

-

(Opcional) Renomeie os dados de nome do Notebook Filter.

-

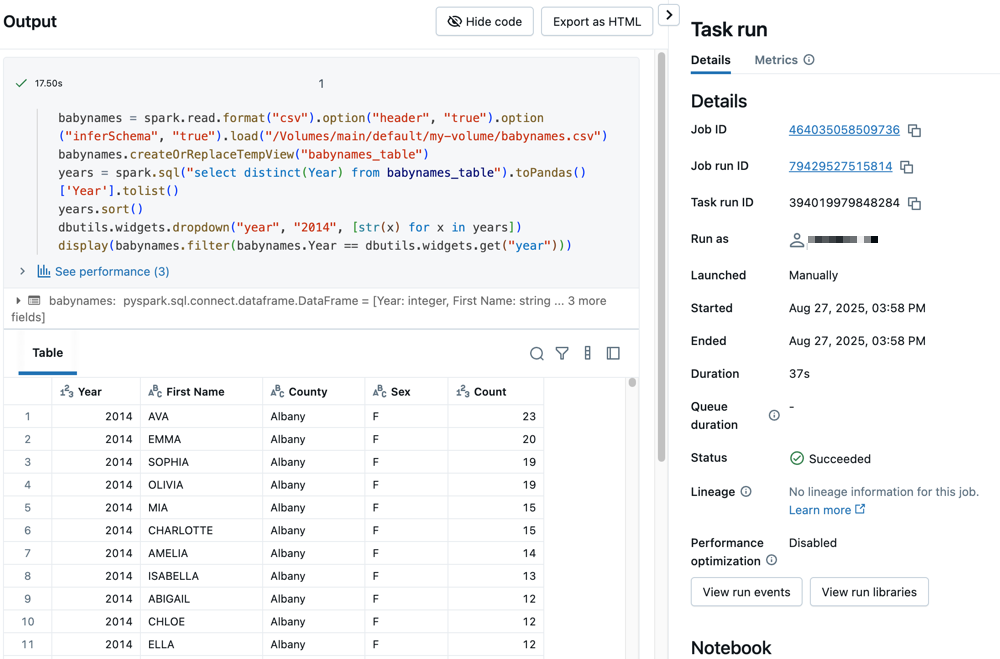

O código Python a seguir lê os dados que o senhor salvou no passo anterior e cria uma tabela. Ele também cria um widget que você pode usar para filtrar os dados na tabela.

Pythonbabynames = spark.read.format("csv").option("header", "true").option("inferSchema", "true").load("/Volumes/main/default/my-volume/babynames.csv")

babynames.createOrReplaceTempView("babynames_table")

years = spark.sql("select distinct(Year) from babynames_table").toPandas()['Year'].tolist()

years.sort()

dbutils.widgets.dropdown("year", "2014", [str(x) for x in years])

display(babynames.filter(babynames.Year == dbutils.widgets.get("year")))

Criar um trabalho

O trabalho que o senhor está criando consiste em duas tarefas.

Para criar a primeira tarefa:

- Em seu site workspace, clique em

Jobs & pipeline na barra lateral.

- Clique em Create e depois em Job .

- Clique no bloco Bloco Notebook para configurar a primeira tarefa. Se o bloco Bloco Notebook não estiver disponível, clique em Adicionar outro tipo de tarefa e pesquise por Notebook .

- (Opcional) Substitua o nome do Job, cujo padrão é

New Job <date-time>pelo seu nome de trabalho. - No campo Nome da tarefa , insira um nome para a tarefa; por exemplo, recuperar nomes de bebês .

- Se necessário, selecione Notebook no menu suspenso Type (Tipo ).

- No menu suspenso Source (Fonte ), selecione workspace (espaço de trabalho ), o que lhe permite usar um Notebook salvo anteriormente.

- Para Path , use o navegador de arquivos para localizar o primeiro Notebook que o senhor criou, clique no nome do Notebook e clique em Confirm (Confirmar ).

- Clique em Criar tarefa . Uma notificação aparece no canto superior direito da tela.

Para criar a segunda tarefa:

- Clique em + Add tarefa >. Notebook .

- No campo Nome da tarefa , insira um nome para a tarefa; por exemplo, filtrar-nomes-bebe .

- Para Path (Caminho ), use o navegador de arquivos para localizar o segundo Notebook que o senhor criou, clique no nome do Notebook e clique em Confirm (Confirmar ).

- Clique em Adicionar em Parâmetros . No campo Chave , digite

year. No campo Valor , digite2014. - Clique em Criar tarefa .

execução do trabalho

Para executar o trabalho imediatamente, clique em no canto superior direito.

ver detalhes da execução

-

Clique na execução tab e clique no link na coluna começar time para abrir a execução que o senhor deseja view.

-

Clique em uma das tarefas para ver o resultado e os detalhes. Por exemplo, clique na tarefa filter-baby-names para acessar view os detalhes de saída e execução da tarefa de filtro:

execução com diferentes parâmetros

Para executar novamente o job e filtrar nomes de bebês de outro ano:

- Clique em

ao lado de executar agora e selecione executar agora com configurações diferentes .

- No campo Valor , digite

2015. - Clique em Executar .