チュートリアル: Classic コンピュートの PyCharm から Code を実行する

この記事は、Databricks Runtime 13.3 LTS 以降の Databricks Connect に適用されます。

Databricks Connect を使用すると、PyCharmのような人気のIDE、ノートブックサーバー、その他のカスタムアプリケーションをDatabricksの計算資源に接続できます。「Databricks Connect とは」を参照してください。

この記事では、 PyCharm を使用して Databricks Connect for Python をすばやく開始する方法を示します。PyCharmでプロジェクトを作成し、Databricks Runtime 13.3 LTS以降のDatabricks Connectをインストールし、 実行 PyCharmからDatabricksワークスペースでクラシックコンピュートで簡単なコードを実行します。

必要条件

このチュートリアルを完了するには、以下の条件を満たす必要があります。

- ワークスペース、ローカル環境、コンピュートは、PythonのDatabricks Connectの要件を満たしています。「 Databricks Connect の使用要件」を参照してください。

- PyCharmがインストールされている。このチュートリアルは、PyCharm Community Edition 2023.3.5でテストされました。PyCharm の別のバージョンまたはエディションを使用している場合、次の手順が異なる場合があります。

- クラシックコンピュートを使用している場合は、クラスターのIDが必要になります。 クラスター ID を取得するには、ワークスペースでサイドバーの [コンピュート ] をクリックし、クラスターの名前をクリックします。 Web ブラウザーのアドレス バーで、URL の

clustersとconfigurationの間の文字列をコピーします。

手順 1: Databricks 認証を構成する

このチュートリアルでは、Databricks OAuth ユーザーマシン間 (U2M) 認証 と Databricks 構成プロファイル を使用して、Databricks ワークスペースを認証します。別の認証タイプを使用するには、「 接続プロパティの構成」を参照してください。

OAuth U2M 認証を構成するには、Databricks CLI が必要です。情報 Databricks CLIのインストールについては、 Databricks CLIのインストールまたは更新を参照してください。

次のように、OAuth U2M認証を開始します。

-

Databricks CLI を使用して、ターゲット ワークスペースごとに次のコマンドを実行して、ローカルで OAuth トークン管理を開始します。

次のコマンドで、

<workspace-url>をhttps://1234567890123456.7.gcp.databricks.comのような Databricks ワークスペース インスタンスの URL に置き換えます。Bashdatabricks auth login --configure-cluster --host <workspace-url>

サーバレス コンピュートを Databricks Connectで使用するには、「 サーバレス コンピュートへの接続を設定する」を参照してください。

-

Databricks CLI では、入力した情報を Databricks 構成プロファイルとして保存するように求められます。

Enterを押して、提案されたプロファイル名を受け入れるか、新規または既存のプロファイルの名前を入力します。同じ名前の既存のプロファイルは、入力した情報で上書きされます。プロファイルを使用して、複数のワークスペース間で認証コンテキストをすばやく切り替えることができます。既存のプロファイルの一覧を取得するには、別のターミナルまたはコマンド プロンプトで、Databricks CLI を使用してコマンド

databricks auth profilesを実行します。特定のプロファイルの既存の設定を表示するには、コマンドdatabricks auth env --profile <profile-name>を実行します。 -

Webブラウザで、画面の指示に従ってDatabricksワークスペースにログインします。

-

ターミナル プロンプトまたはコマンド プロンプトに表示される使用可能なクラスターの一覧で、上方向キーと下方向キーを使用してワークスペース内のターゲット クラスター Databricks を選択し、

Enterキーを押します。 クラスターの表示名の任意の部分を入力して、使用可能なクラスターの一覧をフィルター処理することもできます。 -

プロファイルの現在の OAuth トークン値とトークンの今後の有効期限タイムスタンプを表示するには、次のいずれかのコマンドを実行します。

databricks auth token --host <workspace-url>databricks auth token -p <profile-name>databricks auth token --host <workspace-url> -p <profile-name>

同じ

--host値を持つプロファイルが複数ある場合、Databricks CLIが正しいOAuthトークン情報を見つけられるように--hostと-pオプションを一緒に指定する必要がある場合があります。

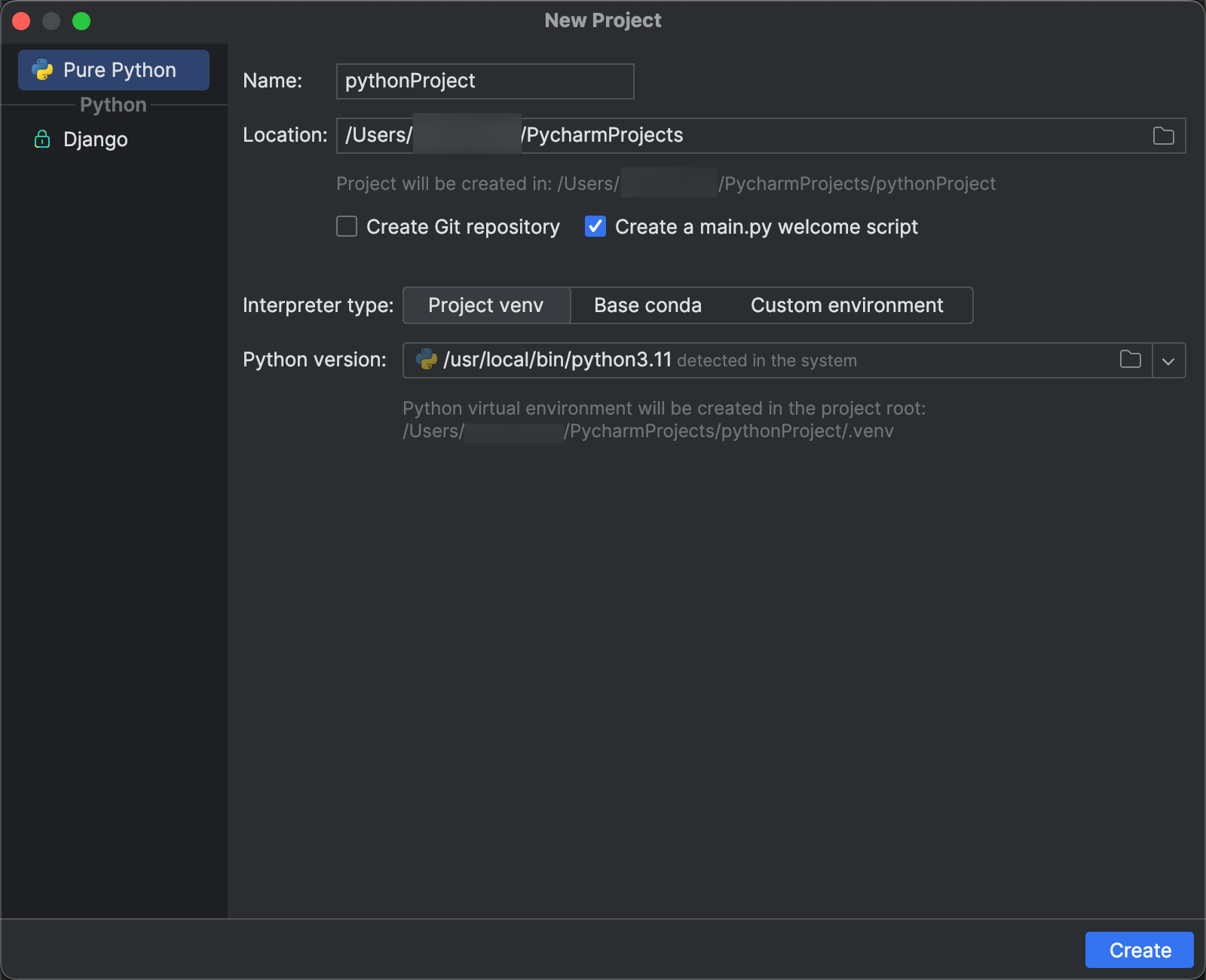

ステップ 2: プロジェクトを作成する

- PyCharmを起動します。

- メインメニューで、 [ファイル] > [新しいプロジェクト] をクリックします。

- [新しいプロジェクト] ダイアログで、 [Pure Python] をクリックします。

- [場所] には、フォルダーアイコンをクリックし、画面上の指示に従って新しいPythonプロジェクトへのパスを指定します。

- [main.py welcomeスクリプトを作成] は選択したままにしておきます。

- [インタープリターのタイプ] では [Project venv] をクリックします。

- [Pythonのバージョン] を展開し、フォルダアイコンまたはドロップダウンリストを使用して、前述の要件にあるPythonインタープリターへのパスを指定します。

- 作成 をクリックします。

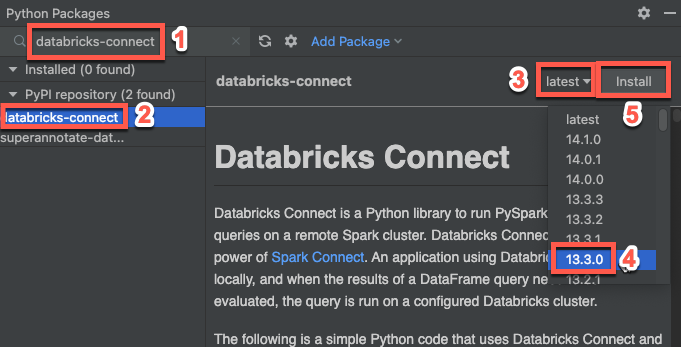

手順 3: Databricks Connect パッケージを追加する

- PyCharmのメインメニューで、[ ツール>表示] Windows > Python [パッケージ] をクリックします。

- 検索ボックスに「

databricks-connect」と入力します。 - [PyPIリポジトリ] のリストから [databricks-connect] をクリックします。

- 結果ペインの 最新の ドロップダウンリストで、クラスターの Databricks Runtime バージョンに一致するバージョンを選択します。 たとえば、クラスターに Databricks Runtime 14.3 がインストールされている場合は、 14.3.1 を選択します。

- [パッケージのインストール] をクリックします。

- パッケージがインストールされたら、 [Pythonパッケージ] のウィンドウを閉じてかまいません。

ステップ 4: コードを追加する

-

[プロジェクト ツール] ウィンドウで、プロジェクトのルート フォルダーを右クリックし、[ Python ファイル>新規 作成] をクリックします。

-

main.pyと入力し、 [Pythonファイル] をダブルクリックします。 -

構成プロファイルの名前に応じて、以下のコードをファイルに入力し、ファイルを保存します。

ステップ1の構成プロファイルが

DEFAULTという名前である場合は、次のコードをファイルに入力して、ファイルを保存します。Pythonfrom databricks.connect import DatabricksSession

spark = DatabricksSession.builder.getOrCreate()

df = spark.read.table("samples.nyctaxi.trips")

df.show(5)ステップ1の構成プロファイルが

DEFAULTという名前でない場合は、代わりに次のコードをファイルに入力します。プレースホルダー<profile-name>をステップ1で作成した構成プロファイルの名前に置き換えて、ファイルを保存します。Pythonfrom databricks.connect import DatabricksSession

spark = DatabricksSession.builder.profile("<profile-name>").getOrCreate()

df = spark.read.table("samples.nyctaxi.trips")

df.show(5)

ステップ 5: コードを実行する

- リモートのDatabricksワークスペースでターゲット・クラスターを開始します。

- クラスターが開始されたら、メイン メニューで [実行] > [実行 'main] をクリックします。

- 実行 ツールウィンドウ (実行タブのメイン ペインに 実行タブ Windows >> 最初の 5

samples.nyctaxi.trips行が表示されます。

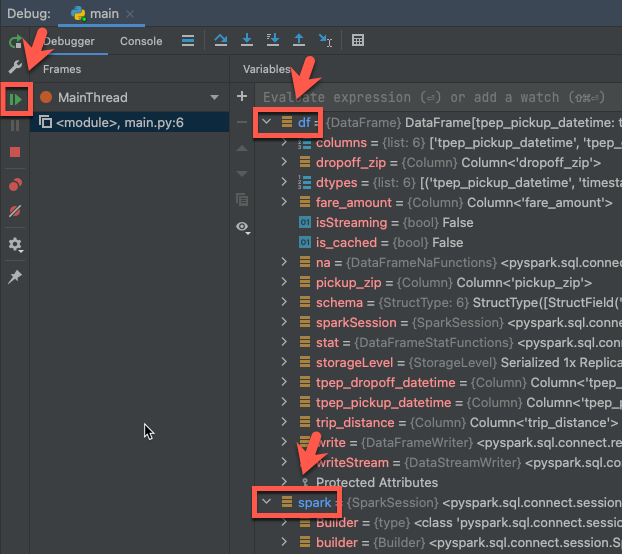

手順 6: コードをデバッグする

- クラスターが実行されている状態で、前のコードで、

df.show(5)の横のガターをクリックしてブレークポイントを設定します。 - メインメニューで、[ 実行]> [デバッグ 'main' ] をクリックします。

- [ デバッグ ツール] ウィンドウ ([ > ツールの表示] Windows > [デバッグ ]) の [デバッガー ] タブの [変数] ウィンドウで、 df 変数ノードと spark 変数ノードを展開して、コードの

df変数とspark変数に関する情報を参照します。 - デ バッグツール ウィンドウのサイドバーで、緑色の矢印( プログラムの再開 )アイコンをクリックします。

- [ デバッガ] タブの [コンソール ] ペインに、

samples.nyctaxi.tripsの最初の 5 行が表示されます。