チュートリアル: Visual Studio CodeのDatabricks拡張を用いた、クラスター上およびジョブとしてのPythonの実行

このチュートリアルでは、Visual Studio Code のDatabricks 拡張機能を設定し、DatabricksクラスターでPython を実行し、リモート ワークスペースで ジョブとして実行する方法について説明します。Visual Studio Code の Databricks 拡張機能とはを参照してください。

必要条件

このチュートリアルでは、次のことが必要です。

- Visual Studio Code 用の Databricks 拡張機能をインストールていること。 Visual Studio Code の Databricks 拡張機能のインストールを参照してください。

- 使用するリモート Databricks クラスターがあります。 クラスターの名前をメモします。 利用可能なクラスターを表示するには、 Databricks ワークスペースのサイドバーで[ コンピュート ]をクリックします。 コンピュートを参照してください。

手順 1: 新しい Databricks プロジェクトを作成する

この手順では、新しい Databricks プロジェクトを作成し、リモート Databricks ワークスペースとの接続を構成します。

- Visual Studio Code を起動し、 ファイル > フォルダーを開く をクリックして、ローカルの開発マシンで空のフォルダーを開きます。

- サイドバーで、 Databricks のロゴアイコンをクリックします。 これにより、Databricks 拡張機能が開きます。

- 設定 ビューで、 設定の作成 をクリックします。

- Databricks ワークスペースを構成するための コマンド パレット が開きます。 Databricks Host で、ワークスペース インスタンスの URL (

https://1234567890123456.7.gcp.databricks.comなど) を入力または選択します。 - プロジェクトの認証プロファイルを選択します。 Visual Studio Code の Databricks 拡張機能の承認を設定するを参照してください。

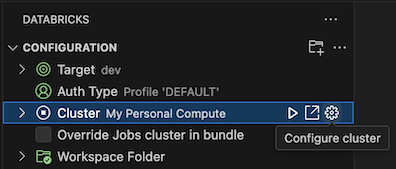

手順 2: クラスター情報を Databricks 拡張機能に追加し、クラスターを開始する

-

設定 ビューがすでに開いている状態で、 クラスターの選択 をクリックするか、歯車 ( クラスターの設定 ) アイコンをクリックします。

-

コマンド パレット で、前に作成したクラスターの名前を選択します。

-

クラスターが開始していない場合には、再生アイコン( クラスターの起動 )をクリックします。

ステップ 3: Python コードを作成して実行する

-

ローカルのPythonコードファイルを作成する:サイドバーで、フォルダ( エクスプローラー )アイコンをクリックします。

-

メイン メニューで、 ファイル > 新しいファイル をクリックし、Python ファイルを選択します。ファイルに demo.py という名前を付け、プロジェクトのルートに保存します。

-

以下のコードをファイルに追加し、保存します。このコードは、基本的なPySparkデータフレームを作成し、その内容を表示するコードです。

Pythonfrom pyspark.sql import SparkSession

from pyspark.sql.types import *

spark = SparkSession.builder.getOrCreate()

schema = StructType([

StructField('CustomerID', IntegerType(), False),

StructField('FirstName', StringType(), False),

StructField('LastName', StringType(), False)

])

data = [

[ 1000, 'Mathijs', 'Oosterhout-Rijntjes' ],

[ 1001, 'Joost', 'van Brunswijk' ],

[ 1002, 'Stan', 'Bokenkamp' ]

]

customers = spark.createDataFrame(data, schema)

customers.show()Output# +----------+---------+-------------------+

# |CustomerID|FirstName| LastName|

# +----------+---------+-------------------+

# | 1000| Mathijs|Oosterhout-Rijntjes|

# | 1001| Joost| van Brunswijk|

# | 1002| Stan| Bokenkamp|

# +----------+---------+-------------------+ -

エディター タブの一覧の横にある Databricks で実行 アイコンをクリックし、 ファイルのアップロードと実行 をクリックします。 出力が デバッグコンソール ビューに表示されます。

または、 エクスプローラー ビューで

demo.pyファイルを右クリックし、 Databricks で実行 > ファイルのアップロードと実行 をクリックします。

ステップ 4: コードをジョブとして実行する

demo.py をジョブとして実行するには、エディタ タブのリストの横にある Databricksで実行 アイコンをクリックし、 ワークフローとしてファイルを実行 をクリックします。出力は、 demo.py ファイルエディタの横にある別のエディタタブに表示されます。

![]()

または、 エクスプローラー パネルで demo.py ファイルを右クリックし、 Databricks で実行 > ファイルをワークフローとして実行 を選択します。

次のステップ

Visual Studio Code の Databricks 拡張機能を正常に使用してローカルの Python ファイルをアップロードし、リモートで実行したので、次の操作も実行できます。

- 拡張機能 UI を使用して、Databricks Asset Bundles のリソースと変数を探索します。 Databricks Asset Bundles 拡張機能を参照してください。

- Databricks Connect を使用して Python コードを実行またはデバッグします。 Visual Studio Code の Databricks 拡張機能については、Databricks Connect を使用したコードのデバッグを参照してください。

- ファイルまたはノートブックを Databricks ジョブとして実行します。 Databricks で Visual Studio Code の Databricks 拡張機能を使用して、クラスターまたはファイルまたはノートブックをジョブとしてファイルを実行するを参照してください。

pytestを使用してテストを実行します。「Visual Studio Code の Databricks 拡張機能を使用して Python テストを実行する」を参照してください。