Lakeflowコネクト のマネージド コネクタ

Lakeflowコネクト のマネージド コネクタは、さまざまなリリース状態にあります。

このページでは、 SaaSアプリケーションおよびデータベースからデータを取り込むためのDatabricks LakeFlow Connectのマネージド コネクタの概要を説明します。 結果として得られる取り込みパイプラインはUnity Catalogによって管理され、サーバレス コンピュートとLakeFlow Spark宣言型パイプラインによって強化されます。 マネージド コネクタは、効率的な増分読み取りと書き込みを活用して、データの取り込みをより高速かつスケーラブルでコスト効率の高いものにすると同時に、データを下流での使用に備えて最新の状態に維持します。

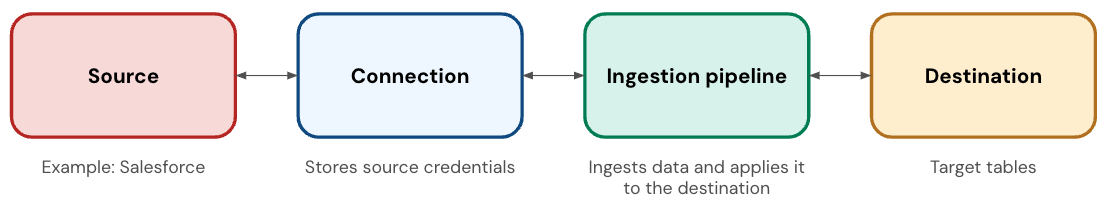

SaaS コネクタ コンポーネント

SaaS コネクタには、次のコンポーネントがあります。

コンポーネント | 説明 |

|---|---|

接続 | アプリケーションの認証の詳細を格納する Unity Catalog のセキュリティ保護可能なオブジェクト。 |

取り込みパイプライン | アプリケーションから送信先テーブルにデータをコピーするパイプライン。この取り込みパイプラインはサーバレスコンピュートで実行されます。 |

宛先テーブル | 取り込み パイプラインがデータを書き込むテーブル。これらは ストリーミングテーブルであり、増分データ処理の追加サポートを備えた Delta テーブルです。 |

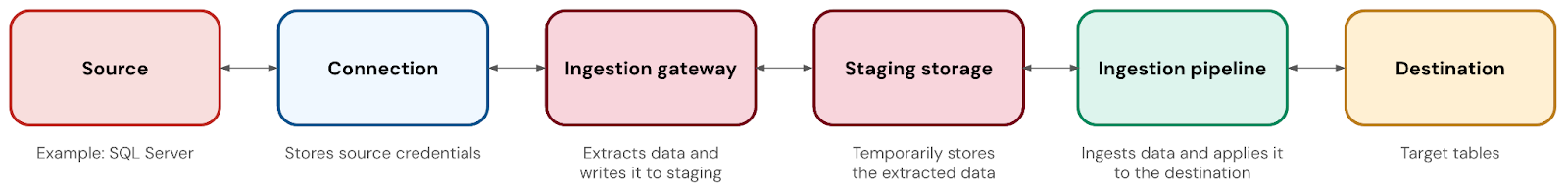

データベースコネクタコンポーネント

データベースコネクタには、次のコンポーネントがあります。

コンポーネント | 説明 |

|---|---|

接続 | データベースの認証の詳細を格納する Unity Catalog のセキュリティ保護可能なオブジェクト。 |

取り込みゲートウェイ | ソース データベースからスナップショット、変更ログ、メタデータを抽出するパイプライン。ゲートウェイは従来のコンピュートで実行され、ソースで変更ログを切り捨てる前に変更をキャプチャするために継続的に実行されます。 |

ステージング・ストレージ | 抽出されたデータを宛先テーブルに適用する前に一時的に保存する Unity Catalog ボリューム。これにより、ゲートウェイが継続的に変更をキャプチャしている場合でも、任意のスケジュールで取り込み パイプラインを実行できます。また、障害の回復にも役立ちます。ゲートウェイをデプロイするときにステージングストレージボリュームを自動的に作成し、その保存場所のカタログとスキーマをカスタマイズできます。データは 30 日後にステージングから自動的に消去されます。 |

取り込みパイプライン | ステージングストレージから宛先テーブルにデータを移動するパイプライン。この取り込みパイプラインはサーバレスコンピュートで実行されます。 |

宛先テーブル | 取り込み パイプラインがデータを書き込むテーブル。これらは ストリーミングテーブルであり、増分データ処理の追加サポートを備えた Delta テーブルです。 |

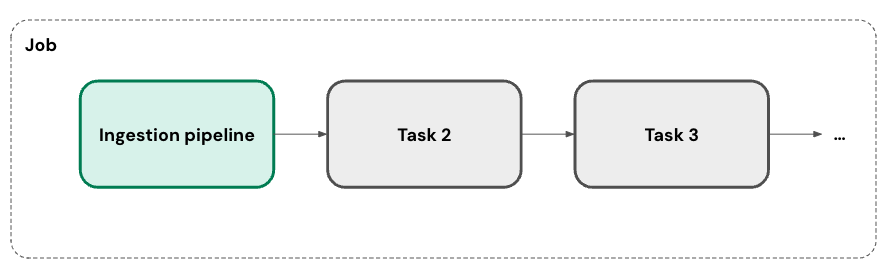

オーケストレーション

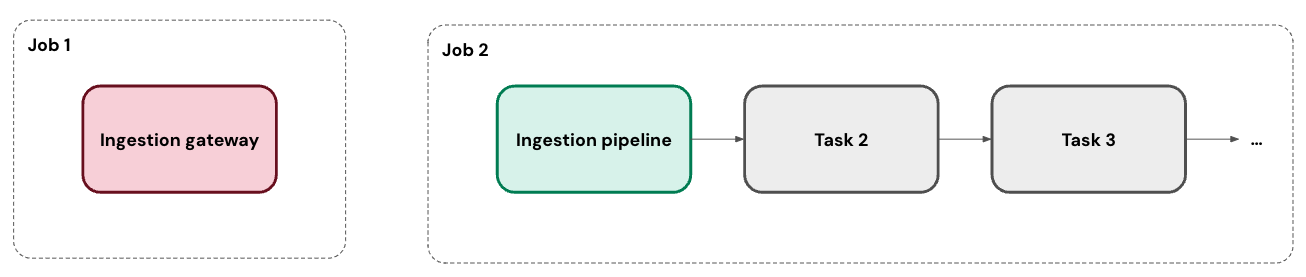

インジェスト パイプラインは、1 つ以上のカスタム スケジュールで実行できます。パイプラインに追加するスケジュールごとに、 Lakeflow Connect によってその ジョブ が自動的に作成されます。 インジェスト パイプラインは、ジョブ内のタスクです。オプションで、ジョブにタスクを追加できます。

データベース コネクタの場合、取り込み ゲートウェイは、連続タスクとして独自のジョブで実行されます。

増分取り込み

Lakeflow Connect では、増分インジェストを使用してパイプラインの効率を向上させます。 パイプラインの最初の実行時に、選択したすべてのデータがソースから取り込まれます。並行して、ソース データへの変更を追跡します。パイプラインの後続の各実行では、その変更追跡を使用して、可能な場合は前の実行から変更されたデータのみを取り込みます。

正確なアプローチは、データソースで利用可能なものによって異なります。 たとえば、変更の追跡とチェンジデータキャプチャ (CDC) の両方を SQL Serverで使用できます。 これに対し、Salesforce コネクタは、設定されたオプションのリストからカーソル列を選択します。

一部のソースまたは特定のテーブルでは、現時点では増分取り込みはサポートされていません。Databricks は、増分サポートの対象範囲を拡大する予定です。

ネットワーキング

SaaS アプリケーションまたはデータベースに接続するには、いくつかのオプションがあります。

- SaaSアプリケーション用のコネクタは、ソースのAPIに手を差し伸べます。また、サーバレスのエグレスコントロールとも自動的に互換性があります。

- クラウド データベースのコネクタは、Private Link を介してソースに接続できます。あるいは、ワークスペースに、データベースをホストしている VNet または VPC とピアリングされている仮想ネットワーク (VNet) または仮想プライベート クラウド (VPC) がある場合は、その中にゲートウェイをデプロイできます。

- オンプレミス データベース用のコネクタは、AWS Direct Connect や Azure ExpressRoute などのサービスを使用して接続できます。

配備

Databricks Asset Bundle を使用してインジェストパイプラインをデプロイし、ソース管理、コードレビュー、テスト、継続的インテグレーションと継続的デリバリー (CI/CD) などのベストプラクティスを実現できます。バンドルは Databricks CLI を使用して管理され、開発、ステージング、本番運用など、異なるターゲット ワークスペースで実行できます。

障害復旧

フルマネージドサービスとして、 Lakeflowコネクト は可能な限り問題から自動的に回復することを目指しています。 たとえば、コネクタに障害が発生すると、エクスポネンシャル バックオフで自動的に再試行されます。

ただし、エラーによって介入が必要になる可能性があります (たとえば、資格情報の有効期限が切れた場合など)。このような場合、コネクタはカーソルの最後の位置を格納することで、データの欠落を回避しようとします。その後、可能な場合は、パイプラインの次の実行でその位置から再開できます。

モニタリング

LakeFlow Connectパイプラインの維持に役立つ堅牢なアラートとモニタリングを提供します。 これには、イベント ログ、クラスター ログ、パイプライン ヘルス メトリクス、およびデータ品質メトリクスが含まれます。 system.billing.usageテーブルを使用してコストを追跡し、パイプラインの使用状況を監視することもできます。「マネージド インジェスチョン パイプラインのコストを監視する」を参照してください。

データベース コネクタの場合、イベント ログを使用してゲートウェイの進行状況をリアルタイムで監視できます。「イベント ログを使用してインジェスト ゲートウェイの進行状況を監視する」を参照してください。

リリースステータス

コネクター | リリースステータス |

|---|---|

Confluence | ベータ版 |

Dynamics 365 | パブリックプレビュー |

Google Ads | ベータ版 |

Googleアナリティクス | 一般提供 |

HubSpot | ベータ版 |

メタ広告 | ベータ版 |

MySQL | パブリックプレビュー |

Salesforce | 一般提供 |

ServiceNow | 一般提供 |

SharePoint | ベータ版 |

SQL Server | 一般提供 |

TikTok広告 | ベータ版 |

Workdayレポート | 一般提供 |

Zendesk Support | ベータ版 |

機能の可用性

次の表は、各マネージド インジェスチョン コネクタの機能の可用性をまとめたものです。追加の機能と制限については、特定のコネクタのドキュメントを参照してください。

- Confluence

- Dynamics 365

- Google Ads

- Google Analytics

- HubSpot

- Jira

- Meta Ads

- MySQL

- PostgreSQL

- Salesforce

- ServiceNow

- SharePoint

- SQL Server

- TikTok Ads

- Workday Reports

- Zendesk Support

機能 | 可用性 |

|---|---|

UI ベースのパイプラインオーサリング |

|

API ベースのパイプラインオーサリング |

|

Databricksアセットバンドル |

|

増分取り込み |

|

Unity Catalog のガバナンス |

|

Databricks Workflowsを使用したオーケストレーション |

|

SCDタイプ2 |

|

API ベースの列の選択と選択解除 |

|

APIベースの行フィルタリング |

|

自動化されたスキーマ進化: 新しい列と削除された列 |

|

自動スキーマ進化: データ型の変更 |

|

自動化されたスキーマ進化: 列の名前変更 |

新しい列 (新しい名前) と削除された列 (古い名前) として扱われます。 |

自動スキーマ進化: 新しいテーブル |

スキーマ全体を取り込む場合。パイプラインあたりのテーブル数の制限を参照してください。 |

パイプラインあたりのテーブルの最大数 | 250 |

機能 | 可用性 |

|---|---|

UI ベースのパイプラインオーサリング |

|

API ベースのパイプラインオーサリング |

|

Databricksアセットバンドル |

|

増分取り込み |

|

Unity Catalog のガバナンス |

|

Databricks Workflowsを使用したオーケストレーション |

|

SCDタイプ2 |

|

API ベースの列の選択と選択解除 |

|

APIベースの行フィルタリング |

|

自動化されたスキーマ進化: 新しい列と削除された列 |

|

自動スキーマ進化: データ型の変更 |

|

自動化されたスキーマ進化: 列の名前変更 |

新しい列 (新しい名前) と削除された列 (古い名前) として扱われます。 |

自動スキーマ進化: 新しいテーブル | N/A |

パイプラインあたりのテーブルの最大数 | 250 |

機能 | 可用性 |

|---|---|

UI ベースのパイプラインオーサリング |

|

API ベースのパイプラインオーサリング |

|

Databricksアセットバンドル |

|

増分取り込み |

レポート テーブルは増分取り込みをサポートします。リソース テーブルは更新ごとに完全に更新されます。 |

Unity Catalog のガバナンス |

|

Lakeflow ジョブ |

|

SCDタイプ2 |

|

列の選択と選択解除 |

特定のテーブルを選択できます。 |

APIベースの行フィルタリング |

|

自動化されたスキーマ進化: 新しい列と削除された列 |

|

自動スキーマ進化: データ型の変更 |

|

自動化されたスキーマ進化: 列の名前変更 |

|

自動スキーマ進化: 新しいテーブル |

|

パイプラインあたりのテーブルの最大数 | 250 |

機能 | 可用性 |

|---|---|

UI ベースのパイプラインオーサリング |

|

API ベースのパイプラインオーサリング |

|

Databricksアセットバンドル |

|

増分取り込み |

|

Unity Catalog のガバナンス |

|

Databricks Workflowsを使用したオーケストレーション |

|

SCDタイプ2 |

|

API ベースの列の選択と選択解除 |

|

APIベースの行フィルタリング |

|

自動化されたスキーマ進化: 新しい列と削除された列 |

|

自動スキーマ進化: データ型の変更 |

|

自動化されたスキーマ進化: 列の名前変更 |

|

自動スキーマ進化: 新しいテーブル |

|

パイプラインあたりのテーブルの最大数 | 250 |

機能 | 可用性 |

|---|---|

UI ベースのパイプラインオーサリング |

|

API ベースのパイプラインオーサリング |

|

Databricksアセットバンドル |

|

増分取り込み |

一部のテーブルは増分取り込みをサポートしています。その他のテーブルでは完全な更新が必要です。HubSpot コネクタリファレンスを参照してください。 |

Unity Catalog のガバナンス |

|

Databricks Workflowsを使用したオーケストレーション |

|

SCDタイプ2 |

|

API ベースの列の選択と選択解除 |

|

APIベースの行フィルタリング |

|

自動化されたスキーマ進化: 新しい列と削除された列 |

|

自動スキーマ進化: データ型の変更 |

|

自動化されたスキーマ進化: 列の名前変更 |

|

自動スキーマ進化: 新しいテーブル |

|

パイプラインあたりのテーブルの最大数 | 250 |

機能 | 可用性 |

|---|---|

UI ベースのパイプラインオーサリング |

|

API ベースのパイプラインオーサリング |

|

Databricksアセットバンドル |

|

増分取り込み |

|

Unity Catalog のガバナンス |

|

Databricks Workflowsを使用したオーケストレーション |

|

SCDタイプ2 |

|

API ベースの列の選択と選択解除 |

|

APIベースの行フィルタリング |

|

自動化されたスキーマ進化: 新しい列と削除された列 |

|

自動スキーマ進化: データ型の変更 |

|

自動化されたスキーマ進化: 列の名前変更 |

新しい列 (新しい名前) と削除された列 (古い名前) として扱われます。 |

自動スキーマ進化: 新しいテーブル | N/A |

パイプラインあたりのテーブルの最大数 | 250 |

機能 | 可用性 |

|---|---|

UI ベースのパイプラインオーサリング |

|

API ベースのパイプラインオーサリング |

|

Databricksアセットバンドル |

|

増分取り込み |

レポート テーブルは増分取り込みをサポートします。リソース テーブルは更新ごとに完全に更新されます。 |

Unity Catalog のガバナンス |

|

Lakeflow ジョブ |

|

SCDタイプ2 |

|

列の選択と選択解除 |

特定のテーブルを選択できます。 |

APIベースの行フィルタリング |

|

自動化されたスキーマ進化: 新しい列と削除された列 |

|

自動スキーマ進化: データ型の変更 |

|

自動化されたスキーマ進化: 列の名前変更 |

|

自動スキーマ進化: 新しいテーブル | N/A |

パイプラインあたりのテーブルの最大数 | 250 |

機能 | 可用性 |

|---|---|

UI ベースのパイプラインオーサリング |

|

API ベースのパイプラインオーサリング |

|

Databricksアセットバンドル |

|

増分取り込み |

|

Unity Catalog のガバナンス |

|

Databricks Workflowsを使用したオーケストレーション |

|

SCDタイプ2 |

|

API ベースの列の選択と選択解除 |

|

APIベースの行フィルタリング |

|

自動化されたスキーマ進化: 新しい列と削除された列 |

|

自動スキーマ進化: データ型の変更 |

|

自動化されたスキーマ進化: 列の名前変更 |

新しい列 (新しい名前) と削除された列 (古い名前) として扱われます。 |

自動スキーマ進化: 新しいテーブル |

スキーマ全体を取り込む場合。パイプラインあたりのテーブル数の制限を参照してください。 |

パイプラインあたりのテーブルの最大数 | 250 |

機能 | 可用性 |

|---|---|

UI ベースのパイプラインオーサリング |

|

API ベースのパイプラインオーサリング |

|

Databricksアセットバンドル |

|

増分取り込み |

|

Unity Catalog のガバナンス |

|

Databricks Workflowsを使用したオーケストレーション |

|

SCDタイプ2 |

|

API ベースの列の選択と選択解除 |

|

APIベースの行フィルタリング |

|

自動化されたスキーマ進化: 新しい列と削除された列 |

|

自動スキーマ進化: データ型の変更 |

|

自動化されたスキーマ進化: 列の名前変更 |

新しい列 (新しい名前) と削除された列 (古い名前) として扱われます。 |

自動スキーマ進化: 新しいテーブル | N/A |

パイプラインあたりのテーブルの最大数 | 250 |

機能 | 可用性 |

|---|---|

UI ベースのパイプラインオーサリング |

|

API ベースのパイプラインオーサリング |

|

Databricksアセットバンドル |

|

増分取り込み |

デフォルトでは、数式フィールドには完全なスナップショットが必要です。数式フィールドの増分取り込みを有効にするには、 「Salesforce 数式フィールドを増分的に取り込む」を参照してください。 |

Unity Catalog のガバナンス |

|

Databricks Workflowsを使用したオーケストレーション |

|

SCDタイプ2 |

|

API ベースの列の選択と選択解除 |

|

APIベースの行フィルタリング |

|

自動化されたスキーマ進化: 新しい列と削除された列 |

|

自動スキーマ進化: データ型の変更 |

|

自動化されたスキーマ進化: 列の名前変更 |

新しい列 (新しい名前) と削除された列 (古い名前) として扱われます。 |

自動スキーマ進化: 新しいテーブル |

スキーマ全体を取り込む場合。パイプラインあたりのテーブル数の制限を参照してください。 |

パイプラインあたりのテーブルの最大数 | 250 |

機能 | 可用性 |

|---|---|

UI ベースのパイプラインオーサリング |

|

API ベースのパイプラインオーサリング |

|

Databricksアセットバンドル |

|

増分取り込み |

ただし、テーブルにカーソルフィールドがない場合の例外 |

Unity Catalog のガバナンス |

|

Databricks Workflowsを使用したオーケストレーション |

|

SCDタイプ2 |

|

API ベースの列の選択と選択解除 |

|

APIベースの行フィルタリング |

|

自動化されたスキーマ進化: 新しい列と削除された列 |

|

自動スキーマ進化: データ型の変更 |

|

自動化されたスキーマ進化: 列の名前変更 |

新しい列 (新しい名前) と削除された列 (古い名前) として扱われます。 |

自動スキーマ進化: 新しいテーブル |

スキーマ全体を取り込む場合。パイプラインあたりのテーブル数の制限を参照してください。 |

パイプラインあたりのテーブルの最大数 | 250 |

機能 | 可用性 |

|---|---|

UI ベースのパイプラインオーサリング |

|

API ベースのパイプラインオーサリング |

|

Databricksアセットバンドル |

|

増分取り込み |

|

Unity Catalog のガバナンス |

|

Databricks Workflowsを使用したオーケストレーション |

|

SCDタイプ2 |

|

API ベースの列の選択と選択解除 |

|

APIベースの行フィルタリング |

|

自動化されたスキーマ進化: 新しい列と削除された列 |

|

自動スキーマ進化: データ型の変更 |

|

自動化されたスキーマ進化: 列の名前変更 |

新しい列 (新しい名前) と削除された列 (古い名前) として扱われます。 |

自動スキーマ進化: 新しいテーブル |

スキーマ全体を取り込む場合。パイプラインあたりのテーブル数の制限を参照してください。 |

パイプラインあたりのテーブルの最大数 | 250 |

機能 | 可用性 |

|---|---|

UI ベースのパイプラインオーサリング |

|

API ベースのパイプラインオーサリング |

|

Databricksアセットバンドル |

|

増分取り込み |

|

Unity Catalog のガバナンス |

|

Databricks Workflowsを使用したオーケストレーション |

|

SCDタイプ2 |

|

API ベースの列の選択と選択解除 |

|

APIベースの行フィルタリング |

|

自動化されたスキーマ進化: 新しい列と削除された列 |

|

自動スキーマ進化: データ型の変更 |

|

自動化されたスキーマ進化: 列の名前変更 | いいえ - 完全な更新が必要です。 |

自動スキーマ進化: 新しいテーブル |

スキーマ全体を取り込む場合。パイプラインあたりのテーブル数の制限を参照してください。 |

パイプラインあたりのテーブルの最大数 | 250 |

機能 | 可用性 |

|---|---|

UI ベースのパイプラインオーサリング |

|

API ベースのパイプラインオーサリング |

|

Databricksアセットバンドル |

|

増分取り込み |

ただし、テーブルが増分取り込みをサポートしていない場合は例外です。増分更新をサポートするテーブルを参照してください。 |

Unity Catalog のガバナンス |

|

Databricks Workflowsを使用したオーケストレーション |

|

SCDタイプ2 |

|

API ベースの列の選択と選択解除 |

|

APIベースの行フィルタリング |

|

自動化されたスキーマ進化: 新しい列と削除された列 |

|

自動スキーマ進化: データ型の変更 |

|

自動化されたスキーマ進化: 列の名前変更 |

完全な更新が必要です。 |

自動スキーマ進化: 新しいテーブル |

スキーマ全体を取り込む場合。パイプラインあたりのテーブル数の制限を参照してください。 |

パイプラインあたりのテーブルの最大数 | 250 |

機能 | 可用性 |

|---|---|

UI ベースのパイプラインオーサリング |

|

API ベースのパイプラインオーサリング |

|

Databricksアセットバンドル |

|

増分取り込み |

|

Unity Catalog のガバナンス |

|

Databricks Workflowsを使用したオーケストレーション |

|

SCDタイプ2 |

|

API ベースの列の選択と選択解除 |

|

APIベースの行フィルタリング |

|

自動化されたスキーマ進化: 新しい列と削除された列 |

|

自動スキーマ進化: データ型の変更 |

|

自動化されたスキーマ進化: 列の名前変更 |

新しい列 (新しい名前) と削除された列 (古い名前) として扱われます。 |

自動スキーマ進化: 新しいテーブル | N/A |

パイプラインあたりのテーブルの最大数 | 250 |

機能 | 可用性 |

|---|---|

UI ベースのパイプラインオーサリング |

|

API ベースのパイプラインオーサリング |

|

Databricksアセットバンドル |

|

増分取り込み |

|

Unity Catalog のガバナンス |

|

Databricks Workflowsを使用したオーケストレーション |

|

SCDタイプ2 |

|

API ベースの列の選択と選択解除 |

|

APIベースの行フィルタリング |

|

自動化されたスキーマ進化: 新しい列と削除された列 |

|

自動スキーマ進化: データ型の変更 |

|

自動化されたスキーマ進化: 列の名前変更 |

新しい列 (新しい名前) と削除された列 (古い名前) として扱われます。 |

自動スキーマ進化: 新しいテーブル | N/A |

パイプラインあたりのテーブルの最大数 | 250 |

認証方法

次の表に、各マネージド インジェスチョン コネクタでサポートされている認証方法を示します。Databricks では、可能な場合は OAuth U2M または OAuth M2M を使用することをお勧めします。コネクタが OAuth をサポートしている場合、基本認証は従来の方法と見なされます。

- Confluence

- Dynamics 365

- Google Ads

- Google Analytics

- HubSpot

- Jira

- Meta Ads

- MySQL

- PostgreSQL

- Salesforce

- ServiceNow

- SharePoint

- SQL Server

- TikTok Ads

- Workday Reports

- Zendesk Support

認証方法 | 可用性 |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (手動更新トークン) |

|

基本認証(ユーザー名/パスワード) |

|

基本認証(APIキー) |

|

基本認証(サービスアカウントのJSONキー) |

|

認証方法 | 可用性 |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (手動更新トークン) |

|

基本認証(ユーザー名/パスワード) |

|

基本認証(APIキー) |

|

基本認証(サービスアカウントのJSONキー) |

|

認証方法 | 可用性 |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (手動更新トークン) |

|

基本認証(ユーザー名/パスワード) |

|

基本認証(APIキー) |

|

基本認証(サービスアカウントのJSONキー) |

|

認証方法 | 可用性 |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (手動更新トークン) |

|

基本認証(ユーザー名/パスワード) |

|

基本認証(APIキー) |

|

基本認証(サービスアカウントのJSONキー) |

|

認証方法 | 可用性 |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (手動更新トークン) |

|

基本認証(ユーザー名/パスワード) |

|

基本認証(APIキー) |

|

基本認証(サービスアカウントのJSONキー) |

|

認証方法 | 可用性 |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (手動更新トークン) |

|

基本認証(ユーザー名/パスワード) |

|

基本認証(APIキー) |

|

基本認証(サービスアカウントのJSONキー) |

|

認証方法 | 可用性 |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (手動更新トークン) |

|

基本認証(ユーザー名/パスワード) |

|

基本認証(APIキー) |

|

基本認証(サービスアカウントのJSONキー) |

|

認証方法 | 可用性 |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (手動更新トークン) |

|

基本認証(ユーザー名/パスワード) |

|

基本認証(APIキー) |

|

基本認証(サービスアカウントのJSONキー) |

|

認証方法 | 可用性 |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (手動更新トークン) |

|

基本認証(ユーザー名/パスワード) |

|

基本認証(APIキー) |

|

基本認証(サービスアカウントのJSONキー) |

|

認証方法 | 可用性 |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (手動更新トークン) |

|

基本認証(ユーザー名/パスワード) |

|

基本認証(APIキー) |

|

基本認証(サービスアカウントのJSONキー) |

|

認証方法 | 可用性 |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (手動更新トークン) |

|

基本認証(ユーザー名/パスワード) |

|

基本認証(APIキー) |

|

基本認証(サービスアカウントのJSONキー) |

|

認証方法 | 可用性 |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (手動更新トークン) |

|

基本認証(ユーザー名/パスワード) |

|

基本認証(APIキー) |

|

基本認証(サービスアカウントのJSONキー) |

|

認証方法 | 可用性 |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (手動更新トークン) |

|

基本認証(ユーザー名/パスワード) |

|

基本認証(APIキー) |

|

基本認証(サービスアカウントのJSONキー) |

|

認証方法 | 可用性 |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (手動更新トークン) |

|

基本認証(ユーザー名/パスワード) |

|

基本認証(APIキー) |

|

基本認証(サービスアカウントのJSONキー) |

|

認証方法 | 可用性 |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (手動更新トークン) |

|

基本認証(ユーザー名/パスワード) |

|

基本認証(APIキー) |

|

基本認証(サービスアカウントのJSONキー) |

|

認証方法 | 可用性 |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (手動更新トークン) |

|

基本認証(ユーザー名/パスワード) |

|

基本認証(APIキー) |

|

基本認証(サービスアカウントのJSONキー) |

|

外部サービスへの依存

DatabricksのSaaS、データベース、およびその他のフルマネージド コネクタは、接続先のアプリケーション、データベース、または外部サービスのアクセシビリティ、互換性、安定性に依存します。Databricks はこれらの外部サービスを制御していないため、変更、更新、およびメンテナンスに対する影響力は (あったとしても) 制限されています。

外部サービスに関連する変更、中断、または状況により、コネクタの運用が妨げられたり、非現実的になったりした場合、Databricks はそのコネクタの保守を中止または中止することができます。Databricksは、該当するドキュメントの更新を含む、メンテナンスの中止または中止を顧客に通知するために合理的な努力を払います。