Lakeflowコネクトとは?

Lakeflow Connect は、ローカル ファイル、一般的なエンタープライズ アプリケーション、データベース、クラウド ストレージ、メッセージ バスなどからデータを取り込むためのシンプルで効率的なコネクタを提供します。 このページでは、 Lakeflow Connect で ETL パフォーマンスを向上させる方法をいくつか紹介します。 また、一般的なユース ケースと、フルマネージド コネクタから完全にカスタマイズ可能なフレームワークまで、サポートされているインジェスト ツールの範囲についても説明します。

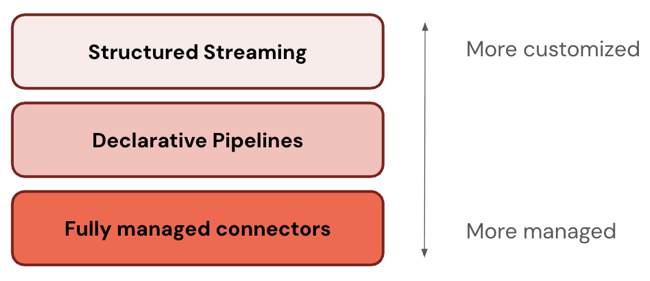

柔軟なサービスモデル

Lakeflow Connect は、エンタープライズ アプリケーション、クラウド ストレージ、データベース、メッセージ バスなどに対応する幅広いコネクタを提供しています。 また、以下のいずれかを柔軟に選択することもできます。

オプション | 説明 |

|---|---|

フルマネージドサービス | シンプルなUIと強力な APIsでデータアクセスを民主化する、すぐに使えるコネクタです。 これにより、長期的なメンテナンスコストを最小限に抑えながら、堅牢なインジェストパイプラインを迅速に作成できます。 |

カスタム パイプライン | さらにカスタマイズが必要な場合は、 Lakeflow Spark宣言型パイプラインまたは構造化ストリーミングを使用できます。 最終的に、この汎用性により、 Lakeflow Connect組織の特定のニーズを満たすことができます。 |

Databricks のコアツールによる統合

Lakeflowコネクト は、 Databricks のコア機能を使用して、包括的なデータマネジメントを提供します。 たとえば、 Unity Catalogを使用したガバナンス、 Lakeflow ジョブを使用したオーケストレーション、パイプライン全体にわたる全体的なモニタリングを提供します。 これにより、組織はデータのセキュリティ、品質、コストを管理しながら、インジェストプロセスを他のデータエンジニアリングツールと統合できます。Lakeflowコネクト はオープンなデータインテリジェンスプラットフォーム上に構築されており、お好みのサードパーティツールを完全に組み込むための完全な柔軟性を備えています。 これにより、既存のインフラストラクチャと将来のデータ戦略に合わせたカスタマイズされたソリューションが保証されます。

高速でスケーラブルな取り込み

Lakeflowコネクト は、増分読み取りと増分書き込みを使用して、効率的なインジェストを可能にします。 下流の増分変換と組み合わせると、ETLのパフォーマンスを大幅に向上させることができます。

一般的な使用例

お客様は、データをインジェストして、組織の最も困難な問題を解決します。 使用例には、次のようなものがあります。

ユースケース | 説明 |

|---|---|

キャンペーンのパフォーマンスと顧客リードのスコアリングの測定 | |

履歴モデルと予測モデルによるROIの最大化 | |

顧客の購入体験をパーソナライズする | |

一元化されたヒューマンリソース | 組織の従業員をサポート |

製造効率の向上 | |

ユーザーがポリシーや製品などを理解するのに役立つチャットボットの構築 |

ETLスタックのレイヤー

一部のコネクタは ETL スタックの 1 つのレベルで動作します。たとえば、 Databricks 、Salesforce などのエンタープライズ アプリケーションやSQL Serverなどのデータベース用のフルマネージド コネクタを提供します。 その他のコネクタは、ETL スタックの複数のレイヤーで動作します。たとえば、構造化ストリーミングで標準コネクタを使用して完全なカスタマイズを行うことも、 Lakeflow Spark宣言型パイプラインでより管理されたエクスペリエンスを使用することもできます。 同様に、Apache Kafka、Amazon Kinesis、Google Pub/Sub、Apache Pulsar からのストリーミング データのカスタマイズ レベルを選択できます。

Databricks では、最も管理されたレイヤーから始めることをお勧めします。要件を満たさない場合 (たとえば、データソースをサポートしていない場合) は、次のレイヤーにドロップダウンします。 Databricks は、3 つのレイヤーすべてでより多くのコネクタのサポートを拡大する予定です。

次の表では、インジェスト製品の 3 つのレイヤーを、最もカスタマイズ可能なものから最も管理しやすいものの順に説明しています。

層 | 説明 |

|---|---|

構造化ストリーミングは、ほぼリアルタイムで増分ストリーム処理を行うためのAPIです。強力なパフォーマンス、スケーラビリティ、およびフォールトトレランスを提供します。 | |

Lakeflow Spark宣言型パイプラインは構造化ストリーミングに基づいて構築されており、データパイプラインを作成するための宣言型フレームワークを提供します。 データに対して実行する変換を定義でき、 Lakeflow Spark宣言型パイプラインがオーケストレーション、モニタリング、データ品質、エラーなどを管理します。 したがって、構造化ストリーミングよりも自動化が進み、オーバーヘッドが少なくなります。 | |

フルマネージド コネクタはLakeflow Spark宣言型パイプライン上に構築されており、最も人気のあるデータ ソースのさらなる自動化を提供します。 これらは、 Lakeflow Spark宣言型パイプライン機能を拡張し、ソース固有の認証、 CDC 、エッジケース処理、長期APIメンテナンス、自動再試行、自動スキーマ進化なども組み込みます。 したがって、サポートされているデータ ソースに対してさらに高度な自動化が提供されます。 |

マネージド コネクタ

フルマネージド コネクタを使用して、エンタープライズ アプリケーションやデータベースから取り込むことができます。

サポートされているコネクタは次のとおりです。

サポートされているインターフェイスは次のとおりです。

- Databricks UI

- Databricksアセットバンドル

- Databricks API

- Databricks SDK

- Databricks CLI

標準コネクタ

Databricks は、マネージド コネクタに加えて、クラウド オブジェクト ストレージとメッセージ バス用のカスタマイズ可能なコネクタを提供します。Lakeflow Connectの標準コネクタを参照してください。

ファイルのアップロードとダウンロード

ローカルネットワーク上に存在するファイル、ボリュームにアップロードされたファイル、またはインターネットの場所からダウンロードされたファイルを取り込むことができます。「ファイル」を参照してください。

インジェストパートナー

多くのサードパーティ ツールは、Databricks へのバッチまたはストリーミング インジェストをサポートしています。Databricks はさまざまなサードパーティ統合を検証していますが、ソースシステムへのアクセスを設定し、データを取り込む手順はツールによって異なります。検証済みのツールの一覧については、「 インジェスト パートナー 」を参照してください。一部の技術パートナーは、サードパーティツールをレイクハウスデータに簡単に接続できるUIを備えた Databricks Partner Connectでも紹介されています。

DIYインジェスト

Databricks 一般的なコンピュートプラットフォームを提供します。 その結果、Python や Java など、Databricks でサポートされている任意のプログラミング言語を使用して、独自のインジェスト コネクタを作成できます。また、データロードツール、Airbyte、Debeziumなどの一般的なオープンソースコネクタライブラリをインポートして使用することもできます。

インジェストの代替手段

Databricks では、大量のデータ、低レイテンシのクエリ、サードパーティ API の制限に対応するようにスケーリングできるため、ほとんどのユース ケースでインジェストを推奨しています。インジェストでは、ソース システムから Databricks にデータがコピーされるため、重複するデータが発生し、時間の経過と共に古くなる可能性があります。データをコピーしない場合は、次のツールを使用できます。

ツール | 説明 |

|---|---|

レイクハウスフェデレーション | データを移動せずに外部データソースをクエリできます。 |

Delta Sharing | プラットフォーム、クラウド、リージョン間でデータを安全に共有できます。 |