トレーシングインストラクター

Instructor は、Pydantic の上に構築されたオープンソース Python ライブラリであり、検証、再試行、およびストリーミングを使用して構造化された LLM 出力を簡素化します。

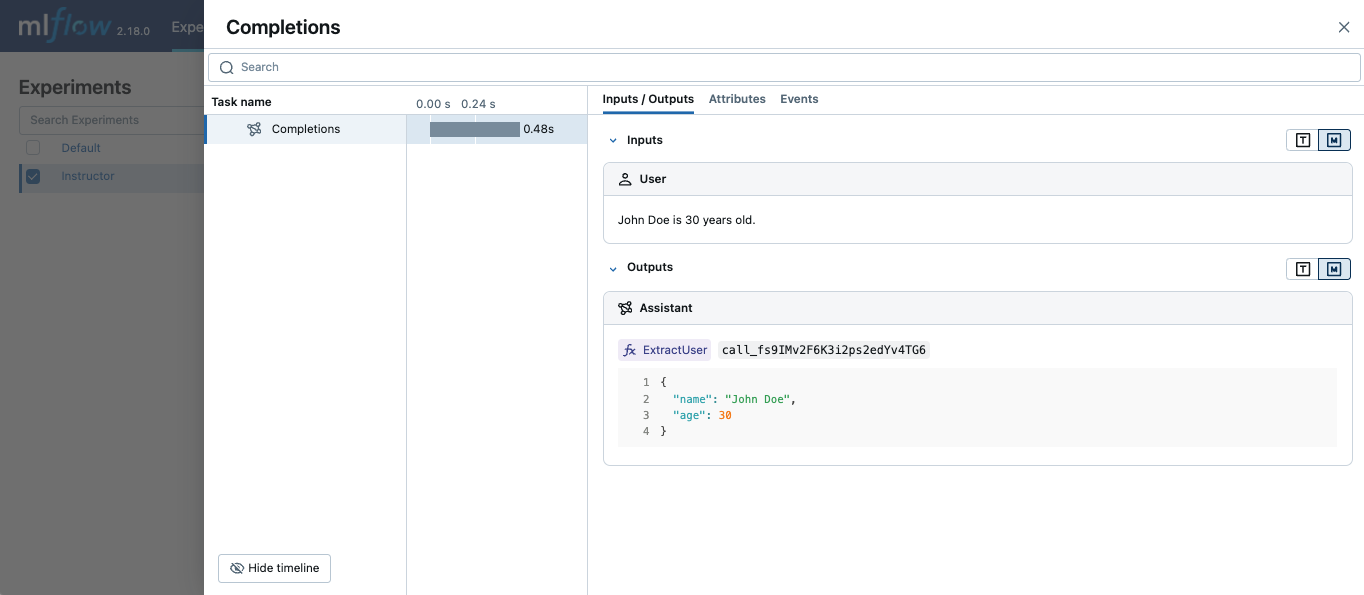

MLflow Tracing は、基になる LLM ライブラリの自動トレースを有効にすることで、Instructor と連携します。たとえば、Instructor for OpenAI LLMs を使用する場合、mlflow.openai.autolog() でトレースを有効にすると、生成されたトレースが Instructor からの構造化された出力をキャプチャします。

同様に、MLflow で対応する自動ログを有効にすることで、Anthropic、Gemini、LiteLLM などの他の LLM プロバイダーと共に Instructor をトレースすることもできます。

注記

サーバレス コンピュート クラスターでは、自動ログは自動的に有効になりません。 この統合の自動トレースを有効にするには、適切な自動ログ関数 ( mlflow.openai.autolog() やmlflow.anthropic.autolog()など) を明示的に呼び出す必要があります。

使用例

次の例は、OpenAI API をラップする Instructor 呼び出しをトレースする方法を示しています。

Python

import instructor

from pydantic import BaseModel

from openai import OpenAI

import mlflow

# Use other autologging function e.g., mlflow.anthropic.autolog() if you are using Instructor with different LLM providers

mlflow.openai.autolog()

# Set up MLflow tracking on Databricks

mlflow.set_tracking_uri("databricks")

mlflow.set_experiment("/Shared/instructor-demo")

# Use Instructor as usual

class ExtractUser(BaseModel):

name: str

age: int

client = instructor.from_openai(OpenAI())

res = client.chat.completions.create(

model="gpt-4o-mini",

response_model=ExtractUser,

messages=[{"role": "user", "content": "John Doe is 30 years old."}],

)

print(f"Name: {res.name}, Age:{res.age}")

次のステップ

- トレースの概念を理解する - MLflow でトレース データをキャプチャして整理する方法を学習します

- アプリのデバッグと監視 - Trace UI を使用して、Instructor アプリケーションの動作を分析します

- アプリの品質を評価する - 構造化された出力アプリケーションの品質評価を設定します