Ler dados compartilhados usando o compartilhamento aberto Delta Sharing com tokens de portador (para destinatários)

Esta página descreve como ler os dados compartilhados com o senhor usando o protocolo de compartilhamento aberto Delta Sharing com tokens de portador. Inclui instruções para a leitura do uso compartilhado de dados das seguintes ferramentas:

Nesse modelo de compartilhamento aberto, o senhor usa um arquivo de credenciais, compartilhado com um membro da sua equipe pelo provedor de dados, para obter acesso seguro de leitura aos dados compartilhados. O acesso persiste enquanto a credencial for válida e o provedor continuar compartilhando os dados. Os provedores gerenciam a expiração e a rotação de credenciais. As atualizações dos dados estão disponíveis quase em tempo real. Você pode ler e fazer cópias dos dados compartilhados, mas não pode modificar os dados de origem.

Se os dados foram compartilhados com você usando Delta Sharing Databricks-to-Databricks , você não precisa de um arquivo de credenciais para acessar os dados e esta página não se aplica a você. Em vez disso, consulte Ler dados compartilhados usando Delta Sharing Databricks-to-Databricks (para destinatários).

As seções a seguir descrevem como usar os clientes Databricks, Apache Spark, pandas, Power BI e Iceberg para acessar e ler o arquivo de credenciais compartilhado. Para obter uma lista completa dos conectores Delta Sharing e informações sobre como usá-los, consulte a documentação de código abertoDelta Sharing. Se você tiver problemas para acessar os dados compartilhados, entre em contato com o provedor de dados.

Antes de começar

Um membro da sua equipe deve download o arquivo de credenciais compartilhado pelo provedor de dados e usar um canal seguro para compartilhar esse arquivo ou a localização do arquivo com você. Consulte Obter acesso no modelo de compartilhamento aberto.

Para obter documentação específica do conector, consulte a página de credenciais de download.

Databricks: Leitura compartilhada uso de dados conectores de compartilhamento aberto

Esta seção descreve como importar um provedor e como consultar os dados compartilhados no Catalog Explorer ou em um notebook Python:

-

Se o seu Databricks workspace estiver habilitado para Unity Catalog, use a interface do usuário do provedor de importação no Catalog Explorer. Você pode fazer o seguinte sem precisar armazenar ou especificar um arquivo de credenciais:

- Crie catálogos a partir de compartilhamentos com o clique de um botão.

- Use os controles de acesso do Unity Catalog para conceder acesso a tabelas compartilhadas.

- A consulta compartilhou o uso de dados da sintaxe padrão do site Unity Catalog.

-

Se o seu Databricks workspace não estiver habilitado para Unity Catalog, use as instruções do Python Notebook como exemplo.

- Catalog Explorer

- Python

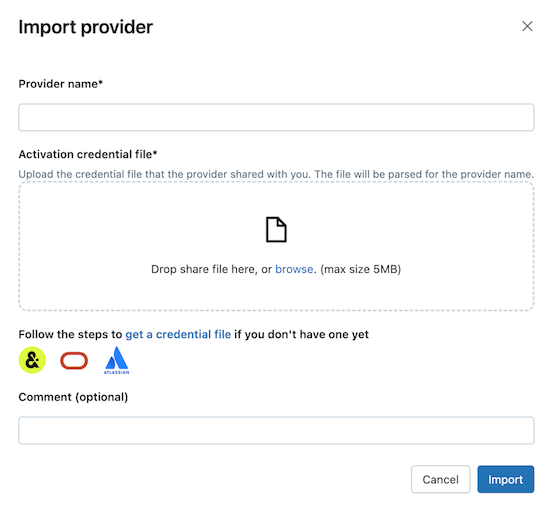

Permissões necessárias : Um administrador de metastore ou um usuário que tenha os privilégios CREATE PROVIDER e USE PROVIDER para o metastore do Unity Catalog.

-

Em seu site Databricks workspace, clique em

Catalog para abrir o Catalog Explorer.

-

Na parte superior do painel Catálogo , clique em

e selecione Delta Sharing .

Como alternativa, na página de acesso rápido , clique no botão Delta Sharing > .

-

Em Shared with me (Compartilhado comigo) tab, clique em Import data (Importar dados ).

-

Insira o nome do provedor.

O nome não pode incluir espaços.

-

Faça o upload do arquivo de credencial que o provedor compartilhou com o senhor.

Muitos provedores têm suas próprias redes Delta Sharing, das quais o senhor pode receber compartilhamentos. Para obter mais informações, consulte Configurações específicas do provedor.

-

(Opcional) Insira um comentário.

-

Clique em Importar .

-

Crie catálogos a partir dos dados compartilhados.

Em Shares tab, clique em Create catalog (Criar catálogo ) na linha de compartilhamento.

Para obter informações sobre como usar o site SQL ou o Databricks CLI para criar um catálogo a partir de um compartilhamento, consulte Criar um catálogo a partir de um compartilhamento.

-

Conceda acesso aos catálogos.

Consulte Como faço para disponibilizar dados compartilhados para minha equipe? e gerenciar permissões para os esquemas, tabelas e volumes em um catálogo Delta Sharing.

-

Leia os objetos de dados compartilhados da mesma forma que faria com qualquer objeto de dados registrado no Unity Catalog.

Para obter detalhes e exemplos, consulte Acessar dados em uma tabela ou volume compartilhado.

Esta seção descreve como usar um conector de compartilhamento aberto para acessar um Notebook compartilhado no seu workspace Databricks . Você ou outro membro da sua equipe armazena o arquivo de credenciais no Databricks e, em seguida, o usa para autenticar a account do Databricks do provedor de dados e ler os dados que o provedor de dados compartilhou com você.

Estas instruções pressupõem que o seu Databricks workspace não está habilitado para Unity Catalog. Se o senhor estiver usando o Unity Catalog, não precisará apontar para o arquivo de credenciais ao ler do compartilhamento. O senhor pode ler de tabelas compartilhadas da mesma forma que lê de qualquer tabela registrada no Unity Catalog. A Databricks recomenda que o senhor use a UI do provedor de importação no Catalog Explorer em vez das instruções fornecidas aqui.

Primeiro, armazene o arquivo de credenciais como um arquivo de workspace Databricks para que os usuários da sua equipe possam acessar os dados compartilhados.

-

Para importar o arquivo de credenciais no seu workspace Databricks , consulte Importar um arquivo.

-

Conceda permissão a outros usuários para acessar o arquivo clicando

ao lado do arquivo, depois Compartilhar (Permissões) . Insira as identidades do Databricks que devem ter acesso ao arquivo.

Para obter mais informações sobre permissões de arquivo, consulte ACLs de arquivo.

Agora que o arquivo de credenciais está armazenado, use um Notebook para listar e ler tabelas compartilhadas.

-

Em seu site Databricks workspace, clique em New > Notebook .

Para obter mais informações sobre Databricks Notebook, consulte Databricks Notebook.

-

Para usar Python ou

pandaspara acessar os dados compartilhados, instale o conector Python de compartilhamento delta. No editor do Notebook, cole o seguinte comando:%sh pip install delta-sharing -

execução da célula.

A biblioteca Python

delta-sharingé instalada no cluster, caso ainda não esteja instalada. -

Usando Python, liste as tabelas no compartilhamento.

Em uma nova célula, cole o seguinte comando. Substitua o caminho workspace pelo caminho do arquivo para seu arquivo de credenciais.

Quando o código é executado, Python lê o arquivo de credenciais.

Pythonimport delta_sharing

client = delta_sharing.SharingClient(f"/Workspace/path/to/config.share")

client.list_all_tables() -

execução da célula.

O resultado é uma matriz de tabelas, junto com metadados para cada tabela. A saída a seguir mostra duas tabelas:

Out[10]: [Table(name='example_table', share='example_share_0', schema='default'), Table(name='other_example_table', share='example_share_0', schema='default')]Se a saída estiver vazia ou não contiver as tabelas que você espera, entre em contato com o provedor de dados.

-

Consulte uma tabela compartilhada.

-

Usando Scala :

Em uma nova célula, cole o seguinte comando. Quando o código é executado, o arquivo de credenciais é lido do arquivo workspace .

Substitua as variáveis da seguinte forma:

<profile-path>: o caminho workspace do arquivo de credenciais. Por exemplo,/Workspace/Users/user.name@email.com/config.share.<share-name>: o valor deshare=para a tabela.<schema-name>: o valor deschema=para a tabela.<table-name>: o valor dename=para a tabela.

%scala

spark.read.format("deltaSharing")

.load("<profile-path>#<share-name>.<schema-name>.<table-name>").limit(10);execução da célula. Cada vez que você carrega a tabela compartilhada, você vê novos dados da fonte.

-

Usando SQL :

Para consultar o uso de dados SQL, o senhor cria uma tabela local no workspace a partir da tabela compartilhada e, em seguida, consulta a tabela local. Os dados compartilhados não são armazenados nem armazenados em cache na tabela local. Sempre que você consulta a tabela local, você vê o estado atual dos dados compartilhados.

Em uma nova célula, cole o seguinte comando.

Substitua as variáveis da seguinte forma:

<local-table-name>: o nome da tabela local.<profile-path>: a localização do arquivo de credenciais.<share-name>: o valor deshare=para a tabela.<schema-name>: o valor deschema=para a tabela.<table-name>: o valor dename=para a tabela.

%sql

DROP TABLE IF EXISTS table_name;

CREATE TABLE <local-table-name> USING deltaSharing LOCATION "<profile-path>#<share-name>.<schema-name>.<table-name>";

SELECT * FROM <local-table-name> LIMIT 10;Quando o senhor executa o comando, os dados compartilhados são consultados diretamente. Como teste, a tabela é consultada e os 10 primeiros resultados são retornados.

Se a saída estiver vazia ou não contiver os dados esperados, entre em contato com o provedor de dados.

-

Clientes da Iceberg: Leia os dados compartilhados

Visualização

Esse recurso está em Public Preview.

Utilize clientes Iceberg externos, como Snowflake, Trino, Flink e Spark, para ler dados compartilhados com acesso sem cópia usando a APIREST CatalogApache Iceberg.

Obtenha as credenciais de conexão.

Antes de acessar dados compartilhados ativos com clientes externos Iceberg , reúna as seguintes credenciais:

- O endpoint do catálogo REST do Iceberg

- Tokens Bearer válidos

- O nome da ação

- (Opcional) O nome do namespace ou do esquema

- (Opcional) O nome da tabela

O endpoint do catálogo REST Iceberg (icebergEndpoint) e os tokens Bearer são encontrados no arquivo de credenciais compartilhado com você pelo seu provedor de dados. Para obter mais informações, consulte Antes de começar. O nome do compartilhamento, o namespace e o nome da tabela podem ser descobertos programaticamente usando APIs Delta Sharing .

O icebergEndpoint é encontrado no arquivo de credenciais e tem o formato <workspace-url>/api/2.0/delta-sharing/metastores/<metastore-id>/iceberg.

Os exemplos a seguir mostram como obter as credenciais adicionais. Insira o endpoint, endpoint Iceberg e os tokens Bearer do arquivo de credenciais onde necessário:

// List shares

curl -X GET "<endpoint>/shares" \

-H "Authorization: Bearer <bearerToken>"

// List namespaces

curl -X GET "<icebergEndpoint>/v1/shares/<share>/namespaces" \

-H "Authorization: Bearer <bearerToken>"

// List tables

curl -X GET "<icebergEndpoint>/v1/shares/<share>/namespaces/<namespace>/tables" \

-H "Authorization: Bearer <bearerToken>"

Este método sempre recupera a lista mais atualizada de ativos. No entanto, requer acesso à internet e pode ser mais difícil de integrar em ambientes sem código.

Configurar catálogo Iceberg

Após obter as credenciais de conexão necessárias, configure seu cliente para usar o endpoint do Catálogo REST Iceberg para criar e consultar tabelas.

-

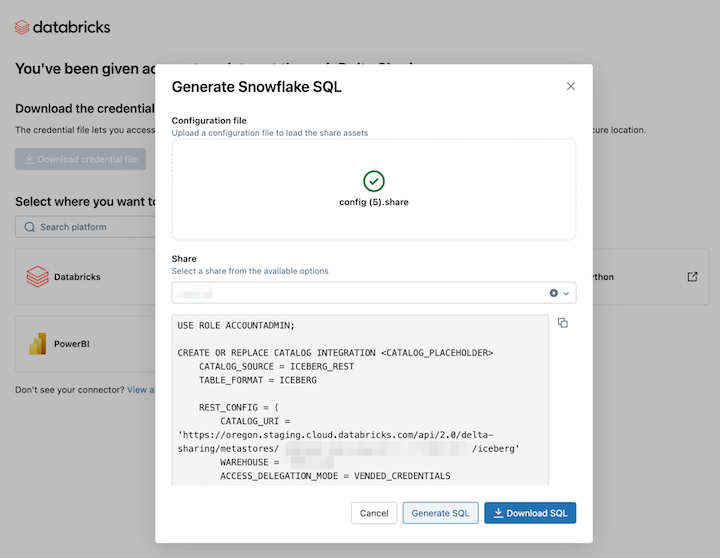

Para cada ação, crie uma integração de catálogo.

SQLUSE ROLE ACCOUNTADMIN;

CREATE OR REPLACE CATALOG INTEGRATION <CATALOG_PLACEHOLDER>

CATALOG_SOURCE = ICEBERG_REST

TABLE_FORMAT = ICEBERG

REST_CONFIG = (

CATALOG_URI = '<icebergEndpoint>',

WAREHOUSE = '<share_name>',

ACCESS_DELEGATION_MODE = VENDED_CREDENTIALS

)

REST_AUTHENTICATION = (

TYPE = BEARER,

BEARER_TOKEN = '<bearerToken>'

)

ENABLED = TRUE; -

Opcionalmente, adicione

REFRESH_INTERVAL_SECONDSpara manter os metadados atualizados. Defina o valor com base na frequência de atualização do seu catálogo.SQLREFRESH_INTERVAL_SECONDS = 30 -

Após configurar o catálogo, crie um banco de dados a partir dele. Isso cria automaticamente todos os esquemas e tabelas nesse catálogo.

SQLCREATE DATABASE <DATABASE_PLACEHOLDER>

LINKED_CATALOG = (

CATALOG = <CATALOG_PLACEHOLDER>

); -

Para confirmar se o compartilhamento foi bem-sucedido, consulte uma tabela no banco de dados. Você deverá ver os dados compartilhados do Databricks.

Se o resultado estiver vazio ou ocorrer um erro, siga estes passos comuns de resolução de problemas:

- Verifique novamente os privilégios, o status de geração do snapshot e as credenciais REST .

- Entre em contato com seu provedor de dados.

- Consulte a documentação específica do seu cliente Iceberg.

Exemplo: Acessar tabelas compartilhadas usando diferentes clientes Iceberg

Os exemplos a seguir mostram como acessar tabelas compartilhadas do Delta usando clientes Iceberg externos, como Snowflake, Apache Spark, PyIceberg e API REST, após obter suas credenciais de conexão. Para mais informações sobre como obter credenciais de conexão, consulte Antes de começar.

- Snowflake

- Apache Spark

- PyIceberg

- REST API

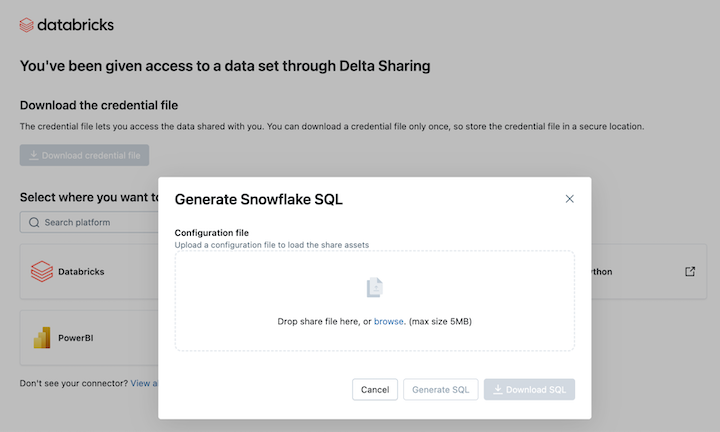

Para ler dados compartilhados ativos no Snowflake, upload do arquivo de credenciais que você baixou e gere o comando SQL necessário:

-

A partir do seu link de ativação Delta Sharing , clique no ícone Snowflake .

-

Na página de integração do Snowflake, faça o upload do arquivo de credenciais que você recebeu do provedor de dados.

-

Após inserir as credenciais, escolha o compartilhamento que deseja acessar no Snowflake.

-

Clique em Gerar SQL após selecionar a ativa desejada.

-

Copie e cole o SQL gerado na sua planilha do Snowflake. Substitua

CATALOG_PLACEHOLDERpelo nome do catálogo que você deseja usar eDATABASE_PLACEHOLDERpelo nome do banco de dados que você deseja usar.

Limitações

A conexão com o catálogo REST do Iceberg no Snowflake apresenta as seguintes limitações:

- O arquivo de metadados não é atualizado automaticamente com o Snapshot mais recente. Você deve optar pelarefresh automática ou pela atualização manual.

- R2 não é suportado.

- Todas as limitações do cliente Iceberg se aplicam.

Para acessar tabelas compartilhadas usando o Apache Spark, configure a API do Catálogo REST do Iceberg com as seguintes configurações. Substitua <spark-catalog-name> pelo nome do seu catálogo e forneça suas credenciais de conexão:

"spark.sql.extensions": "org.apache.iceberg.spark.extensions.IcebergSparkSessionExtensions",

# Configuration for accessing tables shared using Delta Sharing

"spark.sql.catalog.<spark-catalog-name>":"org.apache.iceberg.spark.SparkCatalog",

"spark.sql.catalog.<spark-catalog-name>.type": "rest",

"spark.sql.catalog.<spark-catalog-name>.uri": "<icebergEndpoint>",

"spark.sql.catalog.<spark-catalog-name>.token": "<bearerToken>",

"spark.sql.catalog.<spark-catalog-name>.warehouse":"<share_name>",

"spark.sql.catalog.<spark-catalog-name>.scope":"all-apis"

PyIceberg é uma implementação em Python para acessar tabelas Iceberg sem usar uma JVM. PyIceberg requer pyarrow para operações de tabela, como leitura de dados e inspeção de metadados da tabela. Instale o PyIceberg com o adicional pyarrow :

pip install "pyiceberg[pyarrow]"

Para acessar tabelas compartilhadas, adicione a seguinte configuração de catálogo ao seu arquivo de configuração do PyIceberg:

catalog:

delta_sharing:

type: rest

uri: <icebergEndpoint>

warehouse: <share_name>

token: <bearerToken>

Utilize uma chamada à API REST, como no exemplo curl a seguir, para carregar uma tabela e recuperar seus metadados, juntamente com credenciais temporárias para acessar os arquivos de dados:

curl -X GET -H "Authorization: Bearer <bearerToken>" -H "Accept: application/json" \

<icebergEndpoint>/v1/shares/<share_name>/namespaces/<schema_name>/tables/<table_name>

A resposta inclui os metadados da tabela Iceberg, a localização no S3 e credenciais temporárias da AWS que permitem ao seu cliente ler os arquivos de dados:

{

"metadata-location": "s3://bucket/path/to/iceberg/table/metadata/file",

"metadata": <iceberg-table-metadata-json>,

"config": {

"expires-at-ms": "<epoch-ts-in-millis>",

"s3.access-key-id": "<temporary-s3-access-key-id>",

"s3.session-token": "<temporary-s3-session-token>",

"s3.secret-access-key": "<temporary-secret-access-key>",

"client.region": "<aws-bucket-region-for-metadata-location>"

}

}

Limitações do cliente Iceberg

As seguintes limitações se aplicam ao consultar dados Delta Sharing de clientes Iceberg :

- Ao listar tabelas em um namespace, se o namespace contiver mais de 100 visualizações compartilhadas, a resposta será limitada às primeiras 100 visualizações.

Apache Spark: Ler dados compartilhados

Siga estes passos para acessar o uso compartilhado de dados Spark 3.x ouacima.

Essas instruções pressupõem que você tenha acesso ao arquivo de credenciais que foi compartilhado pelo provedor de dados. Consulte Obter acesso no modelo de compartilhamento aberto.

Certifique-se de que seu arquivo de credenciais esteja acessível pelo Apache Spark usando um caminho absoluto. O caminho pode se referir a um objeto cloud ou volume Unity Catalog .

Se estiver usando Spark em um Databricks workspace que esteja habilitado para Unity Catalog e tiver usado a interface do usuário do provedor de importação para importar o provedor e compartilhar, as instruções desta seção não se aplicam a você. O senhor pode acessar as tabelas compartilhadas da mesma forma que qualquer outra tabela registrada no Unity Catalog. O senhor não precisa instalar o conector delta-sharing Python nem fornecer o caminho para o arquivo de credenciais. Consulte:Databricks Leia os conectores de uso compartilhado de dados de compartilhamento aberto.

Instale os conectores Delta Sharing Python e Spark

Para acessar metadados relacionados aos dados compartilhados, como a lista de tabelas compartilhadas com você, faça o seguinte. Este exemplo usa Python.

-

Instale o conector Python delta-compartilhamento. Para obter informações sobre as limitações do conector Python , consulte Limitações do conector Python Delta Sharing.

Bashpip install delta-sharing -

Instale o conector do Apache Spark.

Listar tabelas compartilhadas usando o Spark

Liste as tabelas no compartilhamento. No exemplo a seguir, substitua <profile-path> pela localização do arquivo de credencial.

import delta_sharing

client = delta_sharing.SharingClient(f"<profile-path>/config.share")

client.list_all_tables()

O resultado é uma matriz de tabelas, junto com metadados para cada tabela. A saída a seguir mostra duas tabelas:

Out[10]: [Table(name='example_table', share='example_share_0', schema='default'), Table(name='other_example_table', share='example_share_0', schema='default')]

Se a saída estiver vazia ou não contiver as tabelas que você espera, entre em contato com o provedor de dados.

Acesso compartilhado uso de dados Spark

Execute o seguinte, substituindo essas variáveis:

<profile-path>: a localização do arquivo de credenciais.<share-name>: o valor deshare=para a tabela.<schema-name>: o valor deschema=para a tabela.<table-name>: o valor dename=para a tabela.<version-as-of>: opcional. A versão da tabela para carregar os dados. Só funciona se o provedor de dados compartilhar a história da tabela. Requerdelta-sharing-spark0.5.0 ouacima.<timestamp-as-of>: opcional. Carregue os dados na versão anterior ou no carimbo de data/hora fornecido. Só funciona se o provedor de dados compartilhar a história da tabela. Requerdelta-sharing-spark0.6.0 ouacima.

- Python

- Scala

delta_sharing.load_as_spark(f"<profile-path>#<share-name>.<schema-name>.<table-name>", version=<version-as-of>)

spark.read.format("deltaSharing")\

.option("versionAsOf", <version-as-of>)\

.load("<profile-path>#<share-name>.<schema-name>.<table-name>")\

.limit(10)

delta_sharing.load_as_spark(f"<profile-path>#<share-name>.<schema-name>.<table-name>", timestamp=<timestamp-as-of>)

spark.read.format("deltaSharing")\

.option("timestampAsOf", <timestamp-as-of>)\

.load("<profile-path>#<share-name>.<schema-name>.<table-name>")\

.limit(10)

spark.read.format("deltaSharing")

.option("versionAsOf", <version-as-of>)

.load("<profile-path>#<share-name>.<schema-name>.<table-name>")

.limit(10)

spark.read.format("deltaSharing")

.option("timestampAsOf", <version-as-of>)

.load("<profile-path>#<share-name>.<schema-name>.<table-name>")

.limit(10)

Acesse o feed de dados de alterações compartilhadas usando o Spark

Se a tabela histórico tiver sido compartilhada com você e o feed de dados de alteração (CDF) estiver habilitado na tabela de origem, acesse o feed de dados de alteração executando o seguinte, substituindo essas variáveis. Requer delta-sharing-spark 0.5.0 ou acima.

Um parâmetro começar deve ser fornecido.

<profile-path>: a localização do arquivo de credenciais.<share-name>: o valor deshare=para a tabela.<schema-name>: o valor deschema=para a tabela.<table-name>: o valor dename=para a tabela.<starting-version>: opcional. A versão inicial da consulta, inclusive. Especifique como longo.<ending-version>: opcional. A versão final da consulta, inclusive. Se a versão final não for fornecida, a API usará a versão mais recente da tabela.<starting-timestamp>: opcional. O carimbo de data/hora inicial da consulta, é convertido em uma versão criada maior ou igual a esse carimbo de data/hora. Especifique como uma cadeia de caracteres no formatoyyyy-mm-dd hh:mm:ss[.fffffffff].<ending-timestamp>: opcional. O carimbo de data/hora final da consulta, é convertido em uma versão criada anteriormente ou igual a esse carimbo de data/hora. Especifique como uma cadeia de caracteres no formatoyyyy-mm-dd hh:mm:ss[.fffffffff]

- Python

- Scala

delta_sharing.load_table_changes_as_spark(f"<profile-path>#<share-name>.<schema-name>.<table-name>",

starting_version=<starting-version>,

ending_version=<ending-version>)

delta_sharing.load_table_changes_as_spark(f"<profile-path>#<share-name>.<schema-name>.<table-name>",

starting_timestamp=<starting-timestamp>,

ending_timestamp=<ending-timestamp>)

spark.read.format("deltaSharing").option("readChangeFeed", "true")\

.option("startingVersion", <starting-version>)\

.option("endingVersion", <ending-version>)\

.load("<profile-path>#<share-name>.<schema-name>.<table-name>")

spark.read.format("deltaSharing").option("readChangeFeed", "true")\

.option("startingTimestamp", <starting-timestamp>)\

.option("endingTimestamp", <ending-timestamp>)\

.load("<profile-path>#<share-name>.<schema-name>.<table-name>")

spark.read.format("deltaSharing").option("readChangeFeed", "true")

.option("startingVersion", <starting-version>)

.option("endingVersion", <ending-version>)

.load("<profile-path>#<share-name>.<schema-name>.<table-name>")

spark.read.format("deltaSharing").option("readChangeFeed", "true")

.option("startingTimestamp", <starting-timestamp>)

.option("endingTimestamp", <ending-timestamp>)

.load("<profile-path>#<share-name>.<schema-name>.<table-name>")

Se a saída estiver vazia ou não contiver os dados esperados, entre em contato com o provedor de dados.

Acessar uma tabela compartilhada usando Spark transmissão estructurada

Se a história da tabela for compartilhada com você, você poderá ler os dados compartilhados por transmissão. Requer delta-sharing-spark 0.6.0 ouacima.

Opções suportadas:

ignoreDeletes: ignore as transações que excluem dados.ignoreChanges: Reprocesse as atualizações se os arquivos foram reescritos na tabela de origem devido a operações de alteração de dados, comoUPDATE,MERGE INTO,DELETE(dentro de partições) ouOVERWRITE. Linhas inalteradas ainda podem ser emitidas. Portanto, seus consumidores downstream devem ser capazes de lidar com duplicatas. As exclusões não são propagadas para jusante.ignoreChangessubsumeignoreDeletes. Portanto, se você usarignoreChanges, sua transmissão não será interrompida por exclusões ou atualizações na tabela de origem.startingVersion: A versão da tabela compartilhada para começar. Todas as alterações de tabela a partir desta versão (inclusive) são lidas pela fonte de transmissão.startingTimestamp: O registro de data e hora para começar. Todas as alterações de tabela confirmadas no registro de data e hora (inclusive) ou depois dele são lidas pela fonte de transmissão. Exemplo:"2023-01-01 00:00:00.0".maxFilesPerTrigger: O número de novos arquivos a serem considerados em cada micro-lote.maxBytesPerTrigger: A quantidade de dados que é processada em cada micro-lote. Essa opção define um "soft max", o que significa que um lote processa aproximadamente essa quantidade de dados e pode processar mais do que o limite para fazer com que a consulta de transmissão avance nos casos em que a menor unidade de entrada for maior do que esse limite.readChangeFeedTransmissão: lê o feed de dados de alteração da tabela compartilhada.

Opções não suportadas:

Trigger.availableNow

Exemplo de consultas de transmissão estruturada

- Scala

- Python

spark.readStream.format("deltaSharing")

.option("startingVersion", 0)

.option("ignoreChanges", true)

.option("maxFilesPerTrigger", 10)

.load("<profile-path>#<share-name>.<schema-name>.<table-name>")

spark.readStream.format("deltaSharing")\

.option("startingVersion", 0)\

.option("ignoreDeletes", true)\

.option("maxBytesPerTrigger", 10000)\

.load("<profile-path>#<share-name>.<schema-name>.<table-name>")

Veja também os conceitos de transmissão estruturada.

Leia tabelas com vetores de exclusão ou mapeamento de colunas habilitados

Visualização

Esse recurso está em Public Preview.

Os vetores de exclusão são um recurso de otimização de armazenamento que seu provedor pode habilitar em tabelas Delta compartilhadas. Consulte Vetores de exclusão no Databricks.

O Databricks também oferece suporte ao mapeamento de colunas para tabelas Delta. Consulte Renomear e soltar colunas com o mapeamento de colunas do Delta Lake.

Se o provedor compartilhou uma tabela com vetores de exclusão ou mapeamento de coluna ativado, o senhor pode ler a tabela usando compute que esteja executando delta-sharing-spark 3.1 ou acima. Se estiver usando o clustering Databricks, o senhor pode realizar leituras de lotes usando um clustering que esteja executando o Databricks Runtime 14.1 ou o acima. As consultas de CDF e transmissão exigem o site Databricks Runtime 14.2 ou superior.

O senhor pode realizar muitas consultas como estão, porque elas podem resolver automaticamente responseFormat com base no recurso de tabela da tabela compartilhada.

Para ler um feed de dados de alteração (CDF) ou para realizar consultas de transmissão em tabelas compartilhadas com vetores de exclusão ou mapeamento de coluna ativados, o senhor deve definir a opção adicional responseFormat=delta.

Os exemplos a seguir mostram consultas de lotes, CDF e transmissão:

import org.apache.spark.sql.SparkSession

val spark = SparkSession

.builder()

.appName("...")

.master("...")

.config("spark.sql.extensions", "io.delta.sql.DeltaSparkSessionExtension")

.config("spark.sql.catalog.spark_catalog", "org.apache.spark.sql.delta.catalog.DeltaCatalog")

.getOrCreate()

val tablePath = "<profile-file-path>#<share-name>.<schema-name>.<table-name>"

// Batch query

spark.read.format("deltaSharing").load(tablePath)

// CDF query

spark.read.format("deltaSharing")

.option("readChangeFeed", "true")

.option("responseFormat", "delta")

.option("startingVersion", 1)

.load(tablePath)

// Streaming query

spark.readStream.format("deltaSharing").option("responseFormat", "delta").load(tablePath)

Pandas: Ler dados compartilhados

Siga estes passos para acessar dados compartilhados em pandas 0.25.3 ou acima.

Essas instruções pressupõem que você tenha acesso ao arquivo de credenciais que foi compartilhado pelo provedor de dados. Consulte Obter acesso no modelo de compartilhamento aberto.

Se você estiver usando pandas em um workspace Databricks habilitado para Unity Catalog e tiver usado a interface do usuário do provedor de importação para importar o provedor e o compartilhamento, as instruções nesta seção não se aplicam a você. Você pode acessar tabelas compartilhadas da mesma forma que faria com qualquer outra tabela registrada no Unity Catalog. Você não precisa instalar o conector Python delta-sharing ou fornecer o caminho para o arquivo de credenciais. Consulte Databricks: Ler conectores de compartilhamento abertos de uso de dados compartilhados.

Instale o conector Python do Delta Sharing

Para acessar os metadados relacionados aos dados compartilhados, como a lista de tabelas compartilhadas com você, é necessário instalar o conector Python delta-compartilhamento. Para obter informações sobre as limitações do conector Python , consulte Limitações do conector Python Delta Sharing.

pip install delta-sharing

Listar tabelas compartilhadas usando pandas

Para listar as tabelas no compartilhamento, execute o seguinte, substituindo <profile-path>/config.share pelo local do arquivo de credenciais.

import delta_sharing

client = delta_sharing.SharingClient(f"<profile-path>/config.share")

client.list_all_tables()

Se a saída estiver vazia ou não contiver as tabelas que você espera, entre em contato com o provedor de dados.

Acessar uso compartilhado de dados pandas

Para acessar dados compartilhados em pandas usando Python, execute o seguinte, substituindo as variáveis da seguinte forma:

<profile-path>: a localização do arquivo de credenciais.<share-name>: o valor deshare=para a tabela.<schema-name>: o valor deschema=para a tabela.<table-name>: o valor dename=para a tabela.

import delta_sharing

delta_sharing.load_as_pandas(f"<profile-path>#<share-name>.<schema-name>.<table-name>")

Acesse um feed de dados de alterações compartilhado usando pandas

Para acessar o feed de dados de alterações para uma tabela compartilhada em pandas usando Python , execute o seguinte, substituindo as variáveis da seguinte forma. Um feed de dados de alteração pode não estar disponível, dependendo se o provedor de dados compartilhou ou não o feed de dados de alteração para a tabela.

<starting-version>: opcional. A versão inicial da consulta, inclusive.<ending-version>: opcional. A versão final da consulta, inclusive.<starting-timestamp>: opcional. A data e hora de início da consulta. Isso é convertido em uma versão criada maior ou igual a esse carimbo de data/hora.<ending-timestamp>: opcional. O carimbo de data/hora final da consulta. Isso é convertido em uma versão criada anteriormente ou igual a esse carimbo de data/hora.

import delta_sharing

delta_sharing.load_table_changes_as_pandas(

f"<profile-path>#<share-name>.<schema-name>.<table-name>",

starting_version=<starting-version>,

ending_version=<ending-version>)

delta_sharing.load_table_changes_as_pandas(

f"<profile-path>#<share-name>.<schema-name>.<table-name>",

starting_timestamp=<starting-timestamp>,

ending_timestamp=<ending-timestamp>)

Se a saída estiver vazia ou não contiver os dados esperados, entre em contato com o provedor de dados.

Power BI: ler dados compartilhados

O conector Power BI Delta Sharing permite que o senhor descubra, analise e visualize o conjunto de dados compartilhado com o senhor por meio do protocolo aberto Delta Sharing.

Requisitos

- Power BI Desktop 2.99.621.0 ouacima.

- Acesso ao arquivo de credenciais que foi compartilhado pelo provedor de dados. Consulte Obter acesso no modelo de compartilhamento aberto.

Conectar-se ao Databricks

Para se conectar ao Databricks usando o conector Delta Sharing, faça o seguinte:

- Abra o arquivo de credencial compartilhada com um editor de texto para recuperar o URL endpoint e os tokens.

- Abra o Power BI Desktop.

- No menu Get Data (Obter dados ), procure por Delta Sharing .

- Selecione o conector e clique em Conectar .

- Digite o URL do endpoint que o senhor copiou do arquivo de credenciais no campo URL do Delta Sharing Server .

- Opcionalmente, em Advanced Options tab, defina um Row Limit para o número máximo de linhas que o senhor pode download. Isso é definido como 1 milhão de linhas em default.

- Clique em OK .

- Para Authentication (Autenticação ), copie os tokens que o senhor recuperou do arquivo de credenciais para Bearer tokens (Tokens do portador ).

- Clique em Conectar .

Limitações do conector Power BI Delta Sharing

O conector Power BI Delta Sharing tem as seguintes limitações:

- Os dados que o conector carrega devem caber na memória da sua máquina. Para gerenciar esse requisito, o conector limita o número de linhas importadas ao Limite de linhas que o senhor define nas Opções avançadas tab em Power BI Desktop.

Tableau: Ler dados compartilhados

O conector Tableau Delta Sharing permite que o senhor descubra, analise e visualize conjuntos de dados compartilhados com o senhor por meio do protocolo aberto Delta Sharing.

Requisitos

- Tableau Desktop e Tableau Server 2024.1 ou acima

- Acesso ao arquivo de credenciais que foi compartilhado pelo provedor de dados. Consulte Obter acesso no modelo de compartilhamento aberto.

Conectar-se ao Databricks

Para se conectar ao Databricks usando o conector Delta Sharing, faça o seguinte:

- Acesse Tableau Exchange, siga as instruções para download o conector Delta Sharing e coloque-o em uma pasta apropriada da área de trabalho.

- Abra o Tableau Desktop.

- Na página Connectors (Conectores ), procure por "Delta Sharing by Databricks".

- Selecione carregar arquivo de compartilhamento e escolha o arquivo de credencial que foi compartilhado pelo provedor.

- Clique em Obter dados .

- No Data Explorer, selecione a tabela.

- Opcionalmente, adicione filtros SQL ou limites de linha.

- Clique em Obter dados da tabela .

Limitações

O conector Tableau Delta Sharing tem as seguintes limitações:

- Os dados que o conector carrega devem caber na memória da sua máquina. Para gerenciar esse requisito, o conector limita o número de linhas importadas ao limite de linhas que o senhor definiu no Tableau.

- Todas as colunas são retornadas como tipo

String. - O SQL Filter só funciona se o seu servidor Delta Sharing suportar predicateHint.

- Os vetores de exclusão não são suportados.

- O mapeamento de colunas não é suportado.

Limitações do conector Python Delta Sharing

Essas limitações são específicas do conector Python Delta Sharing :

- O conector Python Delta Sharing 1.1.0+ O serviço suporta consultas Snapshot em tabelas com mapeamento de colunas, mas não suporta consultas CDF em tabelas com mapeamento de colunas.

- O conector Python Delta Sharing falha nas consultas CDF com

use_delta_format=Truese o esquema foi alterado durante o intervalo de versões consultado.

Solicite uma nova credencial

Se o URL de ativação da credencial ou a credencial de downloads for perdida, corrompida ou comprometida, ou se a credencial expirar sem que o provedor envie uma nova, entre em contato com o provedor para solicitar uma nova credencial.