Comece agora: Consulte LLMs e crie protótipos de agentes AI sem código.

Este tutorial sem código de 5 minutos apresenta o AI generativo em Databricks. O senhor usará o AI Playground para fazer o seguinte:

- Consulte modelos de linguagem grande (LLMs) e compare os resultados lado a lado

- Protótipo de um agente de chamada de ferramenta AI

- Exporte seu agente para codificar

- Opcional: prototipar um chatbot de perguntas e respostas usando a geração aumentada de recuperação (RAG)

Antes de começar

Certifique-se de que o site workspace possa acessar o seguinte:

-

Estrutura de Agentes. Veja recurso com disponibilidade regional limitada.

Etapa 1: Consultar LLMs usando o AI Playground

Use o AI Playground para consultar LLMs em uma interface de bate-papo.

- Em seu site workspace, selecione Playground .

- Digite uma pergunta como: "O que é RAG?"

Adicione um novo LLM para comparar as respostas lado a lado:

- No canto superior direito, selecione + para adicionar um modelo para comparação.

- No novo painel, selecione um modelo diferente usando o seletor dropdown.

- Marque as caixas de seleção Sincronizar para sincronizar as consultas.

- Experimente uma nova pergunta, como "O que é um sistema AI composto?", para ver as duas respostas lado a lado.

Continue testando e comparando diferentes LLMs para ajudá-lo a decidir qual é o melhor para usar na criação de um agente AI .

Etapa 2: Criar um protótipo de uma ferramenta, chamando o agente AI

As ferramentas permitem que os LLMs façam mais do que gerar linguagem. As ferramentas podem consultar dados externos, executar códigos e realizar outras ações. O AI Playground oferece ao senhor uma opção sem código para criar protótipos de agentes de chamadas de ferramentas:

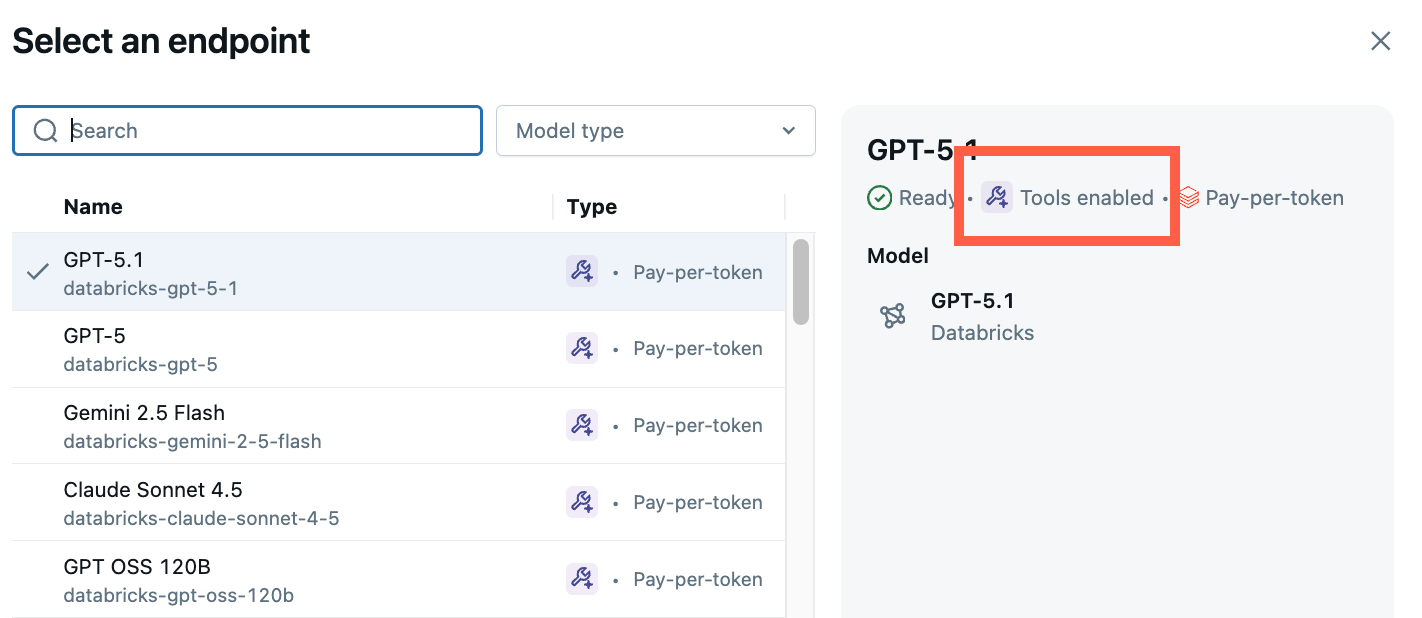

-

No Playground, escolha um modelo com o rótulo Tools enabled (Ferramentas ativadas ).

-

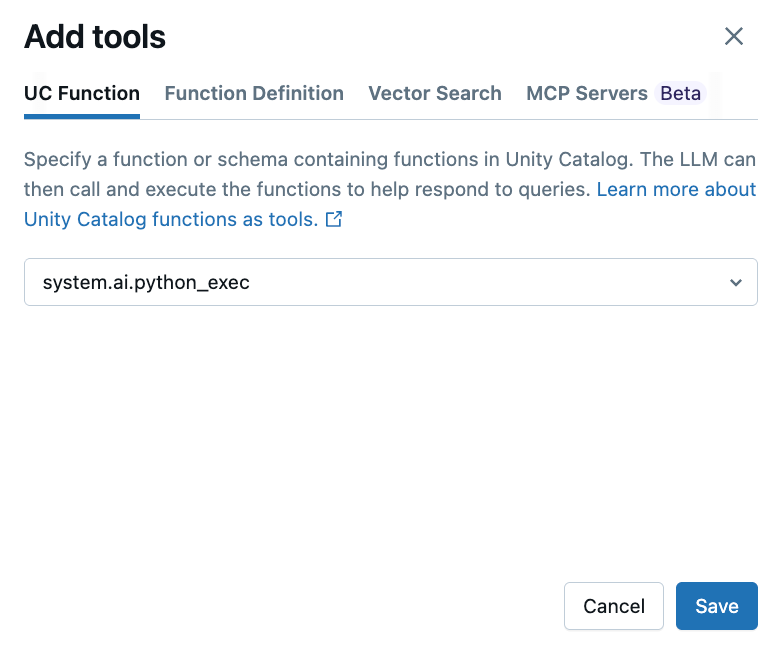

Selecione Tools (Ferramentas) > + Add tool (Adicionar ferramenta ) e selecione a função integrada do Unity Catalog,

system.ai.python_exec.Essa função permite que seu agente execute código Python arbitrário.

Outras opções de ferramentas incluem:

- Função UC : Selecione uma função Unity Catalog para o seu agente usar.

- Definição de função : Defina uma função personalizada para o seu agente chamar.

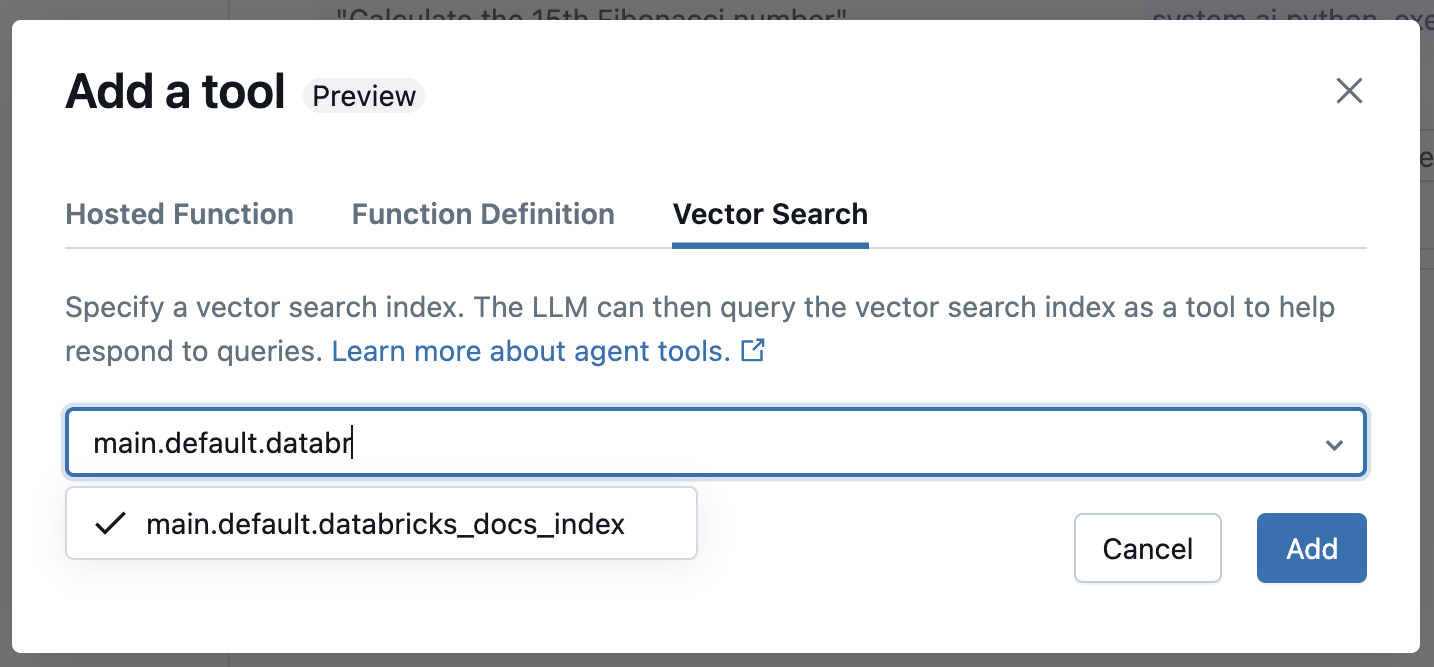

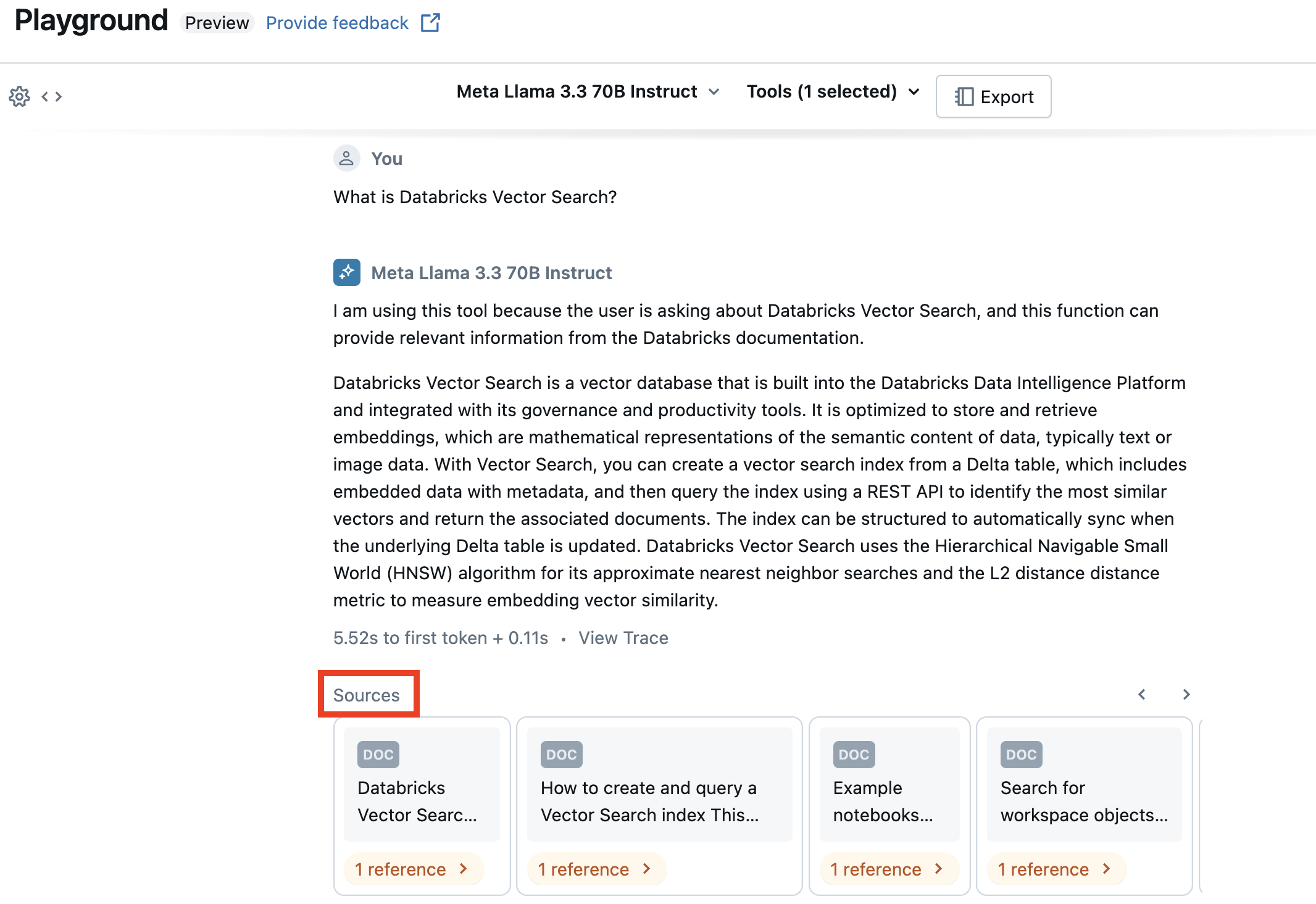

- Pesquisa vetorial : Especifique um índice de pesquisa vetorial. Se o seu agente usar um índice de busca vetorial, a resposta citará as fontes utilizadas.

- MCP : Especifique os servidores MCP a serem usados para gerenciar servidores MCP Databricks ou servidores MCP externos.

-

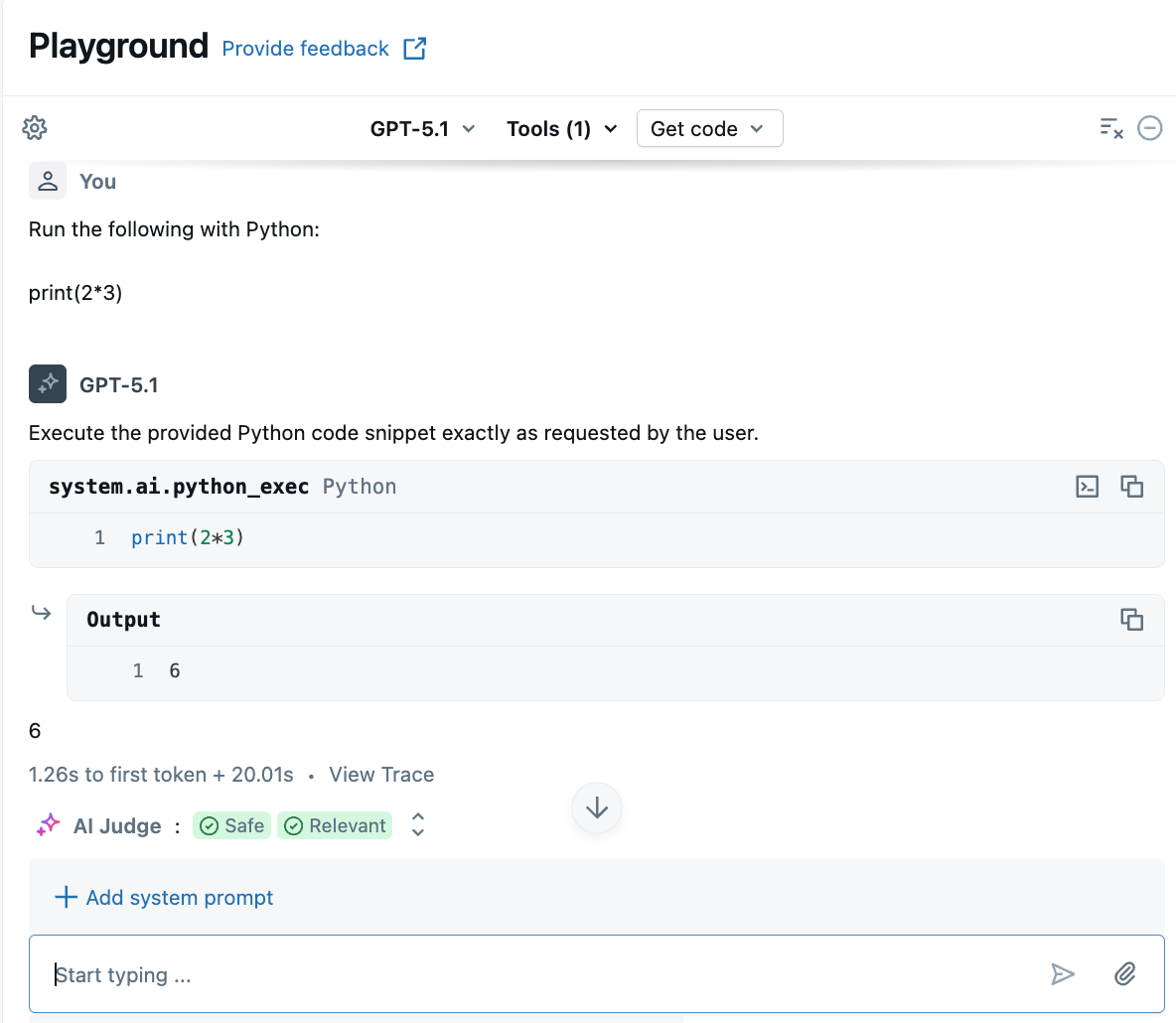

Faça uma pergunta que envolva a geração ou a execução de código Python. Você pode experimentar diferentes variações em seu fraseado imediato. Se o senhor adicionar várias ferramentas, o LLM selecionará a ferramenta apropriada para gerar uma resposta.

Etapa 3: exportar seu agente para codificar

Após testar seu agente no AI Playground, clique em Obter código > Criar notebook do agente para exportar seu agente para um notebook Python .

O Notebook Python contém o código que define o agente e o implanta em um modelo de serviço endpoint.

O Notebook exportado atualmente utiliza um fluxo de trabalho de autoria de agente legado que implantou o agente em modelo específico. A Databricks recomenda que os agentes de criação usem o Databricks Apps. Veja Criar um agente AI e implantá-lo em Databricks Apps.

Opcional: prototipar um bot RAG para responder perguntas

Se o senhor tiver um índice de pesquisa de vetores configurado em seu site workspace, poderá criar um protótipo de bot de perguntas e respostas. Esse tipo de agente usa documentos em um índice de pesquisa vetorial para responder perguntas com base nesses documentos.

-

Clique em Ferramentas > + Adicionar ferramenta . Em seguida, selecione seu índice de pesquisa vetorial.

-

Faça uma pergunta relacionada aos seus documentos. O agente pode usar o índice vetorial para pesquisar informações relevantes e citará todos os documentos usados em sua resposta.

Para configurar um índice de pesquisa vetorial, consulte Criar um índice de pesquisa vetorial.

Exportar e implantar agentes AI Playground

Após criar o protótipo do agente AI no AI Playground, exporte-o para um Notebook Python para implantá-lo em um endpoint de modelo de serviço.

-

Clique em Obter código > Criar notebook do agente para gerar o notebook que define e implanta o agente AI .

Após exportar o código do agente, uma pasta contendo um Notebook de drivers é salva em seu workspace. Este driver define uma ferramenta chamada ResponsesAgent, testa o agente localmente, usa registro baseado em código, registra e implanta o agente AI usando Mosaic AI Agent Framework.

-

Responda a todas as tarefas pendentes no caderno.

O código exportado pode se comportar de maneira diferente da sua sessão no AI Playground. Databricks recomenda executar o Notebook exportado para iterar e depurar ainda mais, avaliar a qualidade do agente e, em seguida, implantá-lo para compartilhar com outras pessoas.

Próximas etapas

Para criar agentes usando uma abordagem de código-primeiro, consulte Criar um agente AI e implantá-lo em Databricks Apps.