O que é a Databricks?

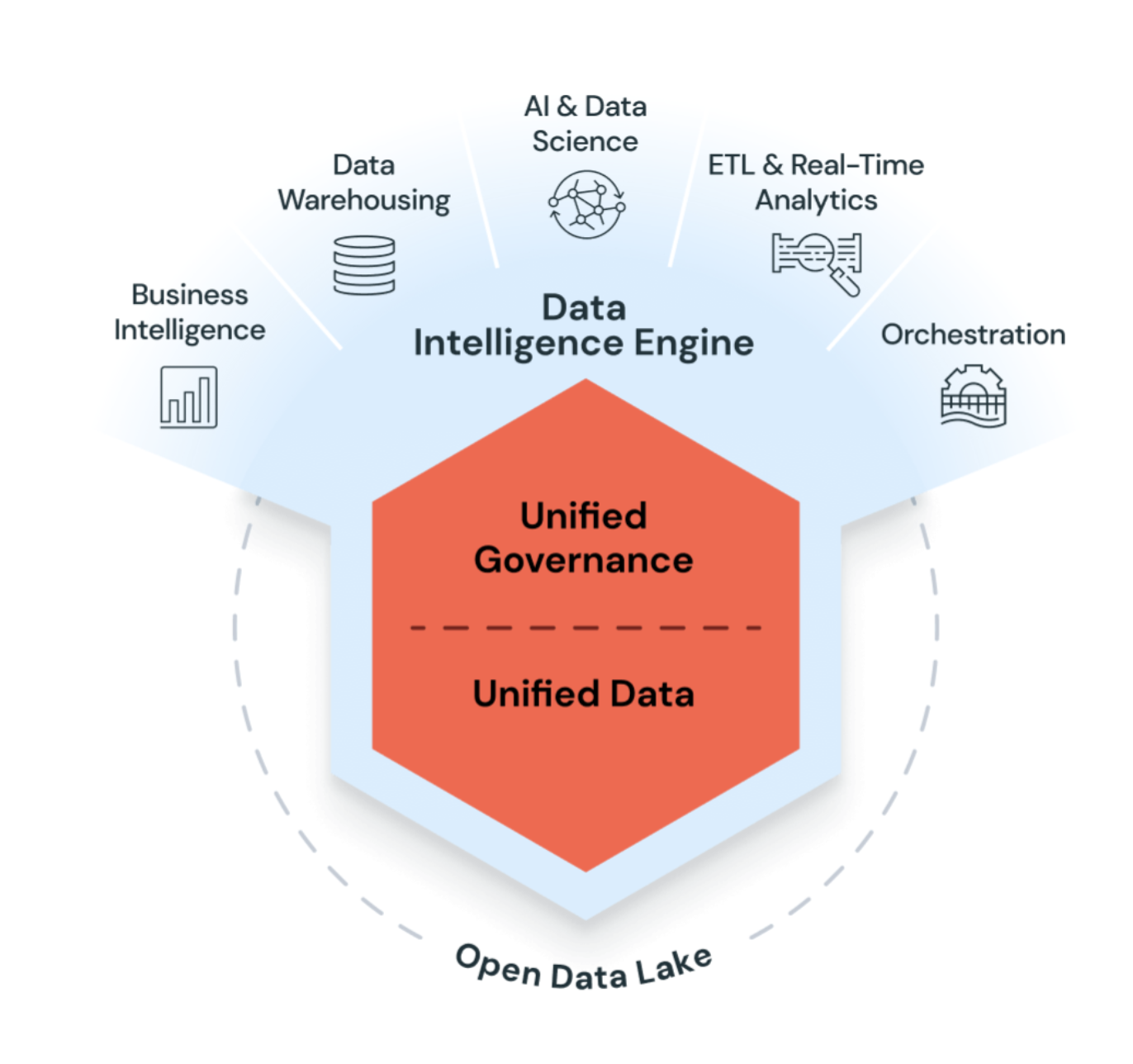

Databricks é uma plataforma analítica aberta e unificada para criação, implantação, compartilhamento e manutenção de análises de dados de nível empresarial e AI soluções em escala. A Databricks Data Intelligence Platform integra-se ao armazenamento em nuvem e à segurança em sua nuvem account, além de gerenciar e implantar a infraestrutura de nuvem para o senhor.

Databricks usa o generativo AI com o data lakehouse para entender a semântica exclusiva de seus dados. Em seguida, ele otimiza automaticamente o desempenho e gerencia a infraestrutura para atender às necessidades de sua empresa.

O processamento de linguagem natural aprende o idioma da sua empresa, para que você possa pesquisar e descobrir dados fazendo uma pergunta com suas próprias palavras. A assistência em linguagem natural ajuda você a escrever código, solucionar erros e encontrar respostas na documentação.

gerenciar código aberto integração

Databricks está comprometida com o código aberto comunidade e gerenciar as atualizações das integrações do código aberto com as versões do Databricks Runtime. As tecnologias a seguir são projetos de código aberto criados originalmente por funcionários do Databricks:

Casos de uso comuns

Os casos de uso a seguir destacam algumas das maneiras pelas quais os clientes usam o site Databricks para realizar tarefas essenciais para processar, armazenar e analisar os dados que impulsionam as funções e as decisões comerciais essenciais.

Criar uma empresa data lakehouse

O data lakehouse combina data warehouse corporativo e data lake para acelerar, simplificar e unificar as soluções de dados corporativos. O engenheiro de dados, data scientists, o analista e os sistemas de produção podem usar o data lakehouse como sua única fonte de verdade, fornecendo acesso a dados consistentes e reduzindo as complexidades da criação, manutenção e sincronização de muitos sistemas de dados distribuídos. Consulte O que é um data lakehouse?

ETL e engenharia de dados

Quer o senhor esteja gerando painéis ou alimentando aplicativos de inteligência artificial, a engenharia de dados fornece a espinha dorsal para empresas centradas em dados, garantindo que os dados estejam disponíveis, limpos e armazenados em modelos de dados para descoberta e uso eficientes. A Databricks combina o poder do Apache Spark com a Delta e ferramentas personalizadas para proporcionar uma experiência de ETL inigualável. Use os sites SQL, Python e Scala para compor a lógica do ETL e orquestrar a implantação de trabalhos agendados com apenas alguns cliques.

O pipeline declarativoLakeFlow Spark simplifica ainda mais ETL , gerenciando de forma inteligente as dependências entre os conjuntos de dados e implantando e dimensionando automaticamente a infraestrutura de produção para garantir a entrega de dados precisa e em tempo hábil, de acordo com suas especificações.

Databricks fornece ferramentas para ingestão de dados, incluindo Auto Loaderuma ferramenta eficiente e escalonável para carregar dados de forma incremental e idempotente do armazenamento de objetos na nuvem e do data lake no site data lakehouse.

Aprendizado de máquina, AI e ciência de dados

Databricks O aprendizado de máquina expande a funcionalidade principal da plataforma com um conjunto de ferramentas adaptadas às necessidades dos engenheiros de data scientists e ML, incluindo MLflow e Databricks Runtime para aprendizado de máquina.

Modelos de linguagem grandes e geradores AI

Databricks Runtime for Machine Learning inclui uma biblioteca como a Hugging Face Transformers, que permite que o senhor integre modelos pré-treinados existentes ou outra biblioteca de código aberto ao seu fluxo de trabalho. A integração Databricks MLflow facilita o uso do serviço de acompanhamento MLflow com pipeline de transformadores, modelos e componentes de processamento. Integre modelos OpenAI ou soluções de parceiros como o John Snow Labs em seu Databricks fluxo de trabalho.

Com a Databricks, personalize um LLM em seus dados para sua tarefa específica. Com o suporte de ferramentas de código aberto, como Hugging Face e DeepSpeed, o senhor pode usar com eficiência uma base LLM e começar a treinar com seus próprios dados para obter mais precisão para seu domínio e carga de trabalho.

armazenamento de dados, análise e BI

Databricks combina interfaces de usuário amigáveis com recursos compute econômicos e armazenamento infinitamente escalável e acessível, oferecendo uma plataforma poderosa para executar consultas analíticas. Os administradores configuram clusters compute escaláveis como um repositórioSQL, permitindo que os usuários finais executem consultas sem se preocuparem com as complexidades de trabalhar na cloud. Usuários SQL podem executar consultas em dados no lakehouse usando o editor de consultasSQL ou no Notebook. O Notebook oferece suporte Python, R e Scala além de SQL, e permite que os usuários incorporem as mesmas visualizações disponíveis nos dashboards, juntamente com links, imagens e comentários escritos em Markdown.

governança de dados e compartilhamento seguro de dados

O Unity Catalog fornece um modelo unificado de governança de dados para o data lakehouse. Os administradores da nuvem configuram e integram permissões de controle de acesso grosseiras para o Unity Catalog e, em seguida, os administradores do Databricks podem gerenciar as permissões para equipes e indivíduos. Os privilégios são gerenciados com listas de controle de acesso (ACLs) por meio de interfaces de usuário amigáveis ou sintaxe SQL, facilitando aos administradores de banco de dados a proteção do acesso aos dados sem a necessidade de escalonar o gerenciamento de acesso à identidade (IAM) e a rede nativos da nuvem.

Unity Catalog simplifica a execução de análises seguras na nuvem e oferece uma divisão de responsabilidade que ajuda a limitar a necessidade de requalificação ou atualização de habilidades para administradores e usuários finais da plataforma. Consulte O que é o Unity Catalog?

O lakehouse torna o compartilhamento de dados em sua organização tão simples quanto conceder acesso de consulta a uma tabela ou view. Para compartilhar fora de seu ambiente seguro, Unity Catalog recorra a uma versão gerenciar do Delta Sharing.

DevOps, CI/CD, e tarefa orquestração

Os ciclos de vida de desenvolvimento para pipelines de ETL, modelos de ML e painéis analíticos apresentam, cada um, seus próprios desafios únicos. O Databricks permite que todos os seus usuários aproveitem uma única fonte de dados, o que reduz esforços duplicados e relatórios fora de sincronia. Ao fornecer adicionalmente um conjunto de ferramentas comuns para controle de versão, automação, agendamento, implantação de código e recursos de produção, você pode simplificar sua sobrecarga de monitoramento, orquestração e operações.

Jobs programar Databricks Notebook, SQL consultas e outros códigos arbitrários. Databricks ativo Bundles permitem que o senhor defina, implante e execute Databricks recursos como Job e pipeline de forma programática. As pastas Git permitem que o senhor sincronize os projetos da Databricks com vários provedores git populares.

Para conhecer as melhores práticas e recomendações do CI/CD, consulte Melhores práticas e fluxo de trabalho recomendado CI/CD em Databricks. Para obter uma visão geral completa das ferramentas para desenvolvedores, consulte Develop on Databricks.

tempo real e transmissão analítica

Databricks aproveita a transmissão estruturada Apache Spark para trabalhar com transmissão de dados e alterações incrementais de dados. A transmissão estruturada integra-se perfeitamente com Delta Lake, e essas tecnologias fornecem as bases tanto para o pipeline declarativo Spark LakeFlow quanto para Auto Loader. Veja conceitos de transmissão estruturada.