MLflow para aplicativos e agentes GenAI

Os testes tradicionais de software e ML não foram criados para a linguagem de forma livre da GenAI , o que dificulta a medição e o aprimoramento da qualidade pelas equipes.

MLflow resolve isso combinando as métricas doAIque medem de forma confiável a qualidade do GenAI com observabilidade de rastreamento abrangente, permitindo que o senhor meça , melhore e monitore a qualidade durante todo o ciclo de vida do aplicativo.

Como o MLflow ajuda a medir e melhorar a qualidade dos aplicativos e agentes de GenAI

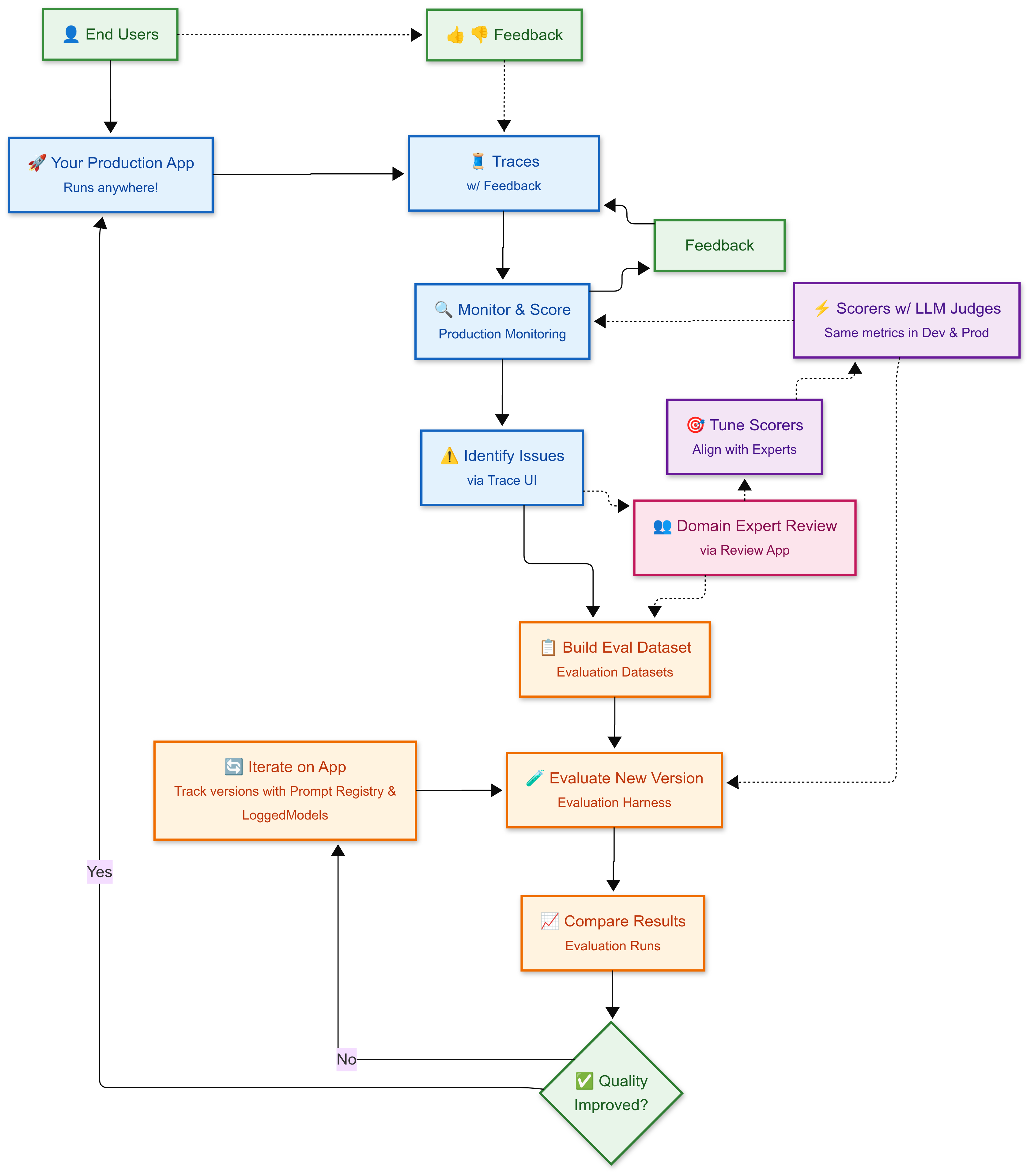

O MLflow ajuda o senhor a orquestrar um ciclo de melhoria contínua que incorpora o feedback do usuário e o julgamento de especialistas no domínio. Desde o desenvolvimento até a produção, o senhor usa métricas de qualidade consistentes (pontuadores) que são ajustadas para se alinhar com a experiência humana, garantindo que a avaliação automatizada reflita os padrões de qualidade do mundo real.

O ciclo de melhoria contínua

-

🚀 Aplicativo de produção: Seu aplicativo GenAI implantado atende aos usuários e gera rastreamentos com traços de execução detalhados com todas as etapas, entradas e saídas para cada interação

-

👍 👎 Feedback do usuário : os usuários finais fornecem feedback (polegar para cima/para baixo, avaliações) que é anexado a cada rastreamento, ajudando a identificar problemas de qualidade

-

🔍 Monitor & Score: Monitoramento automático da execução da produção LLM- pontuações baseadas em julgadores em traços para avaliar a qualidade, anexando o feedback a cada traço

-

⚠️ Identificar problemas : O usuário usa a Trace UI para encontrar padrões em traços de baixa pontuação por meio do feedback do usuário final e do juiz do LLM

-

👥 Revisão do especialista em domínio : Opcionalmente, o senhor pode enviar uma amostra de traços para especialistas em domínio por meio do Review App para obter uma avaliação detalhada do rótulo e da qualidade

-

📋 Criar conjunto de dados de avaliação : O senhor seleciona tanto os traços problemáticos quanto os traços de alta qualidade no conjunto de dados de avaliação, para que possa corrigir os ruins e preservar os bons

-

🎯 Ajuste os marcadores : opcionalmente, você usa o feedback de especialistas para alinhar seus marcadores e juízes com o julgamento humano, garantindo que os marcadores automatizados representem o julgamento humano

-

🧪 Avaliar novas versões : O senhor usa o chicote de avaliação para testar versões aprimoradas do aplicativo em relação ao seu conjunto de dados de avaliação, aplicando os mesmos pontuadores do monitoramento para avaliar se a qualidade melhorou ou regrediu. Opcionalmente, você usa o gerenciamento de versões e prompts para acompanhar seu trabalho.

-

📈 Comparar resultados : O senhor usa a execução da avaliação, gerada pelo chicote de avaliação, para comparar as versões e identificar as versões com melhor desempenho

-

✅ implantado ou Iterado : Se a qualidade melhorar sem regressão, implantado; caso contrário, iterar e reavaliar

Por que essa abordagem funciona

- Métricas alinhadas por humanos : Os avaliadores são ajustados para corresponder ao julgamento de especialistas no domínio, garantindo que a avaliação automatizada reflita os padrões de qualidade humana

- Métricas consistentes : Os mesmos avaliadores trabalham tanto no desenvolvimento quanto na produção

- Dados do mundo real : traços de produção se tornam casos de teste, garantindo que você corrija problemas reais do usuário

- Validação sistemática : Cada alteração é testada em relação ao conjunto de dados de regressão antes da implementação

- Aprendizado contínuo : Cada ciclo melhora seu aplicativo e seu conjunto de dados de avaliação

Próximas etapas

- Siga um guia de início rápido para configurar o rastreamento, executar sua primeira avaliação e coletar feedback de especialistas do domínio.

- Obtenha uma compreensão conceitual das abstrações do key que potencializam o MLflow - de Traces a conjuntos de dados de avaliação e Scorers.