Agentes de rastreamento implantados no Databricks

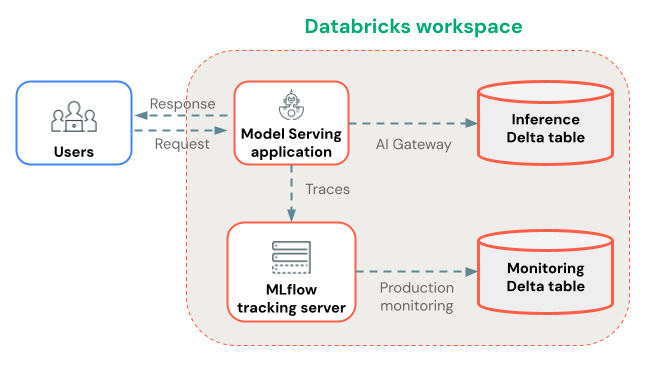

Esta página mostra como implantar aplicações GenAI no Databricks para que os rastreamentos de produção sejam capturados automaticamente.

Para aplicativos implantados fora Databricks, consulte Agentes de rastreamento implantados fora do Databricks.

Você pode implantar aplicativos GenAI no Databricks usando Mosaic AI Agent Framework (recomendado) ou um modelo de servidor de CPU personalizado. Independentemente do método de implantação escolhido, os rastreamentos são registros do seu experimento MLflow para visualização em tempo real. Opcionalmente, você pode armazenar registros de longo prazo em tabelas Delta usando o monitoramento de produção para armazenamento durável e avaliação automatizada da qualidade.

implantado com o Agent Framework (recomendado)

Ao implantar aplicações GenAI usando Mosaic AI Agent Framework, MLflow Tracing funciona automaticamente, sem necessidade de configuração adicional. Os registros são armazenados no experimento MLflow do agente.

Configure o(s) local(is) de armazenamento para os rastreamentos:

- Se o senhor planeja usar o monitoramento de produção para armazenar traços nas tabelas Delta, certifique-se de que ele esteja ativado para o seu workspace.

- Crie um MLflow Experiment para armazenar os traços de produção do seu aplicativo.

Em seguida, no Notebook Python, instale seu agente com MLflow Tracing e use o Agent Framework para implantá-lo:

- Instale a versão mais recente de

mlflow[databricks]em seu ambiente Python. - Conecte-se ao experimento MLflow usando

mlflow.set_experiment(...). - Envolva seu código de agente usando MLflow

ResponsesAgent. No código do seu agente, habilite MLflow Tracing usando instrumentação automática ou manual . - Registre seu agente como um modelo MLflow e registre-o em Unity Catalog.

- Certifique-se de que

mlflowesteja nas dependências Python do modelo, com a mesma versão de pacote usada no ambiente do Notebook. - Use

agents.deploy(...)para implantar o modelo Unity Catalog (agente) em um modelo de serviço endpoint.

Se você implantar um agente a partir de um Notebook armazenado em uma pasta Git Databricks, o rastreamento em tempo real MLflow 3 não funcionará por default.

Para habilitar o rastreamento em tempo real, defina o experimento como um experimento não associado ao Git usando mlflow.set_experiment() antes de executar agents.deploy().

Este Notebook demonstra a implantação dos passos acima.

Estrutura do agente e MLflow Tracing Notebook

implantado com serviço de CPU personalizado (alternativa)

Se você não puder usar o Agent Framework, implante seu agente usando um modelo de servidor de CPU personalizado.

Primeiro, configure o (s) local (s) de armazenamento para rastreamentos:

- Se o senhor planeja usar o monitoramento de produção para armazenar traços nas tabelas Delta, certifique-se de que ele esteja ativado para o seu workspace.

- Crie um MLflow Experiment para armazenar os traços de produção do seu aplicativo.

Em seguida, no Notebook Python, instale seu agente com MLflow Tracing e use a UI servindo modelo ou APIs para implantar seu agente:

- Registre seu agente como um modelo MLflow com instrumentação de rastreamento automática ou manual .

- implantado o modelo para servir a CPU.

- provisionamento a entidade de serviço ou Personal access token (PAT) com acesso

CAN_EDITao experimento MLflow. - Na página do endpoint de serviço da CPU, acesse "Edit endpoint." Para cada modelo implantado a ser rastreado, adicione a seguinte variável de ambiente:

ENABLE_MLFLOW_TRACING=trueMLFLOW_EXPERIMENT_ID=<ID of the experiment you created>- Se o senhor provisionar uma entidade de serviço, defina

DATABRICKS_CLIENT_IDeDATABRICKS_CLIENT_SECRET. Se o senhor provisionar um PAT, definaDATABRICKS_HOSTeDATABRICKS_TOKEN.

Armazenamento de rastreamento

Databricks logs os rastreamentos do experimento MLflow que você configurou com mlflow.set_experiment(...) durante a implantação. Os rastreamentos estão disponíveis para visualização em tempo real na interface do usuário do MLflow.

Os rastros são armazenados como artefatos, para os quais você pode especificar um local de armazenamento personalizado. Por exemplo, se você criar um experimento workspace com artifact_location definido para um volume Unity Catalog , o acesso aos dados de rastreamento será regido pelos privilégios do volumeUnity Catalog.

Armazene rastreando a produção a longo prazo.

Após os rastreamentos serem registrados em seu experimento MLflow , você pode, opcionalmente, armazená-los a longo prazo em tabelas Delta usando o monitoramento de produção (em versão beta).

Benefícios do monitoramento da produção para armazenamento de traços:

- Armazenamento durável : Armazene rastros em tabelas Delta para retenção a longo prazo, além do ciclo de vida do artefato do experimento MLflow.

- Sem limites de tamanho de rastreamento : Ao contrário de outros métodos de armazenamento, o monitoramento de produção lida com rastreamentos de qualquer tamanho.

- Avaliação automatizada da qualidade : execução de avaliadores MLflow em rastreamentos de produção para monitorar continuamente a qualidade da aplicação.

- Sincronização rápida : os rastreamentos são sincronizados com as tabelas Delta aproximadamente a cada 15 minutos.

Alternativamente, você pode usar tabelas de inferência habilitadas para AI Gateway para armazenar rastreamentos. No entanto, esteja ciente das limitações nos tamanhos de rastreamento e nos atrasos de sincronização.

Próximas etapas

- Visualizar rastreamentos na interface do usuário Databricks MLflow - visualizar rastreamentos na interface do usuário MLflow .

- Monitoramento da produção - Armazene rastros em tabelas Delta para retenção a longo prazo e avalie automaticamente com ferramentas de pontuação.

- Adicione contexto aos rastreamentos - Anexe metadados para acompanhamento de solicitações, sessões de usuário e dados de ambiente.