Databricks Geos: Residência de dados

Este artigo descreve como o Databricks Geos gerencia a residência de dados ao processar o conteúdo do cliente para um recurso conhecido como Serviço Designado.

Como o site Databricks gerencia a residência de dados ao processar o conteúdo do cliente?

Na arquitetura Databricks, há um "plano de controle", um "plano compute clássico" e um "planoserverless compute " que são fornecidos em uma base específica da região.

Os serviços designados, inclusive aqueles que alimentam as cargas de trabalho do Generative AI, estão disponíveis em Databricks Geos. Os serviços designados são sempre gerenciados pelo site Databricks em nome do cliente.

O conteúdo do cliente é processado apenas no mesmo Geo que o seu workspace, exceto para determinados serviços designados. Se um serviço designado não estiver disponível em seu site workspace Geo, um administrador do site account poderá usar o recurso dando permissão explícita para processar os dados relevantes em outro site Geo.

O que é um Databricks Geo?

Um Geo é um grupo de regiões de data center que a Databricks agrupa para oferecer aos clientes previsibilidade e transparência em relação ao local onde seus dados são processados.

Para obter mais informações, consulte Disponibilidade do serviço designado em cada Geo.

A tabela a seguir descreve o site Databricks Geos disponível e as regiões que ele inclui:

Databricks Geo | Compreendendo regiões em: |

|---|---|

Américas |

|

Ásia |

|

Austrália e Nova Zelândia |

|

Europa |

|

Índia |

|

China continental |

|

Oriente Médio e África |

|

Serviço designado oferecido em Geo

Se o senhor tiver um serviço designado que dependa de GPUs ou de outro processamento avançado, o conteúdo do cliente será processado apenas no site workspace Databricks Geos , a menos que o processamento entre regiões geográficas esteja ativado. Para obter mais informações, consulte Databricks Serviço designado.

Meus dados serão enviados para fora de um Geo?

O conteúdo do cliente é processado em Geos de forma semelhante ao modo como o plano clássico compute processa dados em uma região específica.

O conteúdo do cliente pode ser processado em Geos se o processamento entre regiões geográficas estiver ativado. Caso contrário, o conteúdo do cliente é processado no mesmo Geo que o do senhor workspace.

Habilitar o processamento entre regiões geográficas

Os administradores de conta podem habilitar o processamento cruzadoGeo que permite que os dados do serviço designado sejam processados fora de seu workspace Geo. Se um serviço designado não estiver disponível em seu workspace Geo, o senhor poderá usar o recurso dando permissão para processar os dados relevantes em outro Geo.

O processamento entre regiões geográficas é ativado por default para todos os espaços de trabalho em Geos fora dos EUA e da UE que não tenham um perfil de segurançacompliance ativado.

Administradores: se você não puder usar o recurso assistivo de AI Databricks, talvez seja necessário desabilitar Aplicar processamento de dados na Geografia workspace para o serviço Designado .

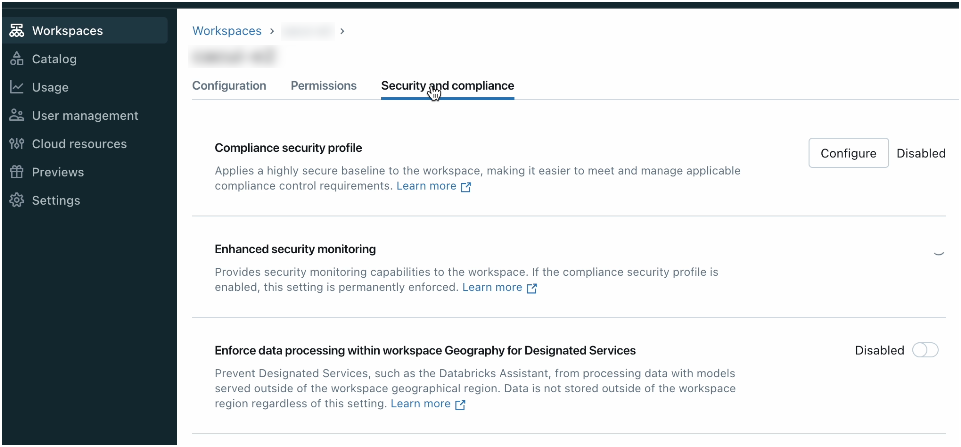

Para habilitar o processamento entre regiões geográficas:

-

Como administrador do account, acesse o consoleaccount.

-

Na barra lateral, clique em Workspaces .

-

Para localizar o workspace para o qual o senhor deseja controlar as configurações do Geo, use a caixa de pesquisa.

-

Clique no nome workspace e clique em Security e compliance tab.

-

Desativar o processamento de dados do Enforce em workspace Geography for Designated service .

Meus aviões compute existentes serão movidos para uma região diferente no mesmo Geo?

Não. Tanto no plano serverless quanto no plano compute clássico, os planos regionais compute permanecem em sua região para todos os serviços existentes. O avião clássico compute opera em um account sob seu controle, e o senhor deve especificar a região em que ele opera. serverless compute plane recurso, como serverless SQL warehouse, são oferecidos em uma base regional e não processam dados fora da região selecionada pelo senhor.

Como o site Geos afeta o Preview Recurso?

A menos que seja explicitamente indicado o contrário, o recurso de pré-visualização respeita a configuração "Impor processamento de dados dentro da geografia do workspace workspace para o serviço designado" . Se essa configuração estiver habilitada para um workspace, a visualização do recurso nesse workspace processará os dados dentro do workspace Geo.

Recurso adicional

- Recurso assistencialDatabricks AI.

- Consulte Confiança e segurança do recurso assistivoDatabricks AI para saber como os dados são usados e protegidos para Databricks AI.