Databricks でのファイルの操作

Databricks には、次の場所にあるファイルを操作するための複数のユーティリティと API があります。

- Unity Catalog ボリューム

- ワークスペース ファイル

- クラウドオブジェクトストレージ

- DBFS マウントと DBFSルート

- クラスターのドライバーノードにアタッチされたエフェメラルストレージ

この記事では、次のツールでこれらの場所にあるファイルを操作する例を示します。

- Apache Spark

- Spark SQL と Databricks SQL

- Databricks ファイルシステムユーティリティ (

dbutils.fsまたは%fs) - Databricks CLI

- Databricks REST API

- Bash シェル コマンド (

%sh) - ノートブック スコープのライブラリは、

%pip - pandas

- OSS Python ファイル管理および処理ユーティリティ

Databricks の一部の操作 (特に Java または Scala ライブラリを使用する操作) は、次のような JVM プロセスとして実行されます。

- Spark 構成での

--jarsを使用した JAR ファイル依存関係の指定 - Scalaノートブックでの

catまたはjava.io.Fileの呼び出し - カスタムデータソース (

spark.read.format("com.mycompany.datasource") - Javaの

FileInputStreamを使用してファイルをロードするライブラリまたはPaths.get()

これらの操作では、標準のファイル パス ( /Volumes/my-catalog/my-schema/my-volume/my-file.csvなど) を使用した Unity Catalog ボリュームまたはワークスペース ファイルの読み取りまたは書き込みはサポートされていません。JAR依存関係またはJVMベースのライブラリからボリュームファイルまたはワークスペースファイルにアクセスする必要がある場合は、最初にPythonまたは%shコマンド(%sh mv.など)を使用してファイルをコンピュートローカルストレージにコピーします。JVM を使用する %fs および dbutils.fs は使用しないでください。既にローカルにコピーされたファイルにアクセスするには、Python shutil などの言語固有のコマンドを使用するか、 %sh コマンドを使用します。クラスターの開始中にファイルが存在する必要がある場合は、最初にinitスクリプトを使用してファイルを移動します。 「initスクリプトとは」を参照してください。

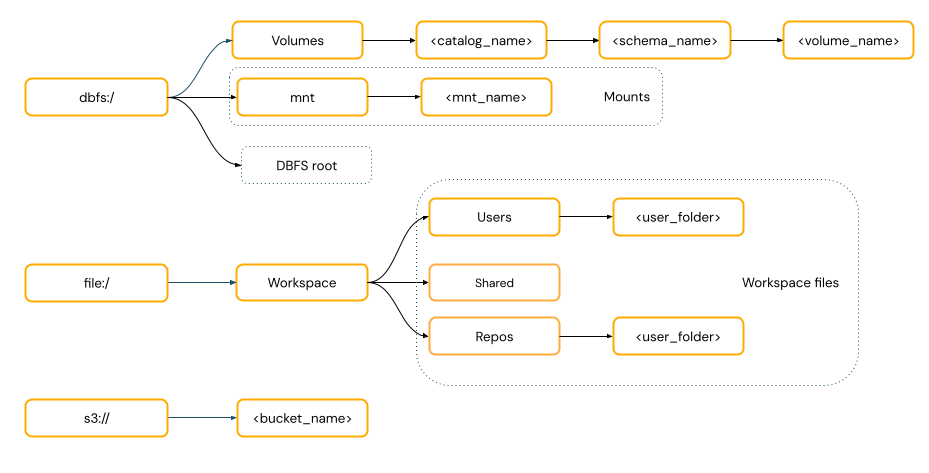

データにアクセスするためにURIスキームを提供する必要がありますか?

Databricks のデータ アクセス パスは、次のいずれかの標準に従います。

-

URI スタイルのパス には、URI スキームが含まれます。 Databricks ネイティブのデータ アクセス ソリューションの場合、URI スキームはほとんどのユース ケースで省略可能です。 クラウド・オブジェクト・ストレージ内のデータに直接アクセスする場合は、ストレージ・タイプに適した URI スキームを指定する必要があります。

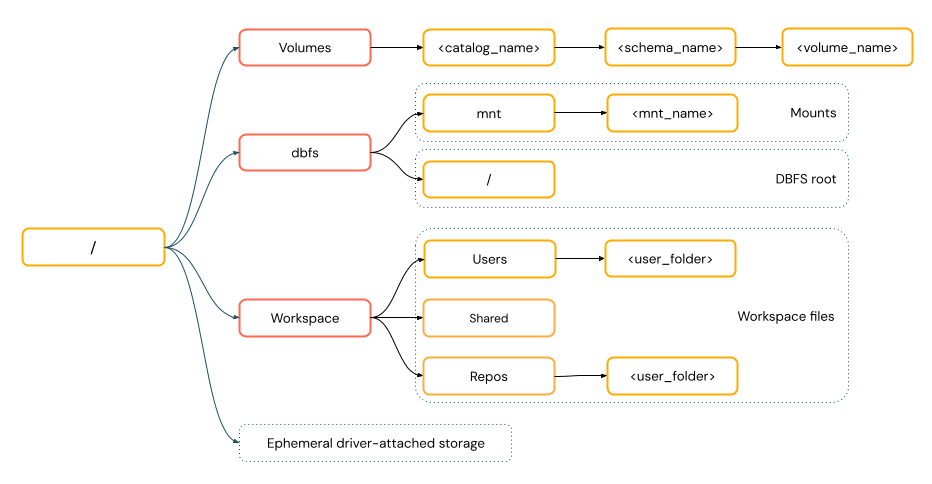

-

POSIX スタイルのパス は、ドライバーのルート (

/) を基準にしたデータアクセスを提供します。 POSIX スタイルのパスはスキームを必要としません。 Unity Catalog ボリュームまたは DBFS マウントを使用して、クラウド オブジェクト ストレージ内のデータへの POSIX スタイルのアクセスを提供できます。 多くの ML フレームワークやその他の OSS Python モジュールには FUSE が必要であり、POSIX スタイルのパスのみを使用できます。

FUSE データ・アクセスを必要とするファイル操作では、URI を使用してクラウド・オブジェクト・ストレージに直接アクセスすることはできません。 Databricks では、 Unity Catalog ボリュームを使用して FUSE のこれらの場所へのアクセスを設定することをお勧めします。

専用アクセス・モード (旧シングル・ユーザー・アクセス・モード) およびDatabricks Runtime 14.3 以降で構成されたコンピュートでは、Scala Unity CatalogScalaは、 から発生するサブプロセス (Scala コマンド ・ など) を除き、 ・ボリュームおよびワークスペース・ファイルの FUSE"cat /Volumes/path/to/file".!! をサポートします。

Unity Catalog ボリューム内のファイルを操作する

Databricks では、Unity Catalog ボリュームを使用して、クラウド オブジェクト ストレージに格納されている非表形式データ ファイルへのアクセスを構成することをお勧めします。詳細な手順やベスト プラクティスなど、ボリューム内のファイルの管理に関する完全なドキュメントについては、「 Unity Catalog ボリューム内のファイルの操作」を参照してください。

次の例は、さまざまなツールとインターフェイスを使用した一般的な操作を示しています。

ツール | 例 |

|---|---|

Apache Spark |

|

Spark SQL と Databricks SQL |

|

Databricks ファイルシステムユーティリティ |

|

Databricks CLI |

|

Databricks REST API |

|

Bash シェルコマンド |

|

ライブラリのインストール |

|

Pandas |

|

OSSのPythonの |

|

ボリュームの制限と回避策については、ボリューム内のファイルの操作の制限を参照してください。

ワークスペース ファイルの操作

Databricksワークスペース ファイルは、ワークスペース ストレージ アカウントに保存される、ワークスペース内のファイルです。ワークスペース ファイルを使用すると、ノートブック、ソース コード ファイル、データ ファイル、その他のワークスペース アセットなどのファイルを保存したり、アクセスしたりできます。

ワークスペース ファイルにはサイズ制限があるため、Databricks では、主に開発とテスト用に小さなデータ ファイルのみをここに保存することをお勧めします。他のファイル タイプを保存する場所に関する推奨事項については、 「ファイル タイプ」を参照してください。

ツール | 例 |

|---|---|

Apache Spark |

|

Spark SQL と Databricks SQL |

|

Databricks ファイルシステムユーティリティ |

|

Databricks CLI |

|

Databricks REST API |

|

Bash シェルコマンド |

|

ライブラリのインストール |

|

Pandas |

|

OSSのPythonの |

|

file:/ スキーマは、 Databricks ユーティリティ、 Apache Spark、または SQLを使用する場合に必要です。

DBFSルートとマウントが無効になっているワークスペースでは、 dbfs:/Workspace使用してDatabricksユーティリティでワークスペース ファイルにアクセスすることもできます。 これには、Databricks Runtime 13.3 LTS 以上が必要です。DBFSルートへのアクセスを無効にし、既存のDatabricksワークスペースにマウントする」を参照してください。

ワークスペースファイルの操作に関する制限事項については、 制限事項を参照してください。

削除されたワークスペース ファイルはどこに行きますか?

ワークスペース ファイルを削除すると、そのファイルはごみ箱に送られます。 UI を使用して、ごみ箱からファイルを回復または完全に削除できます。

オブジェクトの削除を参照してください。

クラウドオブジェクトストレージ内のファイルの操作

Databricks では、Unity Catalog ボリュームを使用して、クラウド オブジェクト ストレージ内のファイルへの安全なアクセスを構成することをお勧めします。URI を使用してクラウド・オブジェクト・ストレージ内のデータに直接アクセスすることを選択した場合は、権限を構成する必要があります。管理ボリュームと外部ボリュームを参照してください。

次の例では、URI を使用してクラウド・オブジェクト・ストレージ内のデータにアクセスします。

ツール | 例 |

|---|---|

Apache Spark |

|

Spark SQL と Databricks SQL |

|

Databricks ファイルシステムユーティリティ |

|

Databricks CLI | サポートされていない |

Databricks REST API | サポートされていない |

Bash シェルコマンド | サポートされていない |

ライブラリのインストール |

|

Pandas | サポートされていない |

OSSのPythonの | サポートされていない |

クラウドオブジェクトストレージは、クライアント側の暗号化が有効になっているAmazon S3マウントをサポートしていません。

DBFSマウントとDBFSルートでファイルを操作する

DBFSルートとDBFSマウントは両方とも非推奨であり、 Databricksでは推奨されていません。 新しいアカウントはこれらの機能にアクセスできない状態でプロビジョニングされます。Databricks 、代わりにUnity Catalogボリューム、外部ロケーション、またはワークスペース ファイルを使用することをお勧めします。

ツール | 例 |

|---|---|

Apache Spark |

|

Spark SQL と Databricks SQL |

|

Databricks ファイルシステムユーティリティ |

|

Databricks CLI |

|

Databricks REST API |

|

Bash シェルコマンド |

|

ライブラリのインストール |

|

Pandas |

|

OSSのPythonの |

|

Databricks CLI を使用する場合は、 dbfs:/ スキームが必要です。

ドライバーノードにアタッチされたエフェメラルストレージ内のファイルの操作

ドライバーノードにアタッチされたエフェメラルストレージは、組み込みPOSIXベースのパスアクセスを備えたブロックストレージです。 この場所に格納されているデータは、クラスターが終了または再起動すると消えます。

ツール | 例 |

|---|---|

Apache Spark | サポートされていない |

Spark SQL と Databricks SQL | サポートされていない |

Databricks ファイルシステムユーティリティ |

|

Databricks CLI | サポートされていない |

Databricks REST API | サポートされていない |

Bash シェルコマンド |

|

ライブラリのインストール | サポートされていない |

Pandas |

|

OSSのPythonの |

|

Databricks ユーティリティを使用する場合は、 file:/ スキーマが必要です。

エフェメラルストレージからボリュームへのデータの移動

Apache Spark を使用して、一時ストレージにダウンロードまたは保存されたデータにアクセスすることができます。 エフェメラル ストレージはドライバーにアタッチされ、Spark は分散処理エンジンであるため、すべての操作がここでデータに直接アクセスできるわけではありません。 ドライバー ファイルシステムから Unity Catalog ボリュームにデータを移動する必要があるとします。 その場合は、次の例のように、 マジック コマンド または Databricks ユーティリティを使用してファイルをコピーできます。

dbutils.fs.cp ("file:/<path>", "/Volumes/<catalog>/<schema>/<volume>/<path>")

%sh cp /<path> /Volumes/<catalog>/<schema>/<volume>/<path>

%fs cp file:/<path> /Volumes/<catalog>/<schema>/<volume>/<path>

追加のリソース

ローカル ファイルのアップロードまたはインターネット ファイルの Databricksへのダウンロードに関する情報については、「Databricksへのファイルのアップロード」を参照してください。