AI エージェントを作成する

この記事では、Databricks で AI エージェントを作成するプロセスを紹介し、エージェントの作成に使用できる方法の概要を説明します。

エージェントの詳細については、 「エージェント システムの設計パターン」を参照してください。

Agent Bricksでエージェントを自動的に構築

Agent Bricksは、一般的なAIユースケース向けに、ドメイン固有の高品質のAIエージェントシステムを構築および最適化するためのシンプルなアプローチを提供します。ユースケースとデータを指定すると、Agent BricksがいくつかのAIエージェントシステムを自動的に構築し、さらに改良することができます。エージェント ブリックを参照してください。

コードでエージェントを作成する

Mosaic AI Agent Framework と MLflow は、Python でエンタープライズ対応のエージェントを作成するのに役立つツールを提供します。

Databricks は、LangGraph/LangChain、OpenAI、LlamaIndex、カスタム Python 実装などのサードパーティ エージェント作成ライブラリを使用する作成エージェントをサポートしています。

すぐに開始するには、 「AI エージェントの使用を開始する」を参照してください。さまざまなフレームワークと高度な機能を備えたオーサリングエージェントの詳細については、 「 AIエージェントを作成してDatabricks Appsにデプロイする」を参照してください。

AI Playground を使用したエージェントのプロトタイピング

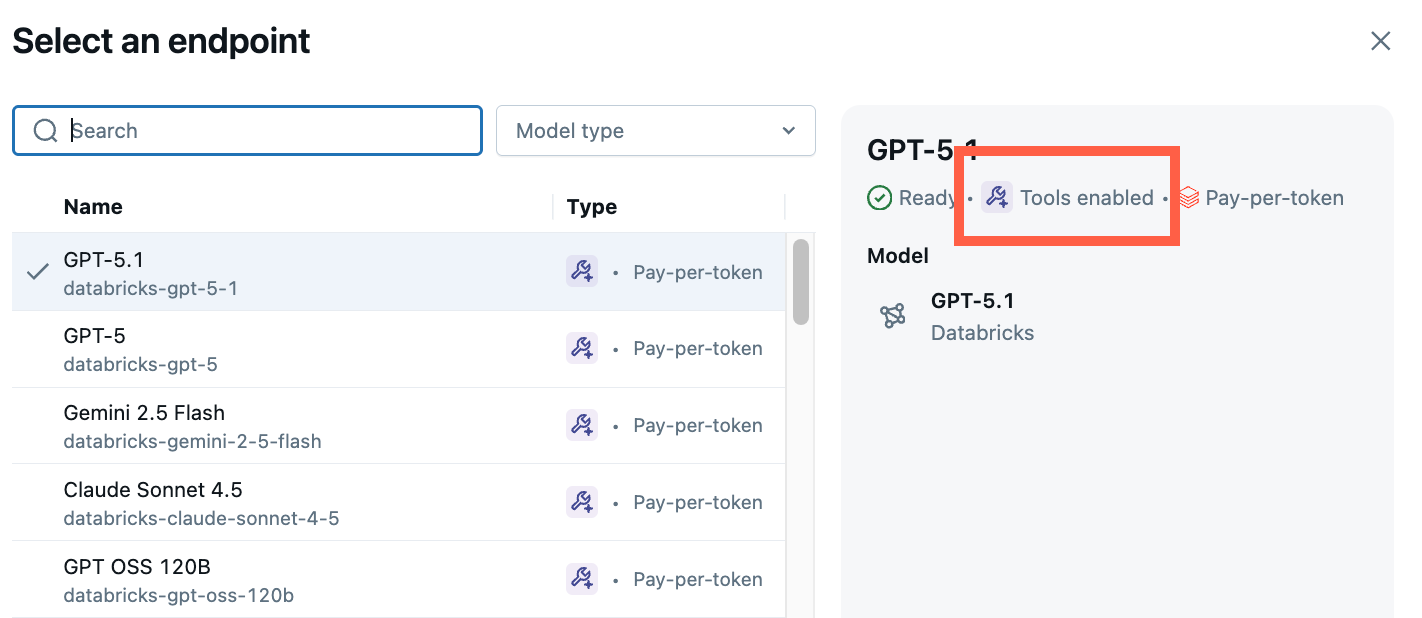

AI Playground は、Databricks でエージェントを作成する最も簡単な方法です。 AI Playground では、さまざまな LLM から選択し、ローコード UI を使用して LLM にツールをすばやく追加できます。 その後、エージェントとチャットして応答をテストし、エージェントをコードにエクスポートしてデプロイまたはさらに開発できます。

「はじめに: コードなしで LLM をクエリし、 AI エージェントのプロトタイプを作成する 」を参照してください。

モデルのシグネチャを理解して Databricks 機能との互換性を確保する

Databricks では、MLflow モデルシグネチャ を使用して、エージェントの入力スキーマと出力スキーマを定義します。 AI Playground などの製品機能は、エージェントがサポートされている一連のモデルシグネチャのいずれかを持っていることを前提としています。

ResponsesAgent インターフェイスを使用してエージェントを作成するための推奨アプローチに従うと、MLflow は Databricks 製品機能と互換性のあるエージェントの署名を自動的に推測します。

それ以外の場合は、エージェントがレガシー入力および出力エージェントスキーマ(モデルサービング)の他の署名のいずれかに準拠していることを確認する必要があります。 Databricks 機能との互換性を確保するためです。