MLflow para o ciclo de vida do modelo de ML

Este artigo descreve como MLflow o site on Databricks é usado para desenvolver agentes generativos de alta qualidade AI e modelos de aprendizado de máquina.

Se o senhor estiver começando a usar o Databricks, considere experimentar o MLflow no Databricks Free Edition.

O que é o MLflow?

MLflow é uma plataforma de código aberto para o desenvolvimento de modelos e aplicativos generativos AI. Ele tem os seguintes componentes principais:

- acompanhamento: Permite que o senhor acompanhe experimentos para registrar e comparar parâmetros e resultados.

- Modelos: Permite que o senhor gerencie e implante modelos de várias ML bibliotecas para várias plataformas de modelo de serviço e inferência.

- Model Registry: Permite que o senhor gerencie o processo de implementação de modelos, desde a preparação até a produção, com recursos de versão e anotação de modelos.

- AI Avaliação e rastreamento de agentes: Permite que o senhor desenvolva agentes de alta qualidade no site AI, ajudando-o a comparar, avaliar e solucionar problemas de agentes.

O MLflow é compatível com APIs Java, Python, R e REST.

MLflow 3

MLflow 3 em Databricks oferece acompanhamento de experimentos, observabilidade e avaliação de desempenho de última geração para modelos de aprendizado de máquina, aplicativos generativos AI e agentes no site Databricks lakehouse. Usando o MLflow 3 no Databricks, o senhor pode:

-

Rastreie e analise de forma centralizada o desempenho de seus modelos, aplicativos AI e agentes em todos os ambientes, desde consultas interativas em um Notebook de desenvolvimento até lotes de produção ou implantações de tempo real.

-

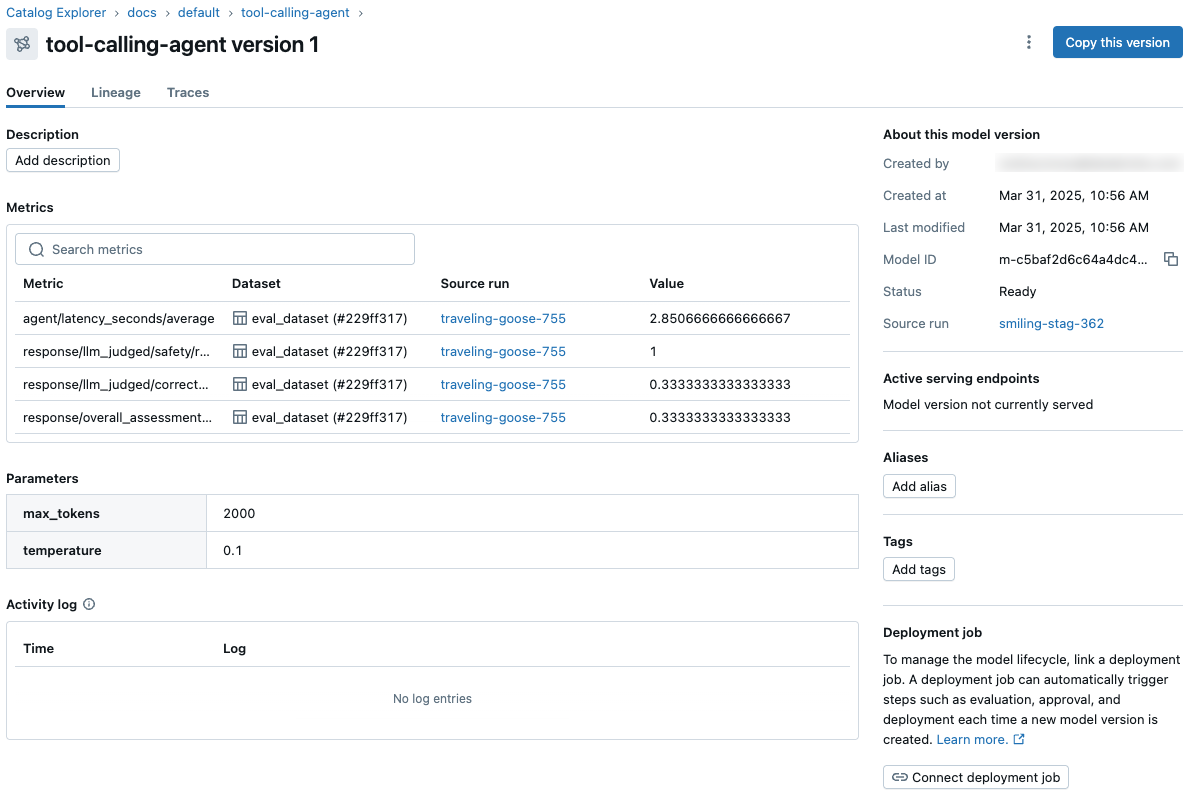

Orquestre a avaliação e o fluxo de trabalho de implantação usando Unity Catalog e acesse o status abrangente logs para cada versão do seu modelo, aplicativo AI ou agente.

-

visualize e acesse as métricas e os parâmetros do modelo na página da versão do modelo em Unity Catalog e no site REST API.

-

Anotar solicitações e respostas (traces ) para todos os seus aplicativos e agentes gen AI, permitindo que especialistas humanos e técnicas automatizadas (como o LLM-as-a-judge) forneçam feedback rico. O senhor pode aproveitar esse feedback para avaliar e comparar o desempenho das versões do aplicativo e criar um conjunto de dados para melhorar a qualidade.

Esses recursos simplificam e agilizam a avaliação, a implementação, a depuração e o monitoramento de todas as suas iniciativas de AI.

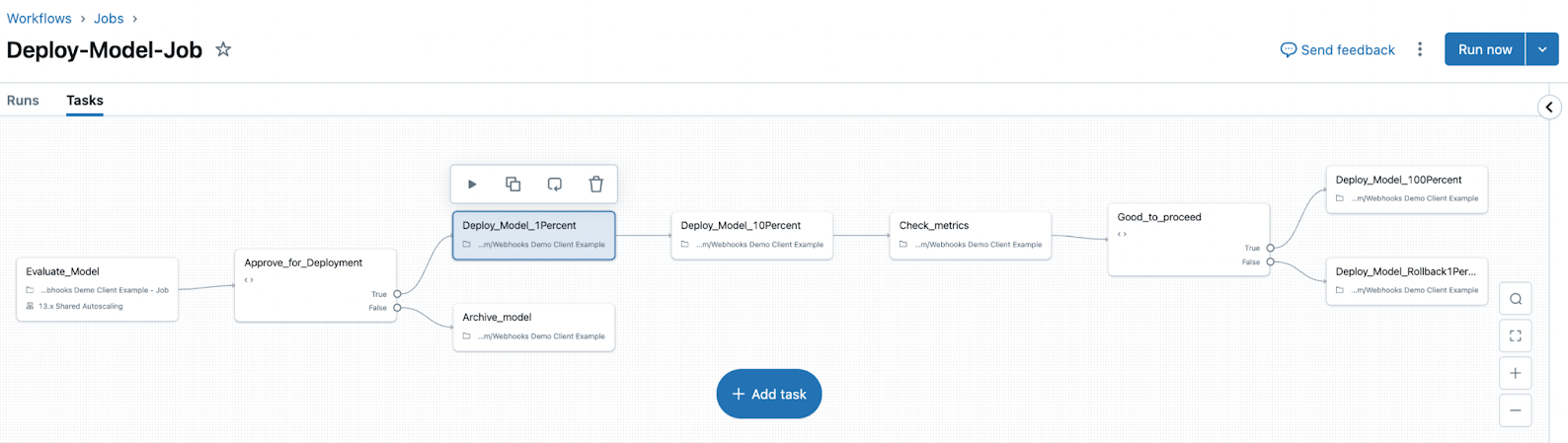

MLflow 3 também apresenta os conceitos de modelos registrados e trabalhos de implantação.

- Os modelos registrados ajudam o senhor a acompanhar o progresso de um modelo durante todo o seu ciclo de vida. Quando o senhor log um modelo usando

log_model(), é criado umLoggedModelque persiste durante todo o ciclo de vida do modelo, em diferentes ambientes e execuções, e contém links para artefatos como metadados, métricas, parâmetros e o código usado para gerar o modelo. O senhor pode usar os modelos registrados para comparar modelos entre si, encontrar o modelo de melhor desempenho e rastrear informações durante a depuração. - O trabalho de implantação pode ser usado para gerenciar o ciclo de vida do modelo, incluindo etapas como avaliação, aprovação e implantação. Esses modelos de fluxo de trabalho são regidos pelo site Unity Catalog, e todos os eventos são salvos em uma atividade log que está disponível na página da versão do modelo em Unity Catalog.

Consulte os artigos a seguir para instalar e começar a usar o MLflow 3.

- Comece com MLflow 3 para modelos.

- Acompanhe e compare modelos usando MLflow modelos logados.

- Model Registry melhorias com MLflow 3.

- MLflow 3 implantação Trabalho.

Databricks-gerenciar MLflow

Databricks oferece uma versão totalmente gerenciada e hospedada do MLflow, com base na experiência do código aberto para torná-lo mais robusto e dimensionável para uso corporativo.

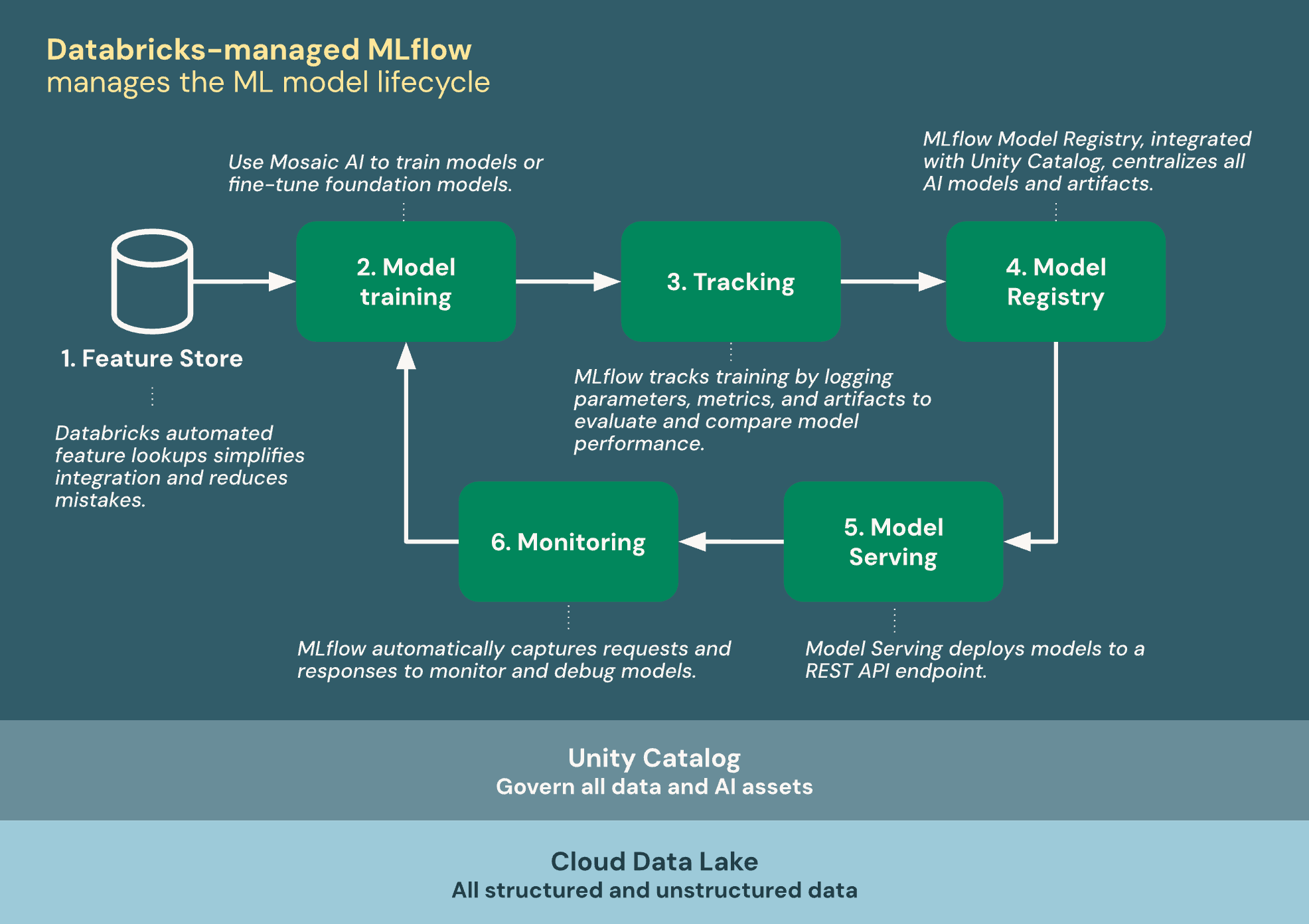

O diagrama a seguir mostra como o Databricks se integra ao MLflow para treinar e implantar o modelo de aprendizado de máquina.

Databricks-gerenciar MLflow foi desenvolvido com base em Unity Catalog e no lago de dados da nuvem para unificar todos os seus dados e AI ativos no ciclo de vida ML:

- recurso store: Databricks pesquisas automatizadas de recurso simplificam a integração e reduzem os erros.

- Treine modelos: Use o Mosaic AI para treinar modelos ou ajustar modelos básicos.

- acompanhamento : MLflow acompanha o treinamento registrando parâmetros, métricas e artefatos para avaliar e comparar o desempenho do modelo.

- Model Registry: MLflow Model Registry, integrado ao Unity Catalog, centraliza os modelos e artefatos do AI.

- servindo modelo: Mosaic AI Model Serving implantado modelos para a REST API endpoint.

- monitoramento: o site Mosaic AI Model Serving captura automaticamente solicitações e respostas para monitorar e depurar modelos. O MLflow aumenta esses dados com dados de rastreamento para cada solicitação.

Modelo treinamento

MLflow Os modelos estão no centro do desenvolvimento de AI e ML em Databricks. MLflow AI Os modelos são um formato padronizado para empacotar modelos de aprendizado de máquina e agentes generativos. O formato padronizado garante que os modelos e agentes possam ser usados por ferramentas downstream e fluxo de trabalho em Databricks.

- Documentação do MLflow - Modelos.

Databricks fornece recurso para ajudá-lo a treinar diferentes tipos de modelos ML.

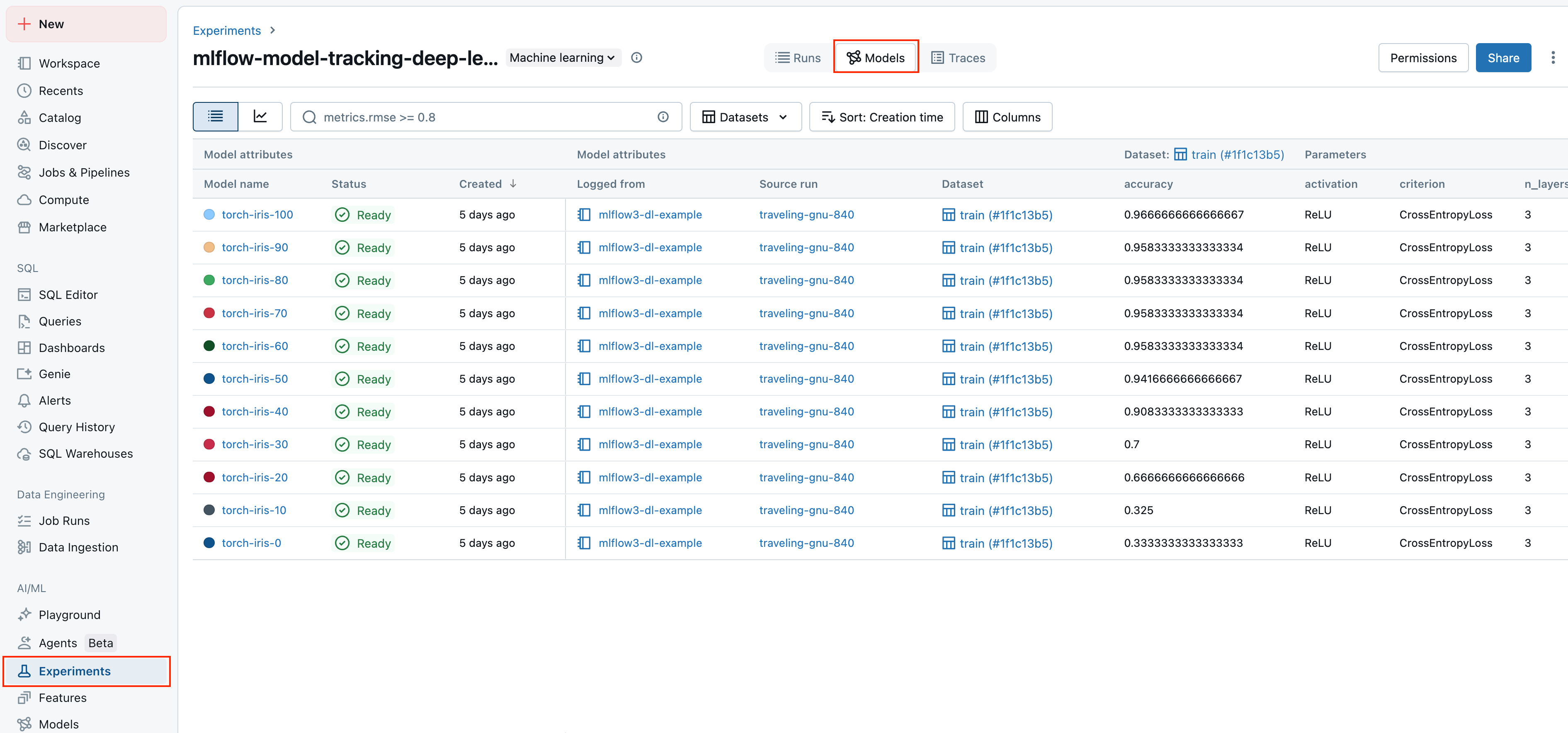

Experimentar acompanhamento

A Databricks usa experimentos MLflow como unidades organizacionais para acompanhar seu trabalho durante o desenvolvimento de modelos.

O acompanhamento de experimentos permite que o senhor log e gerencie parâmetros, métricas, artefatos e versões de código durante o treinamento de aprendizado de máquina e o desenvolvimento de agentes. A organização do logs em experimentos e execução permite comparar modelos, analisar o desempenho e iterar com mais facilidade.

- Acompanhamento de experimentos usando Databricks o site.

- Consulte a documentação do site MLflow para obter informações gerais sobre execução e acompanhamento de experimentos.

Model Registry com Unity Catalog

O MLflow Model Registry é um repositório de modelos centralizado, uma interface de usuário e um conjunto de APIs para gerenciar o processo de implantação de modelos.

A Databricks integra o Model Registry ao Unity Catalog para fornecer governança centralizada para modelos. Unity Catalog permite que o senhor acesse modelos em todo o espaço de trabalho, acompanhe a linhagem do modelo e descubra modelos para reutilização.

- gerenciar modelos usando Databricks Unity Catalog .

- Consulte a documentação do site MLflow para obter informações gerais sobre o Model Registry.

servindo modelo

Databricks O servindo modelo é totalmente integrado ao MLflow Model Registry e oferece uma interface unificada e escalonável para implantar, governar e consultar modelos AI. Cada modelo que o senhor atende está disponível como uma API REST que pode ser integrada a aplicativos da Web ou de clientes.

Embora sejam componentes distintos, o servindo modelo depende muito do MLflow Model Registry para lidar com o controle de versão do modelo, o gerenciamento de dependências, a validação e a governança.

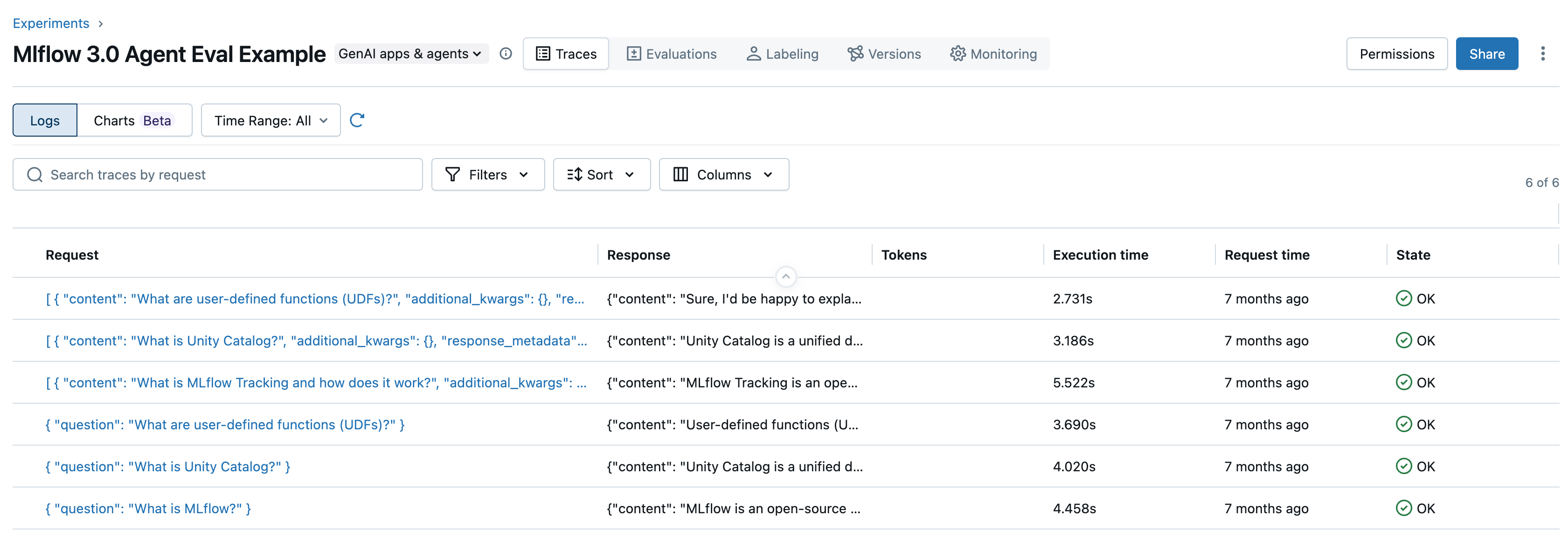

AI desenvolvimento e avaliação de agentes

Para o desenvolvimento do agente AI, o Databricks se integra ao MLflow de forma semelhante ao desenvolvimento do modelo ML. No entanto, existem algumas diferenças key:

- Para criar agentes AI em Databricks, use o Mosaic AI Agent Framework, que se baseia em MLflow para rastrear o código do agente, o desempenho métrico e os rastros do agente.

- Para avaliar agentes em Databricks, use o Mosaic AI Agent Evaluation, que se baseia no MLflow para rastrear os resultados da avaliação.

- MLflow O acompanhamento para agentes também inclui MLflow Tracing. MLflow Tracing permite que o senhor veja informações detalhadas sobre a execução do serviço do seu agente. O rastreamento registra as entradas, saídas e metadados associados a cada etapa intermediária de uma solicitação, permitindo que você encontre rapidamente a origem do comportamento inesperado nos agentes.

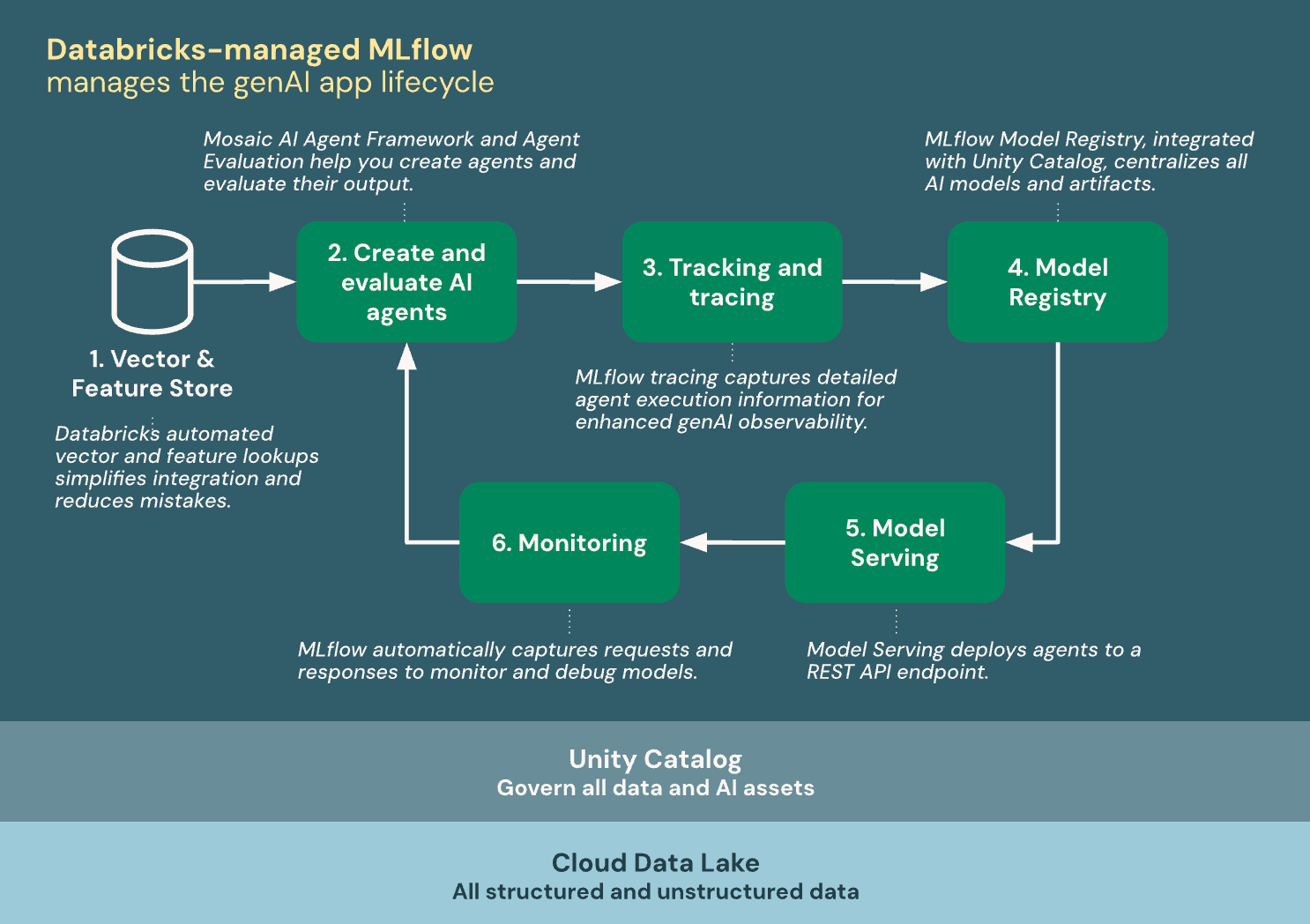

O diagrama a seguir mostra como o Databricks se integra ao MLflow para criar e implantar os agentes do AI.

Databricks-gerenciar MLflow foi desenvolvido com base em Unity Catalog e no lago de dados da nuvem para unificar todos os seus dados e AI ativos no ciclo de vida do aplicativo gen AI:

- Vector & recurso store: Databricks pesquisas automatizadas de vetores e recursos simplificam a integração e reduzem os erros.

- Crie e avalie os agentes do site AI: Mosaic AI Agent Framework e Agent Evaluation ajudam o senhor a criar agentes e avaliar seus resultados.

- acompanhamento e rastreamento: o rastreamento MLflow captura informações detalhadas sobre a execução do agente para melhorar a observabilidade generativa AI.

- Model Registry: MLflow Model Registry, integrado ao Unity Catalog, centraliza os modelos e artefatos do AI.

- servindo modelo: Mosaic AI Model Serving implantado modelos para a REST API endpoint.

- monitoramento: o site MLflow captura automaticamente solicitações e respostas para monitorar e depurar modelos.

código aberto vs. Databricks-gerenciar MLflow recurso

Para conhecer os conceitos gerais do MLflow, APIs e os recursos compartilhados entre as versões do código aberto e do Databricks-gerenciar, consulte a documentação doMLflow. Para o recurso exclusivo do Databricks-gerenciar MLflow, consulte a documentação da Databricks.

A tabela a seguir destaca as diferenças key entre o código aberto MLflow e Databricks-gerenciar MLflow e fornece links de documentação para ajudá-lo a saber mais:

Recurso | Disponibilidade no MLflow de código aberto | Disponibilidade em Databricks-gerenciar MLflow |

|---|---|---|

Segurança | O usuário deve fornecer sua própria camada de governança de segurança | |

Recuperação de desastres | Indisponível | |

Acompanhamento de experimentos | MLflow acompanhamento API integrado com Databricks acompanhamento avançado de experimentos | |

Registro de modelos | MLflow Model Registry integrado com Databricks Unity Catalog | |

Integração com o Unity Catalog | Integração de código aberto com o Unity Catalog | |

Implantação de modelos | Integrações configuradas pelo usuário com soluções de serviço externas (SageMaker, Kubernetes, serviços de contêineres, etc.) | Databricks servindo modelo e soluções de serviço externo |

AI agentes | MLflow LLM desenvolvimento integrado com Mosaic AI Agent Framework e Agent Evaluation | |

Criptografia | Indisponível | Criptografia usando a chave gerenciadora do cliente |

A coleta de telemetria de código aberto foi introduzida no MLflow 3.2.0. e está desativado em Databricks por default . Para obter mais detalhes, consulte a documentação de acompanhamento de uso doMLflow.