Databricks AI recurso assistencial confiança e segurança

Databricks entende a importância dos seus dados e a confiança que você deposita em nós ao usar nossa plataforma e o recurso de assistência AI Databricks . Databricks está comprometida com os mais altos padrões de proteção de dados e implementou medidas rigorosas para garantir que as informações que você envia ao recurso de assistência AI Databricks sejam protegidas.

-

Seus dados permanecem confidenciais.

- Databricks não treina modelos de base generativa com os dados que o usuário envia a esses recursos, e o Databricks não usa esses dados para gerar sugestões exibidas para outros clientes.

- Nossos parceiros modelo não retêm dados que você envia por meio desses recursos, mesmo para monitoramento de abuso. Nosso recurso assistencial de AI baseado em parceiros usa zero endpoint de retenção de dados de nosso modelo de parceiros.

-

Proteção contra saída prejudicial. Ao usar o Azure Open AI, o Databricks também usa a filtragem de conteúdo do Azure OpenAI para proteger os usuários de conteúdo prejudicial. Além disso, a Databricks realizou uma avaliação abrangente com milhares de interações simuladas de usuários para garantir que as proteções implementadas contra conteúdo prejudicial, jailbreaks, geração de código inseguro e uso de conteúdo protegido por direitos autorais de terceiros sejam eficazes.

-

A Databricks usa apenas os dados necessários para fornecer o serviço. Os dados são enviados somente quando você interage com o recurso de assistência AI Databricks . O Databricks envia seu prompt, metadados e valores de tabela relevantes, erros, bem como código de entrada ou consultas para ajudar a retornar resultados mais relevantes.

-

Databricks não treina modelos de base generativos com dados, prompts ou respostas que você enviar para esses recursos. A Databricks não utiliza esses dados para gerar sugestões exibidas para outros clientes.

-

Os dados são protegidos em trânsito e em repouso. Todo o tráfego entre Databricks e os parceiros do modelo é criptografado em trânsito com a criptografia TLS padrão das indústrias. Todos os dados armazenados em um Databricks workspace são criptografados em AES-256 bits.

-

O Databricks oferece controles de residência de dados. Os recursos assistivos AI Databricks são serviços designados e estão em conformidade com os limites de residência de dados. Para mais detalhes, consulte Databricks Geos: Residência de dados e Serviço designadoDatabricks.

Para saber mais sobre a privacidade do Databricks Assistant, consulte Perguntas frequentes sobre privacidade e segurança.

Perguntas frequentes sobre privacidade e segurança

Quais serviços e modelos o recurso assistivo AI baseado em parceiros utiliza?

Se a configuração de recurso AI com tecnologia de parceiros estiver ativada, o recurso de assistência AI Databricks usa modelos hospedados pelo serviço Azure OpenAI ou Anthropic no Databricks. Se você desativar a configuração de recursos AI com tecnologia de parceiros , alguns recursos de assistência AI poderão usar um modelo hospedado Databricks . Para mais informações, consulte recurso AI com tecnologia de parceiros.

Quais dados são enviados para os modelos?

O Databricks envia apenas os dados necessários para fornecer o serviço, que podem ser diferentes para cada recurso.

O Databricks Assistant envia seu prompt (por exemplo, sua pergunta ou código), bem como metadados relevantes para o modelo que alimenta o recurso em cada solicitação de API. Isso ajuda a retornar resultados mais relevantes para seus dados. Exemplos incluem:

- Código e consultas na célula atual do Notebook ou no editor SQL tab

- Nomes e descrições da tabela e da coluna

- Perguntas anteriores

- Mesas favoritas

O Modede Agente Assistente , agora em Beta, também pode analisar saídas de células e ler amostras de dados de tabelas, semelhante a outros agentes de codificação do setor.

O Genie usa seu prompt, metadados e valores de tabela relevantes, erros, bem como código de entrada ou consultas ao gerar uma resposta.

Para processar respostas, o Genie usa o seguinte:

- O prompt de linguagem natural enviado pelo usuário

- Nomes e descrições das tabelas

- Valores relevantes

- Instruções gerais

- Exemplos de consultas SQL

- Funções SQL

Para comentários gerados porAI , Databricks envia os seguintes metadados aos modelos com cada solicitação API :

- Catálogo (nome do catálogo, comentário atual, tipo de catálogo)

- Esquema (nome do catálogo, nome do esquema, comentário atual)

- Tabela (nome do catálogo, nome do esquema, nome da tabela, comentário atual)

- Função (nome do catálogo, nome do esquema, nome da função, comentário atual, parâmetros, definição)

- Modelo (nome do catálogo, nome do esquema, nome do modelo, comentário atual, aliases)

- Volume (nome do catálogo, nome do esquema, nome do volume, comentário atual)

- Nomes de colunas (nome da coluna, tipo, key primária ou não, comentário da coluna atual)

Os provedores de modelos parceiros armazenam meus dados?

Não. Ao usar modelos de parceiros por meio do Databricks, os provedores de modelos de parceiros não armazenam prompts ou respostas.

Onde estão as respostas do repositório de recursos assistenciais AI ?

As respostas Genie e os comentários aprovados gerados AIsão armazenados no banco de dados do plano de controle Databricks . O banco de dados do plano de controle é criptografado com AES de 256 bits.

O histórico de bate-papo do assistente é armazenado no mesmo lugar que outros conteúdos do Notebook.

Os dados enviados aos modelos respeitam as permissões do Unity Catalog do usuário?

Sim, todos os dados enviados aos modelos de recursos assistivos AI respeitam as permissões Unity Catalog , portanto, nenhum dado ao qual os usuários não têm acesso é enviado a esses modelos.

Outros usuários podem ver meu histórico de bate-papo com o Assistente ou Genie?

As interações com o Assistente são visíveis apenas para o usuário que as iniciou.

Os gerentes de espaço Genie podem ver as mensagens de outros usuários, mas não os resultados de suas consultas.

O Genie ou o Databricks Assistant executam código?

Genie foi projetado com acesso somente leitura aos dados do cliente, portanto, ele só pode gerar e executar consultas SQL somente leitura.

Com o Agent Mode, o Assistant pode executar códigos no Notebook e no editor SQL. Inicialmente, o Assistente solicitará sua confirmação para prosseguir com a execução. Você pode optar por confirmar, sempre permitir a execução no thread atual do Assistente ou sempre permitir a execução. Outros modos do Assistant não executam automaticamente o código em seu nome.

AI Os modelos podem cometer erros, não entender a intenção, alucinar ou dar respostas incorretas. Revise e teste o código gerado pelo AIantes de executá-lo.

Databricks fez alguma avaliação para avaliar a precisão e a adequação das respostas do recurso assistivo AI ?

Sim, Databricks realizou testes extensivos de todos os nossos recursos assistivos AI com base nos casos de uso esperados e usando entradas de usuários simuladas para aumentar a precisão e a adequação das respostas. Dito isto, AI generativa é uma tecnologia emergente, e os recursos assistivos AI podem fornecer respostas imprecisas ou inapropriadas.

Posso usar o recurso assistivo AI com tabelas que processam dados regulamentados (PHI, PCI, IRAP, FedRAMP)?

Sim Para isso, o senhor deve cumprir os requisitos, como ativar o perfil de segurançacompliance, e adicionar o padrão compliance relevante como parte da configuração do perfil de segurança compliance.

Como meu tráfego é roteado pelo Geos?

Os recursos assistivos AI Databricks são serviços designados que usam Databricks Geos para gerenciar a residência de dados ao processar o conteúdo do cliente. O roteamento de tráfego depende da sua região e se o processamento entre regiões geográficas está habilitado (a opção Aplicar processamento de dados na Geografia workspace para o serviço Designado está desabilitada).

Como os recursos assistivos AI funcionam com modelos hospedados Databricks ?

Quando o recurso assistivo de AI Databricks usa modelos hospedados Databricks , eles usam o OpenAI GPT OSS ou outros modelos disponíveis para uso comercial. Veja informações sobre licenciamento e uso de modelos AI generativos.

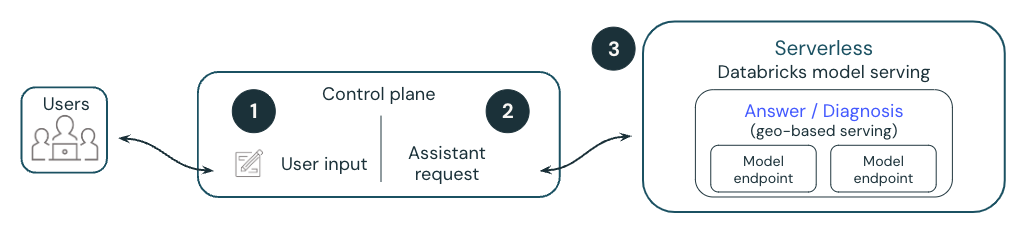

O diagrama a seguir fornece uma visão geral de como um modelo hospedado em Databricksalimenta o recurso Databricks AI , como o Quick Fix.

- Um usuário executa uma célula do Notebook, o que resulta em um erro.

- A Databricks anexa metadados a uma solicitação e a envia para um modelo de linguagem grande (LLM) hospedado pela Databricks. Todos os dados são criptografados em repouso. Os clientes podem usar um gerenciador de clientes key (CMK).

- O modelo hospedado na Databricks responde com as edições de código sugeridas para corrigir o erro, que é exibido para o usuário.