Databricks Runtime 7,4 (EoS)

O suporte para essa versão do Databricks Runtime foi encerrado. Para saber a data do fim do suporte, consulte Histórico do fim do suporte. Para conhecer todas as versões compatíveis do site Databricks Runtime, consulte Databricks Runtime notas sobre as versões e a compatibilidade.

A Databricks lançou esta versão em novembro de 2020.

As notas a seguir sobre a versão fornecem informações sobre o site Databricks Runtime 7.4, alimentado por Apache Spark 3.0.

Novo recurso

Nesta secção:

- Delta Lake recurso e melhorias

- Auto Loader Agora é possível delegar a configuração de recursos de notificação de arquivos aos administradores

- O novo privilégio

USAGEoferece aos administradores maior controle sobre os privilégios de acesso aos dados - DBFS O FUSE agora está habilitado para clustering habilitado para passthrough

Delta Lake recurso e melhorias

Esta versão oferece os seguintes Delta Lake recursos e melhorias:

- A nova API permite que o Delta Lake verifique se os dados adicionados a uma tabela satisfazem as restrições

- A nova API permite que o senhor reverta uma tabela Delta para uma versão mais antiga da tabela

- A nova versão inicial permite retornar apenas as alterações mais recentes em uma fonte de transmissão Delta Lake

- Estabilidade aprimorada do

OPTIMIZE

A nova API permite que o Delta Lake verifique se os dados adicionados a uma tabela satisfazem as restrições

O Delta Lake agora suporta as restrições do site CHECK. Quando fornecido, o Delta Lake verifica automaticamente se os dados adicionados a uma tabela satisfazem a expressão especificada.

Para adicionar as restrições do site CHECK, use o comando ALTER TABLE ADD CONSTRAINTS. Para obter detalhes, consulte Restrições em Databricks.

A nova API permite que o senhor reverta uma tabela Delta para uma versão mais antiga da tabela

Agora, o senhor pode reverter suas tabelas Delta para versões mais antigas usando o comando RESTORE:

- SQL

- Python

- Scala

RESTORE <table> TO VERSION AS OF n;

RESTORE <table> TO TIMESTAMP AS OF 'yyyy-MM-dd HH:mm:ss';

from delta.tables import DeltaTable

DeltaTable.forName(spark, "table_name").restoreToVersion(n)

DeltaTable.forName(spark, "table_name").restoreToTimestamp('yyyy-MM-dd')

import io.delta.tables.DeltaTable

DeltaTable.forName(spark, "table_name").restoreToVersion(n)

DeltaTable.forName(spark, "table_name").restoreToTimestamp("yyyy-MM-dd")

RESTORE cria um novo commit que reverte todas as alterações feitas na tabela desde a versão que o senhor deseja restaurar. Todos os dados e metadados existentes são restaurados, o que inclui o esquema, as restrições, os IDs das transações de transmissão, os metadados do site COPY INTO e a versão do protocolo da tabela. Para obter detalhes, consulte Restaurar uma tabela Delta.

A nova versão inicial permite retornar apenas as alterações mais recentes em uma fonte de transmissão Delta Lake

Para retornar somente as alterações mais recentes, especifique startingVersion como latest. Para obter detalhes, consulte Especificar a posição inicial.

Estabilidade aprimorada do OPTIMIZE

OPTIMIZE (sem nenhum predicado de partição) pode ser escalonado para execução em tabelas com dezenas de milhões de arquivos pequenos. Anteriormente, o driver Apache Spark podia ficar sem memória e o OPTIMIZE não era concluído.OPTIMIZE agora lida com tabelas muito grandes com dezenas de milhões de arquivos.

Auto Loader Agora é possível delegar a configuração de recursos de notificação de arquivos aos administradores

Um novo Scala API permite que os administradores configurem o recurso de notificação de arquivos para Auto Loader. Os engenheiros de dados agora podem operar sua transmissão Auto Loader com menos permissões, delegando a configuração inicial do recurso aos seus administradores. Consulte Configurar manualmente ou gerenciar recurso de notificação de arquivo.

O novo privilégio USAGE oferece aos administradores maior controle sobre os privilégios de acesso aos dados

Para realizar uma ação em um objeto em um banco de dados, agora você deve receber o privilégio USAGE nesse banco de dados, além dos privilégios necessários para realizar a ação. O privilégio USAGE é concedido para um banco de dados ou catálogo. Com a introdução do privilégio USAGE, o proprietário da tabela não pode mais decidir unilateralmente compartilhá-la com outro usuário; o usuário também deve ter o privilégio USAGE no banco de dados que contém a tabela.

No espaço de trabalho que tem o controle de acesso da tabela ativado, o grupo users tem automaticamente o privilégio USAGE para a raiz CATALOG.

Para obter detalhes, consulte USAGE privilege.

DBFS O FUSE agora está habilitado para clustering habilitado para passthrough

Agora é possível ler e gravar no DBFS usando a montagem FUSE em /dbfs/ quando o senhor estiver usando um cluster de alta simultaneidade habilitado para passagem de credenciais. Suportes regulares são suportados. Não há suporte para montagens que exigem credenciais de passagem.

Melhorias

O Spark SQL suporta IFF e CHARINDEX como sinônimos de IF e POSITION

No Databricks Runtime, IF() é sinônimo de CASE WHEN <cond> THEN <expr1> ELSE <expr2> END

O Databricks Runtime agora suporta IFF() como sinônimo de IF()

SELECT IFF(c1 = 1, 'Hello', 'World'), c1 FROM (VALUES (1), (2)) AS T(c1)

=> (Hello, 1)

(World, 2)

CHARINDEX é um nome alternativo para a função POSITION. CHARINDEX encontra a posição da primeira ocorrência de uma cadeia de caracteres dentro de outra cadeia de caracteres com um índice começar opcional.

VALUES(CHARINDEX('he', 'hello from hell', 2))

=> 12

Várias saídas por célula habilitadas para Python Notebook by default

Databricks Runtime A versão 7.1 introduziu o suporte a várias saídas por célula no Python Notebook (e células %python dentro de um Notebook que não sejaPython ), mas o senhor precisava ativar o recurso para o seu Notebook. Esse recurso é ativado por default em Databricks Runtime 7.4. Veja a visualização de várias saídas por célula.

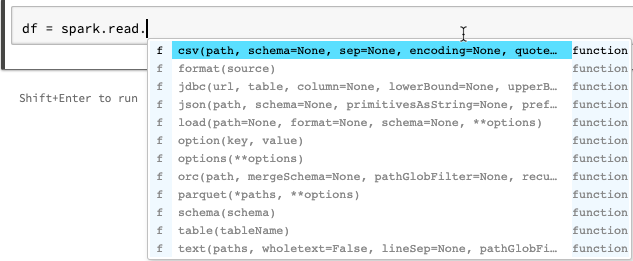

Melhorias no preenchimento automático para o Python Notebook

O preenchimento automático para Python mostra informações adicionais de tipo geradas a partir da análise estática do código usando a biblioteca Jedi. O senhor pode pressionar a guia key para ver uma lista de opções.

Melhoria do site display dos vetores Spark ML na visualização do Spark DataFrame

O formato display agora mostra rótulo para o tipo de vetor (esparso ou denso), comprimento, índices (para vetores esparsos) e valores.

Outras correções

- Foi corrigido um problema de decapagem com o site

collections.namedtupleno Notebook. - Corrigido um problema de decapagem com classes e métodos definidos interativamente.

- Foi corrigido um bug que fazia com que as chamadas para

mlflow.start_run()falhassem em passthrough ou clustering ativado para controle de acesso da tabela.

Atualizações da biblioteca

-

Atualizado Python biblioteca:

- jedi foi atualizado de 0.14.1 para 0.17.2.

- koalas foram atualizados de 1.2.0 para 1.3.0.

- parso foi atualizado de 0.5.2 para 0.7.0.

-

Atualizou várias instalações da R biblioteca. Consulte R biblioteca instalada.

Apache Spark

O Databricks Runtime 7.4 inclui o Apache Spark 3.0.1. Esta versão inclui todas as correções e melhorias do Spark incluídas no Databricks Runtime 7.3 LTS (EoS), bem como as seguintes correções de bugs e melhorias adicionais feitas no Spark:

- [SPARK-33170] [SQL] Adicionar configuração SQL para controlar o comportamento de falha rápida no FileFormatWriter

- [SPARK-33136] [SQL] Corrigir parâmetro de troca equivocada em V2WriteCommand.outputResolved

- [SPARK-33134] [SQL] Retorna resultados parciais apenas para objetos JSON raiz

- [SPARK-33038] [SQL] Combine os planos inicial e atual do AQE...

- [SPARK-33118] [SQL] CREATE TEMPORARY TABLE falha com a localização

- [SPARK-33101] [ML] Fazer com que o formato LibSVM propague a configuração do Hadoop das opções do DS para o sistema de arquivos HDFS subjacente

- [SPARK-33035] [SQL] Atualiza as entradas obsoletas do mapeamento de atributos em QueryPlan#transformUpWithNewOutput

- [SPARK-33091] [SQL] Evite usar map em vez de foreach para evitar possíveis efeitos colaterais em quem chama OrcUtils.readCatalystSchema

- [SPARK-33073] [Python] Melhorar o tratamento de erros em falhas de conversão de Pandas para Arrow

- [SPARK-33043] [ML] Manipular spark.driver.maxResultSize=0 no cálculo heurístico de RowMatrix

- [SPARK-29358] [SQL] Fazer com que unionByName preencha opcionalmente as colunas ausentes com nulos

- [SPARK-32996] [WEB-UI] Manipule executorMetrics vazios no ExecutorMetricsJsonSerializer

- [SPARK-32585] [SQL] Suporte à enumeração Scala em ScalaReflection

- [SPARK-33019] [CORE] Use spark.hadoop.mapreduce.fileoutputcommitter.algorithm.version=1 by default

- [SPARK-33018] [SQL] Corrigir problema de estatísticas de estimativa se o filho tiver 0 bytes

- [SPARK-32901] [CORE] Não aloque memória ao derramar UnsafeExternalSorter

- [SPARK-33015] [SQL] Usar millisToDays() na regra ComputeCurrentTime

- [SPARK-33015] [SQL] calcula a data atual apenas uma vez

- [SPARK-32999] [SQL] Use Utils.getSimpleName para evitar o acerto de um nome de classe malformado em TreeNode

- [SPARK-32659] [SQL] Transmitir matriz em vez de conjunto em InSubqueryExec

- [SPARK-32718] [SQL] Remover palavras-chave desnecessárias para unidades de intervalo

- [SPARK-32886] [WEBUI] corrigir link "indefinido" na linha do tempo do evento view

- [SPARK-32898] [CORE] Corrigir executorRunTime errado quando a tarefa é morta antes de começar de verdade

- [SPARK-32635] [SQL] Adicionar um novo caso de teste no módulo catalisador

- [SPARK-32930] [CORE] Substitua os métodos isFile/isDirectory obsoletos

- [SPARK-32906] [SQL] Os nomes dos campos de estrutura não devem ser alterados após a normalização de valores flutuantes

- [SPARK-24994] [SQL] Adicionar otimizador UnwrapCastInBinaryComparison para simplificar o literal integral

- [SPARK-32635] [SQL] Corrigir a propagação dobrável

- [SPARK-32738] [CORE] Deve reduzir o número de threads ativos se ocorrer um erro fatal em

Inbox.process - [SPARK-32900] [CORE] Permitir que UnsafeExternalSorter seja derramado quando houver nulos

- [SPARK-32897] [Python] Não mostrar um aviso de depreciação em SparkSession.builder.getOrCreate

- [SPARK-32715] [CORE] Corrige vazamento de memória quando falha ao armazenar partes da transmissão

- [SPARK-32715] [CORE] Corrige vazamento de memória quando falha ao armazenar partes da transmissão

- [SPARK-32872] [CORE] Impedir que BytesToBytesMap em MAX_CAPACITY exceda o limite de crescimento

- [SPARK-32876] [SQL] Alterar default fallback versões para 3.0.1 e 2.4.7 em HiveExternalCatalogVersionsSuite

- [SPARK-32840] [SQL] Um valor de intervalo inválido pode ser apenas um adesivo com a unidade

- [SPARK-32819] [SQL] O parâmetro ignoreNullability deve ser aplicado recursivamente

- [SPARK-32832] [SS] Use maiúsculas de minúsculas e minúsculas para opções de leitor/gravador do DataStream

- [SPARK-32794] [SS] Corrigido erro raro de caso de canto no mecanismo de micro-lotes com algumas consultas com estado + no-data-lotes + fontes V1

- [SPARK-32813] [SQL] Obter default config do leitor vetorizado ParquetSource se não estiver ativo SparkSession

- [SPARK-32823] [WEB UI] Corrigir o relatório de recurso da interface do usuário principal

- [SPARK-32824] [CORE] Aprimore a mensagem de erro quando o usuário esquecer o .amount em uma configuração de recurso

- [SPARK-32614] [SQL] Não aplicar o processamento de comentários se 'comment' não estiver definido para CSV

- [SPARK-32638] [SQL] Corrige referências ao adicionar aliases em WidenSetOperationTypes

- [SPARK-32810] [SQL] CSV/JSON fonte de dados deve evitar caminhos globbing ao inferir o esquema

- [SPARK-32815] [ML] Corrigir o erro de carregamento da fonte de dados do LibSVM em caminhos de arquivos com metacaracteres glob

- [SPARK-32753] [SQL] Copiar somente tags para nós sem tags

- [SPARK-32785] [SQL] Intervalo com partes pendentes não deve resultar em nulo

- [SPARK-32764] [SQL] -0.0 deve ser igual a 0.0

- [SPARK-32810] [SQL] CSV/JSON fonte de dados deve evitar caminhos globbing ao inferir o esquema

- [SPARK-32779] [SQL] Evite usar a API sincronizada do SessionCatalog no fluxo withClient, pois isso leva ao DeadLock

- [SPARK-32791] [SQL] As tabelas métricas não particionadas não devem ter tempo de poda de partição dinâmica

- [SPARK-32767] [SQL] Bucket join deve funcionar se spark.sql.shuffle.partitions for maior que o número do bucket

- [SPARK-32788] [SQL] A varredura de tabela não particionada não deve ter filtro de partição

- [SPARK-32776] [SS] O limite na transmissão não deve ser otimizado pelo PropagateEmptyRelation

- [SPARK-32624] [SQL] Corrigir regressão em CodegenContext.addReferenceObj em tipos Scala aninhados

- [SPARK-32659] [SQL] Melhorar o teste de poda de DPP em tipos não atômicos

- [SPARK-31511] [SQL] Tornar os iteradores do BytesToBytesMap seguros para threads

- [SPARK-32693] [SQL] Comparar dois dataframes com o mesmo esquema, exceto a propriedade nullable

- [SPARK-28612] [SQL] Corrigir o método doc de DataFrameWriterV2.replace()

Atualizações de manutenção

Consulte as atualizações de manutenção do Databricks Runtime 7.4.

Ambiente do sistema

- Sistema operacional : Ubuntu 18.04.5 LTS

- Java : Zulu 8.48.0.53-CA-linux64 (build 1.8.0_265-b11)

- Scala : 2.12.10

- Python : 3.7.5

- R : R versão 3.6.3 (2020-02-29)

- Delta Lake 0.7.0

Instalado Python biblioteca

Biblioteca | Versão | Biblioteca | Versão | Biblioteca | Versão |

|---|---|---|---|---|---|

criptomoeda asn1 | 1.3.0 | chamada de volta | 0.1.0 | boto3 | 1.12.0 |

botocore | 1,15.0 | certifi | 2020.6.20 | caffi | 1,14.0 |

chardet | 3.0.4 | criptografia | 2.8 | ciclador | 0.10.0 |

Cython | 0,29,15 | decorador | 4.4.1 | docutils | 0,15.2 |

pontos de entrada | 0,3 | Índia | 2.8 | ipykernel | 5.1.4 |

ipython | 7.12.0 | ipython-genutils | 0.2.0 | jedi | 0,17.2 |

jmespath | 0.10.0 | joblib | 0,14.1 | cliente jupyter | 5.3.4 |

núcleo jupyter | 4.6.1 | solucionador de kiwi | 1.1.0 | coalas | 1.3.0 |

Matplotlib | 3.1.3 | entorpecido | 1.18.1 | Pandas | 1.0.1 |

parso | 0.7.0 | bode expiatório | 0.5.1 | esperar | 4.8.0 |

picles | 0.7.5 | pip | 20,0.2 | kit de ferramentas de aviso | 3.0.3 |

psycopg2 | 2.8.4 | processo pty | 0.6.0 | flecha | 1.0.1 |

pycparser | 2,19 | Pigmentos | 2.5.2 | Objeto PYG | 3.26.1 |

PyOpenSSL | 19.1.0 | análise de pipa | 2.4.6 | Meias PY | 1.7.1 |

Python-apt | 1.6.5+ubuntu0.3 | Python-dateutil | 2.8.1 | pytz | 2019,3 |

pizma | 18.1.1 | pedidos | 2.22,0 | transferência s3 | 0.3.3 |

scikit-learn | 0,22,1 | pegajoso | 1.4.1 | marítimo | 0.10.0 |

ferramentas de configuração | 45,2,0 | seis | 1,14.0 | ID de importação ssh | 5.7 |

modelos de estatísticas | 0.11.0 | tornado | 6.0.3 | almôndegas | 4.3.3 |

atualizações autônomas | 0,1 | urllib3 | 1,25,8 | ambiente virtual | 16.7.10 |

largura do wc | 0.1.8 | Python wheel | 0,34,2 |

Instalada a R biblioteca

As bibliotecas R são instaladas a partir de Microsoft CRAN Snapshot em XXXX-XX-XX.

Biblioteca | Versão | Biblioteca | Versão | Biblioteca | Versão |

|---|---|---|---|---|---|

askpass | 1.1 | afirme que | 0.2.1 | portas traseiras | 1.1.8 |

base | 3.6.3 | base64enc | 0,1-3 | POR | 1,72,0-3 |

pouco | 1,1-15,2 | bit64 | 0,9-7 | bolha | 1.2.1 |

inicialização | 1,3-25 | fermentar | 1,0-6 | vassoura | 0.7.0 |

chamador | 3.4.3 | cursor | 6,0-86 | guarda de celas | 1.1.0 |

crono | 2,3-55 | Aula | 7,3-17 | CLIPE | 2.0.2 |

clipe | 0.7.0 | Cluster | 2.1.0 | ferramentas de código | 0,2-16 |

espaço de cores | 1,4-1 | marca comum | 1.7 | compilador | 3.6.3 |

configuração | 0,3 | capa | 3.5.0 | giz de cera | 1.3.4 |

diafonia | 1.1.0.1 | cacho | 4.3 | data.tabela | 1.12.8 |

conjunto de dados | 3.6.3 | DBI | 1.1.0 | dbplyr | 1.4.4 |

desc | 1.2.0 | ferramentas de desenvolvimento | 2.3.0 | digerir | 0,6,25 |

dplyr | 0,8.5 | DT | 0,14 | reticências | 0.3.1 |

avalie | 0,14 | fansi | 0.4.1 | colorista | 2.0.3 |

mapa rápido | 1.0.1 | para gatos | 0.5.0 | para cada um | 1.5.0 |

estrangeira | 0,8-76 | forjar | 0.2.0 | fs | 1.4.2 |

genéricas | 0.0.2 | ggplot2 | 3.3.2 | gh | 1.1.0 |

git2r | 0,27.1 | glmnet | 3,0-2 | globais | 0,12,5 |

cola | 1.4.1 | goleiro | 0.2.2 | gráficos | 3.6.3 |

Dispositivos GR | 3.6.3 | grade | 3.6.3 | Grid Extra | 2.3 |

gsubfn | 0,7 | mesa | 0.3.0 | refúgio | 2.3.1 |

mais alto | 0,8 | HMS | 0.5.3 | ferramentas html | 0.5.0 |

widgets html | 1.5.1 | http.uv | 1.5.4 | httr | 1.4.1 |

escritor | 1.3.2 | HWriter Plus | 1,0-3 | mini | 0.3.1 |

ipred | 0,9-9 | isóbanda | 0.2.2 | iteradores | 1.0.12 |

jsonlite | 1.7.0 | Kern Smooth | 2,23-17 | tricotar | 1,29 |

rótulo | 0,3 | posteriormente | 1.1.0.1 | treliça | 0,20-41 |

lava | 1.6.7 | preguiçoso | 0.2.2 | ciclo de vida | 0.2.0 |

lubrificar | 1.7.9 | magritter | 1.5 | Markdown | 1.1 |

MASSA | 7,3-53 | Matriz | 1,2-18 | memoise | 1.1.0 |

métodos | 3.6.3 | mgcv | 1,8-33 | mímica | 0,9 |

Métricas do modelo | 1.2.2.2 | modelar | 0.1.8 | munsell | 0.5.0 |

nome | 3,1-149 | net | 7,3-14 | Número Deriv | 2016,8-1,1 |

openssl | 1.4.2 | paralelo | 3.6.3 | pilar | 1.4.6 |

pkgbuild | 1.1.0 | pkgconfig | 2.0.3 | carregamento de pacotes | 1.1.0 |

plogr | 0.2.0 | plyr | 1.8.6 | elogio | 1.0.0 |

unidades bonitas | 1.1.1 | ProC | 1.16.2 | processa | 3.4.3 |

prodlim | 13/11/2019 | progresso | 1.2.2 | promessas | 1.1.1 |

proto | 1.0.0 | ps | 1.3.3 | ronronar | 0.3.4 |

r2d3 | 0.2.3 | R6 | 2.4.1 | Floresta aleatória | 4,6-14 |

corredeiras | 0.3.1 | rcmdcheck | 1.3.3 | Cervejaria RColor | 1,1-2 |

Rcpp | 1.0.5 | leitor | 1.3.1 | readxl | 1.3.1 |

receitas | 0.1.13 | revanche | 1.0.1 | revanche 2 | 2.1.2 |

controles remotos | 2.1.1 | reprex | 0.3.0 | remodelar 2 | 1.4.4 |

rex | 1.2.0 | rojson | 0.2.20 | rlang | 0.4.7 |

rmarkdown | 2.3 | RODBC | 1,3-16 | roxigênio2 | 7.1.1 |

rpartem | 4,1-15 | rprojroot | 1,3-2 | Reservar | 1,8-7 |

RSQLite | 2.2.0 | API do estúdio | 0,11 | reversões | 2.0.2 |

colete | 0.3.5 | escala | 1.1.1 | seletor | 0,4-2 |

informações da sessão | 1.1.1 | forma | 1.4.4 | brilhante | 1.5.0 |

ferramentas de origem | 0.1.7 | Sparklyr | 1.3.1 | SparkR | 3.0.0 |

espacial | 7,3-11 | splines | 3.6.3 | sqldf | 0,4-11 |

QUADRADO | 2020,3 | estatísticas | 3.6.3 | estatísticas4 | 3.6.3 |

stringi | 1.4.6 | longarina | 1.4.0 | sobrevivência | 3,2-7 |

diz | 3.3 | tcltk | 3.6.3 | Demonstrações de ensino | 2,10 |

teste isso | 2.3.2 | petiscar | 3.0.3 | arrumado | 1.1.0 |

seleção arrumada | 1.1.0 | tidyverso | 1.3.0 | Hora/Data | 3043,102 |

tinytex | 0,24 | Ferramentas | 3.6.3 | use isso | 1.6.1 |

utf 8 | 1.1.4 | utilidades | 3.6.3 | uuid | 0,1-4 |

vctrs | 0.3.1 | Viridis Lite | 0.3.0 | bigode | 0,4 |

murchar | 2.2.0 | diversão | 0,15 | xml2 | 1.3.2 |

xopen | 1.0.0 | x estável | 1,8-4 | yaml | 2.2.1 |

Instalei Java e Scala biblioteca (versão de clusteringScala 2.12)

ID do grupo | ID do artefato | Versão |

|---|---|---|

chifre | chifre | 2.7.7 |

com.amazonaws | Amazon-kinesis-client | 1.12.0 |

com.amazonaws | aws-java-sdk-autoscale | 1,11.655 |

com.amazonaws | formação de nuvem aws-java-sdk | 1,11.655 |

com.amazonaws | aws-java-sdk-cloudfront | 1,11.655 |

com.amazonaws | aws-java-sdk-cloudhsm | 1,11.655 |

com.amazonaws | aws-java-sdk-cloudsearch | 1,11.655 |

com.amazonaws | aws-java-sdk-cloudtrail | 1,11.655 |

com.amazonaws | aws-java-sdk-cloudwatch | 1,11.655 |

com.amazonaws | métricas aws-java-sdk-cloudwatch | 1,11.655 |

com.amazonaws | aws-java-sdk-codedeploy | 1,11.655 |

com.amazonaws | identidade cognitiva aws-java-sdk | 1,11.655 |

com.amazonaws | aws-java-sdk-cognitosync | 1,11.655 |

com.amazonaws | aws-java-sdk-config | 1,11.655 |

com.amazonaws | aws-java-sdk-core | 1,11.655 |

com.amazonaws | pipeline de dados aws-java-sdk | 1,11.655 |

com.amazonaws | aws-java-sdk-conexão direta | 1,11.655 |

com.amazonaws | diretório aws-java-sdk | 1,11.655 |

com.amazonaws | aws-java-sdk-dynamodb | 1,11.655 |

com.amazonaws | aws-java-sdk-ec2 | 1,11.655 |

com.amazonaws | aws-java-sdk-ecs | 1,11.655 |

com.amazonaws | aws-java-sdk-efs | 1,11.655 |

com.amazonaws | aws-java-sdk-elasticache | 1,11.655 |

com.amazonaws | aws-java-sdk-elasticbeanstalk | 1,11.655 |

com.amazonaws | balanceamento de carga elástico aws-java-sdk | 1,11.655 |

com.amazonaws | transcodificador elástico aws-java-sdk- | 1,11.655 |

com.amazonaws | aws-java-sdk-emr | 1,11.655 |

com.amazonaws | aws-java-sdk-glacier | 1,11.655 |

com.amazonaws | aws-java-sdk-iam | 1,11.655 |

com.amazonaws | aws-java-sdk-importação/exportação | 1,11.655 |

com.amazonaws | aws-java-sdk-kinesis | 1,11.655 |

com.amazonaws | aws-java-sdk-kms | 1,11.655 |

com.amazonaws | aws-java-sdk-lambda | 1,11.655 |

com.amazonaws | aws-java-sdk-logs | 1,11.655 |

com.amazonaws | aws-java-sdk - aprendizado de máquina | 1,11.655 |

com.amazonaws | aws-java-sdk-opsworks | 1,11.655 |

com.amazonaws | aws-java-sdk-rds | 1,11.655 |

com.amazonaws | aws-java-sdk-redshift | 1,11.655 |

com.amazonaws | aws-java-sdk-route53 | 1,11.655 |

com.amazonaws | aws-java-sdk-s3 | 1,11.655 |

com.amazonaws | aws-java-sdk-ses | 1,11.655 |

com.amazonaws | aws-java-sdk-simpledb | 1,11.655 |

com.amazonaws | aws-java-sdk - fluxo de trabalho simples | 1,11.655 |

com.amazonaws | aws-java-sdk-sns | 1,11.655 |

com.amazonaws | aws-java-sdk-sqs | 1,11.655 |

com.amazonaws | aws-java-sdk-ssm | 1,11.655 |

com.amazonaws | gateway de armazenamento aws-java-sdk | 1,11.655 |

com.amazonaws | aws-java-sdk-sts | 1,11.655 |

com.amazonaws | suporte aws-java-sdk | 1,11.655 |

com.amazonaws | aws-java-sdk-swf-biblioteca | 1.11.22 |

com.amazonaws | aws-java-sdk-workspace | 1,11.655 |

com.amazonaws | jmespath-java | 1,11.655 |

com.chuusai | sem forma_2.12 | 2.3.3 |

com.clearspring.analítica | transmissão | 2.9.6 |

com.databricks | Reservar | 1,8-3 |

com.databricks | jets3t | 0.7.1-0 |

com.databricks.scalapb | plugin_2.12 do compilador | 0,4,15-10 |

com.databricks.scalapb | scalapb-runtime_2.12 | 0,4,15-10 |

com.esotérico software | crio-sombreado | 4.0.2 |

com.esotérico software | minlog | 1.3.0 |

com.fasterxml | colega de classe | 1.3.4 |

com.fasterxml.jackson.core | jackson-anotação | 2.10.0 |

com.fasterxml.jackson.core | jackson-core | 2.10.0 |

com.fasterxml.jackson.core | vinculação de dados jackson | 2.10.0 |

formato de dados com.fasterxml.jackson. | formato de dados jackson-cbor | 2.10.0 |

com.fasterxml.jackson.tipo de dados | jackson-datatype-joda | 2.10.0 |

com.fasterxml.jackson.module | parâmetro do módulo jackson | 2.10.0 |

com.fasterxml.jackson.module | jackson-module-Scala.12 | 2.10.0 |

com.github.ben-manes.cafeína | cafeína | 2.3.4 |

com.github.fommil | descarregador | 1.1 |

com.github.fommil.netlib | abdômen | 1.1.2 |

com.github.fommil.netlib | native_ref-java | 1.1 |

com.github.fommil.netlib | native_ref-java-nativos | 1.1 |

com.github.fommil.netlib | sistema_nativo-java | 1.1 |

com.github.fommil.netlib | native_system-java-natives | 1.1 |

com.github.fommil.netlib | netlib-native_ref-linux-x86_64-natives | 1.1 |

com.github.fommil.netlib | netlib-native_system-linux-x86_64-natives | 1.1 |

com.github.joshelser | dropwizard-métricas-hadoop-metrics2-reporter | 0.1.2 |

com.github.luben | zstd-jni | 1,4.4-3 |

com.github.wendykierp | JTransforma | 3.1 |

com.google.code.findbugs | jsr305 | 3.0.0 |

com.google.code.gson | gson | 2.2.4 |

com.google.flatbuffers | tampões planos-java | 1.9.0 |

com.google.goiaba | goiaba | 15,0 |

com.google.protobuf | protobuf-java | 2.6.1 |

banco de dados com.h2 | h2 | 1,4,195 |

com.helger | perfilador | 1.1.1 |

com.jcraft | jsch | 0,1,50 |

com.jolbox | bonecp | VERSÃO 0.8.0. |

com.lihaoyi | código-fonte_2.12 | 0.1.9 |

com.microsoft.azure | azure-data lake-store-sdk | 2.2.8 |

com.microsoft.sqlserver | mssql-JDBC | 8.2.1. jre8 |

comendo | comprimir-lzf | 1.0.3 |

com.sun.mail | javax.mail | 1.5.2 |

com.trunning | JSON | 1,8 |

com.thoughtworks.paranamer | paranâmero | 2.8 |

com.trueaccord.lenses | lentes_2.12 | 0.4.12 |

com.Twitter | chill-java | 0,9.5 |

com.Twitter | chill_2.12 | 0,9.5 |

com.Twitter | util-app_2.12 | 7.1.0 |

com.Twitter | util-core_2.12 | 7.1.0 |

com.Twitter | função-útil_2.12 | 7.1.0 |

com.Twitter | util-jvm_2.12 | 7.1.0 |

com.Twitter | util-lint_2.12 | 7.1.0 |

com.Twitter | util-registry_2.12 | 7.1.0 |

com.Twitter | util-stats_2.12 | 7.1.0 |

com.typesafe | configuração | 1.2.1 |

com.typesafe.Scala-logging | Scala-logging_2.12 | 3.7.2 |

com.univocidade | analisadores de univocidade | 2.9.0 |

com.zaxxer | HikaricP | 3.1.0 |

folhas de feijão comum | folhas de feijão comum | 1.9.4 |

comum-CLI | comum-CLI | 1.2 |

codec comum | codec comum | 1,10 |

coleções comuns | coleções comuns | 3.2.2 |

configuração comum | configuração comum | 1,6 |

commons-dbcp | commons-dbcp | 1.4 |

digestor comum | digestor comum | 1,8 |

upload de arquivo commons | upload de arquivo commons | 1.3.3 |

commons-httpclient | commons-httpclient | 3.1 |

commons-io | commons-io | 2,4 |

linguagem comum | linguagem comum | 2.6 |

registro de bens comuns | registro de bens comuns | 1.1.3 |

commons-net | commons-net | 3.1 |

comum-pool | comum-pool | 1.5.4 |

info.ganglia.gmetric4j | gmetric4j | 1.0.10 |

io. airlift | compressor de ar | 0,10 |

io.dropwizard.métricas | núcleo de métricas | 4.1.1 |

io.dropwizard.métricas | métricas-grafite | 4.1.1 |

io.dropwizard.métricas | métricas-healthchecks | 4.1.1 |

io.dropwizard.métricas | métricas-jetty9 | 4.1.1 |

io.dropwizard.métricas | métricas-jmx | 4.1.1 |

io.dropwizard.métricas | métricas-JSON | 4.1.1 |

io.dropwizard.métricas | métricas-JVM | 4.1.1 |

io.dropwizard.métricas | métricas-servlets | 4.1.1 |

io.netty | tudo | 4.1.47. Final |

jakarta.anotação | jakarta.anotação-api | 1.3.5 |

jakarta.validação | jakarta.validação-api | 2.0.2 |

jakarta.ws.rs | jakarta.ws.rs-api | 2.1.6 |

javax.ativação | ativação | 1.1.1 |

javax.el | javax.el-api | 2.2.4 |

javax.jdo | jdo-api | 3.0.1 |

javax.servlet | javax.servlet-api | 3.1.0 |

javax.servlet.jsp | jsp-api | 2.1 |

javax.transaction | jta | 1.1 |

javax.transaction | API de transação | 1.1 |

javax.xml.bind | jaxb-api | 2.2.2 |

javax.xml.transmissão | stax-api | 1,0-2 |

javolução | javolução | 5.5.1 |

junte-se | junte-se | 2.14.6 |

hora do dia | hora do dia | 2.10.5 |

log4j | apache-log4j-extras | 1.2.17 |

log4j | log4j | 1.2.17 |

net.razorvine | pirolita | 4,30 |

net.sf.jpam | jpam | 1.1 |

net.sf.opencsv | opencsv | 2.3 |

net.sf.supercsv | supercsv | 2.2.0 |

net.snowflake | SDK de ingestão de flocos de neve | 0.9.6 |

net.snowflake | floco de neve-JDBC | 3.12.8 |

net.snowflake | floco de neve faísca_2.12 | 2.8.1-spark_3.0 |

net.sourceforge.f2j | arpack_combined_all | 0,1 |

org.acplt.remotetea | chá remoto - oncrpc | 1.1.2 |

org.antlr | ST4 | 4.0.4 |

org.antlr | antlr-runtime | 3.5.2 |

org.antlr | antlr4-runtime | 4.7.1 |

org.antlr | modelo de string | 3.2.1 |

org.apache.ant | formiga | 1.9.2 |

org.apache.ant | formiga | 1.9.2 |

org.apache.ant | lançador de formigas | 1.9.2 |

org.apache.arrow | formato de seta | 0.15.1 |

org.apache.arrow | memória de seta | 0.15.1 |

org.apache.arrow | vetor de seta | 0.15.1 |

org.apache.avro | AVRO | 1.8.2 |

org.apache.avro | avro-ipc | 1.8.2 |

org.apache.avro | avro-mapred-hadoop2 | 1.8.2 |

org.apache.commons | compressa comum | 1.8.1 |

org.apache.commons | criptomoeda comum | 1.0.0 |

org.apache.commons | commons-lang3 | 3.9 |

org.apache.commons | commons-math3 | 3.4.1 |

org.apache.commons | texto comum | 1,6 |

org.apache.curator | curador-cliente | 2.7.1 |

org.apache.curator | estrutura de curador | 2.7.1 |

org.apache.curator | receitas de curadores | 2.7.1 |

org.apache.derby | derby | 10.12.1.1 |

org.apache.directory.api | api-asn1-api | 1,0,0-M20 |

org.apache.directory.api | utilitário de API | 1,0,0-M20 |

org.apache.directory.server | apacheds-i18n | 2,0,0-M15 |

org.apache.directory.server | codec apacheds-kerberos | 2,0,0-M15 |

org.apache.hadoop | hadoop-anotação | 2.7.4 |

org.apache.hadoop | autenticação hadoop | 2.7.4 |

org.apache.hadoop | cliente hadoop | 2.7.4 |

org.apache.hadoop | hadoop-comum | 2.7.4 |

org.apache.hadoop | hadoop-HDFS | 2.7.4 |

org.apache.hadoop | aplicativo cliente hadoop mapreduce | 2.7.4 |

org.apache.hadoop | hadoop-mapreduce-client-common | 2.7.4 |

org.apache.hadoop | núcleo do cliente hadoop-mapreduce | 2.7.4 |

org.apache.hadoop | hadoop-mapreduce-client-jobclient | 2.7.4 |

org.apache.hadoop | hadoop-mapreduce-client-shuffle | 2.7.4 |

org.apache.hadoop | API hadoop yarn | 2.7.4 |

org.apache.hadoop | cliente hadoop-yarn | 2.7.4 |

org.apache.hadoop | hadoop-yarn-common | 2.7.4 |

org.apache.hadoop | servidor hadoop-yarn-comum | 2.7.4 |

org.apache.hive | hive-beeline | 2.3.7 |

org.apache.hive | colmeia-CLI | 2.3.7 |

org.apache.hive | colmeia comum | 2.3.7 |

org.apache.hive | núcleo hive-exec-core | 2.3.7 |

org.apache.hive | hive-JDBC | 2.3.7 |

org.apache.hive | hive-llap-client | 2.3.7 |

org.apache.hive | hive-lap-common | 2.3.7 |

org.apache.hive | Hive metastore | 2.3.7 |

org.apache.hive | colmeia | 2.3.7 |

org.apache.hive | hive-shims | 2.3.7 |

org.apache.hive | API de armazenamento em nuvem | 2.7.1 |

org.apache.hive | geração de código vetorial hive | 2.3.7 |

org.apache.hive.shims | calços de colmeia - 0,23 | 2.3.7 |

org.apache.hive.shims | calços de colmeia comuns | 2.3.7 |

org.apache.hive.shims | hive-shims-programador | 2.3.7 |

org.apache.htrace | htrace-core | 3.1.0 - incubação |

org.apache.httpcomponents | cliente http | 4.5.6 |

org.apache.httpcomponents | httpcore | 4.4.12 |

org.apache.ivy | hera | 2.4.0 |

org.apache.orc | núcleo orc | 1.5.10 |

org.apache.orc | orc-mapreduce | 1.5.10 |

org.apache.orc | calços de orc | 1.5.10 |

org.apache.parquet | coluna de parquete | 1.10.1 - blocos de dados 6 |

org.apache.parquet | parquete comum | 1.10.1 - blocos de dados 6 |

org.apache.parquet | codificação de parquet | 1.10.1 - blocos de dados 6 |

org.apache.parquet | formato de parquet | 2.4.0 |

org.apache.parquet | parquet-hadoop | 1.10.1 - blocos de dados 6 |

org.apache.parquet | parquet-jackson | 1.10.1 - blocos de dados 6 |

org.apache.thrift | libfb303 | 0.9.3 |

org.apache.thrift | libthrift | 0.12.0 |

org.apache.velocity | velocidade | 1.5 |

org.apache.xbean | xbean-asm7-shaded | 4,15 |

org.apache.yetus | audiência-anotação | 0.5.0 |

org.apache.zookeeper | tratador | 3.4.14 |

org.codehaus.jackson | jackson-core-asl | 1.9.13 |

org.codehaus.jackson | jackson-jaxers | 1.9.13 |

org.codehaus.jackson | jackson-mapper-asl | 1.9.13 |

org.codehaus.jackson | jackson-xc | 1.9.13 |

org.codehaus.janino | compilador common | 3.0.16 |

org.codehaus.janino | janino | 3.0.16 |

org.datanucleus | núcleo de dados-api-jdo | 4.2.4 |

org.datanucleus | núcleo de dados | 4.1.17 |

org.datanucleus | núcleo de dados-rdbms | 4.1.19 |

org.datanucleus | javax.jdo | 3,2,0-m3 |

org.Eclipse.jetty | jetty-client | 9.4.18.v20190429 |

org.Eclipse.jetty | continuação do cais | 9.4.18.v20190429 |

org.Eclipse.jetty | jetty-http | 9.4.18.v20190429 |

org.Eclipse.jetty | jetty-io | 9.4.18.v20190429 |

org.Eclipse.jetty | jetty-jndi | 9.4.18.v20190429 |

org.Eclipse.jetty | jetty-plus | 9.4.18.v20190429 |

org.Eclipse.jetty | jetty-proxy | 9.4.18.v20190429 |

org.Eclipse.jetty | segurança do cais | 9.4.18.v20190429 |

org.Eclipse.jetty | servidor jetty-server | 9.4.18.v20190429 |

org.Eclipse.jetty | jutty-servlet | 9.4.18.v20190429 |

org.Eclipse.jetty | píer de servlets | 9.4.18.v20190429 |

org.Eclipse.jetty | jetty-util | 9.4.18.v20190429 |

org.Eclipse.jetty | aplicativo web jetty- | 9.4.18.v20190429 |

org.Eclipse.jetty | jetty-xml | 9.4.18.v20190429 |

org.fusesource.leveldbjni | leveldbjni-tudo | 1,8 |

org.glassfish.hk2 | API hk2 | 2.6.1 |

org.glassfish.hk2 | localizador hk2 | 2.6.1 |

org.glassfish.hk2 | hk2-utils | 2.6.1 |

org.glassfish.hk2 | osgi-recurso-locator | 1.0.3 |

org.glassfish.hk2.external | aopalliance - reembalado | 2.6.1 |

org.glassfish.hk2.external | jakarta.inject | 2.6.1 |

org.glassfish.jersey.containers | servlet de contêiner de camisa | 2,30 |

org.glassfish.jersey.containers | jersey-container-servlet-core | 2,30 |

org.glassfish.jersey.core | cliente de camisa | 2,30 |

org.glassfish.jersey.core | camiseta comum | 2,30 |

org.glassfish.jersey.core | servidor de camisa | 2,30 |

org.glassfish.jersey.inject | camiseta-hk2 | 2,30 |

org.glassfish.jersey.media | jersey-media-jaxb | 2,30 |

org.hibernate.validator | validador de hibernação | 6.1.0. Final |

org.javassist | javassist | 3,25,0 GA |

org.jboss.logging | registro de jboss-logging | 3.3.2. Final |

org.jdbi | jdbi | 2.63,1 |

org.joda | conversor de joda | 1.7 |

org.jodd | núcleo nodular | 3.5.2 |

org.json4s | json4s-ast_2.12 | 3.6.6 |

org.json4s | json4s-core_2.12 | 3.6.6 |

org.json4s | json4s-jackson_2.12 | 3.6.6 |

org.json4s | json4s-scalap_2.12 | 3.6.6 |

org.lz4 | lz4-java | 1.7.1 |

org.mariadb.JDBC | cliente mariadb-java | 2.1.2 |

org.objenesis | objênese | 2.5.1 |

org.postgresql | PostgreSQL | 42,14 |

org.roaringbitmap | Mapa de bits estrondoso | 0,7,45 |

org.roaringbitmap | calços | 0,7,45 |

org.rocksdb | rocksdbjni | 6.2.2 |

org.rosuda.rEngine | Motor | 2.1.0 |

org.Scala-lang | Scala-compiler_2.12 | 2.12.10 |

org.Scala-lang | Scala-biblioteca.12 | 2.12.10 |

org.Scala-lang | Scala-reflect_2.12 | 2.12.10 |

org.Scala-lang.modules | Scala-collection-compat_2.12 | 2.1.1 |

org.Scala-lang.modules | Scala-parser-combinators_2.12 | 1.1.2 |

org.Scala-lang.modules | Scala-xml_2.12 | 1.2.0 |

org.Scala-sbt | interface de teste | 1,0 |

org.scalacheck | scalacheck_2.12 | 1.14.2 |

org.scalactic | scalactic_2.12 | 3.0.8 |

org.scalanlp | breeze-macros_2.12 | 1,0 |

org.scalanlp | breeze_2.12 | 1,0 |

org.scalatest | scalatest_2.12 | 3.0.8 |

org.slf4j | jcl-over-slf4j | 1,7.30 |

org.slf4j | jul-a-slf4j | 1,7.30 |

org.slf4j | slf4j-api | 1,7.30 |

org.slf4j | slf4j-log4j12 | 1,7.30 |

org.spark-project.spark | não utilizado | 1.0.0 |

org.springframework | núcleo de mola | 4.1.4. LANÇAMENTO |

org.springframework | teste de primavera | 4.1.4. LANÇAMENTO |

org.threeten | treze e mais | 1.5.0 |

org.tukaani | xz | 1.5 |

org.typelevel | álgebra_2.12 | 2,0,0-M2 |

org.typelevel | cats-kernel_2.12 | 2,0,0-M4 |

org.typelevel | maquinista_2.12 | 0.6.8 |

org.typelevel | macro-compat_2,12 | 1.1.1 |

org.typelevel | spire-macros_2.12 | 0,17.0-M1 |

org.typelevel | spire-platform_2.12 | 0,17.0-M1 |

org.typelevel | spire-util_2.12 | 0,17.0-M1 |

org.typelevel | spire_2.12 | 0,17.0-M1 |

org.xerial | sqlite-JDBC | 3.8.11.2 |

org.xerial.snappy | snappy-java | 1.1.7.5 |

org.yaml | snakeyaml | 1,24 |

oro | oro | 2.0.8 |

pt.edu.icm | Matrizes JLarge | 1.5 |

software.Amazon.ion | ion-java | 1.0.2 |

stax | stax-api | 1.0.1 |

xmlenc | xmlenc | 0,52 |