始めましょう: コードなしで LLM をクエリし、AI エージェントのプロトタイプを作成する

この 5 分間のノーコード チュートリアルでは、 Databricksにおける生成AIを紹介します。この AI Playground を使用して、次の操作を行います。

- 大規模言語モデル (LLM) のクエリを実行し、結果を並べて比較する

- ツールを呼び出すAIエージェントのプロトタイプ作成

- エージェントをコードにエクスポートする

- オプション: RAG(Retrieval-augmented generation)を使用した質問応答チャットボットのプロトタイプ作成

始める前に

ワークスペースが以下にアクセスできることを確認します。

-

エージェント フレームワーク。地域限定で利用できる機能を参照してください。

ステップ 1: AI Playground を使用して LLM をクエリする

AI Playground を使用して、チャット インターフェースで LLM にクエリを実行します。

- ワークスペースで、 Playground を選択します。

- 「RAG とは何ですか?」などの質問を入力します。

新しい LLM を追加して、応答を並べて比較します。

- 右上の + を選択して、比較用のモデルを追加します。

- 新しいペインで、ドロップダウンセレクターを使用して別のモデルを選択します。

- [ 同期 ] チェックボックスをオンにして、クエリを同期します。

- 「複合 AI システムとは何ですか?」などの新しいプロンプトを試して、2 つの応答を並べて表示します。

さまざまな LLM をテストして比較し続けることで、AI エージェントの構築に最適な LLM を決定できます。

ステップ 2: ツールを呼び出す AI エージェントのプロトタイプを作成する

ツールを使用すると、LLMは言語を生成する以上のことを行うことができます。ツールでは、外部データのクエリ、コードの実行、その他のアクションを実行できます。AI Playground には、ツールコール エージェントのプロトタイプを作成するためのノーコード オプションが用意されています。

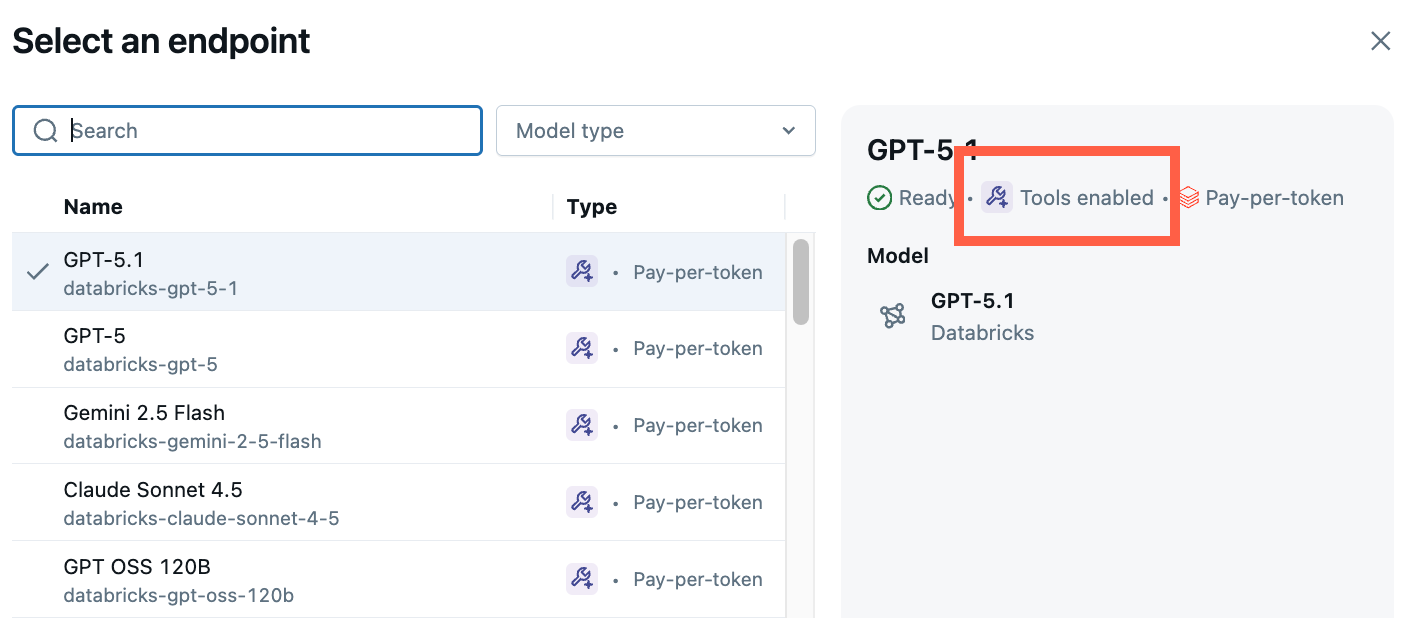

-

Playground から、[ Tools enabled ] というラベルの付いたモデルを選択します。

-

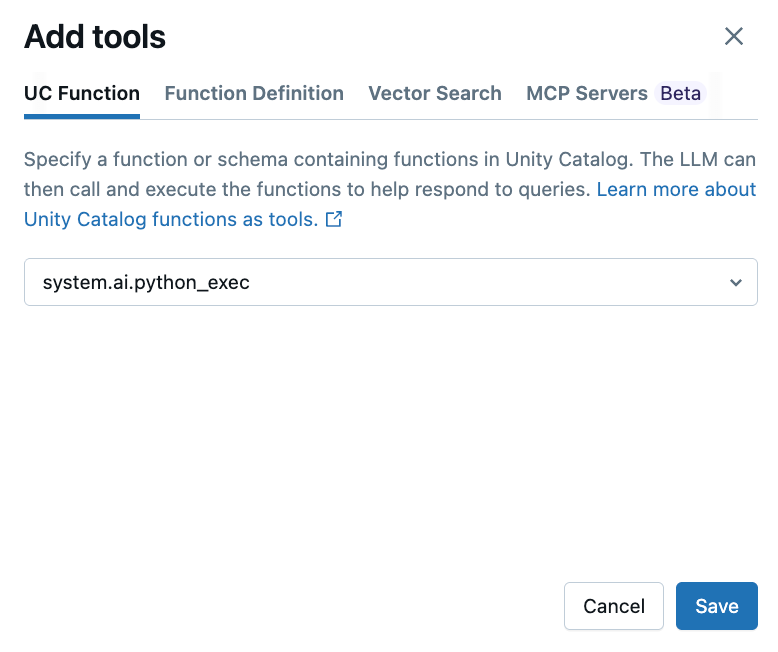

ツール > + ツールの追加 を選択し、組み込みの Unity Catalog 関数 [

system.ai.python_exec] を選択します。この関数を使用すると、エージェントは任意のPythonコードを実行できます。

その他のツール オプションは次のとおりです。

- UC 機能 : エージェントが使用するUnity Catalog機能を選択します。

- 関数定義 : エージェントが呼び出すカスタム関数を定義します。

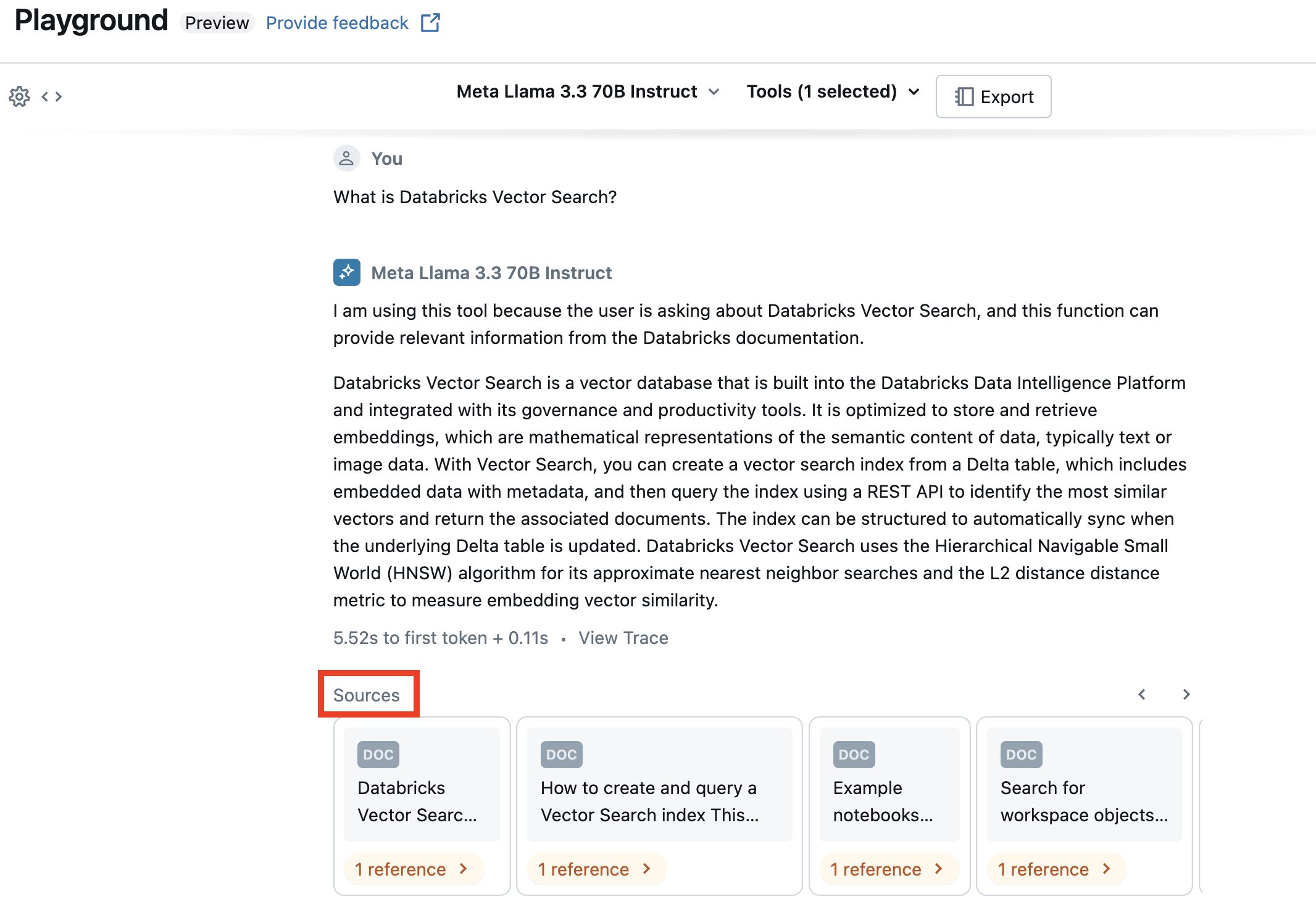

- ベクトル検索 :ベクトル検索インデックスを指定します。 エージェントがベクトル検索インデックスを使用している場合、その応答には使用されたソースが引用されます。

- MCP : 管理された Databricks MCP サーバーまたは外部 MCP サーバーを使用するようにMCP サーバーを指定します。

-

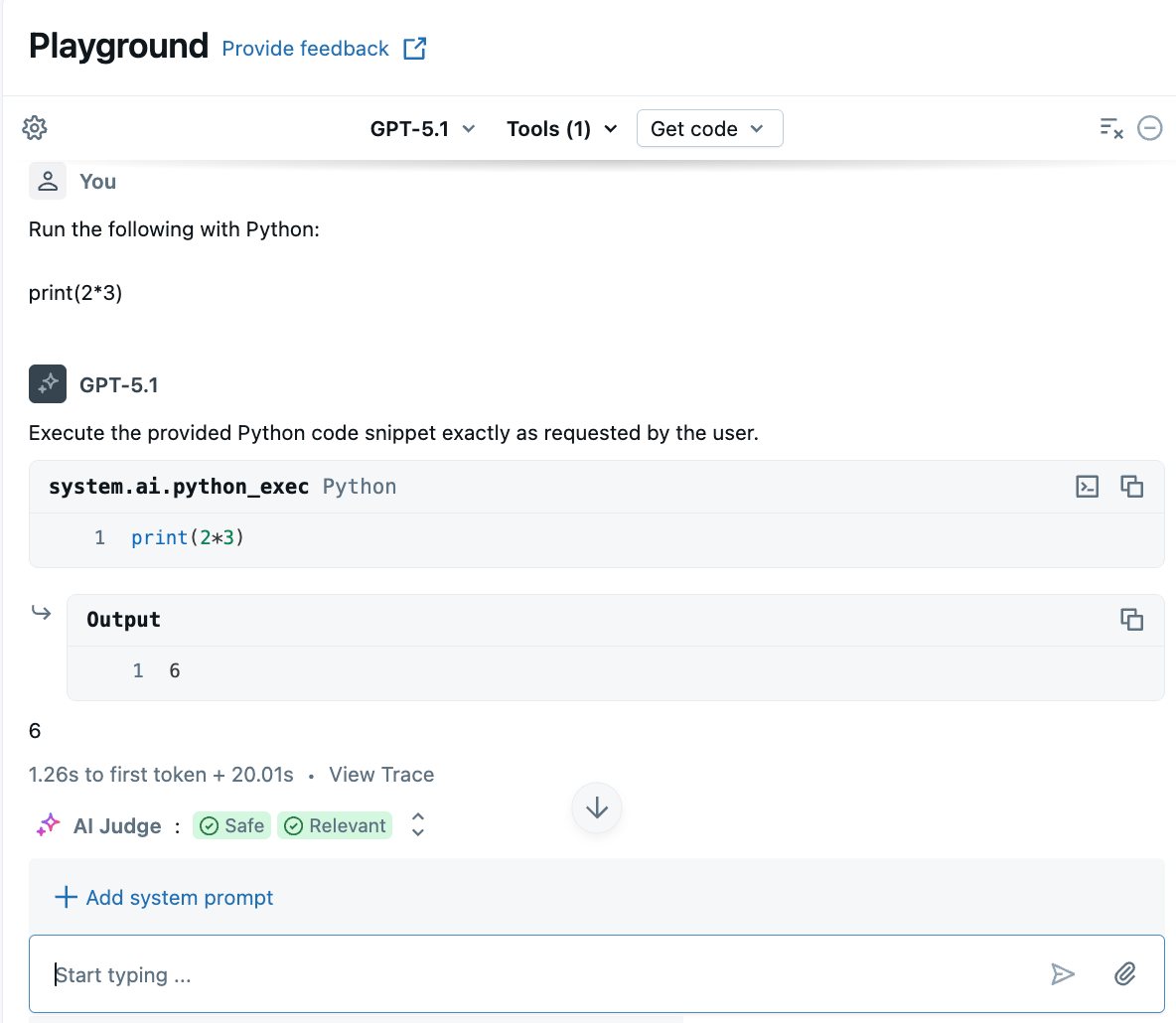

Python コードの生成または実行に関連する質問をします。プロンプトの言い回しにさまざまなバリエーションを試すことができます。複数のツールを追加すると、LLM は適切なツールを選択して応答を生成します。

ステップ 3: エージェントをコードにエクスポートする

AI Playground でエージェントをテストした後、 「コードの取得」 > 「エージェント ノートブックの作成」 をクリックして、エージェントを Python ノートブックにエクスポートします。

Python ノートブックには、エージェントを定義し、それをモデルサービング エンドポイントにデプロイするコードが含まれています。

エクスポートされたノートブックは現在、エージェントをモデルサービングにデプロイするレガシー エージェント オーサリング ワークフローを使用しています。 Databricks 、代わりにDatabricks Appsを使用してエージェントを作成することを推奨しています。 「 AIエージェントを作成してDatabricks Appsにデプロイする」を参照してください。

オプション: RAGの質問応答ボットのプロトタイプ作成

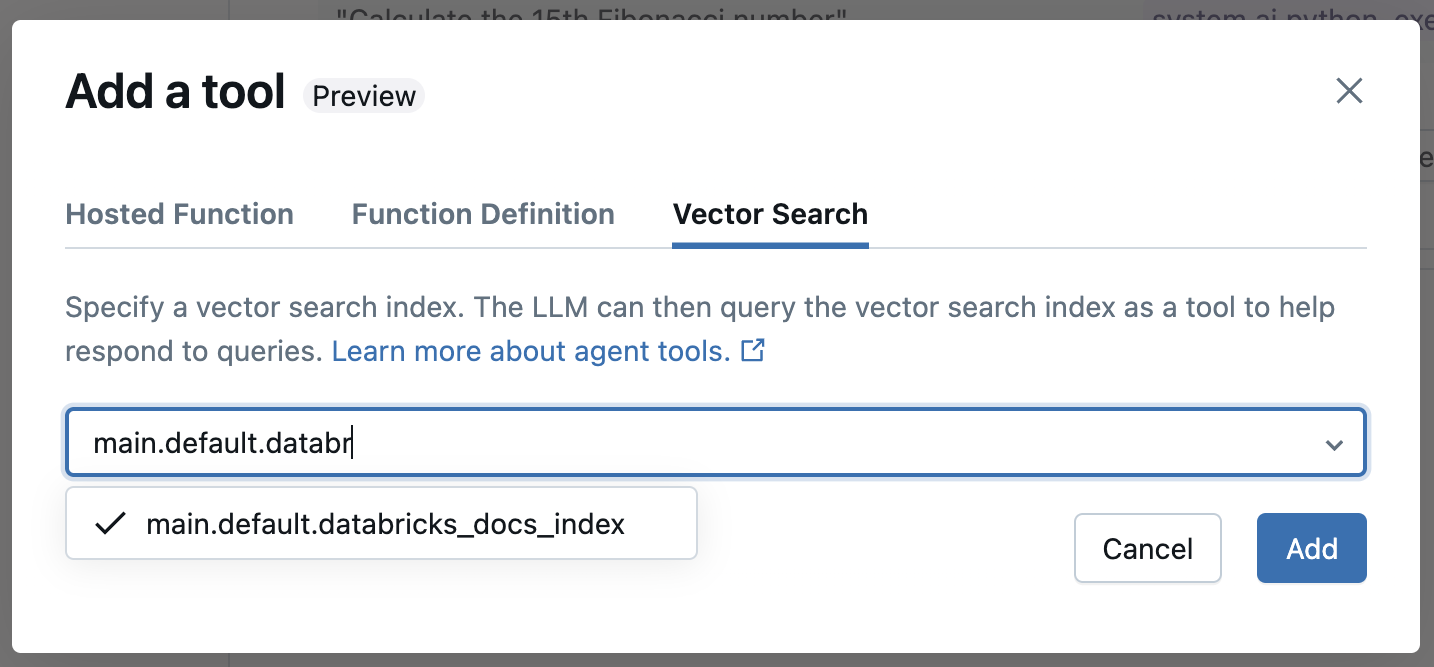

ワークスペースにベクトル検索インデックスが設定されている場合は、質問応答ボットのプロトタイプを作成できます。このタイプのエージェントは、ベクトル検索インデックス内のドキュメントを使用して、それらのドキュメントに基づく質問に答えます。

-

ツール > + ツールの追加 をクリックします。次に、ベクトル検索インデックスを選択します。

-

あなたのドキュメントに関連する質問をしてください。エージェントは、ベクトルインデックスを使用して関連情報を検索でき、回答に使用されたドキュメントを引用します。

地下鉄検索インデックスを設定するには、 「地下鉄検索インデックスを作成する」を参照してください。

AI Playgroundエージェントのエクスポートとデプロイ

AI PlaygroundでAIエージェントのプロトタイプを作成した後、それをPythonノートブックにエクスポートして、モデルサービング エンドポイントにデプロイします。

-

[コードの取得] > [エージェント ノートブックの作成] をクリックして、AI エージェントを定義およびデプロイするノートブックを生成します。

エージェント コードをエクスポートすると、ドライバー ノートブックを含むフォルダーがワークスペースに保存されます。このドライバーは、ツール呼び出しResponsesAgent を定義し、エージェントをローカルでテストし、コードベースのログ記録を使用し、登録し、 Mosaic AI Agent Framework を使用してAIエージェントをデプロイします。

-

ノートブック内のすべての TODO に対処します。

エクスポートされたコードは、AI Playground セッションとは異なる動作をする可能性があります。Databricks では、エクスポートされたノートブックを実行して反復処理とデバッグをさらに行い、エージェントの品質を評価してから、エージェントをデプロイして他のユーザーと共有することをお勧めします。

次のステップ

コードファースト アプローチを使用してエージェントを作成するには、 「 AIエージェントを作成してDatabricks Appsにデプロイする」を参照してください。