gerenciar conectores em LakeFlow Connect

Os conectores gerenciar em LakeFlow Connect estão em vários estados de liberação.

Esta página fornece uma visão geral dos conectores de gerenciamento no Databricks LakeFlow Connect para ingestão de dados de aplicativos SaaS e bancos de dados. O pipeline de ingestão resultante é gerenciado pelo Unity Catalog e utiliza compute serverless e o pipeline declarativo LakeFlow Spark . Os conectores de gerenciamento aproveitam leituras e gravações incrementais eficientes para tornar a ingestão de dados mais rápida, escalável e econômica, enquanto seus dados permanecem atualizados para consumo posterior.

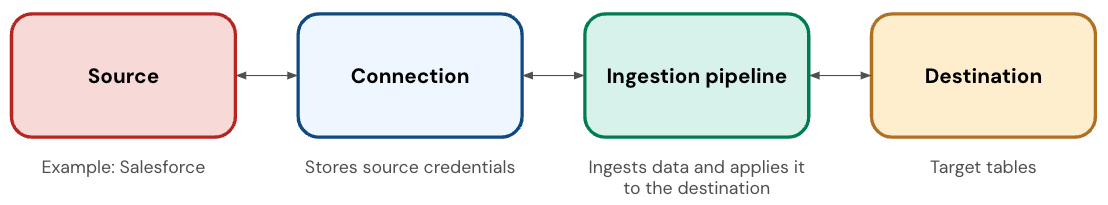

Componentes do conector SaaS

Um conector SaaS tem os seguintes componentes:

Componente | Descrição |

|---|---|

Conexão | Um objeto securizável do Unity Catalog que armazena detalhes de autenticação para o aplicativo. |

Ingestão pipeline | Um pipeline que copia os dados do aplicativo para as tabelas de destino. A ingestão pipeline execução em serverless compute. |

Tabelas de destino | As tabelas nas quais o pipeline de ingestão grava os dados. Essas são tabelas de transmissão, que são Delta tabelas com suporte extra para processamento incremental de dados. |

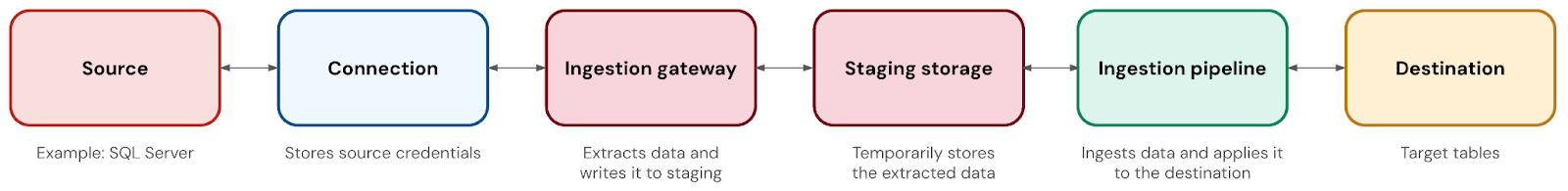

Componentes do conector de banco

Um conector de banco de dados tem os seguintes componentes:

Componente | Descrição |

|---|---|

Conexão | Um objeto seguro do Unity Catalog que armazena detalhes de autenticação para o banco de dados. |

Gateway de ingestão | Um pipeline que extrai Snapshot, altera logs e metadados do banco de dados de origem. O gateway é executado no site clássico compute e é executado continuamente para capturar alterações antes que a alteração logs possa ser truncada na fonte. |

Armazenamento temporário | Um volume Unity Catalog que armazena temporariamente a extração de dados antes de ser aplicada à tabela de destino. Isso permite que o senhor execute sua ingestão pipeline em qualquer programação que desejar, mesmo que o gateway capture continuamente as alterações. Também ajuda na recuperação de falhas. O volume de armazenamento de teste é criado automaticamente quando o gateway é implantado, e o senhor pode personalizar o catálogo e o esquema onde ele reside. Os dados são automaticamente eliminados do teste após 30 dias. |

Ingestão pipeline | Um pipeline que move os dados do armazenamento de preparação para as tabelas de destino. A pipeline execução em serverless compute. |

Tabelas de destino | As tabelas nas quais o pipeline de ingestão grava os dados. Essas são tabelas de transmissão, que são Delta tabelas com suporte extra para processamento incremental de dados. |

orquestração

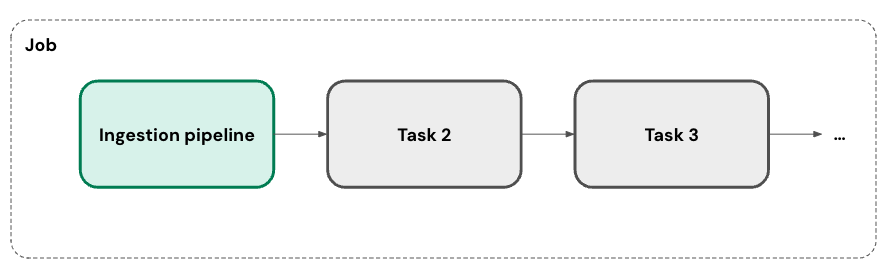

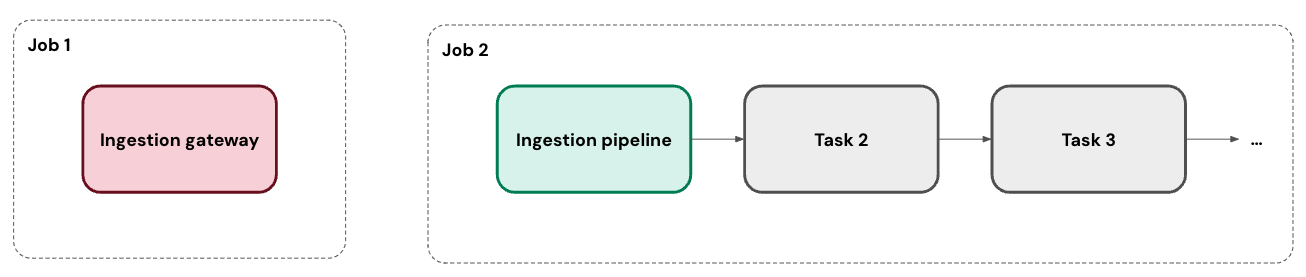

O senhor pode executar sua ingestão pipeline em um ou mais programas personalizados. Para cada programa que o senhor adicionar a um pipeline, o LakeFlow Connect cria automaticamente um Job para ele. A ingestão pipeline é uma tarefa dentro do trabalho. Opcionalmente, o senhor pode adicionar mais tarefas ao trabalho.

Para conectores de banco de dados, o gateway de ingestão é executado em seu próprio Job como uma tarefa contínua.

Ingestão incremental

LakeFlow Connect usa a ingestão incremental para melhorar a eficiência do pipeline. Na primeira execução de seu pipeline, ele ingere todos os dados selecionados da fonte. Paralelamente, ele rastreia as alterações nos dados de origem. Em cada execução subsequente do pipeline, ele usa esse acompanhamento de alterações para ingerir apenas os dados que foram alterados em relação à execução anterior, quando possível.

A abordagem exata depende do que está disponível em sua fonte de dados. Por exemplo, o senhor pode usar tanto o acompanhamento de alterações quanto a captura de dados de alterações (CDC) (CDC) com SQL Server. Por outro lado, o conector Salesforce seleciona uma coluna de cursor em uma lista de opções.

Algumas fontes ou tabelas específicas não oferecem suporte à ingestão incremental no momento. A Databricks planeja expandir a cobertura para suporte incremental.

Trabalho em rede

Há várias opções para se conectar a um aplicativo ou banco de dados SaaS.

- Os conectores para aplicativos SaaS acessam as APIs da fonte. Eles também são automaticamente compatíveis com os controles de saída do site serverless.

- Os conectores para bancos de dados em nuvem podem se conectar à fonte por meio do link privado. Como alternativa, se o seu workspace tiver uma Virtual Network (VNet) ou Virtual Private Cloud (VPC) que esteja emparelhada com a VNet ou VPC que hospeda seu banco de dados, o senhor poderá implantar o gateway de ingestão dentro dela.

- Os conectores para bancos de dados locais podem se conectar usando serviços como AWS Direct Connect e Azure ExpressRoute.

Implantação

O senhor pode implantar o pipeline de ingestão usando Databricks ativo Bundles, que permite práticas recomendadas como controle de origem, revisão de código, testes e integração e entrega contínuas (CI/CD). Os pacotes são gerenciados usando o Databricks CLI e podem ser executados em diferentes espaços de trabalho de destino, como desenvolvimento, preparação e produção.

Recuperação de falhas

Como um serviço totalmente gerenciado, o LakeFlow Connect visa à recuperação automática de problemas sempre que possível. Por exemplo, quando um conector falha, ele tenta novamente automaticamente com recuo exponencial.

No entanto, é possível que um erro exija sua intervenção (por exemplo, quando as credenciais expiram). Nesses casos, o conector tenta evitar a perda de dados armazenando a última posição do cursor. Ele pode, então, retomar a partir dessa posição na próxima execução do pipeline, quando possível.

monitoramento

LakeFlow Connect oferece alertas e monitoramento robustos para ajudar você a manter seu oleoduto em boas condições. Isso inclui logs de eventos, logs cluster , métricas de integridade pipeline e métricas de qualidade de dados. Você também pode usar a tabela system.billing.usage para rastrear custos e monitorar o uso do pipeline. Consulte Monitorar custo pipeline de ingestão.

Status de lançamento

Conector | Status da versão |

|---|---|

Confluência | Beta |

Google Analytics | Disponível ao público em geral |

Google Ads | Beta |

MySQL | Pré-visualização pública |

NetSuite | Pré-visualização pública |

PostgreSQL | Pré-visualização pública |

Salesforce | Disponível ao público em geral |

ServiceNow | Disponível ao público em geral |

SharePoint | Beta |

SQL Server | Disponível ao público em geral |

Workday | Disponível ao público em geral |

Disponibilidade do recurso

As tabelas a seguir resumem a disponibilidade de recursos para cada conector de ingestão de gerenciamento. Para obter informações adicionais sobre recursos e limitações, consulte a documentação do seu conector específico.

- Confluence

- Google Analytics

- Google Ads

- MySQL

- NetSuite

- Salesforce

- Workday

- SQL Server

- PostgreSQL

- ServiceNow

- SharePoint

Recurso | Disponibilidade |

|---|---|

Criação de pipeline com base na interface do usuário |

|

Criação de pipeline baseada em API |

|

Databricks Asset Bundles |

|

Ingestão incremental |

|

Unity Catalog governança |

|

orquestração usando Databricks Workflows |

|

SCD tipo 2 |

|

Seleção e desseleção de colunas com base em API |

|

Filtragem de linhas baseada em API |

|

Evolução automatizada do esquema: Colunas novas e excluídas |

|

Evolução automatizada do esquema: Alterações no tipo de dados |

|

Evolução automatizada do esquema: Renomeação de colunas |

Tratada como uma nova coluna (novo nome) e coluna excluída (nome antigo). |

Evolução automatizada do esquema: Novas tabelas |

Se você ingerir todo o esquema. Veja as limitações do número de tabelas por pipeline. |

Número máximo de tabelas por pipeline | 250 |

Recurso | Disponibilidade |

|---|---|

Criação de pipeline com base na interface do usuário |

|

Criação de pipeline baseada em API |

|

Databricks Asset Bundles |

|

Ingestão incremental |

|

Unity Catalog governança |

|

orquestração usando Databricks Workflows |

|

SCD tipo 2 |

|

Seleção e desseleção de colunas com base em API |

|

Filtragem de linhas baseada em API |

|

Evolução automatizada do esquema: Colunas novas e excluídas |

|

Evolução automatizada do esquema: Alterações no tipo de dados |

|

Evolução automatizada do esquema: Renomeação de colunas |

Tratada como uma nova coluna (novo nome) e coluna excluída (nome antigo). |

Evolução automatizada do esquema: Novas tabelas |

Se você ingerir todo o esquema. Veja as limitações do número de tabelas por pipeline. |

Número máximo de tabelas por pipeline | 250 |

Recurso | Disponibilidade |

|---|---|

Criação de pipeline com base na interface do usuário |

|

Criação de pipeline baseada em API |

|

Databricks Asset Bundles |

|

Ingestão incremental |

As tabelas de relatório suportam ingestão incremental. As tabelas de recursos são totalmente atualizadas a cada atualização. |

Unity Catalog governança |

|

Jobs do Lakeflow |

|

SCD tipo 2 |

|

Seleção e deseleção de colunas |

Você pode selecionar tabelas específicas. |

Filtragem de linhas baseada em API |

|

Evolução automatizada do esquema: Colunas novas e excluídas |

|

Evolução automatizada do esquema: Alterações no tipo de dados |

|

Evolução automatizada do esquema: Renomeação de colunas |

|

Evolução automatizada do esquema: Novas tabelas | N/A |

Número máximo de tabelas por pipeline | 250 |

Recurso | Disponibilidade |

|---|---|

Criação de pipeline com base na interface do usuário |

|

Criação de pipeline baseada em API |

|

Databricks Asset Bundles |

|

Ingestão incremental |

|

Unity Catalog governança |

|

orquestração usando Databricks Workflows |

|

SCD tipo 2 |

|

Seleção e desseleção de colunas com base em API |

|

Filtragem de linhas baseada em API |

|

Evolução automatizada do esquema: Colunas novas e excluídas |

|

Evolução automatizada do esquema: Alterações no tipo de dados |

|

Evolução automatizada do esquema: Renomeação de colunas |

Tratada como uma nova coluna (novo nome) e coluna excluída (nome antigo). |

Evolução automatizada do esquema: Novas tabelas |

Se você ingerir todo o esquema. Veja as limitações do número de tabelas por pipeline. |

Número máximo de tabelas por pipeline | 250 |

Recurso | Disponibilidade |

|---|---|

Criação de pipeline com base na interface do usuário |

|

Criação de pipeline baseada em API |

|

Databricks Asset Bundles |

|

Ingestão incremental |

|

Unity Catalog governança |

|

orquestração usando Databricks Workflows |

|

SCD tipo 2 |

|

Seleção e desseleção de colunas com base em API |

|

Filtragem de linhas baseada em API |

|

Evolução automatizada do esquema: Colunas novas e excluídas |

|

Evolução automatizada do esquema: Alterações no tipo de dados |

|

Evolução automatizada do esquema: Renomeação de colunas |

Tratada como uma nova coluna (novo nome) e coluna excluída (nome antigo). |

Evolução automatizada do esquema: Novas tabelas |

Se você ingerir todo o esquema. Veja as limitações do número de tabelas por pipeline. |

Número máximo de tabelas por pipeline | 200 |

Recurso | Disponibilidade |

|---|---|

Criação de pipeline com base na interface do usuário |

|

Criação de pipeline baseada em API |

|

Databricks Asset Bundles |

|

Ingestão incremental |

Por default, os campos de fórmula exigem um Snapshot completo. Para habilitar a ingestão incremental de campos de fórmula, consulte Ingerir campos de fórmula do Salesforce incrementalmente. |

Unity Catalog governança |

|

orquestração usando Databricks Workflows |

|

SCD tipo 2 |

|

Seleção e desseleção de colunas com base em API |

|

Filtragem de linhas baseada em API |

|

Evolução automatizada do esquema: Colunas novas e excluídas |

|

Evolução automatizada do esquema: Alterações no tipo de dados |

|

Evolução automatizada do esquema: Renomeação de colunas |

Tratada como uma nova coluna (novo nome) e coluna excluída (nome antigo). |

Evolução automatizada do esquema: Novas tabelas | N/A |

Número máximo de tabelas por pipeline | 250 |

Recurso | Disponibilidade |

|---|---|

Criação de pipeline com base na interface do usuário |

|

Criação de pipeline baseada em API |

|

Databricks Asset Bundles |

|

Ingestão incremental |

|

Unity Catalog governança |

|

orquestração usando Databricks Workflows |

|

SCD tipo 2 |

|

Seleção e desseleção de colunas com base em API |

|

Filtragem de linhas baseada em API |

|

Evolução automatizada do esquema: Colunas novas e excluídas |

|

Evolução automatizada do esquema: Alterações no tipo de dados |

|

Evolução automatizada do esquema: Renomeação de colunas |

Tratada como uma nova coluna (novo nome) e coluna excluída (nome antigo). |

Evolução automatizada do esquema: Novas tabelas | N/A |

Número máximo de tabelas por pipeline | 250 |

Recurso | Disponibilidade |

|---|---|

Criação de pipeline com base na interface do usuário |

|

Criação de pipeline baseada em API |

|

Databricks Asset Bundles |

|

Ingestão incremental |

|

Unity Catalog governança |

|

orquestração usando Databricks Workflows |

|

SCD tipo 2 |

|

Seleção e desseleção de colunas com base em API |

|

Filtragem de linhas baseada em API |

|

Evolução automatizada do esquema: Colunas novas e excluídas |

|

Evolução automatizada do esquema: Alterações no tipo de dados |

|

Evolução automatizada do esquema: Renomeação de colunas |

Quando os objetos DDL estão habilitados, o conector pode renomear a coluna. Quando os objetos DDL não estão habilitados, o conector trata isso como uma nova coluna (novo nome) e uma coluna excluída (nome antigo). Em ambos os casos, é necessário um refresh completo. |

Evolução automatizada do esquema: Novas tabelas |

Se você ingerir todo o esquema. Veja as limitações do número de tabelas por pipeline. |

Número máximo de tabelas por pipeline | 250 |

Recurso | Disponibilidade |

|---|---|

Criação de pipeline com base na interface do usuário |

|

Criação de pipeline baseada em API |

|

Databricks Asset Bundles |

|

Ingestão incremental |

|

Unity Catalog governança |

|

orquestração usando Databricks Workflows |

|

SCD tipo 2 |

|

Seleção e desseleção de colunas com base em API |

|

Filtragem de linhas baseada em API |

|

Evolução automatizada do esquema: Colunas novas e excluídas |

|

Evolução automatizada do esquema: Alterações no tipo de dados |

|

Evolução automatizada do esquema: Renomeação de colunas |

Requer uma refresh completa. |

Evolução automatizada do esquema: Novas tabelas |

Se você ingerir todo o esquema. Veja as limitações do número de tabelas por pipeline. |

Número máximo de tabelas por pipeline | 250 |

Recurso | Disponibilidade |

|---|---|

Criação de pipeline com base na interface do usuário |

|

Criação de pipeline baseada em API |

|

Databricks Asset Bundles |

|

Ingestão incremental |

Com exceções quando sua tabela não tem um campo de cursor |

Unity Catalog governança |

|

orquestração usando Databricks Workflows |

|

SCD tipo 2 |

|

Seleção e desseleção de colunas com base em API |

|

Filtragem de linhas baseada em API |

|

Evolução automatizada do esquema: Colunas novas e excluídas |

|

Evolução automatizada do esquema: Alterações no tipo de dados |

|

Evolução automatizada do esquema: Renomeação de colunas |

Tratada como uma nova coluna (novo nome) e coluna excluída (nome antigo). |

Evolução automatizada do esquema: Novas tabelas |

Se você ingerir todo o esquema. Veja as limitações do número de tabelas por pipeline. |

Número máximo de tabelas por pipeline | 250 |

Recurso | Disponibilidade |

|---|---|

Criação de pipeline com base na interface do usuário |

|

Criação de pipeline baseada em API |

|

Databricks Asset Bundles |

|

Ingestão incremental |

|

Unity Catalog governança |

|

orquestração usando Databricks Workflows |

|

SCD tipo 2 |

|

Seleção e desseleção de colunas com base em API |

|

Filtragem de linhas baseada em API |

|

Evolução automatizada do esquema: Colunas novas e excluídas |

|

Evolução automatizada do esquema: Alterações no tipo de dados |

|

Evolução automatizada do esquema: Renomeação de colunas |

Tratada como uma nova coluna (novo nome) e coluna excluída (nome antigo). |

Evolução automatizada do esquema: Novas tabelas |

Se você ingerir todo o esquema. Veja as limitações do número de tabelas por pipeline. |

Número máximo de tabelas por pipeline | 250 |

Métodos de autenticação

A tabela a seguir lista os métodos de autenticação suportados para cada conector de ingestão de manutenção. A Databricks recomenda o uso de OAuth U2M ou OAuth M2M sempre que possível. Se o seu conector suporta OAuth, a autenticação básica é considerada um método legado.

- Google Analytics

- Google Ads

- MySQL

- NetSuite

- Salesforce

- ServiceNow

- SharePoint

- SQL Server

- Workday

- Dynamics 365

Método de autenticação | Disponibilidade |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (manual refresh tokens) |

|

Autenticação básica (nome de usuário/senha) |

|

Autenticação básica ( key API ) |

|

Autenticação básica (serviço account JSON key) |

|

Método de autenticação | Disponibilidade |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (manual refresh tokens) |

|

Autenticação básica (nome de usuário/senha) |

|

Autenticação básica ( key API ) |

|

Autenticação básica (serviço account JSON key) |

|

Método de autenticação | Disponibilidade |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (manual refresh tokens) |

|

Autenticação básica (nome de usuário/senha) |

|

Autenticação básica ( key API ) |

|

Autenticação básica (serviço account JSON key) |

|

Método de autenticação | Disponibilidade |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (manual refresh tokens) |

|

Autenticação básica (nome de usuário/senha) |

|

Autenticação básica ( key API ) |

|

Autenticação básica (serviço account JSON key) |

|

Método de autenticação | Disponibilidade |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (manual refresh tokens) |

|

Autenticação básica (nome de usuário/senha) |

|

Autenticação básica ( key API ) |

|

Autenticação básica (serviço account JSON key) |

|

Método de autenticação | Disponibilidade |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (manual refresh tokens) |

|

Autenticação básica (nome de usuário/senha) |

|

Autenticação básica ( key API ) |

|

Autenticação básica (serviço account JSON key) |

|

Método de autenticação | Disponibilidade |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (manual refresh tokens) |

|

Autenticação básica (nome de usuário/senha) |

|

Autenticação básica ( key API ) |

|

Autenticação básica (serviço account JSON key) |

|

Método de autenticação | Disponibilidade |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (manual refresh tokens) |

|

Autenticação básica (nome de usuário/senha) |

|

Autenticação básica ( key API ) |

|

Autenticação básica (serviço account JSON key) |

|

Método de autenticação | Disponibilidade |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (manual refresh tokens) |

|

Autenticação básica (nome de usuário/senha) |

|

Autenticação básica ( key API ) |

|

Autenticação básica (serviço account JSON key) |

|

Método de autenticação | Disponibilidade |

|---|---|

OAuth U2M |

|

OAuth M2M |

|

OAuth (manual refresh tokens) |

|

Autenticação básica (nome de usuário/senha) |

|

Autenticação básica ( key API ) |

|

Autenticação básica (serviço account JSON key) |

|

Dependência de serviços externos

Databricks SaaS Os conectores de aplicativos, bancos de dados e outros conectores totalmente gerenciados dependem da acessibilidade, da compatibilidade e da estabilidade do aplicativo, do banco de dados ou do serviço externo ao qual se conectam. Databricks não controla esses serviços externos e, portanto, tem influência limitada (se houver) sobre suas alterações, atualizações e manutenção.

Se alterações, interrupções ou circunstâncias relacionadas a um serviço externo impedirem ou tornarem impraticáveis as operações de um conector, o site Databricks poderá descontinuar ou deixar de manter esse conector. A Databricks envidará esforços razoáveis para notificar os clientes sobre a descontinuação ou interrupção da manutenção, incluindo atualizações da documentação aplicável.