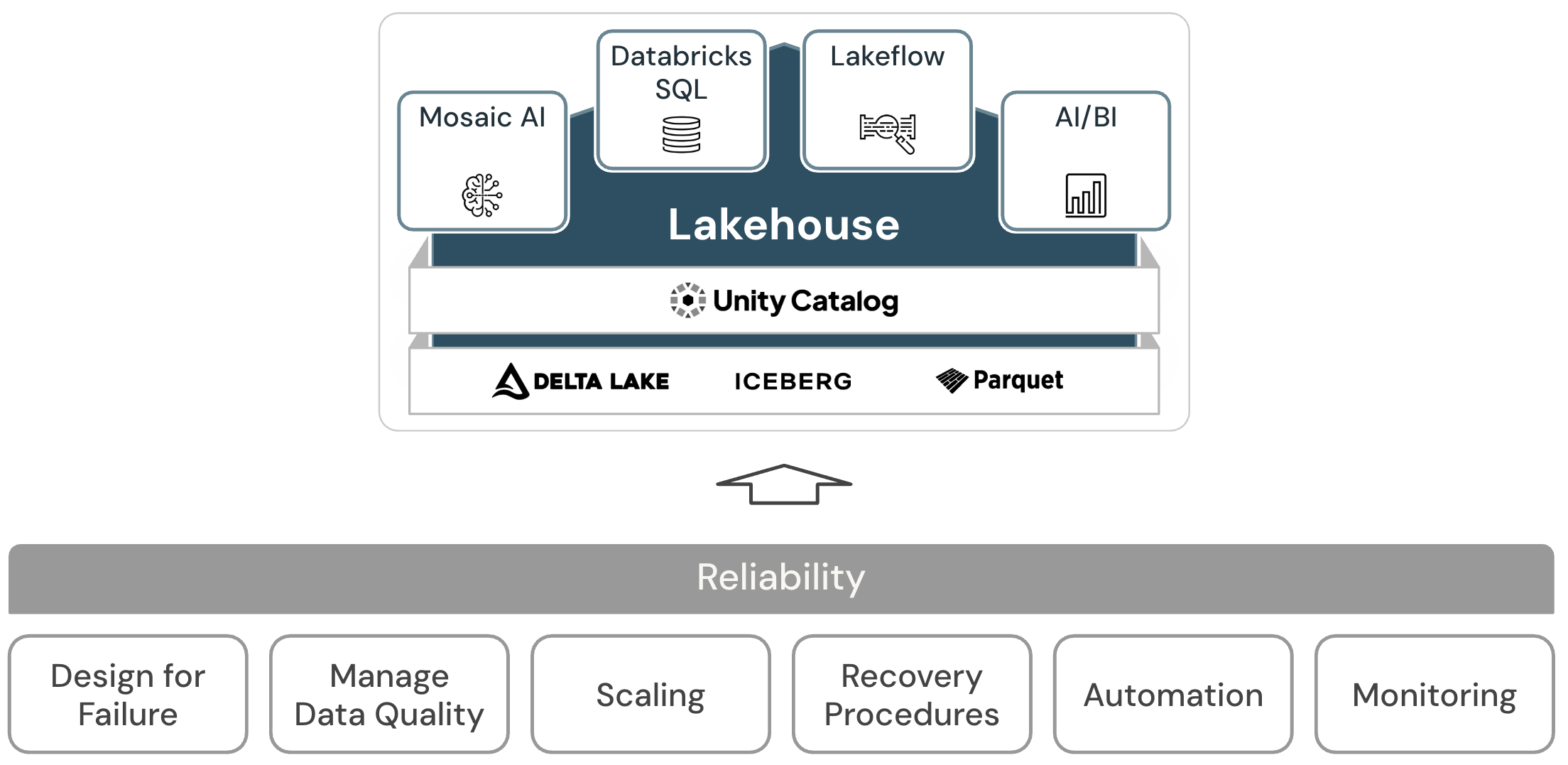

データレイクハウスの信頼性

信頼性 の柱のアーキテクチャ原則は、システムが障害から回復し、機能し続ける能力に対処します。

信頼性の原則

-

失敗のための設計

高度に分散された環境では、停止が発生する可能性があります。 プラットフォームとさまざまなワークロード (ストリーミング ジョブ、バッチジョブ、モデル トレーニング、 BI クエリなど) の両方で、障害を予測し、信頼性を高めるために回復力のあるソリューションを開発する必要があります。 焦点は、アプリケーションを迅速かつ、最良のケースでは自動的に回復するように設計することにあります。

-

データ品質の管理

データ品質は、データから正確で意味のある知見を導き出すための基本です。 データ品質には、完全性、正確性、有効性、一貫性など、さまざまな側面があります。 最終的なデータセットの品質を向上させるために積極的に管理し、データがビジネスユーザーにとって信頼できる信頼できる情報として機能するようにする必要があります。

-

オートスケールの設計

標準的な ETL プロセス、ビジネスレポート、およびダッシュボードには、多くの場合、メモリとコンピュートの観点から予測可能なリソース要件があります。 ただし、新しいプロジェクト、季節的なタスク、またはモデル トレーニング (チャーン、予測、メンテナンス) などの高度なアプローチにより、リソース要件が急増します。 組織がこれらすべてのワークロードを処理するには、スケーラブルなストレージとコンピュートプラットフォームが必要です。 必要に応じて新しいリソースを追加するのは簡単で、実際の消費量に対してのみ課金する必要があります。 ピークが過ぎると、リソースを解放し、それに応じてコストを削減できます。 これは、多くの場合、水平スケーリング (ノード数) および垂直スケーリング (ノードのサイズ) と呼ばれます。

-

テスト復旧手順

ほとんどのアプリケーションやシステムに対して、企業全体のディザスタリカバリ戦略を適用するには、優先順位、機能、制限、およびコストを評価する必要があります。 信頼性の高いディザスタリカバリアプローチは、ワークロードの失敗を定期的にテストし、リカバリ手順を検証します。 自動化を使用して、さまざまな障害をシミュレートしたり、過去に障害を引き起こしたシナリオを再現したりできます。

-

デプロイとワークロードの自動化

レイクハウスのデプロイとワークロードを自動化することで、これらのプロセスを標準化し、人為的エラーを排除し、生産性を向上させ、再現性を高めることができます。 これには、構成のドリフトを回避するための「コードとしての構成」の使用や、必要なすべてのレイクハウスおよびクラウドサービスのプロビジョニングを自動化するための「コードとしてのインフラストラクチャ」の使用が含まれます。

-

システムとワークロードの監視

レイクハウスのワークロードは、通常、Databricks プラットフォームサービスと外部クラウドサービスを (データソースやターゲットなど) 統合します。 正常な実行は、実行チェーン内の各サービスが正常に機能している場合にのみ発生します。 そうでない場合は、問題を検出して追跡し、システムの動作を理解するために、監視、アラート、およびロギングが重要です。

次へ: 信頼性に関するおすすめの方法

信頼性のベスト プラクティスを参照してください。