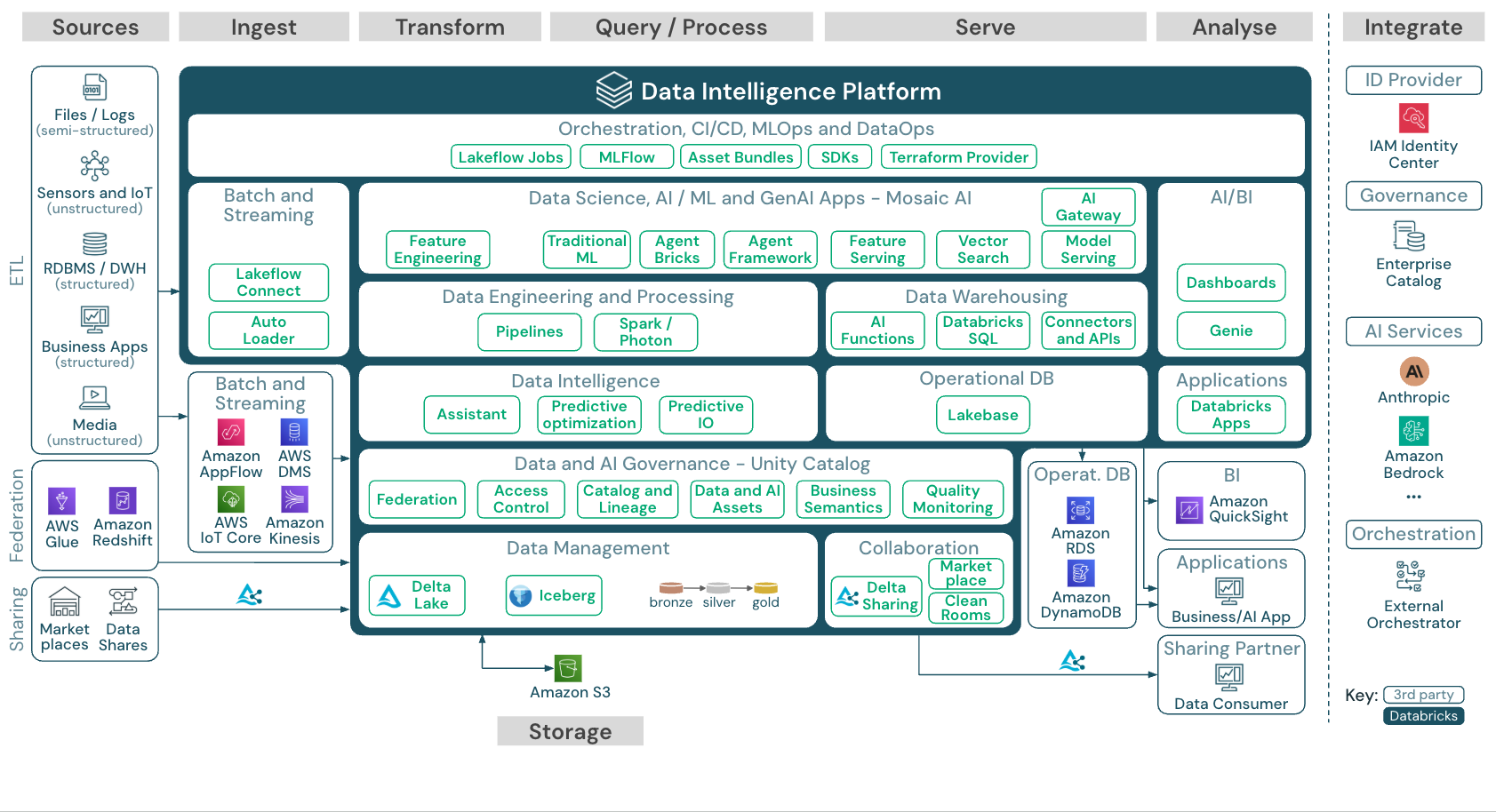

レイクハウスのリファレンスアーキテクチャ (ダウンロード)

この記事では、レイクハウスのアーキテクチャ ガイダンスを提供し、データソース、インジェスト、変換、クエリと処理、サービング、分析、ストレージについて説明します。

各リファレンスアーキテクチャは、11 x 17(A3)フォーマットのPDFをダウンロードできます。

Databricks のレイクハウスは、 パートナーツールの大規模なエコシステムと統合するオープンプラットフォームですが、リファレンスアーキテクチャは AWS サービスと Databricks レイクハウスのみに焦点を当てています。 示されているクラウド プロバイダー サービスは、概念を説明するために選択されており、すべてを網羅しているわけではありません。

ダウンロード:AWS上のDatabricksレイクハウスのリファレンスアーキテクチャ

AWS リファレンスアーキテクチャは、取り込み、保存、サービス、および分析のための次の AWS 固有のサービスを示しています。

- レイクハウスフェデレーションのソースとしてのAmazon Redshift

- バッチ取り込み用のAmazon AppFlowとAWS Glue

- AWS IoT Core、Amazon Kinesis、AWS DMSによるストリーミング取り込み

- Amazon S3 は、データおよび AI アセットのオブジェクトストレージとして

- 運用データベースとしてのAmazon RDSとAmazon DynamoDB

- BIツールとしてのAmazon QuickSight

- Amazon Bedrockは、モデルサービングが主要なAIスタートアップやAmazonの外部LLMを呼び出すために使用されます

リファレンス・アーキテクチャの構成

参照アーキテクチャは、 ソース 、 インジェスト 、 変換 、 クエリ/プロセス 、 サーブ 、 分析 、 ストレージ のスイムレーンに沿って構成されています。

-

ソース

外部データをデータインテリジェンスプラットフォームに統合するには、次の3つの方法があります。

-

ETL:このプラットフォームは、半構造化データおよび非構造化データ(センサー、IoTデバイス、メディア、ファイル、ログなど)を提供するシステム、およびリレーショナルデータベースやビジネスアプリケーションからの構造化データとの統合を可能にします。

-

レイクハウスフェデレーション: SQLリレーショナルデータベースなどの ソースは、 なしでレイクハウスとUnity Catalog ETLに統合できます。この場合、ソース システムのデータは Unity Catalog によって管理され、クエリはソース システムにプッシュダウンされます。

-

カタログのフェデレーション: 外部のHive metastore カタログまたはAWSGlue Unity Catalogは、カタログのフェデレーション を通じて に統合することもでき、Unity Catalog Hive metastoreまたはAWSGlue に格納されたテーブルを制御できます。

-

-

インジェスト

バッチまたはストリーミングでレイクハウスにデータを取り込みます。

- Databricks Lakeflow Connect 、エンタープライズ アプリケーションやデータベースから取り込むための組み込みコネクタを提供します。 結果として得られる取り込みパイプラインはUnity Catalogによって管理され、サーバレス コンピュートとパイプラインによって強化されます。

- クラウドストレージに配信されたファイルは、Databricks Auto Loader を使用して直接読み込むことができます。

- エンタープライズアプリケーションから Delta Lakeへのデータのバッチ取り込みの場合、Databricks レイクハウスは、これらのレコードシステム用の特定のアダプターを備えたパートナー取り込みツールに依存しています。

- ストリーミング イベントは、Databricksの構造化ストリーミングを使用して、Kafkaなどのイベント ストリーミング システムから直接取り込むことができます。ストリーミング ソースは、センサー、 IoT、または チェンジデータキャプチャ プロセスです。

-

ストレージ

- データは通常、クラウド上でストレージシステムに保存され、 ETL パイプラインは メダリオンアーキテクチャ を使用して、 Delta ファイル/テーブル または Apache Iceberg テーブルとしてキュレーションされた方法でデータを格納します。

-

変換 と クエリ/プロセス

-

Databricks レイクハウスは、すべての変換とクエリに Apache Spark と Photon のエンジンを使用します。

-

パイプラインは、信頼性が高く、保守可能で、テスト可能なデータ処理パイプラインを簡素化および最適化するための宣言型フレームワークです。

-

Apache SparkとPhotonを活用して、Databricksデータインテリジェンスプラットフォームは、 SQLウェアハウス を介したSQLクエリー、 ワークスペースのクラスターを通じた、SQL、Python、Scalaワークロードの両方をサポートします。

-

データサイエンス(ML モデリングと 生成AI)の場合、DatabricksのAI および機械学習プラットフォームは、 AutoML と ML ジョブのコーディングに特化した ML ランタイムを提供します。 すべてのデータサイエンスとMLOpsワークフローは、MLflowによって最適にサポートされます。

-

-

サービング

-

データウェアハウジング (DWH) およびBIユースケース向けに、Databricks レイクハウスは、Databricks SQL、SQLウェアハウスを搭載したデータウェアハウス、およびサーバレス SQLウェアハウスを提供しています。

-

機械学習の場合、 Mosaic AI Model Serving 、 Databricksコントロール プレーンでホストされるスケーラブルな随時のエンタープライズ グレードのモデルサービング機能です。 Mosaic AI Gatewayサポートされている生成AIモデルとそれに関連するモデルサービング エンドポイントへのアクセスを管理およびモニタリングするためのDatabricksのソリューションです。

-

運用データベース:

-

Lakebase は、Postgres をベースとし、Databricks Data Intelligence Platform と完全に統合されたオンライン トランザクション処理 (OLTP) データベースです。Databricks上に OLTP データベースを作成し、OLTP ワークロードをレイクハウスと統合することができます。

-

オペレーショナルデータベースなどの外部システムを使用して、最終データ製品を保存し、ユーザーアプリケーションに配信できます。

-

-

-

コラボレーション :

-

ビジネス パートナーは、 Delta Sharing を通じて必要なデータに安全にアクセスできます。

-

Delta Sharing を基盤とする Databricks Marketplace は、データ製品を交換するためのオープン フォーラムです。

-

クリーンルーム は、複数のユーザーが互いのデータに直接アクセスすることなく、機密性の高い企業データで共同作業ができる、安全でプライバシー保護の環境です。

-

-

分析

-

最終的なビジネスアプリケーションは、このスイムレーンにあります。 例としては、 Mosaic AI Model Serving に接続された AI アプリケーションや、リアルタイム推論のための AI アプリケーション、レイクハウスからオペレーショナル データベースにプッシュされたデータにアクセスするアプリケーションなどのカスタム クライアントがあります。

-

BI のユースケースでは、アナリストは通常、 データウェアハウスにアクセスするBI ツールを使用します。 SQL 開発者は、 Databricks SQL エディター (図には示されていません) を使用して、クエリとダッシュボードに追加で使用できます。

-

Data Intelligence Platform には、データの視覚化を構築し、知見を共有するための ダッシュボード も用意されています。

-

-

統合

-

Databricks プラットフォームは、 ユーザー管理 と シングルサインオン (SSO) のための標準 ID プロバイダーと統合されています。

-

OpenAI、LangChain、HuggingFace などの外部 AI サービスは、Databricks Intelligence Platform 内から直接使用できます。

-

外部オーケストレーターは、包括的な REST API を使用するか、 Apache Airflow などの外部オーケストレーション ツールへの専用コネクタを使用できます。

-

Unity Catalogは、Databricks Intelligence PlatformのすべてのデータおよびAIのガバナンスに使用され、レイクハウスフェデレーション を通じて他のデータベースをガバナンスに統合できます。

さらに、Unity Catalog は他のエンタープライズ カタログに統合できます。 詳細については、エンタープライズ カタログ ベンダーにお問い合わせください。

-

すべてのワークロードに共通の機能

さらに、Databricksレイクハウスには、すべてのワークロードをサポートする管理機能が付属しています。

-

データとAIのガバナンス

Databricks Data Intelligence Platform の中心的なデータと AI ガバナンスシステムは、 Unity Catalog です。 Unity Catalog は、すべてのワークスペースに適用され、テーブル、ボリューム、特徴量 (フィーチャ ストア)、モデル (モデルレジストリ) など、レイクハウスで作成または使用されるすべての資産をサポートするデータ アクセス ポリシーを 1 か所で管理します。 Unity Catalogは、 Databricksで実行されるクエリ間でランタイム データリネージをキャプチャ するためにも使用できます。

Databricks データ品質モニタリングを使用すると、アカウント内のすべてのテーブルのデータ品質を監視できます。すべてのテーブルの異常を検出し、各テーブルの完全なデータプロファイリングを提供します。

可観測性のために、 システムテーブル は、アカウントの運用データの Databricksホスト型分析ストアです。 システムテーブルは、アカウント全体の履歴オブザーバビリティに使用できます。

-

データインテリジェンスエンジン

Databricks Data Intelligence Platform を使用すると、組織全体でデータとAIを使用できるようになり、生成AIとレイクハウスの統合メリットを組み合わせて、データの固有のセマンティクスを理解できるようになります。 Databricks AI 支援機能を参照してください。

この Databricks Assistant は、 Databricks ノートブック、 SQL エディター、ファイルエディターなど、ユーザー向けのコンテキスト対応 AI アシスタントとして使用できます。

-

オートメーション&オーケストレーション

Lakeflowジョブは、 Databricks Data Intelligence Platform 上のデータ処理、機械学習、アナリティクス パイプラインを調整します。 Lakeflow Spark宣言型パイプラインを使用すると、宣言型構文を使用して信頼性が高く保守可能なETLパイプラインを構築できます。 このプラットフォームはCI/CDとMLOpsもサポートしています

AWS 上の Data Intelligence Platform の高レベルのユースケース

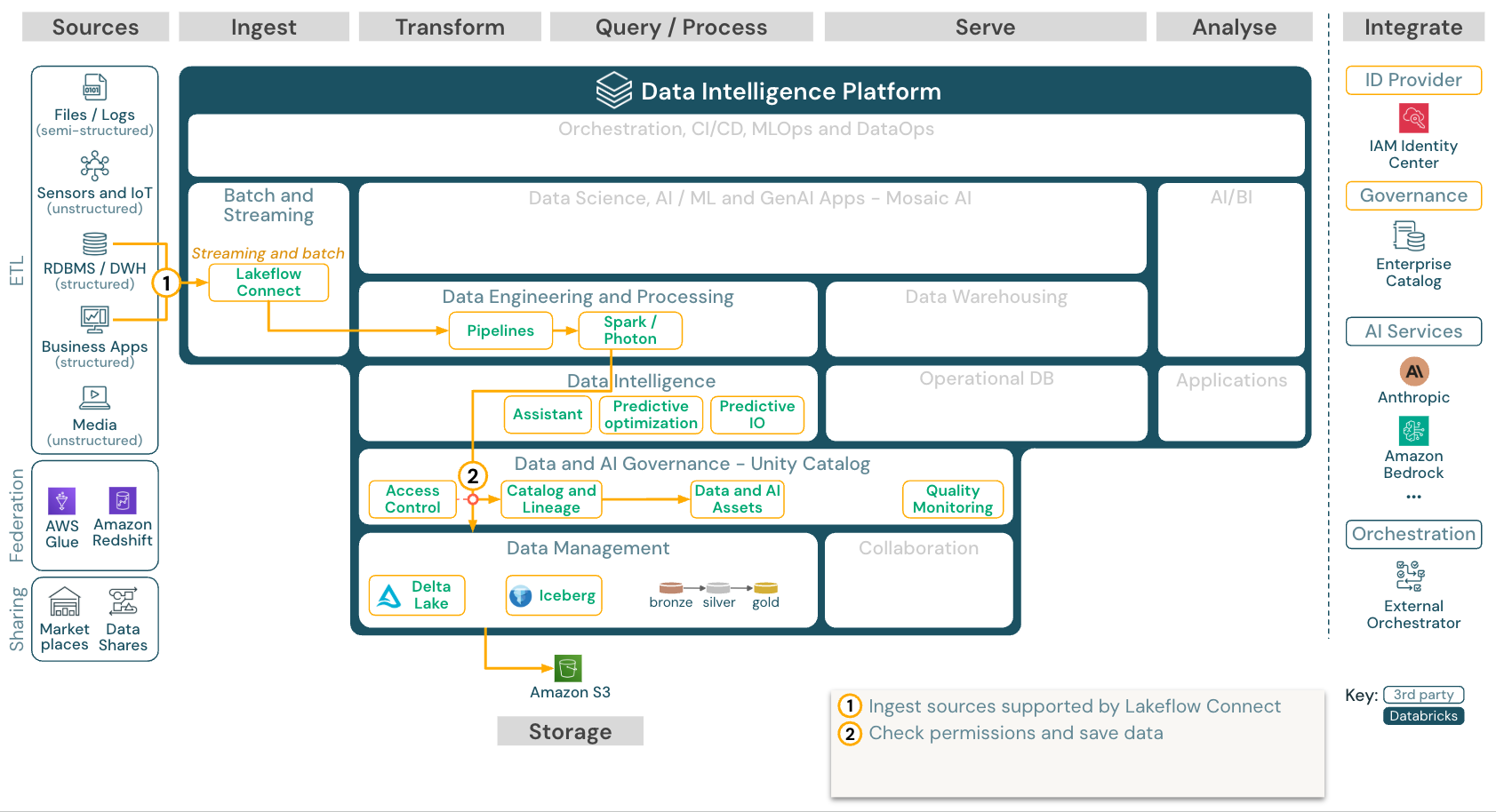

を使用した アプリやデータベースからの組み込みSaaSLakeflowコネクト

ダウンロード:Lakeflowコネクト の リファレンス アーキテクチャDatabricks on AWS

Databricks Lakeflow Connect 、エンタープライズ アプリケーションやデータベースから取り込むための組み込みコネクタを提供します。 結果として得られる取り込みパイプラインはUnity Catalogによって管理され、サーバレス コンピュートとLakeflow Spark宣言型パイプラインによって強化されます。

Lakeflowコネクト は、効率的な増分読み取りと書き込みを活用して、データ取り込みをより速く、スケーラブルで、コスト効率を高めながら、データを最新のままダウンストリームで消費できるようにします。

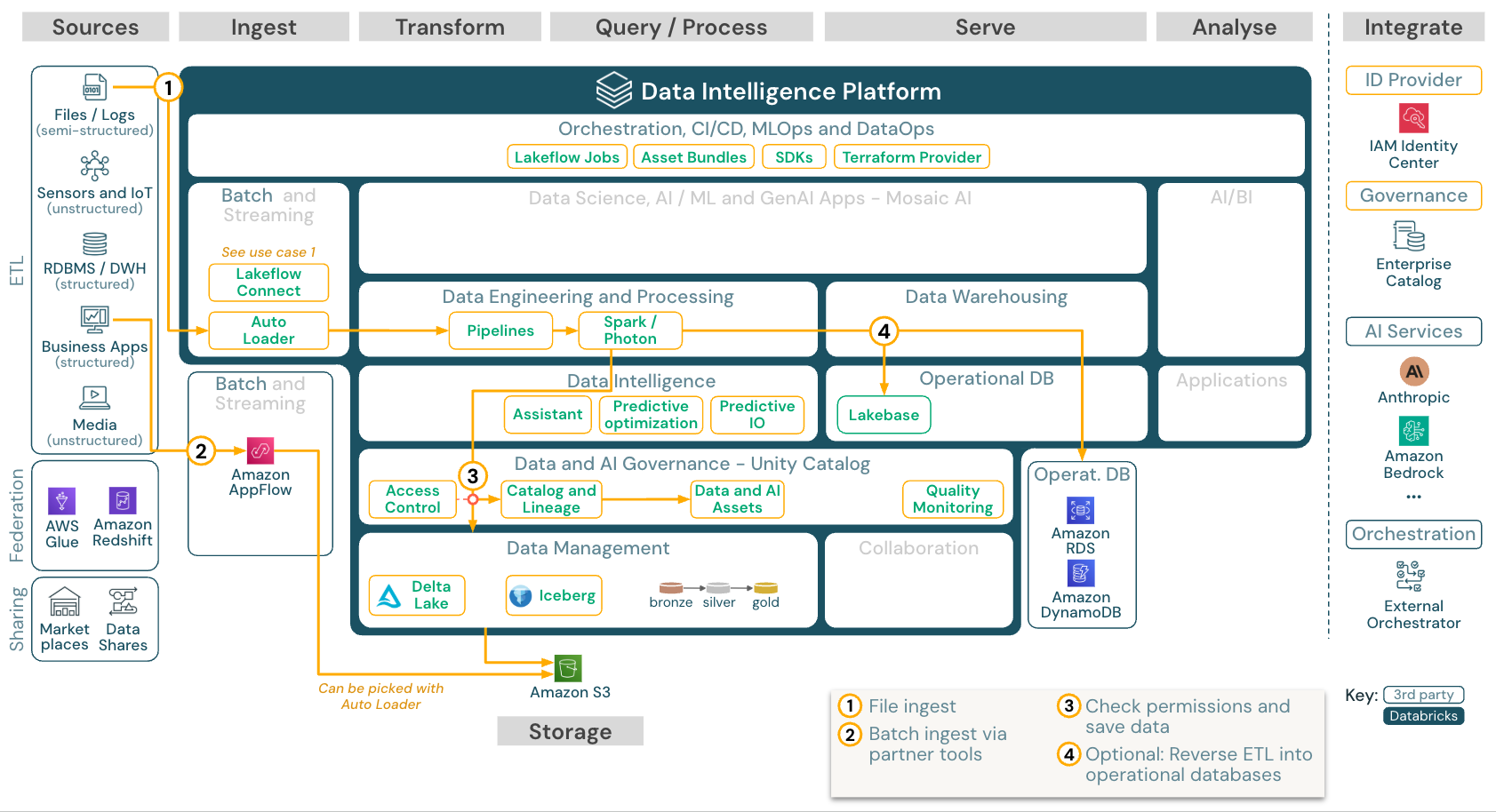

バッチ取り込みとETL

ダウンロード:Databricks on AWSのバッチETLリファレンスアーキテクチャ

インジェスト ツールは、ソース固有のアダプターを使用してソースからデータを読み取り、 Auto Loader読み取れるクラウド上のストレージに保存するか、 Databricks直接呼び出します (たとえば、 Databricksレイクハウスに統合されたパートナー インジェスト ツールを使用します)。 データをロードするには、 Databricks ETLと処理エンジンがパイプライン経由でクエリを実行します。 Lakeflowジョブを使用して単一またはマルチタスクのジョブを調整し、 Unity Catalog (アクセス制御、監査、リネージなど) を使用してそれらを管理します。 低レイテンシの運用システムの特定のゴールデン テーブルへのアクセスを提供するには、ETL パイプラインの最後にある RDBMS やキー値ストアなどの運用データベースにテーブルをエクスポートします。

ストリーミング and チェンジデータキャプチャ (CDC)

ダウンロード:Databricks on AWSのSpark構造化ストリーミングアーキテクチャ

DatabricksETLエンジンSparkApacheKafkaAWSKinesis、 や などのイベント キューから読み取るための構造化ストリーミングダウンストリームの手順は、上記のバッチのユースケースのアプローチに従います。

通常、変化データキャプチャ( CDC ) は、抽出されたイベントをイベント キューに保存します。 そこから、ユースケースはストリーミングのユースケースに従います。

CDCがバッチで実行され、抽出されたレコードが最初にクラウド ストレージに保存されている場合、 Databricks Autoloader はそれらを読み取ることができ、ユース ケースは バッチETLに従います。

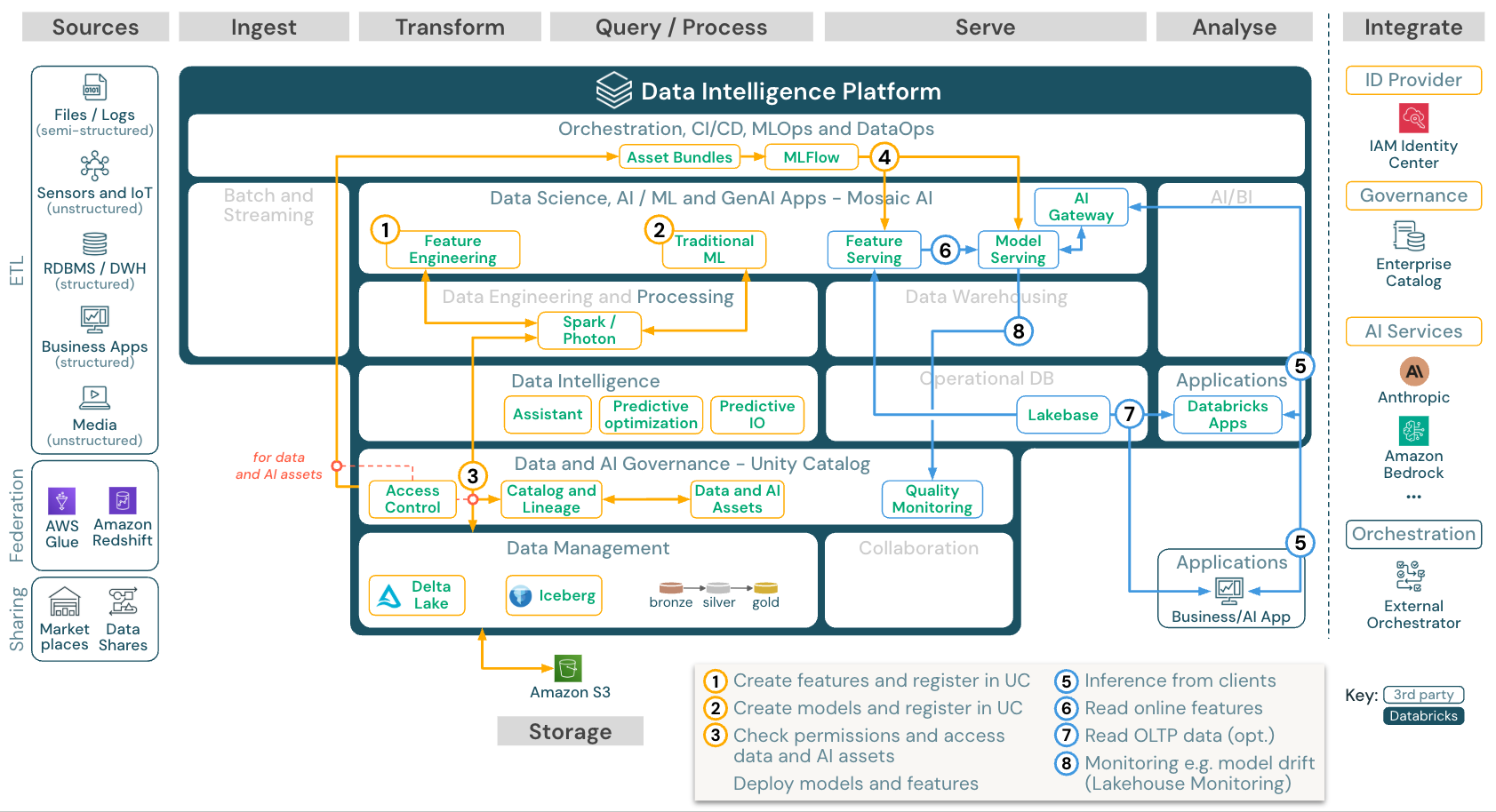

機械学習と AI (従来型)

ダウンロード:Databricks on AWSの機械学習およびAIリファレンスアーキテクチャ

機械学習については、Databricks Data Intelligence Platform が Mosaic AI を提供し、最先端の 機械学習ライブラリとディープラーニングライブラリが付属しています。Feature StoreとModel Registry (どちらもUnity Catalogに統合)、AutoML付きローコード機能、データサイエンスライフサイクルへのMLflow統合などの機能を提供します。

Unity Catalogすべてのデータサイエンス関連の資産 (テーブル、機能、モデル) を管理し、 data scientists Lakeflowジョブを使用してジョブを調整できます。

スケーラブルでエンタープライズ グレードの方法でモデルをデプロイするには、 MLOps 機能を使用してモデルをモデル サービングにパブリッシュします。

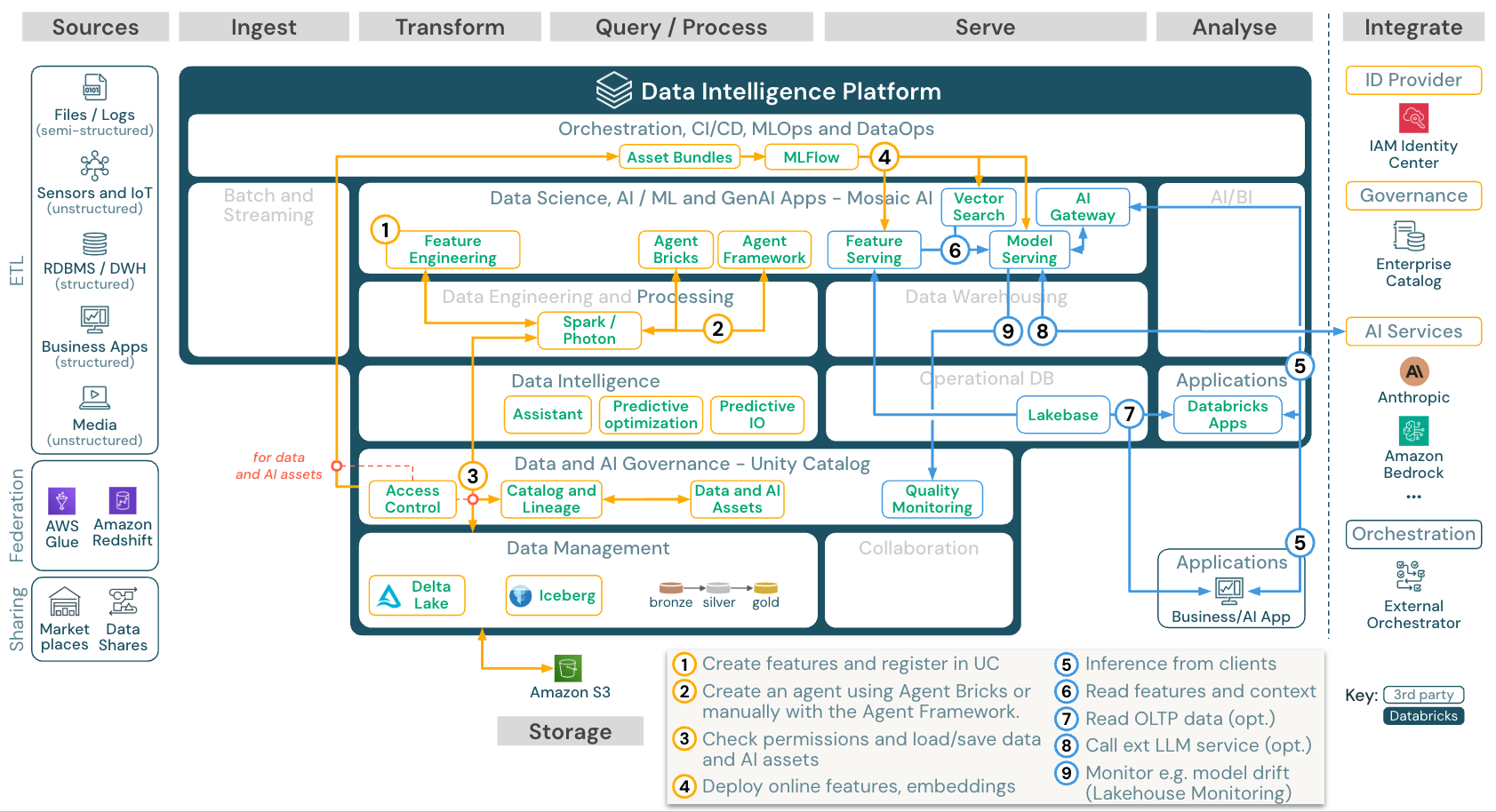

AIエージェントアプリケーション(生成AI)

ダウンロード: Databricks on AWSにおける生成AIアプリケーションのリファレンスアーキテクチャ

スケーラブルでエンタープライズグレードの方法でモデルをデプロイするには、MLOps機能を使用してモデルサービングでモデルを公開します。

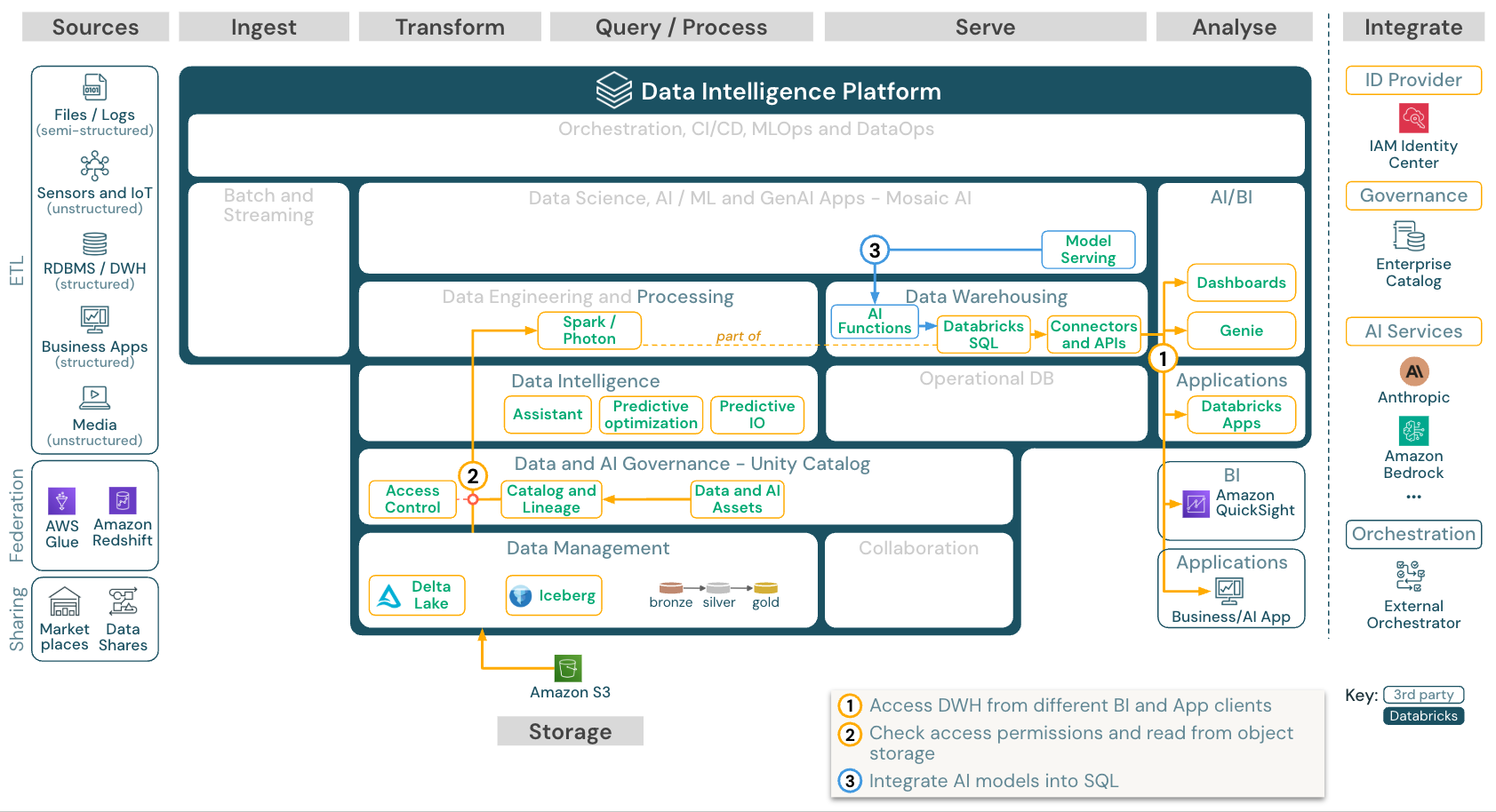

BI and SQL アナリティクス

ダウンロード:Databricks on AWSのBIおよびSQLアナリティクスのリファレンスアーキテクチャ

BI のユースケースでは、ビジネスアナリストは ダッシュボード、 Databricks SQL エディター 、または Tableau や Amazon QuickSight などの BI ツール を使用できます。いずれの場合も、エンジンは Databricks SQL (サーバレスまたは非サーバレス) であり、 Unity Catalog がデータディスカバリー、探索、リネージ、およびアクセス制御を提供します。

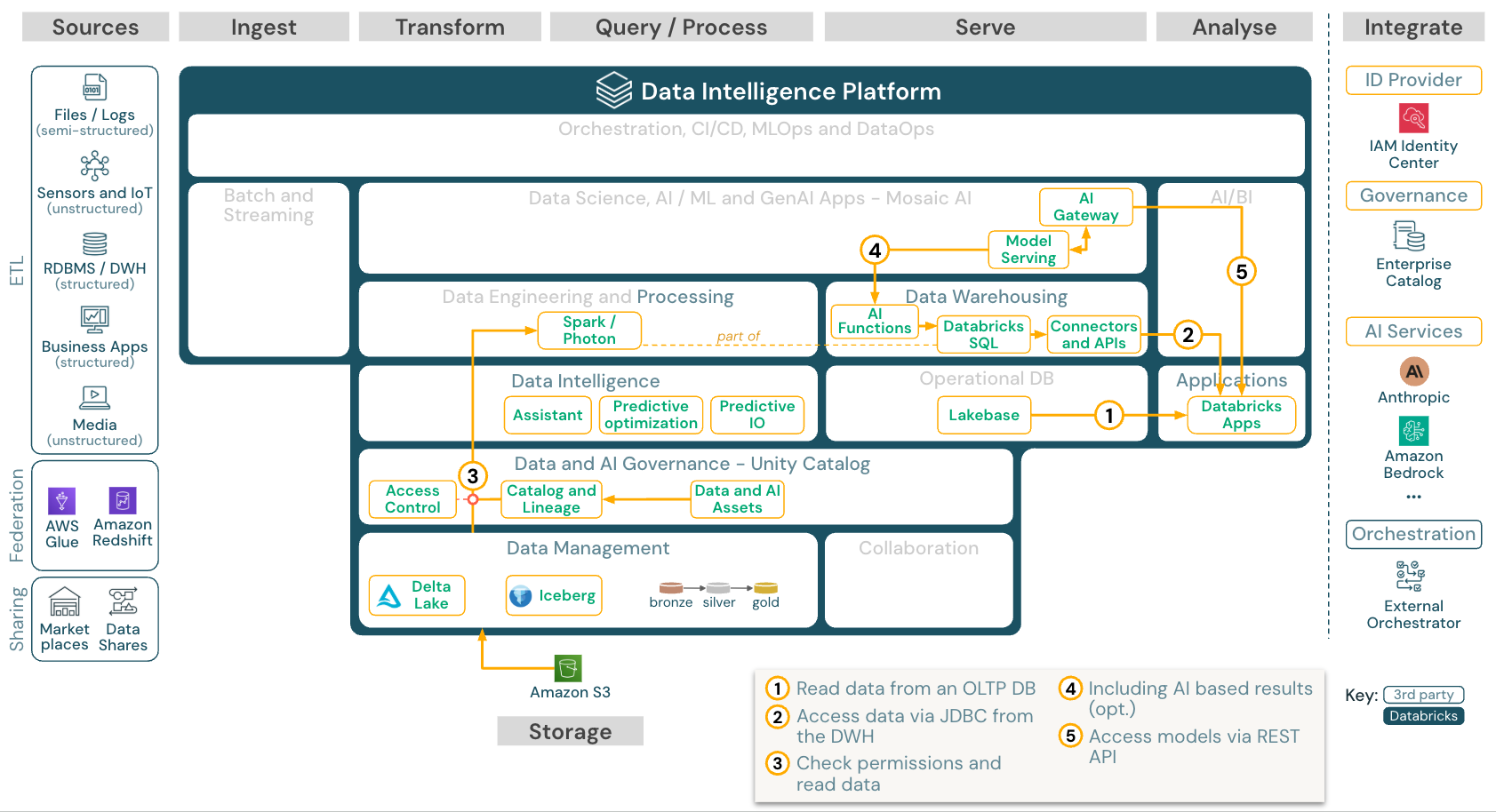

ビジネスアプリ

ダウンロード: Databricks on AWS向けビジネス アプリ

Databricks Apps を使用すると、開発者は安全なデータアプリケーションや AI アプリケーションを Databricks プラットフォーム上で直接構築してデプロイできるため、個別のインフラストラクチャが不要になります。アプリは Databricks サーバレス プラットフォームでホストされ、主要なプラットフォーム サービスと統合されます。 レイクハウスから同期された OLTP データがアプリに必要な場合は、 Lakebase を使用します。

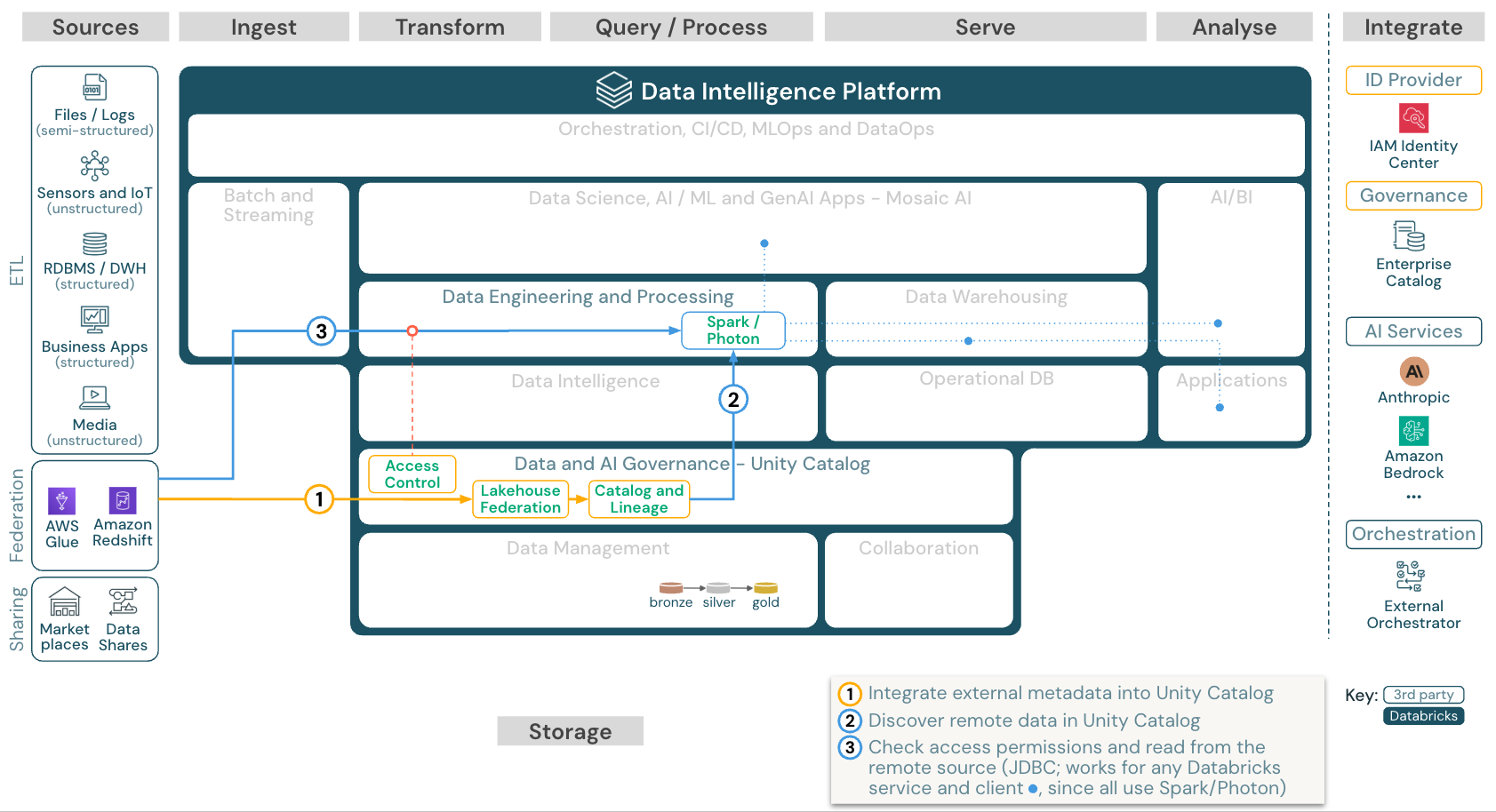

レイクハウス連合

ダウンロード: Databricks on AWSのレイクハウスフェデレーションリファレンスアーキテクチャ

レイクハウスフェデレーション を使用すると、外部データのSQLデータベース(MySQL、Postgres、Redshiftなど)をDatabricksと統合できます。

最初にデータをオブジェクトストレージにETLする必要がなく、すべてのワークロード (AI、DWH、BI) がこのメリットを享受できます。外部ソースカタログはUnity Catalogにマッピングされ、Databricksプラットフォーム経由のアクセスにきめ細かいアクセス制御を適用できます。

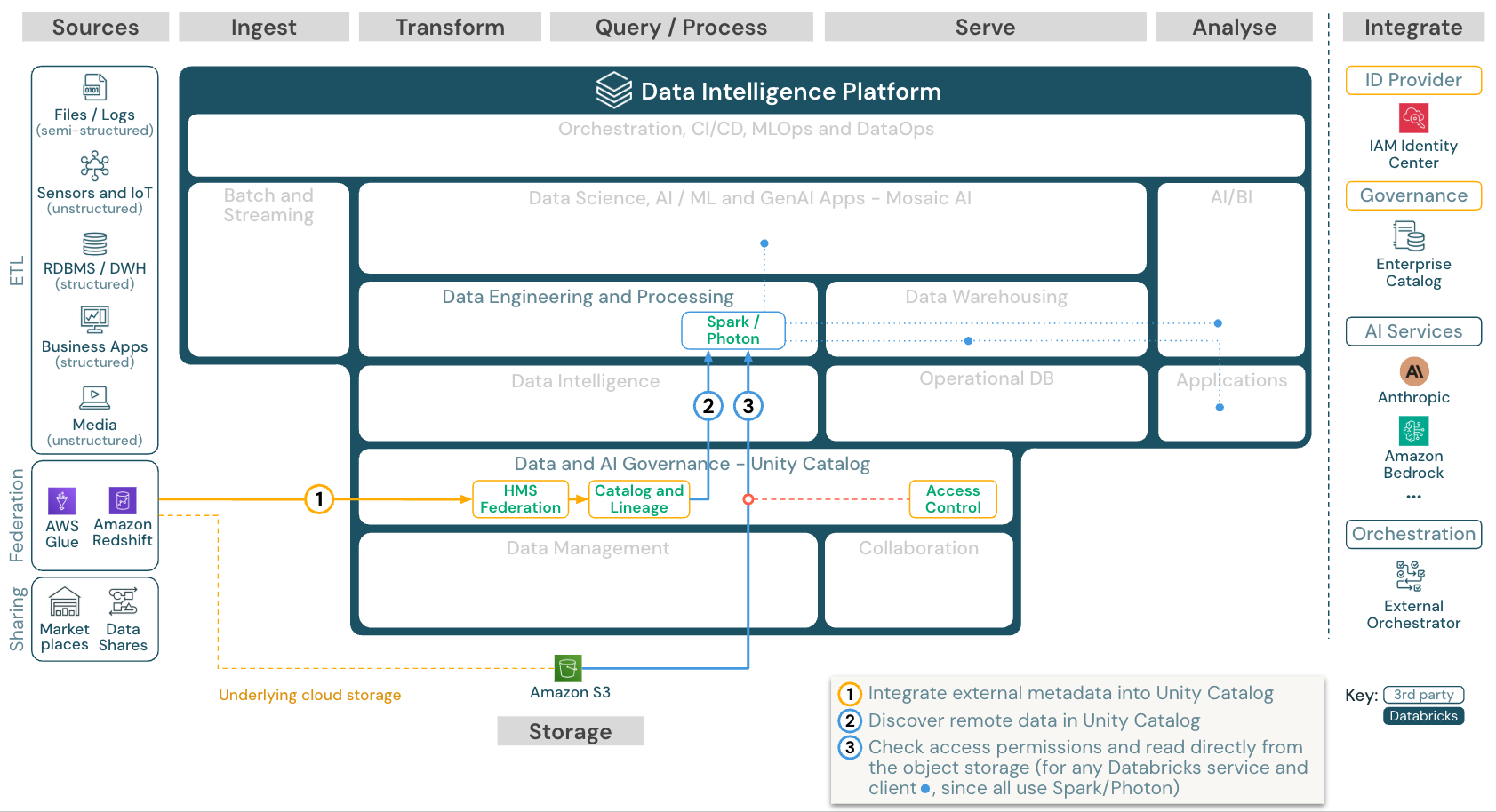

カタログのフェデレーション

ダウンロード: Databricks on AWS のカタログ統合参照アーキテクチャ

カタログフェデレーション を使用すると、外部の Hive メタストア (MySQL、Postgres、Redshift など) または Amazon Glue を Databricks と統合できます。

すべてのワークロード(AI、DWH、BI)は、最初にデータをオブジェクトストレージにETLしなくても、このメリットを享受できます。外部ソース カタログは、Unity Catalog プラットフォームを介してきめ細かなアクセス制御が適用されるDatabricks に追加されます。

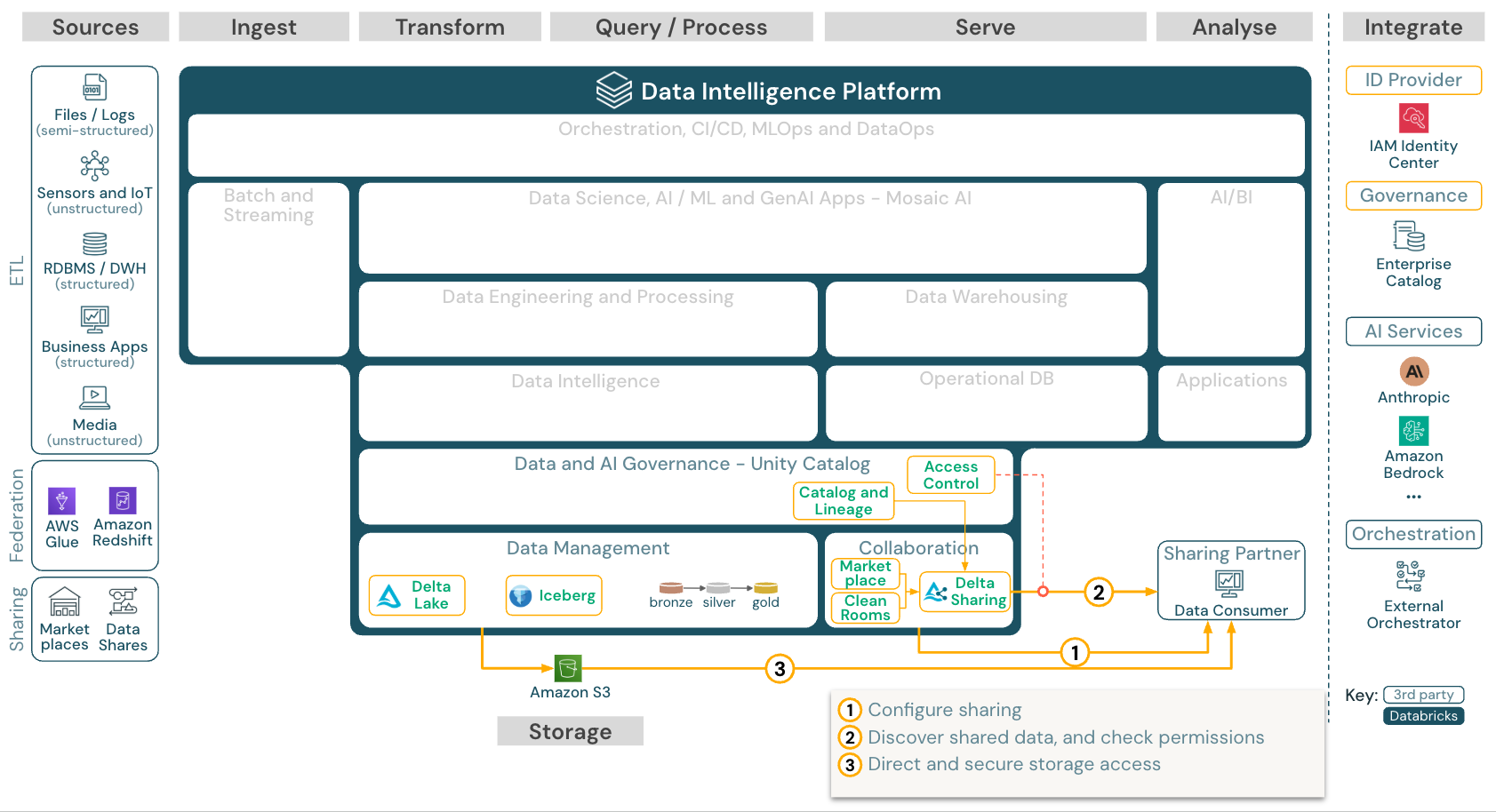

サードパーティのツールとデータを共有する

ダウンロード: 3rd パーティ ツールとのデータ共有: Databricks on AWS のリファレンス アーキテクチャ

第三者とのエンタープライズグレードのデータ共有は、 Delta Sharingによって提供されます。これにより、Unity Catalog によって保護されたオブジェクト ストア内のデータに直接アクセスできます。この機能は、データ製品を交換するためのオープンフォーラムである Databricks Marketplace でも使用されます。

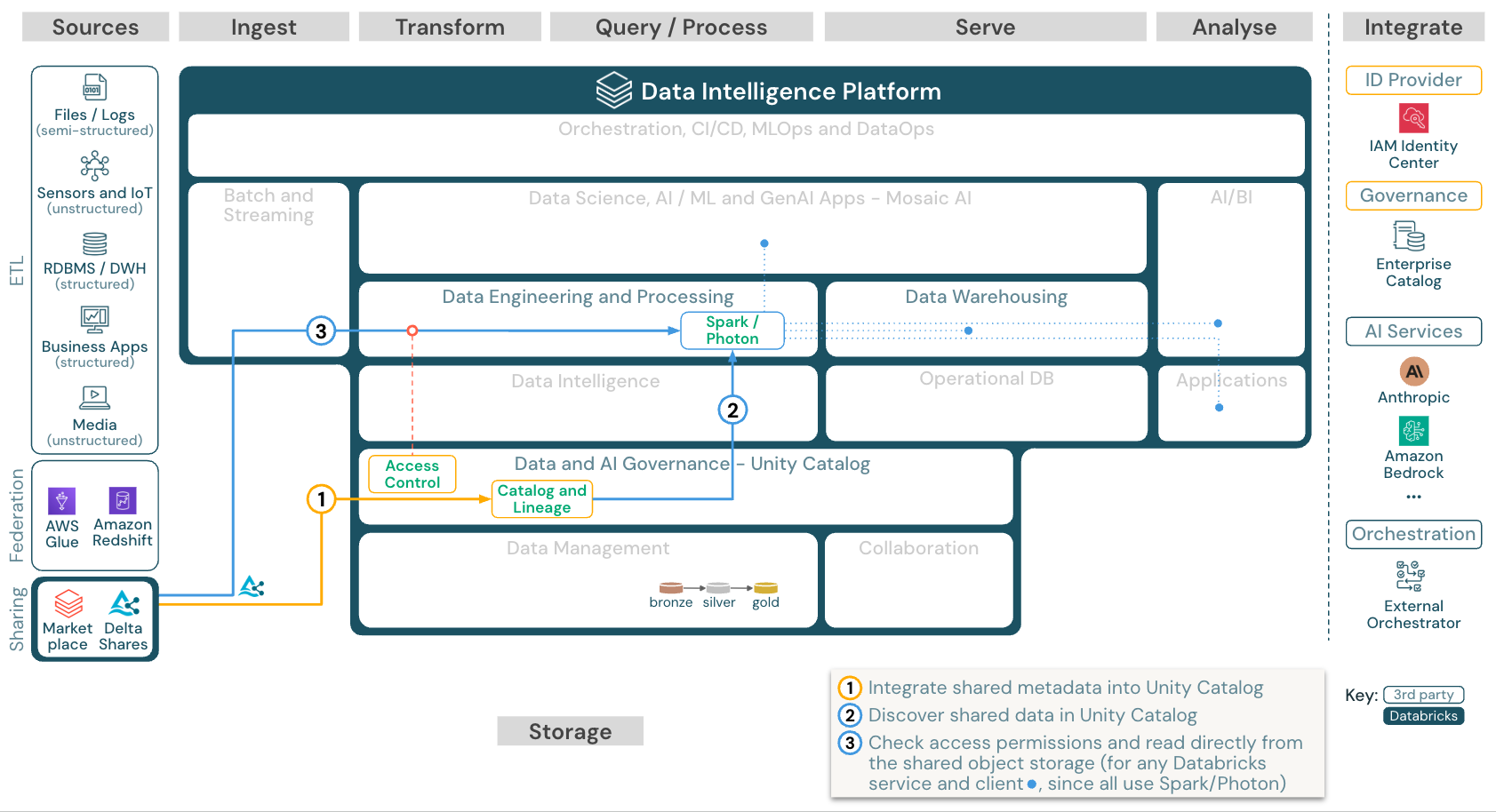

Databricks から共有データを使用する

ダウンロード: の参照アーキテクチャから共有データを使用するDatabricksDatabricks on AWS

Delta Sharing Databricks-to-Databricks プロトコルを使用すると、ユーザーが Unity Catalog が有効になっているワークスペースにアクセスできる限り、アカウントやクラウド ホストに関係なく、任意の Databricks ユーザーとデータを安全に共有できます。