Databricks ativo Bundles extension recurso

A extensão Databricks para Visual Studio Code fornece recursos adicionais dentro do Visual Studio Code que permitem definir, implantar e executar facilmente Bundles ativos Databricks para aplicar as melhores práticas CI/CD aos seus Jobs LakeFlow , pipeline declarativo LakeFlow Spark e Stacks MLOps . Veja O que são Databricks Ativo Bundles?.

Para instalar a extensão Databricks para o Visual Studio Code, consulte Instalar a extensão Databricks para o Visual Studio Code.

Databricks Suporte a pacotes ativos em projetos

A extensão Databricks para o Visual Studio Code adiciona o seguinte recurso aos seus projetos Databricks ativo Bundles:

- Fácil autenticação e configuração de seus pacotes ativos Databricks por meio da interface do usuário do Visual Studio Code, incluindo a seleção do perfil AuthType . Consulte Configurar autorização para a extensão Databricks para Visual Studio Code.

- Um seletor de destino no painel de extensão do Databricks para alternar rapidamente entre ambientes de destino de pacotes. Consulte Alterar a implantação de destino workspace.

- A opção Override Jobs clustering in bundle (Substituir clustering de trabalhos no pacote ) no painel de extensão permite a fácil substituição do clustering.

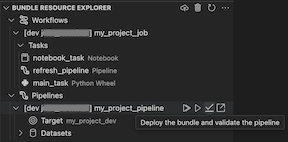

- Um Bundles recurso Explorer view, que permite que o senhor navegue pelo seu recurso de pacote usando a interface do usuário do Visual Studio Code, implante o recurso do seu pacote ativo local Databricks no seu site remoto Databricks workspace com um único clique e vá diretamente para o recurso implantado no seu site workspace a partir do Visual Studio Code. Consulte Bundle recurso Explorer.

- Uma visualização de variáveis de pacotes , que permite que o senhor procure e edite as variáveis do pacote usando a interface do usuário do Visual Studio Code. Consulte a visualização Variáveis do pacote.

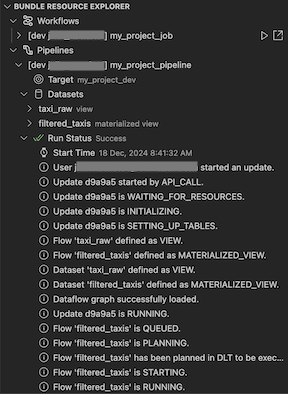

Pacote recurso Explorer

O Bundle recurso Explorer view na extensão Databricks para Visual Studio Code usa as definições de recurso na configuração do pacote do projeto para exibir o recurso, incluindo o conjunto de dados pipeline e seus esquemas. Ele também permite que o senhor implante e execute recurso, valide e realize atualizações parciais do pipeline, view pipeline execute eventos e diagnósticos e navegue até o recurso em seu site remoto Databricks workspace. Para obter informações sobre recurso de configuração de pacote, consulte recurso.

Por exemplo, dada uma definição simples de trabalho:

resources:

jobs:

my-notebook-job:

name: 'My Notebook Job'

tasks:

- task_key: notebook-task

existing_cluster_id: 1234-567890-abcde123

notebook_task:

notebook_path: notebooks/my-notebook.py

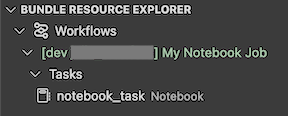

O Bundle recurso Explorer view na extensão exibe o recurso Notebook Job:

implantação e execução de um trabalho

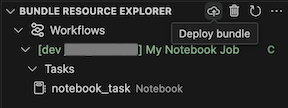

Para implantar o pacote, clique no ícone da nuvem (pacote implantado ).

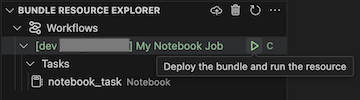

Para executar o Job, no Bundle recurso Explorer view, selecione o nome do Job, que é My Notebook Jobneste exemplo. Em seguida, clique no ícone play (implantado o pacote e executado o recurso ).

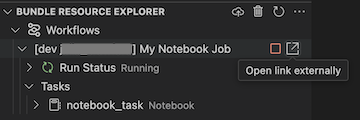

Para view o Job em execução, no Bundle recurso Explorer view, expanda o nome do Job, clique em Execution Status e, em seguida, clique no ícone do link (Open link externally ).

Validar e diagnosticar problemas no pipeline

Para um pipeline, o senhor pode acionar a validação e uma atualização parcial selecionando o ícone pipeline e, em seguida, o ícone de verificação (implantar o pacote e validar o pipeline ). Os eventos da execução são exibidos e todas as falhas podem ser diagnosticadas no painel PROBLEMAS do Visual Studio Code.

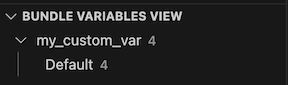

Visualização das variáveis do pacote

A visualização Bundle Variables (Variáveis do pacote ) view na extensão Databricks para Visual Studio Code exibe quaisquer variáveis personalizadas e configurações associadas definidas na configuração do pacote. O senhor também pode definir variáveis diretamente usando a visualização Bundles Variables (Variáveis de pacotes ). Esses valores substituem os definidos nos arquivos de configuração do pacote. Para obter informações sobre variáveis personalizadas, consulte Variáveis personalizadas.

Por exemplo, a visualização Bundle Variables (Variáveis do pacote) view na extensão exibiria o seguinte:

Para a variável my_custom_var definida nesta configuração de pacote:

variables:

my_custom_var:

description: 'Max workers'

default: '4'

resources:

jobs:

my_job:

name: my_job

tasks:

- task_key: notebook_task

job_cluster_key: job_cluster

notebook_task:

notebook_path: ../src/notebook.ipynb

job_clusters:

- job_cluster_key: job_cluster

new_cluster:

spark_version: 13.3.x-scala2.12

node_type_id: i3.xlarge

autoscale:

min_workers: 1

max_workers: ${var.my_custom_var}