Databricks 基盤モデル APIs

この記事では、Databricks の基盤モデル APIs の概要について説明します。 これには、使用要件、サポートされているモデル、および制限事項が含まれています。

Databricks 基盤モデル APIsとは

Databricks モデルサービングでは、サービスエンドポイントから最先端のオープンモデルにアクセスしてクエリを実行できる基盤モデル APIs がサポートされるようになりました。 基盤モデル APIsを使用すると、独自のモデルデプロイを維持することなく、高品質の生成 AI モデルを活用するアプリケーションを迅速かつ簡単に構築できます。

基盤モデル APIs は、次の 2 つの価格設定モードで提供されます。

支払い単位: これは、 Databricks上の基盤モデルへのアクセスを開始する最も簡単な方法であり、基盤モデルAPIsの使用を開始する場合にお勧めします。 このモードは、高スループット アプリケーションやパフォーマンスの本番運用ワークロード向けに設計されていません。

プロビジョニング スループット: このモードは、すべての本番運用ワークロード、特に高スループット、パフォーマンス保証、微調整されたモデルを必要とするワークロード、または追加のセキュリティ要件があるワークロードに推奨されます。 プロビジョニング スループット エンドポイントは、HIPPA などのコンプライアンス認定で利用できます。

これら 2 つのモードとサポートされているモデルの使用方法については、「基盤モデル APIsの使用」を参照してください。

プラットフォームAPIsを使用すると、次のことが可能になります。

クエリー より多くのリソースを投資する前にプロジェクトの妥当性を検証するための一般化されたLLM。

クエリー カスタムモデルのトレーニングとデプロイに投資する前に、LLMベースのアプリケーションの概念実証を迅速に作成するための一般化されたLLM。

基盤モデルとベクトルデータベースを使用して、検索拡張生成(RAG)を使用してチャットボットを構築します。

プロプライエタリなモデルをオープンな代替品に置き換えて、コストとパフォーマンスを最適化します。

LLMを効率的に比較して、ユースケースに最適な候補を確認したり、本番運用モデルをよりパフォーマンスの高いモデルと交換したりできます。

本番運用トラフィックの急増をサポートできるスケーラブルでSLAに裏打ちされたLLMサービスソリューションの上に、開発または本番運用用のLLMアプリケーションを構築します。

要件

エンドポイント要求を認証するための Databricks API トークン。

サーバレス コンピュート (プロビジョニングされたスループット モデルの場合)。

サポートされているリージョンのワークスペース:

注:

DBRX 基本モデルを使用するプロビジョニング スループット ワークロードについては、リージョンの可用性に関するインフラストラクチャAPIs制限を参照してください。

Foundation Model APIs を使用

プラットフォームAPIsを使用するには複数のオプションがあります。

APIs OpenAI と互換性があるため、クエリに OpenAI クライアントを使用することもできます。 サポートされているモデルをクエリするために、UI、基盤APIs Python SDK、MLflow Deployments SDK、または REST API を使用することもできます。 Databricks では、拡張対話には MLflow Deployments SDK または REST API を使用し、機能を試すには UI を使用することをお勧めします。

スコアリングの例については、 「クエリ基盤モデル」を参照してください。

Pay-per-token 基盤モデル APIs

プレビュー

この機能は パブリックプレビュー版です。

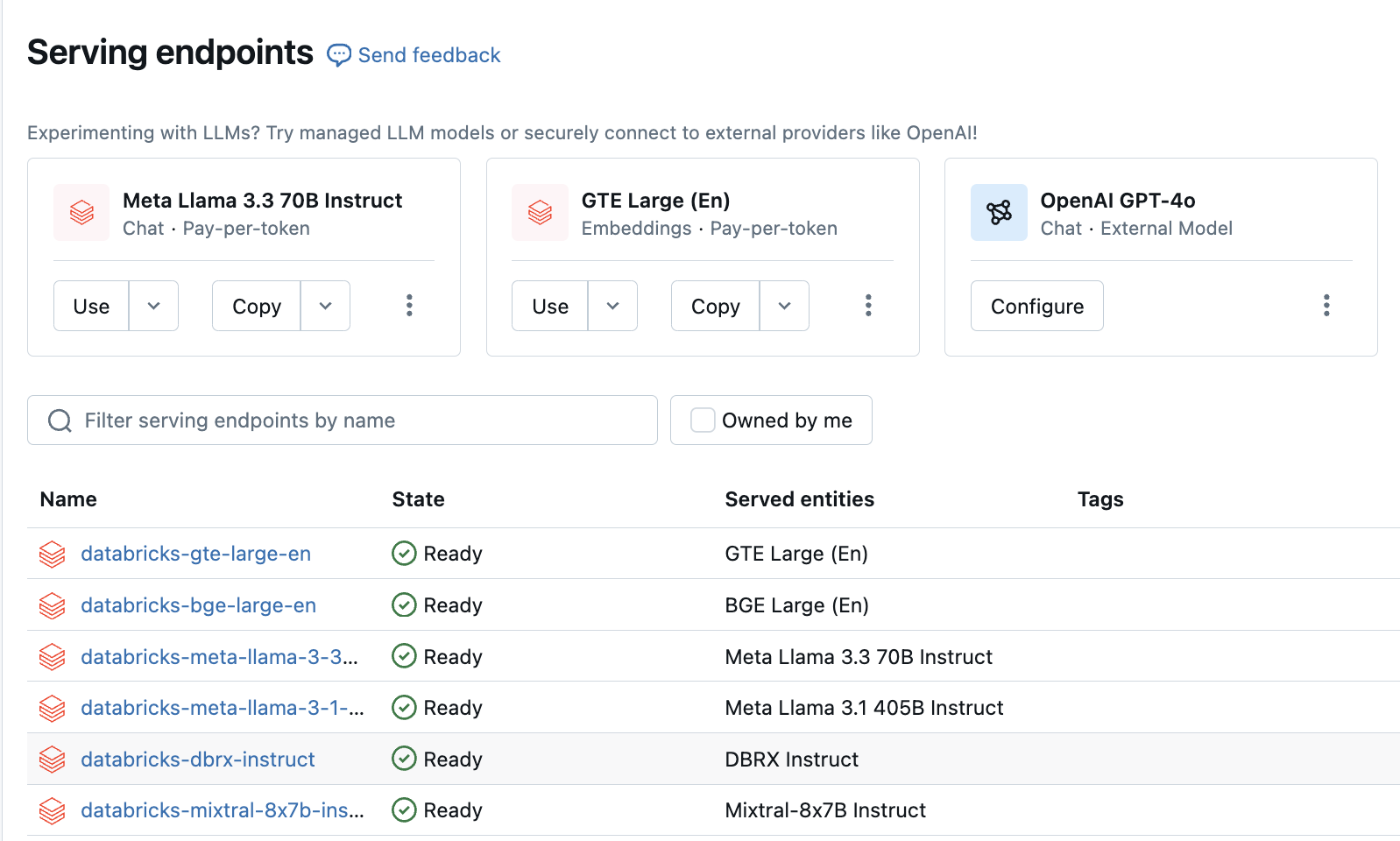

Pay-per-VPN モデルはDatabricksワークスペースからアクセスできるので、始めるのに推奨されます。 ワークスペースでこれらにアクセスするには、左側のサイドバーの[配信中]タブに移動します。 基盤モデルAPIsエンドポイント リスト ビューの上部にあります。

次の表は、トークンごとの支払いでサポートされているモデルをまとめたものです。 追加のモデル情報については「トークン単位の支払いでサポートされるモデル」を参照してください。

これらのモデルをテストしてチャットしたい場合は、 AI Playground使用して行うことができます。 「AI Playground を使用してサポートされている LLM とチャットする」を参照してください。

モデル |

タスクのタイプ |

エンドポイント |

|---|---|---|

DBRX Instruct |

Chat |

|

メタラマ-3-70B-指示 |

Chat |

|

メタラマ- 2 - 70B -チャット |

Chat |

|

Mixtral-8x7B Instruct |

Chat |

|

MPT 7B Instruct |

Completion |

|

MPT 30B Instruct |

Completion |

|

BGE Large (英語) |

Embeddings |

|

基盤モデル を照会する方法については 、「基盤モデルの照会」をAPIs 参照してください。

必要なパラメータと構文については、「プラットフォームモデル REST API リファレンス」を参照してください。

プロビジョニングされたスループットの基盤モデルAPIs

プロビジョニング スループットは一般提供されており、 Databricks本番運用ワークロードにはプロビジョニング スループットを推奨しています。 プロビジョニングされたスループットは、パフォーマンスの保証を必要とする基盤モデルのワークロードに対して最適化された推論をエンドポイントに提供します。 プロビジョニング全体モードで基盤モデルAPIsを展開する方法のステップバイステップ ガイドについては、「プロビジョニング スループット 基盤APIsを参照してください。

プロビジョニングされたスループットのサポートには、次のものが含まれます。

DBRX Base など、あらゆるサイズのベース モデル。基本モデルにはDatabricks Marketplace使用してアクセスすることも、 Hugging Faceまたは別の外部ソースからダウンロードしてUnity Catalogに登録することもできます。 後者のアプローチは、使用される微調整方法に関係なく、サポートされているモデルの微調整されたバリアントで機能します。

LlamaGuard-7Bなどのベースモデルの微調整されたバリエーション。これには、独自のデータで微調整されたモデルが含まれます。

ゼロからトレーニングされたもの、ベースモデルアーキテクチャ(CodeLlama、Yi-34B-Chat、SOLAR-10.7Bなど)を使用した継続的な事前トレーニングやその他のバリエーションなど、完全にカスタマイズされた重みとトークナイザー。

次の表は、プロビジョニングされたスループットでサポートされているモデル アーキテクチャをまとめたものです。

モデル アーキテクチャ |

タスクの種類 |

注 |

|---|---|---|

DBRXの |

Chat または Completion |

利用可能なリージョンについては、「プラットフォームモデルAPIs制限」を参照してください。 |

Llama 3 |

Chat または Completion |

|

Llama 2 |

Chat または Completion |

|

Mistral |

Chat または Completion |

|

Mixtral |

Chat または Completion |

|

MPT |

Chat または Completion |

|

BGE v1.5 (英語) |

Embeddings |

制限事項

「モデルサービングの制限と地域」を参照してください。