Databricks 基盤モデル API

この記事では、Databricksの基盤モデルAPIの概要を説明します。これには、使用要件、サポートされているモデル、および制限が含まれています。

Databricks基盤モデルAPIとは何ですか?

Mosaic AI Model Serving では、サービス エンドポイントから最先端のオープン モデルにアクセスしてクエリを実行できるようにする基盤モデル (API) がサポートされるようになりました。これらのモデルは Databricks によってホストされ、独自のモデルデプロイを維持することなく、それらを使用するアプリケーションを迅速かつ簡単に構築できます。 基盤モデル API は Databricks 指定 サービスであり、顧客コンテンツを処理する際に Databricks Geos を使用してデータ所在地を管理します。

基盤モデル API は、次のモードで提供されます。

- 当初単位の従量課金: これは、 Databricks上の基盤モデルへのアクセスを開始する最も簡単な方法であり、基盤モデルAPIsの使用を開始する場合にお勧めします。 このモードは高スループット アプリケーション向けに設計されていませんが、本番運用ワークロードに使用できます。

- プロビジョニングされたスループット:このモードは、すべての本番運用ワークロード、特に高スループット、パフォーマンス保証、ファインチューニングされたモデル、または追加のセキュリティ要件が必要なワークロードに推奨されます。プロビジョニングされたスループットエンドポイントは、HIPAAなどのコンプライアンス認証を取得して利用できます。

- AI Functions 最適化モデル: このモードは、バッチ推論ワークロードに推奨されます。任意の生成 を使用してバッチ推論を実行するか、AI MLを使用してAI Functions モデルを実行することを選択できます。

これらのモードとサポートされているモデルの使用方法に関するガイダンスについては、 基盤モデル APIの使用を参照してください。

基盤モデル API を使用すると、以下のことを行うことができます。

- 一般化された LLM をクエリして、より多くのリソースを投資する前にプロジェクトの有効性を確認します。

- 一般化された LLM に対してクエリを実行して、LLM ベースのアプリケーションの概念実証を迅速に作成してから、トレーニングとカスタム モデルのデプロイに投資します。

- 基盤モデルとベクトル インデックスを使用して、取得拡張生成 (RAG) を使用したチャットボットを構築します。

- 独自のモデルをオープンな代替モデルに置き換えて、コストとパフォーマンスを最適化します。

- LLMを効率的に比較して、ユースケースに最適な候補を見つけたり、本番運用モデルをパフォーマンスの高いモデルに交換したりできます。

- 開発用または本番運用のLLMアプリケーションを、SLAに裏打ちされたスケーラブルなLLMサービスソリューションの上に構築し、本番環境のトラフィックの急増に対応できます。

必要条件

- エンドポイント要求を認証するためのDatabricks APIトークン。

- サーバーレスコンピュート(プロビジョニングされたスループットモデル用)。

- 次のいずれかのサポートされているリージョンのワークスペース。

基盤モデル APIの利用

基盤モデルAPIを使用するには、複数の選択肢があります。

APIはOpenAIと互換性があるため、OpenAIクライアントを使用してクエリを実行できます。また、UI、基盤モデル APIのPython SDK、 MLflow Deployments SDK、またはサポートされているモデルのクエリの REST API で使用することもできます。 Databricks では、拡張インタラクションには OpenAI クライアント SDK または API を使用し、機能を試すには UI を使用することをお勧めします。

スコアリングの例については、「 基盤モデルを使用する 」を参照してください。

トークン単位の従量課金 基盤モデル API

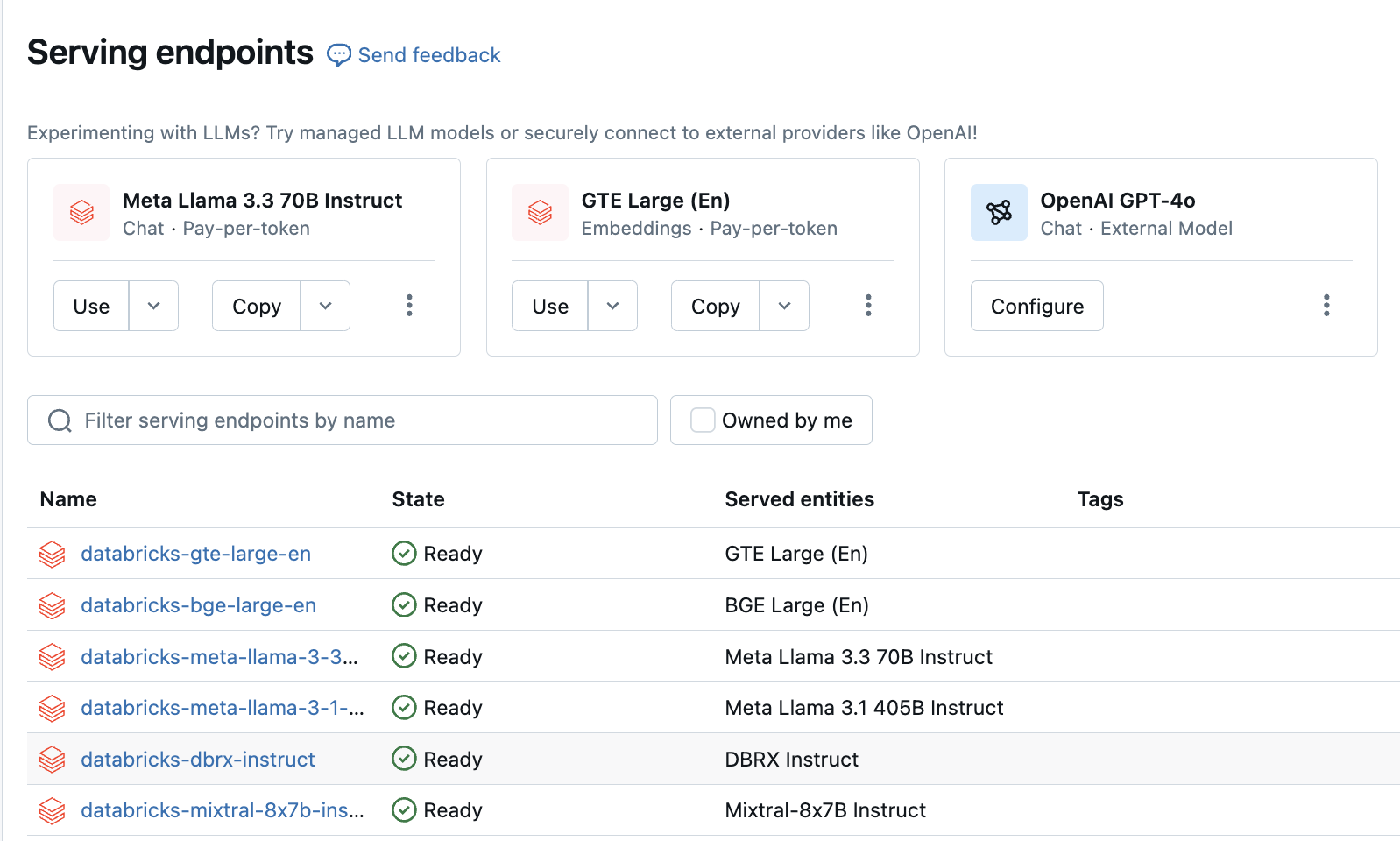

トークン単位の従量課金モデルを提供する事前設定されたエンドポイントには、 Databricks ワークスペースからアクセスできます。 これらのトークン単位の従量課金モデルは、作業を開始するために推奨されます。 ワークスペースでアクセスするには、左側のサイドバーの サービング タブに移動します。 基盤モデル API は、エンドポイント リスト ビューの上部にあります。

- サポートされているトークン単位の従量課金モデル。

- 基盤モデルAPIをクエリする方法については、基盤モデルの使用を参照してください。

- 必要なパラメーターと構文については、基盤モデル REST API リファレンス を参照してください。

プロビジョニングされたスループット 基盤モデル API

プロビジョニングされたスループットは、パフォーマンスの保証を必要とする基盤モデルのワークロードに対してエンドポイントに最適化された推論を提供します。Databricks本番運用ワークロードにはプロビジョニング スループットを推奨します。

- プロビジョニングされたスループットは、モデルアーキテクチャをサポートしました。

- プロビジョニング済みスループットモードで基盤モデルAPIをデプロイする方法の詳細なガイドについては、プロビジョニング済みスループットAPIを参照してください。

プロビジョニングされたスループットのサポートには以下が含まれます。

- すべてのサイズのベースモデル 。 ベースモデルには、 Databricks Marketplaceを使用してアクセスするか、 Hugging Face または別の外部ソースからダウンロードして Unity Catalogに登録することもできます。 後者のアプローチは、サポートされているモデルの微調整されたバリアントで機能します。

- 基本モデルの微調整されたバリアント (独自のデータに基づいて微調整されたモデルなど)。

- 完全にカスタマイズされた重みとトークナイザー (ゼロからトレーニングされたもの、または 基本モデル アーキテクチャ (CodeLlama) を使用して事前トレーニングされたものやその他のバリエーションなど)。

バッチ推論のためのAI関数

DatabricksのAI関数を使用したデータへのAIの適用 を参照してください。

AI Functionsを使用してバッチ推論パイプラインを作成する方法については、「バッチ推論パイプラインのデプロイ」を参照してください。

制限

基盤モデルAPIの制限を参照してください。