MLflow 3.0 generative fluxo de trabalho (Beta) AI

Beta

Esse recurso está na versão beta.

Exemplo de notebook

O exemplo do Notebook cria um agente, logs para MLflow, e avalia seu desempenho. O Notebook instala as bibliotecas databricks-langchain, databricks-agents, uv e langgraph==0.3.4. Este Notebook é uma adaptação do Notebook do agente de chamadas da ferramenta LangGraph. Para obter exemplos adicionais do Notebook e mais detalhes sobre como criar agentes, consulte Autor AI agents in code.

MLflow 3.0 Criar e avaliar um agente generativo AI Notebook

Explore o desempenho do agente usando a UI do MLflow

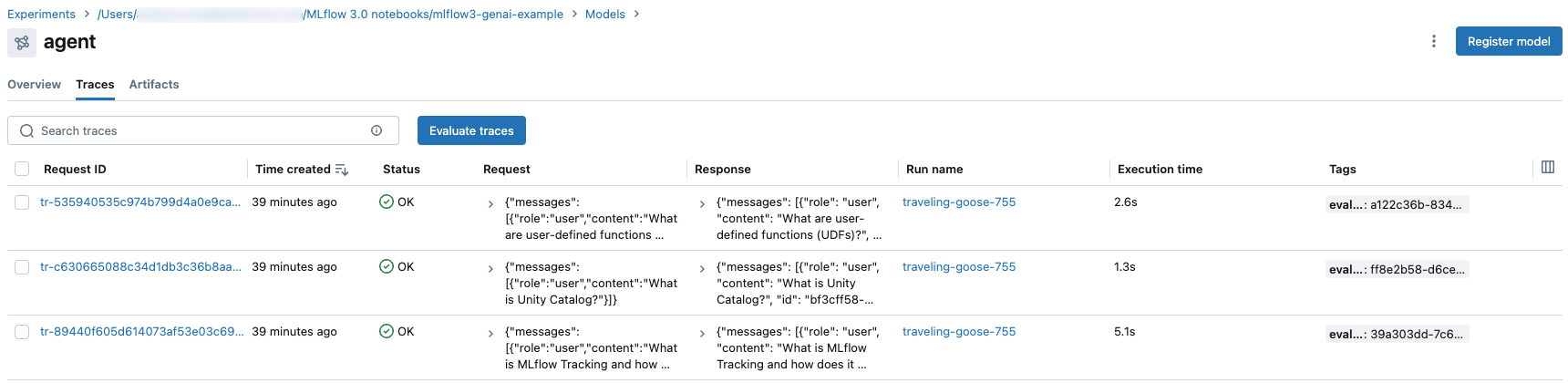

O código do Notebook executa um teste inicial, consultando a cadeia para garantir que ela funcione bem o suficiente para testes adicionais. Os rastreamentos desse teste estão disponíveis na interface do usuário MLflow na página de detalhes do modelo, em Traces tab.

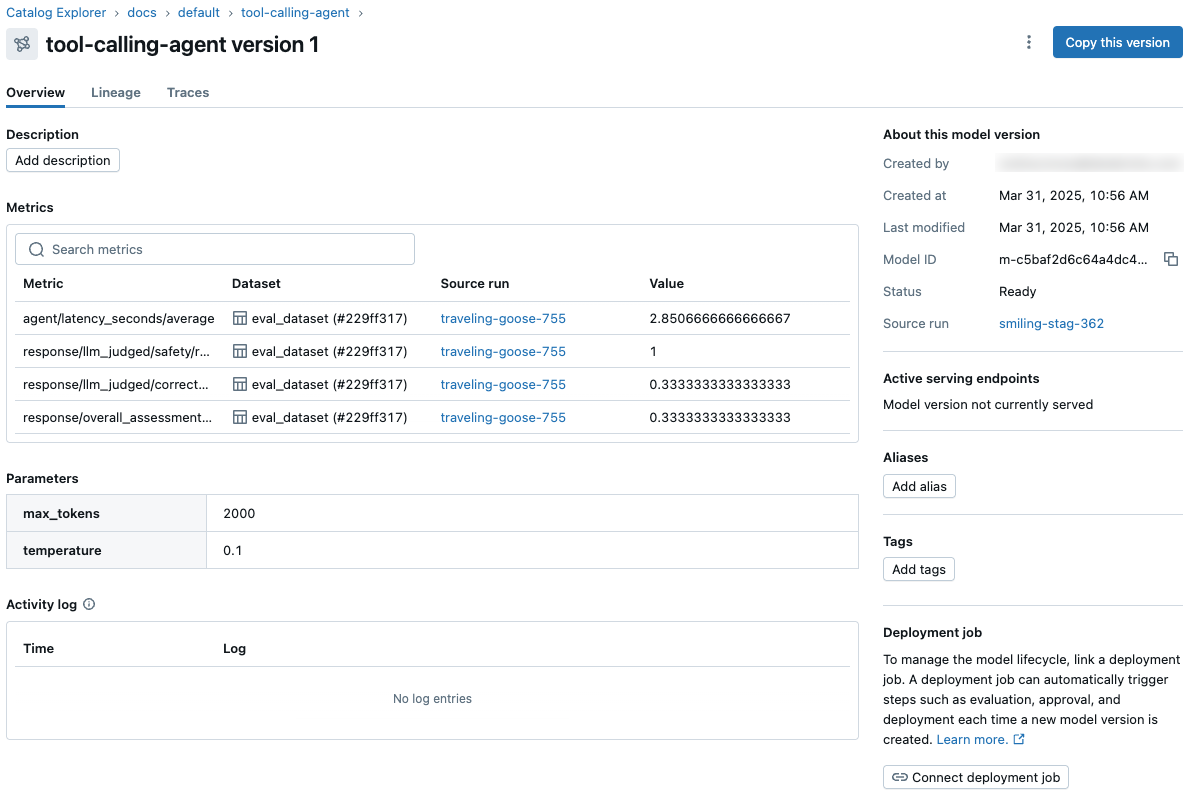

A execução da avaliação no exemplo do Notebook produz duas execuções MLflow, uma MLflow LoggedModel e traços da consulta e da avaliação interativas. Todas as métricas de avaliação do agente são exibidas na página de detalhes do modelo do experimento MLflow.

A ID do modelo e os parâmetros e métricas do modelo também são exibidos na página da versão do modelo do Unity Catalog.

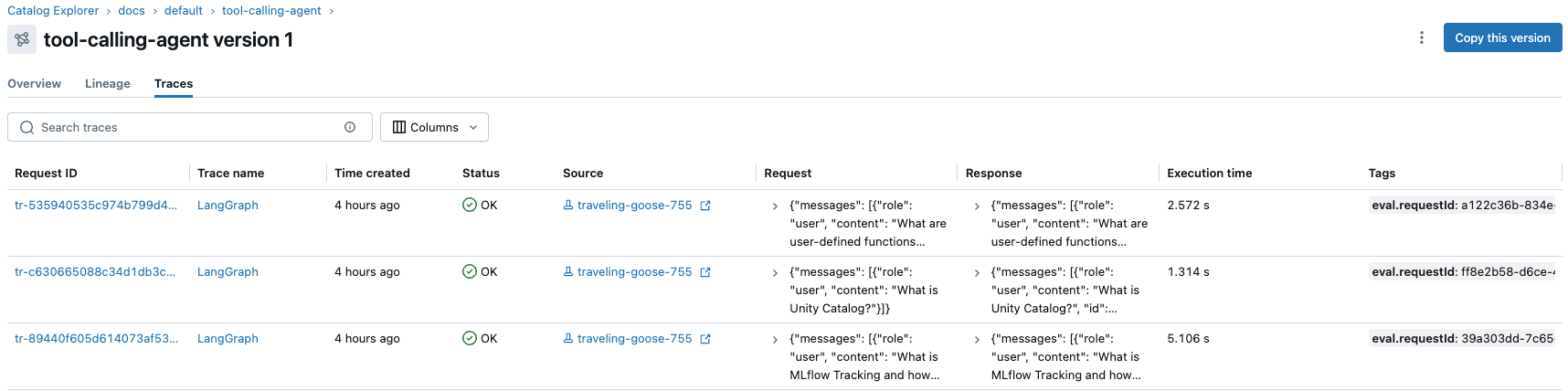

Agora, o senhor pode usar o Mosaic AI Model Serving para servir esse modelo a um endpoint ativo que pode ser incorporado a qualquer aplicativo. Os rastreamentos de invocações on-line do serviço endpoint também são registrados em Traces tab da versão do modelo Unity Catalog, juntamente com todos os rastreamentos off-line da fase de desenvolvimento. Veja implantado um agente para aplicativos generativos AI.

Rastreamento de MLflow e feedback com agentes de chamadas de ferramentas

Este breve tutorial demonstra como o MLflow pode capturar traços detalhados de um agente de chamada de ferramenta LangChain à medida que ele resolve problemas matemáticos. Ele ilustra a capacidade do MLflow de rastrear a execução do agente e armazenar feedback sobre a resposta do agente. O feedback, que é registrado por meio do site log_feedback API, é muito útil para medir e melhorar a qualidade de um agente.

MLflow 3.0 rastreamento e feedback com um Notebook de agente de chamadas de ferramentas

Mais informações

Consulte as páginas a seguir para obter informações adicionais:

- executar uma avaliação e view os resultados

- Monitorar aplicativos implantados usando o Agent Framework

- Observabilidade do agente com o MLflow Tracing

- modelos implantados usando Mosaic AI Model Serving

Qual é a diferença entre os Models tab na página de experimentos MLflow e a página da versão do modelo no Catalog Explorer?

A página Models tab da página do experimento e a página da versão do modelo no Catalog Explorer mostram informações semelhantes sobre o modelo. As duas visualizações têm funções diferentes no ciclo de vida do desenvolvimento e da implantação do modelo.

- A página Models tab da página do experimento apresenta os resultados dos modelos registrados de um experimento em uma única página. O site Charts tab nesta página fornece visualizações para ajudá-lo a comparar modelos e selecionar as versões do modelo a serem registradas em Unity Catalog para possível implementação.

- No Catalog Explorer, a página da versão do modelo oferece uma visão geral de todos os resultados de desempenho e avaliação do modelo. Essa página mostra os parâmetros do modelo, as métricas e os rastreamentos em todos os ambientes vinculados, incluindo diferentes espaços de trabalho, pontos de extremidade e experimentos. Isso é útil para monitoramento e implementação e funciona especialmente bem com o Job de implementação. A tarefa de avaliação em um Job de implantação cria métricas adicionais que aparecem nesta página. O aprovador do trabalho pode então revisar essa página para avaliar se deve aprovar a versão do modelo para implementação.

Próximas etapas

Para saber mais sobre o LoggedModel acompanhamento introduzido no MLflow 3.0, consulte os artigos a seguir:

Para saber mais sobre o uso do MLflow 3.0 com outros fluxos de trabalho, consulte os artigos a seguir: