Fornecer e acessar o uso faturável logs (legado)

Visualização

Esse recurso está em Public Preview.

Uso faturável logs não registra o uso de todos os produtos. Databricks recomenda o uso de tabelas do sistema para view uso completo logs.

Como administrador do Databricks account , o senhor pode configurar a entrega diária do registro de uso faturável no formato de arquivo CSV para um bucket de armazenamento AWS S3 , onde pode disponibilizar os dados para análise de uso. Databricks entrega um arquivo CSV separado para cada workspace em seu account. Esse arquivo CSV inclui dados históricos sobre o uso de clustering da workspace em Databricks Units (DBUs), classificáveis por ID de clustering, faturamento SKU, criador do clustering, Cluster Tag e muito mais. Para obter uma descrição de cada coluna do arquivo CSV, consulte o esquema do arquivo CSV.

Para usar um API para download o billable usage logs sem configurar a entrega log, consulte Return billable usage logs.

Os administradores de conta podem view o uso em forma de gráfico ou tabela na página Usage (Uso) no console account. Essa página também inclui um gráfico de uso que exibe o uso do account em DBUs, agrupado por tipo de carga de trabalho, e permite que o senhor acesse diretamente os dados de uso do download no formato CSV.

Se o seu account estiver em outra versão da plataforma, os proprietários do account podem view usar a Visão geral de uso do console account legado tab.

Você pode, se desejar, enviar os logs para uma conta da AWS que seja diferente da conta utilizada para o IAM role criado para a entrega dos logs.Isso permite flexibilidade, por exemplo, configurar workspace de várias account da AWS para entregar no mesmo bucket do S3. Essa opção requer que você configure uma política de bucket do S3 que faça referência a umaIAM role entre account. Instruções e um modelo de política são fornecidos neste artigo.

O proprietário da conta e o acesso de administrador do account ao logs dependem de como o senhor configurou o bucket S3. Databricks entrega logs para o seu S3 bucket com AWS's integrada BucketOwnerFullControl Canned ACL para que account proprietários e designados possam download o logs diretamente. Para oferecer suporte à propriedade do bucket para objetos recém-criados, o senhor deve definir a configuração S3 Object Ownership do seu bucket como o valor Bucket owner preferred .

Se, em vez disso, o usuário definir a configuração S3 Object Ownership do seu bucket como Object writer , os novos objetos, como o logs, continuarão pertencendo ao upload account, que é default o IAM role que o usuário criou e especificou para acessar o bucket. Isso pode dificultar o acesso aos logs, pois não é possível acessá-los no console do AWS ou nas ferramentas de automação com as quais o usuário se autenticou como proprietário do bucket.

O Databricks recomenda que você revise as Práticas recomendadas de segurança para o S3 para obter orientação sobre como proteger os dados em seu bucket contra acesso indesejado.

Além da entrega de logs para workspaces em execução, os logs são entregues para workspaces cancelados para garantir que os logs sejam entregues adequadamente e representem o último dia do workspace.

Opções de configuração

Ao configurar a entrega do log de uso faturável, você terá as seguintes opções se tiver vários workspaces em sua conta:

- Compartilhe a mesma configuração (papel S3 de entrega de logs e IAM) para todos os workspaces na conta. Este é o padrão.

- Use configurações separadas para cada workspace da conta.

- Use configurações separadas para diferentes grupos de workspaces, cada um compartilhando uma configuração.

Mesmo que você use a API de conta para configurar a entrega de log, você pode configurar a entrega de log com qualquer workspace, incluindo workspaces que não foram criados usando a API de conta.

Fluxo de alto nível

O fluxo de alto nível da entrega do registro de uso faturável:

- Configure o armazenamento: No AWS, crie um novo bucket do AWS S3. Usando Databricks APIs, chame a conta API para criar um objeto de configuração de armazenamento que use o nome do bucket.

Para entregar logs a uma conta da AWS que não seja aquela usada para a função IAM criada para entrega de logs, você precisa adicionar uma política ao bucket S3.Você não adiciona a política nesta passo, mas em uma passo posterior.

-

Configure as credenciais: Em AWS, crie as credenciais apropriadas AWS IAM role. Usando Databricks APIs, chame a conta API para criar um objeto de configuração de credenciais que use o IAM role's ARN. A política de função pode especificar um prefixo de caminho para a entrega de log dentro do seu bucket S3. O senhor pode optar por definir um IAM role para incluir vários prefixos de caminho se quiser configurações de entrega log para diferentes espaços de trabalho que compartilham o bucket S3, mas usam prefixos de caminho diferentes.

-

Suporte cruzado opcionalaccount Para entregar logs a um AWS account que não seja o account do IAM role que o senhor criou para entrega log, adicione uma política de bucket S3. Essa política faz referência a IDs para o siteaccount IAM role que o senhor criou na etapa anterior.

-

Chame a entrega log API : Chame a conta API para criar uma configuração de entrega log que use os objetos de configuração de credenciais e armazenamento das etapas anteriores. Essa etapa permite que o senhor especifique se deseja associar a configuração de entrega do log para todo o account (espaço de trabalho atual e futuro) ou para um conjunto específico de espaços de trabalho.

-

Acesse os arquivos CSV para análise: O local de entrega é

<bucket-name>/<prefix>/billable-usage/csv/, onde<prefix>é o nome do prefixo do caminho de entrega opcional que o senhor definiu durante a configuração de entrega log. Os arquivos são chamados deworkspaceId=<workspace-id>-usageMonth=<month>.csv. Os arquivos são entregues diariamente, sobrescrevendo o arquivo CSV do mês para cada workspace. O senhor pode importar esses dados para o Databricks para análise. Há também um exemplo de Notebook que o senhor pode usar para executar um painel de análise de uso com base nesses arquivos CSV. Consulte Analisar dados de uso no Databricks.

Existe um limite para o número de configurações de entrega de logs que você pode criar para uma conta. você pode criar no máximo duas configurações habilitadas que usam o nível de conta (sem filtro de workspace) e duas configurações habilitadas para cada workspace específico (pode ocorrer um workspaceId no filtro de workspace para duas configurações). você não pode excluir uma configuração de fornecimento de log, mas pode desativá-la. Você pode reativar uma configuração desativada, mas a solicitação falhará se violar os limites descritos anteriormente.

Requisitos

- Você deve ser um administrador de conta

- ID da conta. O ID do account pode ser encontrado no consoleaccount.

Como fazer a autenticação na conta API

Para se autenticar na conta API, o senhor pode usar Databricks OAuth para entidade de serviço ou Databricks OAuth para usuários. Databricks Recomendamos enfaticamente que o senhor use o site Databricks OAuth para usuários ou entidades de serviço. Uma entidade de serviço é uma identidade que o senhor cria em Databricks para uso com ferramentas, trabalhos e aplicativos automatizados. Consulte Autorizar o acesso da entidade de serviço ao Databricks com o OAuth.

Use os exemplos a seguir para se autenticar em um site Databricks account. O senhor pode usar OAuth para entidade de serviço ou OAuth para usuários. Para obter informações básicas, consulte:

- Para OAuth para entidade de serviço, consulte Autorizar o acesso da entidade de serviço a Databricks com OAuth.

- Para obter informações sobre OAuth para usuários, consulte Autorizar acesso do usuário ao Databricks com OAuth.

A autenticação básica usando um nome de usuário e senha da Databricks chegou ao fim da vida útil em 10 de julho de 2024. Consulte End of life para Databricks-gerenciar senhas.

Para exemplos de autenticação, escolha uma das seguintes opções:

- OAuth for service principals

- OAuth for users

-

Instale o site Databricks CLI versão 0.205 ou acima. Consulte Instalar ou atualizar a CLI da Databricks.

-

Conclua as etapas para configurar a autenticação OAuth M2M para a entidade de serviço em account. Consulte Autorizar o acesso da entidade de serviço ao Databricks com o OAuth.

-

Identifique ou crie manualmente um perfil de configuração do Databricks em seu arquivo

.databrickscfg, com os campos do perfil definidos corretamente para os mapeamentos relacionadoshost,account_id,client_ideclient_secretpara a entidade de serviço. Consulte a autenticação OAuth máquina a máquina (M2M). -

Execute o comando Databricks CLI de destino, onde

<profile-name>representa o nome do perfil de configuração no arquivo.databrickscfg:Bashdatabricks account <command-name> <subcommand-name> -p <profile-name>Por exemplo, para listar todos os usuários na conta:

Bashdatabricks account users list -p MY-AWS-ACCOUNT- Para obter uma lista de comandos de conta disponíveis, execute o comando

databricks account -h. - Para obter uma lista de subcomandos disponíveis para um comando de conta, execute o comando

databricks account <command-name> -h.

- Para obter uma lista de comandos de conta disponíveis, execute o comando

-

Instale o site Databricks CLI versão 0.205 ou acima. Consulte Instalar ou atualizar a CLI da Databricks.

-

Conclua as etapas para configurar a autenticação U2M d OAuth para usuários no account. Consulte Autorizar acesso do usuário ao Databricks com OAuth.

-

Inicie o processo de autenticação do usuário executando o seguinte comando Databricks CLI:

Bashdatabricks auth login --host <account-console-url> --account-id <account-id>Por exemplo:

Bashdatabricks auth login --host https://accounts.cloud.databricks.com --account-id 00000000-0000-0000-0000-000000000000

Se o senhor tiver um perfil de configuração do Databricks existente com os campos host e account_id já definidos, poderá substituir --host <account-console-url> --account-id <account-id> por --profile <profile-name>.

-

Siga as instruções na tela para que a CLI do Databricks crie automaticamente o perfil de configuração do Databricks relacionado em seu arquivo

.databrickscfg. -

Continue seguindo as instruções que aparecem na tela para acessar a sua conta Databricks através do seu navegador da web.

-

Execute o comando Databricks CLI de destino, onde

<profile-name>representa o nome do perfil de configuração no arquivo.databrickscfg:Bashdatabricks account <command-name> <subcommand-name> -p <profile-name>Por exemplo, para listar todos os usuários na conta:

Bashdatabricks account users list -p ACCOUNT-00000000-0000-0000-0000-000000000000- Para obter uma lista de comandos de conta disponíveis, execute o comando

databricks account -h. - Para obter uma lista de subcomandos disponíveis para um comando de conta, execute o comando

databricks account <command-name> -h.

- Para obter uma lista de comandos de conta disponíveis, execute o comando

Etapa 1: configurar o armazenamento

O Databricks entrega os dados de uso faturáveis para um bucket S3 na sua conta. Você pode configurar vários workspaces para usar um único bucket do S3 ou pode definir diferentes workspaces (ou grupos de workspaces) para usar buckets diferentes.

Este procedimento explica como criar um único objeto de configuração com uma configuração comum para um ou mais workspaces na conta.Para usar locais de armazenamento diferentes para diferentes workspaces, repita os procedimentos neste artigo para cada workspace ou grupo de workspaces.

- Crie o bucket S3, seguindo as instruções na Etapa 1: Configurar o armazenamento de auditoria log.

Para entregar logs a um AWS account diferente do usado para seu Databricks workspace, o senhor deve adicionar uma política de bucket S3. Você não adiciona a política de bucket nesta etapa. Consulte a Etapa 3: Suporte cruzado opcional -account.

-

Crie um registro de configuração de armazenamento do Databricks que represente seu novo bucket S3. Especifique seu bucket S3 chamando a API de criação de nova configuração de armazenamento (

POST /accounts/<account-id>/storage-configurations).Passe o seguinte:

storage_configuration_name— Novo nome de configuração de armazenamento exclusivo.root_bucket_info— Um objeto JSON que contém um campobucket_nameque contém seu nome do contêiner S3.

Copie o valor

storage_configuration_idretornado no corpo da resposta. Você o usará para criar a configuração de entrega logs em uma passo posterior.Por exemplo:

Bashcurl -X POST

'https://accounts.cloud.databricks.com/api/2.0/accounts/<databricks-account-id>/storage-configurations' \

--header 'Authorization: Bearer $OAUTH_TOKEN' \

-d '{

"storage_configuration_name": "databricks-workspace-storageconf-v1",

"root_bucket_info": {

"bucket_name": "my-company-example-bucket"

}

}'Resposta:

JSON{

"storage_configuration_id": "<databricks-storage-config-id>",

"account_id": "<databricks-account-id>",

"root_bucket_info": {

"bucket_name": "my-company-example-bucket"

},

"storage_configuration_name": "databricks-workspace-storageconf-v1",

"creation_time": 1579754875555

}

Etapa 2: Configurar credenciais

Este procedimento explica como criar um único objeto de configuração com uma configuração comum para um ou mais workspaces na conta.Para usar credenciais diferentes para workspaces diferentes, repita os procedimentos deste artigo para cada workspace ou grupo de workspaces.

Para usar nomes de bucket S3 diferentes, você precisa criar IAM roles separados.

-

Faça login no console da AWS como usuário com privilégios de administrador e acesse o serviço IAM .

-

Clique na guia Funções na barra lateral.

-

Clique em Criar função .

-

Em Selecionar tipo de entidade confiável , clique em Serviço AWS .

-

Em Casos de uso comuns , clique em EC2 .

-

Clique no botão Seguinte: Permissões .

-

Clique no botão Avançar: tags .

-

Clique no botão Próximo: Revisão .

-

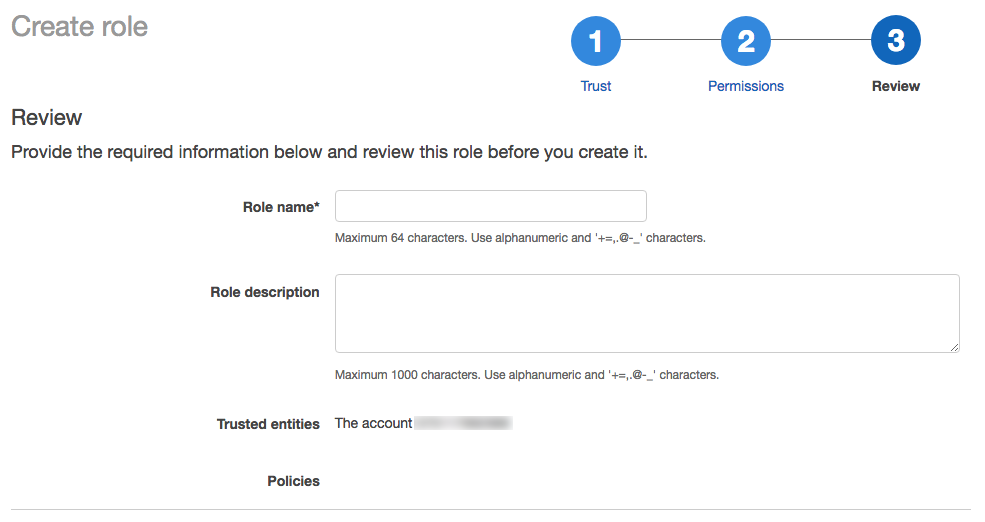

No campo Nome da função , insira um nome de papel.

-

Clique em Criar papel . A lista de funções é exibida.

-

-

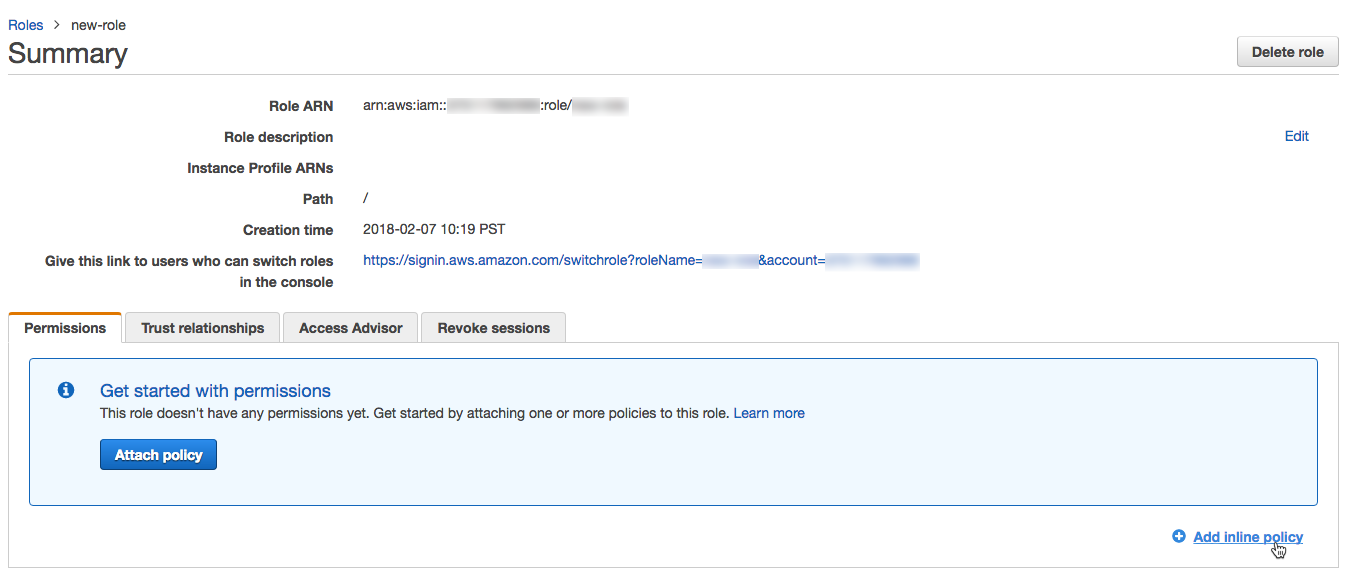

Na lista de funções, selecione a função que você criou.

-

Adicione uma política em linha.

-

Na guia Permissões, clique em Adicionar política em linha .

-

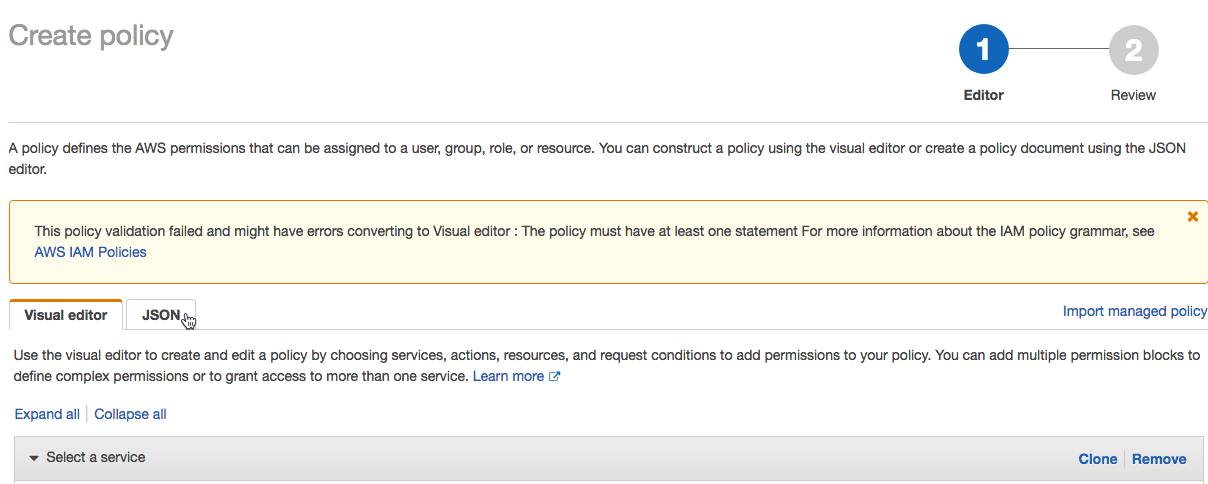

No editor de políticas, clique na guia JSON .

-

Copie essa política de acesso e modifique-a. Substitua os valores a seguir na política pelos seus próprios valores de configuração:

<s3-bucket-name>: o nome do bucket do seu balde AWS S3.<s3-bucket-path-prefix>(Opcional) O caminho para o local de entrega no bucket S3. Se não for especificado, os logs serão entregues na raiz do bucket. Esse caminho deve corresponder ao argumentodelivery_path_prefixquando o senhor chamar a API de fornecimento de log.

JSON{

"Version": "2012-10-17",

"Statement": [

{

"Effect": "Allow",

"Action": ["s3:GetBucketLocation"],

"Resource": ["arn:aws:s3:::<s3-bucket-name>"]

},

{

"Effect": "Allow",

"Action": ["s3:PutObject", "s3:GetObject", "s3:DeleteObject", "s3:PutObjectAcl", "s3:AbortMultipartUpload"],

"Resource": [

"arn:aws:s3:::<s3-bucket-name>/<s3-bucket-path-prefix>/",

"arn:aws:s3:::<s3-bucket-name>/<s3-bucket-path-prefix>/*"

]

},

{

"Effect": "Allow",

"Action": ["s3:ListBucket", "s3:ListMultipartUploadParts", "s3:ListBucketMultipartUploads"],

"Resource": "arn:aws:s3:::<s3-bucket-name>",

"Condition": {

"StringLike": {

"s3:prefix": ["<s3-bucket-path-prefix>", "<s3-bucket-path-prefix>/*"]

}

}

}

]

}Você pode personalizar o uso da política do prefixo do caminho:

- Se você não quiser usar o prefixo do caminho do contêiner, remova

<s3-bucket-path-prefix>/(incluindo a barra final) da política toda vez que ela aparecer. - Se desejar configurações de entrega de log para diferentes workspaces que compartilham o bucket S3, mas usam prefixos de caminho diferentes, você pode definir um IAM role para incluir vários prefixos de caminho. Existem duas partes separadas da política que fazem referência a

<s3-bucket-path-prefix>. Em cada caso, duplique as duas linhas adjacentes que fazem referência ao prefixo do caminho. Repita cada par de linhas para cada novo prefixo de caminho, por exemplo:

JSON{

"Resource": [

"arn:aws:s3:::<mybucketname>/field-team/",

"arn:aws:s3:::<mybucketname>/field-team/*",

"arn:aws:s3:::<mybucketname>/finance-team/",

"arn:aws:s3:::<mybucketname>/finance-team/*"

]

} -

Clique em Revisar política .

-

No campo Nome , insira um nome de política.

-

Clique em Criar política .

-

Se o senhor usar políticas de controle de serviços para negar determinadas ações no nível AWS account , certifique-se de que

sts:AssumeRoleesteja na lista de permissões para que Databricks possa assumir a função cruzadaaccount.

-

-

Na página de resumo do papel, clique na guia Relacionamentos de Confiança .

-

Cole essa política de acesso no editor e substitua os seguintes valores na política pelos seus próprios valores de configuração. A política usa o endereço Databricks AWS account ID

414351767826. Se o senhor estiver usando Databricks on AWS GovCloud use o Databricks account ID044793339203para AWS GovCloud ou170661010020para AWS GovCloud DoD.<databricks-account-id>: ID da sua conta do Databricks.JSON{

"Version": "2012-10-17",

"Statement": [

{

"Effect": "Allow",

"Principal": {

"AWS": "arn:aws:iam::414351767826:role/SaasUsageDeliveryRole-prod-IAMRole-3PLHICCRR1TK"

},

"Action": "sts:AssumeRole",

"Condition": {

"StringEquals": {

"sts:ExternalId": ["<databricks-account-id>"]

}

}

}

]

} -

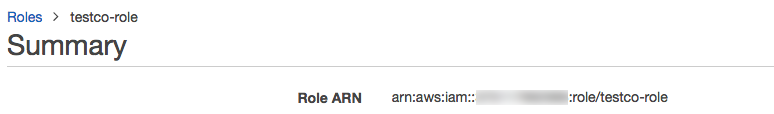

No resumo da função, copie o ARN da função e salve-o para uma etapa posterior.

-

Crie um ID de configuração de credenciais do Databricks para sua função do AWS. Chame a API Create credential configuration (

POST /accounts/<account-id>/credentials). Essa solicitação estabelece a confiança entreaccount e retorna um ID de referência a ser usado quando o senhor criar um novo workspace.Substitua

<account-id>pelo ID da sua account do Databricks. No corpo da solicitação:- Defina

credentials_namepara um nome exclusivo na sua conta. - Defina

aws_credentialscomo um objeto que contém uma propriedadests_role. Esse objeto deve especificar orole_arnpara a função que você criou.

O corpo da resposta incluirá um campo

credentials_id, que é a ID de configuração de credenciais do Databricks que você precisa para criar o novo workspace. Copie este campo para poder usá-lo para criar a configuração de entrega logs em uma passo posterior.Por exemplo:

Bashcurl -X POST

'https://accounts.cloud.databricks.com/api/2.0/accounts/<databricks-account-id>/credentials' \

--header 'Authorization: Bearer $OAUTH_TOKEN' \

-d '{

"credentials_name": "databricks-credentials-v1",

"aws_credentials": {

"sts_role": {

"role_arn": "arn:aws:iam::<aws-account-id>:role/my-company-example-role"

}

}

}'Resposta de exemplo:

JSON{

"credentials_id": "<databricks-credentials-id>",

"account_id": "<databricks-account-id>",

"aws_credentials": {

"sts_role": {

"role_arn": "arn:aws:iam::<aws-account-id>:role/my-company-example-role",

"external_id": "<databricks-account-id>"

}

},

"credentials_name": "databricks-credentials-v1",

"creation_time": 1579753556257

}Copie o campo

credentials_idda resposta para uso posterior. - Defina

Etapa 3: Suporte cruzado opcional -account

Caso seu bucket do S3 estiver na mesma account da AWS que a IAM role usada para entrega logs, pule esta passo.

Para encaminhar os logs para uma conta da AWS que não seja a mesma da conta utilizada para a função IAM criada para a entrega de logs, adicione a política do bucket S3 mostrada abaixo.Esta política faz referência a IDs para o IAM role entre a conta que você criou na etapa anterior.

-

No Console da AWS, acesse o serviço S3.

-

Clique no nome do bucket.

-

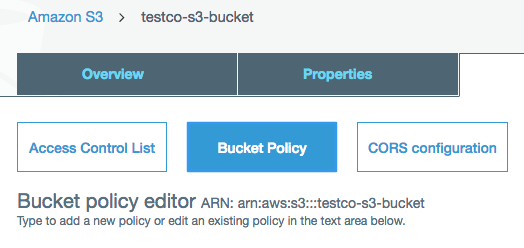

Clique na guia Permissões .

-

Clique no botão Política de bucket .

-

Copie e modifique esta política de bucket.

Substitua

<s3-bucket-name>pelo nome do bucket S3. Substitua<customer-iam-role-id>pelo ID do IAM role recém-criada. Substitua<s3-bucket-path-prefix>pelo prefixo do caminho do bucket desejado. Consulte as notas após o exemplo de política para obter informações sobre como personalizar o prefixo do caminho.JSON{

"Version": "2012-10-17",

"Statement": [

{

"Effect": "Allow",

"Principal": {

"AWS": ["arn:aws:iam::<customer-iam-role-id>"]

},

"Action": "s3:GetBucketLocation",

"Resource": "arn:aws:s3:::<s3-bucket-name>"

},

{

"Effect": "Allow",

"Principal": {

"AWS": "arn:aws:iam::<customer-iam-role-id>"

},

"Action": [

"s3:PutObject",

"s3:GetObject",

"s3:DeleteObject",

"s3:PutObjectAcl",

"s3:AbortMultipartUpload",

"s3:ListMultipartUploadParts"

],

"Resource": [

"arn:aws:s3:::<s3-bucket-name>/<s3-bucket-path-prefix>/",

"arn:aws:s3:::<s3-bucket-name>/<s3-bucket-path-prefix>/*"

]

},

{

"Effect": "Allow",

"Principal": {

"AWS": "arn:aws:iam::<customer-iam-role-id>"

},

"Action": "s3:ListBucket",

"Resource": "arn:aws:s3:::<s3-bucket-name>",

"Condition": {

"StringLike": {

"s3:prefix": ["<s3-bucket-path-prefix>", "<s3-bucket-path-prefix>/*"]

}

}

}

]

}Você pode personalizar o uso da política do prefixo do caminho:

-

Se você não quiser usar o prefixo do caminho do contêiner, remova

<s3-bucket-path-prefix>/(incluindo a barra final) da política toda vez que ela aparecer. -

Se você deseja configurar a entrega de logs para vários workspaces que compartilham o mesmo bucket S3, mas usam diferentes prefixos de caminho, é possível definir um IAM role que inclua múltiplos prefixos de caminho. Duas partes da referência política

<s3-bucket-path-prefix>. Em cada local, duplique as duas linhas adjacentes que fazem referência ao prefixo do caminho. Repita cada par de linhas para cada novo prefixo de caminho. Por exemplo:JSON{

"Resource": [

"arn:aws:s3:::<mybucketname>/field-team/",

"arn:aws:s3:::<mybucketname>/field-team/*",

"arn:aws:s3:::<mybucketname>/finance-team/",

"arn:aws:s3:::<mybucketname>/finance-team/*"

]

}

-

Etapa 4: Ligue para a entrega do log API

Para configurar o fornecimento de log, chame a configuração de fornecimento de log API (POST /accounts/<account-id>/log-delivery).

Você precisa dos seguintes valores que você copiou nas passos anteriores:

credentials_id: Seu ID de configuração de credenciais do Databricks, que representa suas credenciais de função entre contas.storage_configuration_id: Seu ID de configuração de armazenamento do Databricks, que representa seu contêiner raiz S3.

Defina também os seguintes campos:

-

log_type: Sempre definido comoBILLABLE_USAGE. -

output_format: Sempre definido comoCSV. Para obter detalhes sobre o formato de arquivo CSV, consulte Billable usage log schema (legacy). -

delivery_path_prefix: (Opcional) Defina como o prefixo do caminho. Isso deve corresponder ao prefixo do caminho que você usou em sua política de função. -

workspace_ids_filter: (Opcional) Por padrão, essa configuração de log se aplica a todos os workspaces associados ao ID da conta. Para alguns tipos de implementações, há apenas um workspace por ID de conta, portanto, esse campo é desnecessário. Se a sua conta foi criada originalmente para a criação de workspaces com a API da conta, você pode ter vários workspaces associados ao seu ID de conta. Opcionalmente, você pode definir esse campo para uma matriz de IDs do workspace às quais essa configuração se aplica. Se você planeja usar configurações de entrega de logs diferentes para diferentes workspaces, defina isso de forma explícita, em vez de deixar em branco.Se você deixar isso em branco e o ID da conta estiver associado no futuro a workspaces adicionais, essa configuração também se aplicará aos novos workspaces. Uma área de trabalho pode se aplicar a mais de uma configuração de entrega de log, caso em que os logs são gravados em vários locais.

Existe um limite para o número de configurações de entrega de logs que você pode criar para uma conta. você pode criar no máximo duas configurações habilitadas que usam o nível de conta (sem filtro de workspace) e duas configurações habilitadas para cada workspace específico (pode ocorrer um workspaceId no filtro de workspace para duas configurações). você não pode excluir uma configuração de fornecimento de log, mas pode desativá-la. Você pode reativar uma configuração desativada, mas a solicitação falhará se violar os limites descritos anteriormente.

delivery_start_time: (Opcional) o mês e o ano em que a entrega de log começa. O padrão é o mês atual. O formato é texto no formatoYYYY-MM. Você pode inserir qualquer mês e ano a partir de 2019-03.

Por exemplo:

curl -X POST

'https://accounts.cloud.databricks.com/api/2.0/accounts/<databricks-account-id>/log-delivery' \

--header 'Authorization: Bearer $OAUTH_TOKEN' \

-d '{

"log_delivery_configuration": {

"log_type": "BILLABLE_USAGE",

"config_name": "billable usage config",

"output_format": "CSV",

"credentials_id": "<databricks-credentials-id>",

"storage_configuration_id": "<databricks-storage-config-id>",

"delivery_path_prefix": "usage-data",

"delivery_start_time": "2020-06",

"workspace_ids_filter": [

6383650456894062,

4102272838062927

]

}

}'

Resposta de exemplo:

{

"log_delivery_configuration": {

"config_id": "<config-id>",

"config_name": "billable usage config",

"log_type": "BILLABLE_USAGE",

"output_format": "CSV",

"account_id": "<account-id>",

"credentials_id": "<databricks-credentials-id>",

"storage_configuration_id": "<databricks-storage-config-id>",

"workspace_ids_filter": [6383650456894062, 4102272838062927],

"delivery_path_prefix": "usage-data",

"delivery_start_time": "2020-06",

"status": "ENABLED",

"creation_time": 1591638409000,

"update_time": 1593108904000,

"log_delivery_status": {

"status": "CREATED",

"message": "Log Delivery Configuration is successfully created. Status will be updated after the first delivery attempt."

}

}

}

Recurso adicional da entrega log APIs

A entregalog APIstem recurso adicional. Consulte a documentação de referência da API para obter detalhes.

Outras operações incluem:

- Obter todas as configurações de entrega de log

- Obtenha uma configuração de entrega de registros por ID

- Habilitar ou desabilitar uma configuração de entrega de log por ID

O status da configuração da entrega do log pode ser encontrado no objeto log_delivery_status da resposta API. Com log_delivery_status, você pode verificar o status (sucesso ou fracasso) e a última vez de uma tentativa ou entrega bem-sucedida.

Existe um limite para o número de configurações de entrega de logs que você pode criar para uma conta. você pode criar no máximo duas configurações habilitadas que usam o nível de conta (sem filtro de workspace) e duas configurações habilitadas para cada workspace específico (pode ocorrer um workspaceId no filtro de workspace para duas configurações). você não pode excluir uma configuração de fornecimento de log, mas pode desativá-la. Você pode reativar uma configuração desativada, mas a solicitação falhará se violar os limites descritos anteriormente.

Etapa 5: Acesse os arquivos log para análise

Os arquivos de log são entregues em <bucket-name>/<prefix>/billable-usage/csv/, onde <prefix> é o nome do prefixo do caminho de entrega opcional que o senhor definiu durante a configuração de entrega log. Os arquivos são chamados de workspaceId=<workspace-id>-usageMonth=<month>.csv. Os arquivos são entregues diariamente, sobrescrevendo o arquivo CSV do mês para cada workspace.

Para obter o esquema CSV, consulte Esquema de arquivo CSV

Para obter informações sobre como analisar esses arquivos usando,Databricks consulte Analisar dados de uso em Databricks

Configuração automatizada usando o Terraform

O senhor pode usar o provedorDatabricks Terraform para configurar a entrega de uso log automaticamente com a ajuda do recurso databricks_mws_log_delivery. Aqui está um exemplo completo de uso e auditoria da entrega do log:

variable "databricks_account_id" {

description = "Account ID. You can get your account ID in the bottom left corner of the account console. See https://accounts.cloud.databricks.com"

}

resource "aws_s3_bucket" "logdelivery" {

bucket = "${var.prefix}-logdelivery"

acl = "private"

versioning {

enabled = false

}

force_destroy = true

tags = merge(var.tags, {

Name = "${var.prefix}-logdelivery"

})

}

resource "aws_s3_bucket_public_access_block" "logdelivery" {

bucket = aws_s3_bucket.logdelivery.id

ignore_public_acls = true

}

data "databricks_aws_assume_role_policy" "logdelivery" {

external_id = var.databricks_account_id

for_log_delivery = true

}

resource "aws_iam_role" "logdelivery" {

name = "${var.prefix}-logdelivery"

description = "(${var.prefix}) UsageDelivery role"

assume_role_policy = data.databricks_aws_assume_role_policy.logdelivery.json

tags = var.tags

}

data "databricks_aws_bucket_policy" "logdelivery" {

full_access_role = aws_iam_role.logdelivery.arn

bucket = aws_s3_bucket.logdelivery.bucket

}

resource "aws_s3_bucket_policy" "logdelivery" {

bucket = aws_s3_bucket.logdelivery.id

policy = data.databricks_aws_bucket_policy.logdelivery.json

}

resource "databricks_mws_credentials" "log_writer" {

account_id = var.databricks_account_id

credentials_name = "Usage Delivery"

role_arn = aws_iam_role.logdelivery.arn

}

resource "databricks_mws_storage_configurations" "log_bucket" {

account_id = var.databricks_account_id

storage_configuration_name = "Usage Logs"

bucket_name = aws_s3_bucket.logdelivery.bucket

}

resource "databricks_mws_log_delivery" "usage_logs" {

account_id = var.databricks_account_id

credentials_id = databricks_mws_credentials.log_writer.credentials_id

storage_configuration_id = databricks_mws_storage_configurations.log_bucket.storage_configuration_id

delivery_path_prefix = "billable-usage"

config_name = "Usage Logs"

log_type = "BILLABLE_USAGE"

output_format = "CSV"

}

resource "databricks_mws_log_delivery" "audit_logs" {

account_id = var.databricks_account_id

credentials_id = databricks_mws_credentials.log_writer.credentials_id

storage_configuration_id = databricks_mws_storage_configurations.log_bucket.storage_configuration_id

delivery_path_prefix = "audit-logs"

config_name = "Audit Logs"

log_type = "AUDIT_LOGS"

output_format = "JSON"

}