Criar um agente AI

Este artigo apresenta o processo de criação de agentes AI em Databricks e descreve os métodos disponíveis para a criação de agentes.

Para saber mais sobre agentes, consulte Padrões de projeto de sistemas de agentes.

Crie automaticamente um agente com o Agent Bricks

O Agent Bricks oferece uma abordagem simples para construir e otimizar sistemas de agentes de inteligência artificial ( AI ) específicos para cada domínio e de alta qualidade para casos de uso comuns de inteligência artificial ( AI ). Especifique seu caso de uso e seus dados, e o Agent Bricks criará automaticamente vários sistemas de agentes de e-mail ( AI ) para você refinar posteriormente. Veja Agent Bricks.

Crie um agente em código

O Mosaic AI Agent Framework e o MLflow fornecem ferramentas para ajudá-lo a criar agentes prontos para a empresa em Python.

Databricks oferece suporte a agentes de autoria que usam biblioteca de autoria de agentes de terceiros, como LangGraph/LangChain, LlamaIndex ou implementações personalizadas do Python.

Para começar rapidamente, consulte Começar com agentes AI. Para obter mais detalhes sobre a criação de agentes com diferentes estruturas e recursos avançados, consulte Criar agentes AI em código.

Protótipo de agentes com o AI Playground

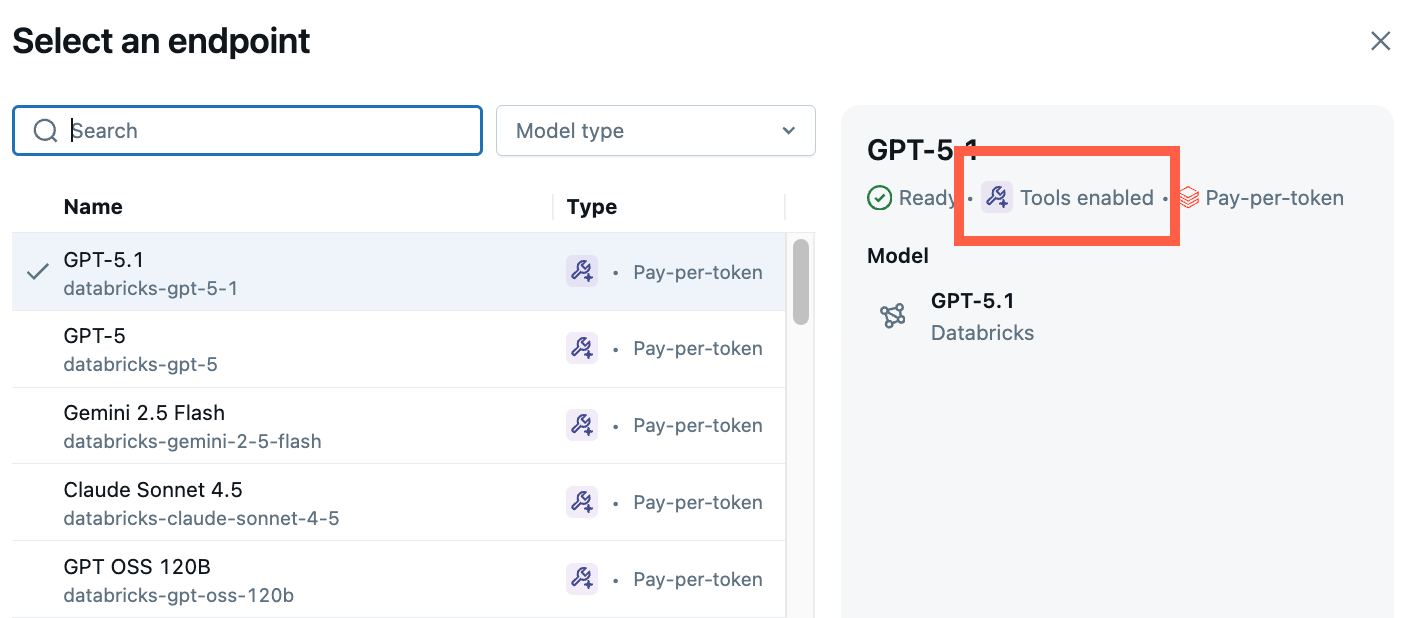

O AI Playground é a maneira mais fácil de criar um agente na Databricks. O AI Playground permite que o senhor selecione entre vários LLMs e adicione rapidamente ferramentas ao LLM usando uma interface de usuário com pouco código. Em seguida, você pode conversar com o agente para testar suas respostas e, em seguida, exportar o agente para código para implantação ou desenvolvimento adicional.

Consulte Protótipo de agentes de chamada de ferramenta no AI Playground.

Entenda as assinaturas do modelo para garantir a compatibilidade com o recurso Databricks

A Databricks usa o MLflow Model Signatures para definir o esquema de entrada e saída dos agentes. produto recurso, como o AI Playground, pressupõe que seu agente tenha um de um conjunto de assinaturas de modelos compatíveis.

Se o senhor seguir a abordagem recomendada para a criação de agentes, o siteMLflow inferirá automaticamente uma assinatura para o seu agente que seja compatível com o Databricks produto recurso, sem necessidade de trabalho adicional de sua parte.

Caso contrário, o senhor deve garantir que o seu agente adira a uma das outras assinaturas no esquema de agente de entrada e saída do Legacy, para garantir a compatibilidade com Databricks recurso.