MLflow 3.0 生成AI ワークフロー (Beta)

ベータ版

この機能は ベータ版です。

ノートブックの例

このサンプル ノートブックでは、エージェントを作成し、MLflow にログを記録し、そのパフォーマンスを評価します。ノートブックは、 databricks-langchain、 databricks-agents、 uv、および langgraph==0.3.4 ライブラリをインストールします。このノートブックは、 LangGraph ツール呼び出しエージェント ノートブックを適応させたものです。その他のノートブックの例とエージェントの作成方法の詳細については、「 コードで AI エージェントを作成する」を参照してください。

MLflow 3.0 生成AIエージェントの構築、評価 ノートブック

MLflow UI を使用してエージェントのパフォーマンスを調べる

ノートブック コードは初期テストを実行し、チェーンに対してクエリを実行して、チェーンがさらにテストするのに十分なパフォーマンスを発揮することを確認します。このテストのトレースは、MLflow UI のモデル詳細ページの トレース タブで使用できます。

![複数のトレースの詳細を示すモデル ページの [トレース] タブ。](/gcp/ja/assets/images/model-details-traces-883b3b2e3d1c23265bc418ded41d221b.png)

ノートブックの例の評価実行では、対話型クエリと評価から 2 つの MLflow ラン、1 つの MLflow LoggedModel、およびトレースが生成されます。 エージェントの評価メトリクスは、 MLflow エクスペリメントの機種詳細ページにすべて表示されています。

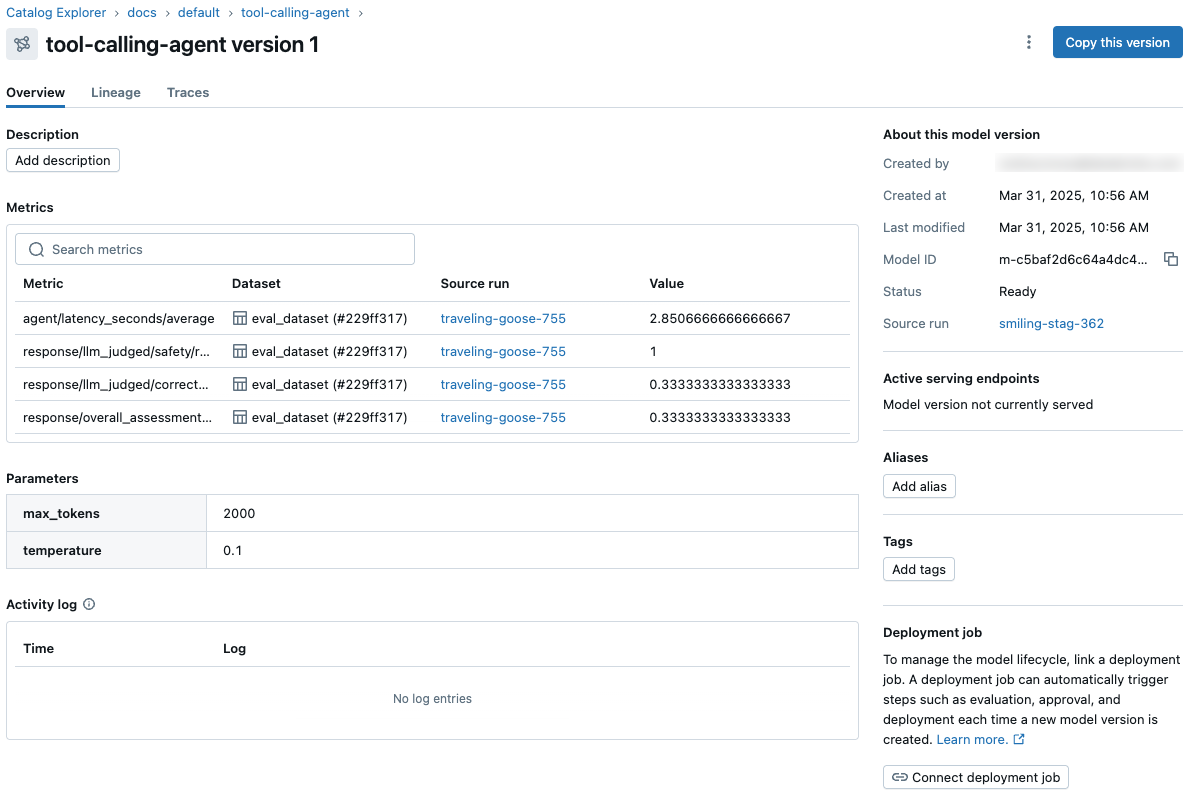

モデル ID とモデル パラメーターとメトリクスは、 Unity Catalog モデル バージョン ページにも表示されます。

Mosaic AI Model Serving を使用して、このモデルを任意のアプリケーションに埋め込むことができるライブエンドポイントに提供できるようになりました。サービス エンドポイントのオンライン呼び出しからのトレースは、開発フェーズからのオフライン トレースと共に、Unity Catalog モデル バージョンの トレース タブにも記録されます。生成AIアプリケーションのためのエージェントのデプロイを参照してください。

![Unity Catalog のモデル バージョン ページの [トレース] タブには、複数のトレースの詳細が表示されます。](/gcp/ja/assets/images/uc-model-version-traces-17c4c2dddd4046d20799269aa7a19e6a.png)

MLflow のトレースとフィードバックとツール呼び出しエージェントによるフィードバック

この短いチュートリアルでは、MLflow が数学的な問題を解決するときに、LangChain ツール呼び出しエージェントの詳細なトレースをキャプチャする方法を示します。これは、エージェントの実行を追跡し、エージェントの応答に関するフィードバックを格納する MLflow の機能を示しています。フィードバックは、 log_feedback API を使用してログに記録され、エージェントの品質を測定し、改善するのに非常に役立ちます。

MLflow 3.0 のトレースとフィードバックとツール呼び出しエージェント ノートブック

詳細情報

詳細については、次のページを参照してください。

エクスペリメント ページのモデルタブとMLflow カタログエクスプローラ のモデル バージョン ページの違いは何ですか?

エクスペリメント ページの モデル タブとカタログエクスプローラー のモデル バージョン ページには、モデルに関する同様の情報が表示されます。この 2 つのビューは、モデルの開発とデプロイのライフサイクルで異なる役割を果たします。

- エクスペリメントページの モデル タブには、エクスペリメントの記録済みモデルの結果を1つのページに掲載しています。 このページの チャートタブでは、モデルを比較し、デプロイのために Unity Catalog に登録するモデルのバージョンを選択するのに役立つ視覚化を提供します。

- カタログ エクスプローラーのモデル バージョン ページには、すべてのモデルのパフォーマンスと評価結果の概要が表示されます。このページには、さまざまなワークスペース、エンドポイント、エクスペリメントなど、リンクされたすべての環境にわたるモデル パラメーター、メトリクス、トレースが表示されます。 これは、モニタリングとデプロイに役立ち、 デプロイジョブで特にうまく機能します。 デプロイメント・ジョブの評価タスクは、このページに表示される追加のメトリクスを作成します。 ジョブの承認者は、このページを確認して、デプロイのモデル バージョンを承認するかどうかを評価できます。

次のステップ

MLflow 3.0 で導入された LoggedModel 追跡の詳細については、次の記事を参照してください。

MLflow 3.0 を他のワークフローと共に使用する方法の詳細については、次の記事を参照してください。