MLflow 3 aprendizagem profunda fluxo de trabalho

Exemplo de notebook

O exemplo Notebook executa um único trabalho de treinamento de modelo de aprendizagem profunda com PyTorch, que é rastreado como uma execução MLflow. Ele logs um modelo de ponto de verificação após cada 10 épocas. Cada ponto de controle é rastreado como um MLflow LoggedModel. Usando a interface de usuário do MLflow ou a API de pesquisa, o senhor pode inspecionar os modelos de ponto de verificação e classificá-los por precisão.

O Notebook instala a biblioteca scikit-learn e torch.

MLflow 3 modelo de aprendizagem profunda com pontos de controle Notebook

Use a UI para explorar o desempenho do modelo e registrar um modelo

Depois de executar o Notebook, o senhor pode view os modelos de ponto de verificação salvos na UI de experimentos do MLflow. Um link para o experimento aparece na saída da célula do Notebook, ou siga estas etapas:

-

Clique em Experiments (Experimentos ) na barra lateral do site workspace.

-

Encontre seu experimento na lista de experimentos. Você pode marcar a caixa de seleção Somente meus experimentos ou usar a caixa de pesquisa Filtrar experimentos para filtrar a lista de experimentos.

-

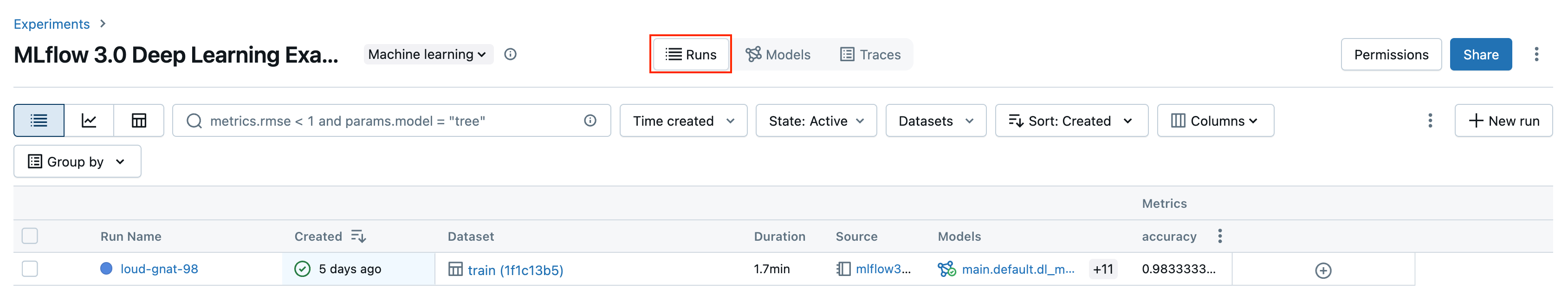

Clique no nome do seu experimento. A página de execução é aberta. O experimento contém uma execução do MLflow.

-

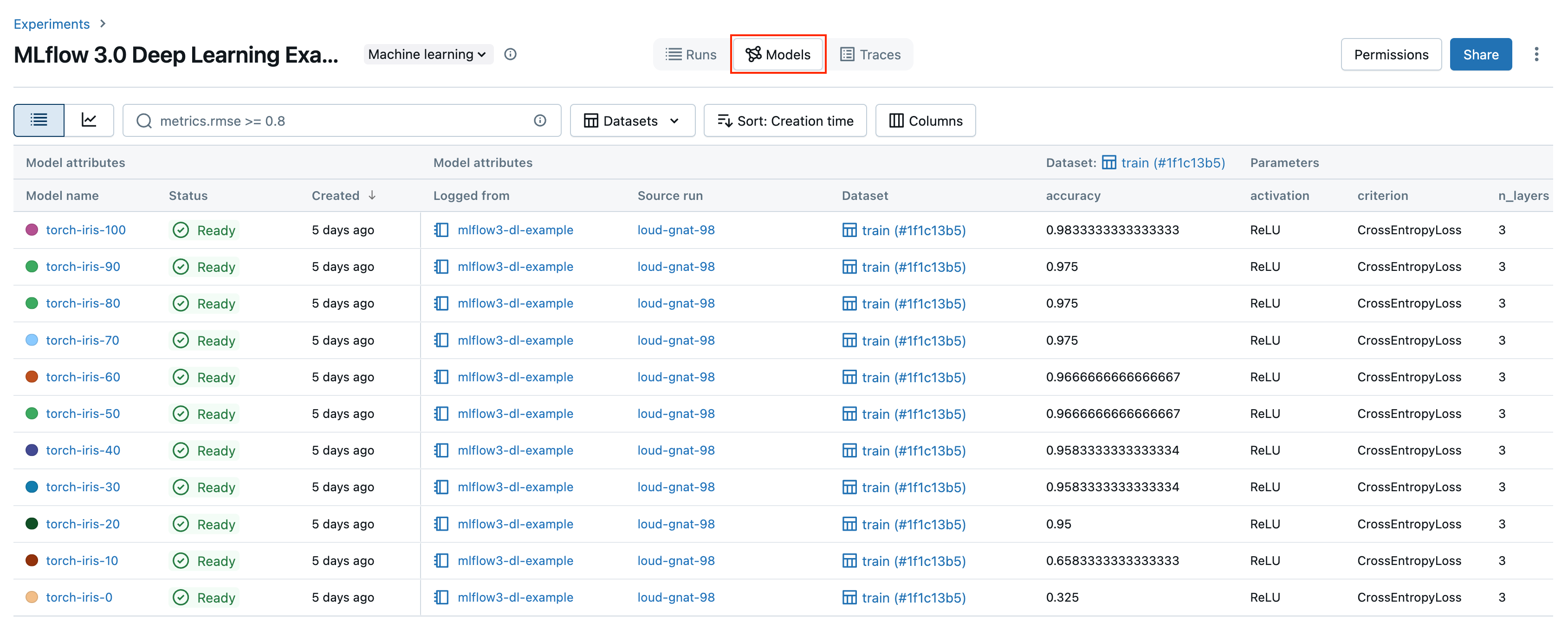

Clique em Models tab. Os modelos de pontos de verificação individuais são rastreados nessa tela. Para cada ponto de verificação, você pode ver a precisão do modelo, junto com todos os seus parâmetros e metadados.

No exemplo do Notebook, o senhor registrou o modelo de melhor desempenho em Unity Catalog. O senhor também pode registrar um modelo na interface do usuário. Para fazer isso, siga estas etapas:

-

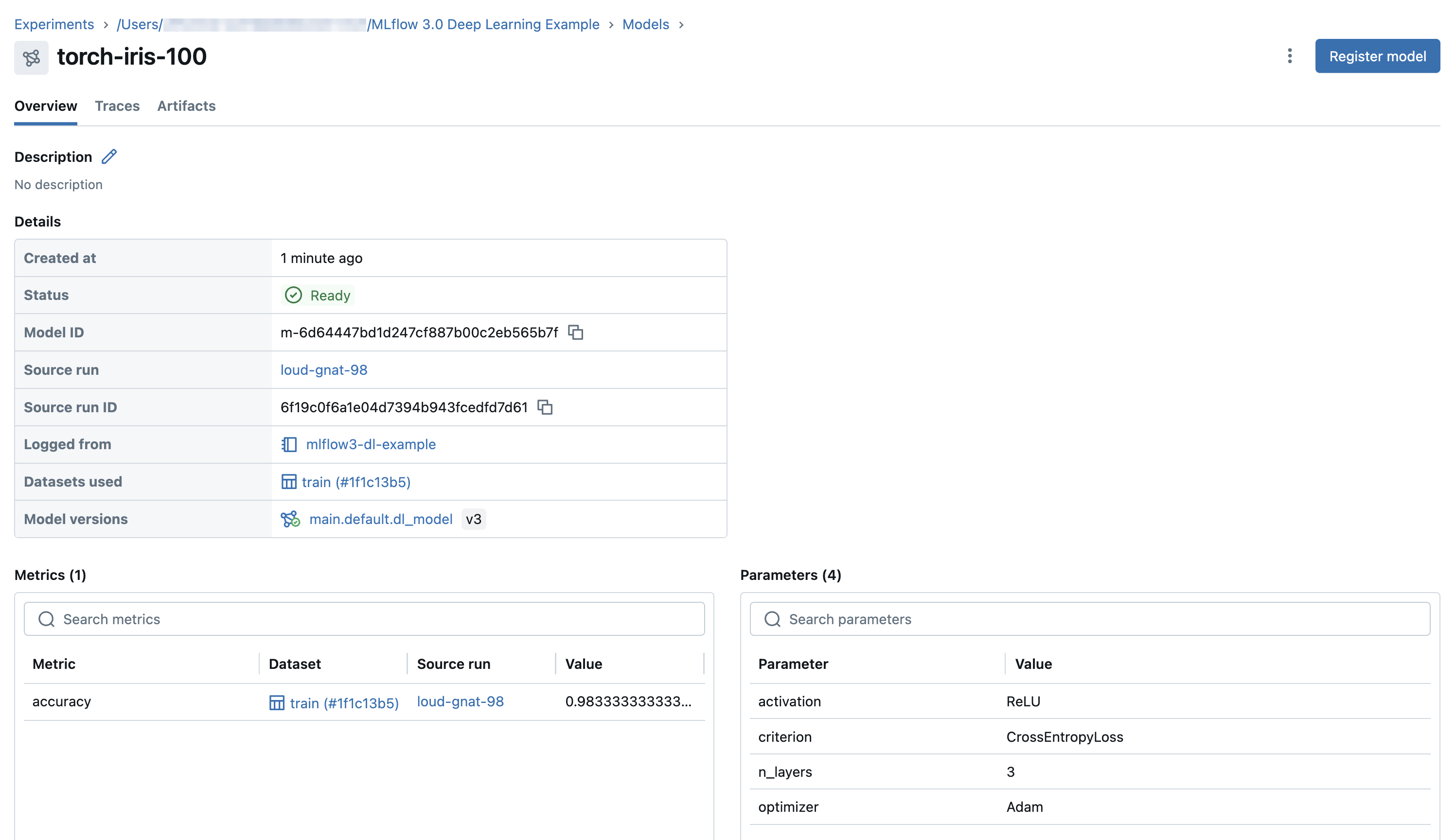

Em Models (Modelos ) tab, clique no nome do modelo a ser registrado.

-

Na página de detalhes do modelo, no canto superior direito, clique em registrar modelo .

Pode levar alguns minutos para que um modelo apareça na interface do usuário após o registro. Não pressione o modelo de registro mais de uma vez, caso contrário, o senhor registrará modelos duplicados.

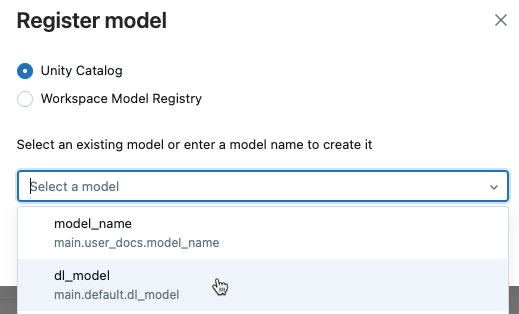

3. Selecione Unity Catalog e selecione um nome de modelo existente no menu suspenso ou digite um novo nome.

3. Selecione Unity Catalog e selecione um nome de modelo existente no menu suspenso ou digite um novo nome.

4. Clique em Registrar .

4. Clique em Registrar .

Use a API para classificar os modelos de ponto de verificação

O código a seguir mostra como classificar os modelos de pontos de verificação por precisão. Para obter mais detalhes sobre a pesquisa de modelos registrados usando o site API, consulte Pesquisar e filtrar modelos registrados.

ranked_checkpoints = mlflow.search_logged_models(

output_format="list",

order_by=[{"field_name": "metrics.accuracy", "ascending": False}]

)

best_checkpoint: mlflow.entities.LoggedModel = ranked_checkpoints[0]

print(best_checkpoint.metrics[0])

<Metric:

dataset_digest='9951783d',

dataset_name='train',

key='accuracy',

model_id='m-bba8fa52b6a6499281c43ef17fcdac84',

run_id='394928abe6fc4787aaf4e666ac89dc8a',

step=90,

timestamp=1730828771880,

value=0.9553571428571429

>

worst_checkpoint: mlflow.entities.LoggedModel = ranked_checkpoints[-1]

print(worst_checkpoint.metrics[0])

<Metric:

dataset_digest='9951783d',

dataset_name='train',

key='accuracy',

model_id='m-88885bc26de7492f908069cfe15a1499',

run_id='394928abe6fc4787aaf4e666ac89dc8a',

step=0,

timestamp=1730828730040,

value=0.35714285714285715

Qual é a diferença entre os Models tab na página de experimentos MLflow e a página da versão do modelo no Catalog Explorer?

A página Models tab da página do experimento e a página da versão do modelo no Catalog Explorer mostram informações semelhantes sobre o modelo. As duas visualizações têm funções diferentes no ciclo de vida do desenvolvimento e da implantação do modelo.

- A página Models tab da página do experimento apresenta os resultados dos modelos registrados de um experimento em uma única página. O site Charts tab nesta página fornece visualizações para ajudá-lo a comparar modelos e selecionar as versões do modelo a serem registradas em Unity Catalog para possível implementação.

- No Catalog Explorer, a página da versão do modelo oferece uma visão geral de todos os resultados de desempenho e avaliação do modelo. Essa página mostra os parâmetros do modelo, as métricas e os rastreamentos em todos os ambientes vinculados, incluindo diferentes espaços de trabalho, pontos de extremidade e experimentos. Isso é útil para monitoramento e implementação e funciona especialmente bem com o Job de implementação. A tarefa de avaliação em um Job de implantação cria métricas adicionais que aparecem nesta página. O aprovador do trabalho pode então revisar essa página para avaliar se deve aprovar a versão do modelo para implementação.

Próximas etapas

Para saber mais sobre o LoggedModel acompanhamento introduzido em MLflow 3, consulte os artigos a seguir:

Para saber mais sobre como usar o MLflow 3 com o tradicional ML fluxo de trabalho, consulte os artigos a seguir: