Databricks Runtime 6,0 (EoS)

O suporte para essa versão do Databricks Runtime foi encerrado. Para saber a data do fim do suporte, consulte Histórico do fim do suporte. Para conhecer todas as versões compatíveis do site Databricks Runtime, consulte Databricks Runtime notas sobre as versões e a compatibilidade.

A Databricks lançou esta versão em outubro de 2019.

As notas a seguir sobre a versão fornecem informações sobre o site Databricks Runtime 6.0, desenvolvido pela Apache Spark.

Novo recurso

Ambiente Python

O Databricks Runtime 6.0 inclui grandes mudanças no Python e na forma como os ambientes Python são configurados, incluindo a atualização do Python para a versão 3.7.3, refinar a lista de pacotes Python instalados e atualizar os pacotes instalados para versões mais recentes. Para obter detalhes, consulte Python biblioteca instalada.

Além disso, conforme anunciado anteriormente, o Databricks Runtime 6.0 não oferece suporte ao Python 2.

As principais mudanças incluem:

-

Atualizei o Python da versão 3.5.2 para a 3.7.3. Algumas versões antigas do Python pacote podem não ser compatíveis com o Python 3.7 porque dependem de versões antigas do Cython que não são compatíveis com o Python 3.7. A instalação desse pacote pode disparar erros semelhantes a

'PyThreadState' {'struct _ts'} has no member named 'exc_type'(consulte o problema 1978 do GitHub para obter detalhes). Em vez disso, instale as versões compatíveis do Python 3.7 do Python pacote. -

Grandes atualizações do pacote:

- boto3 até 1.9.162

- ipython para 7.4.0

- matplotlib para 3.0.3

- numpy para 1.16.2

- Pandas para 0.24.2

- pyarrow até 0.13.0

-

Em comparação com o Databricks Runtime 5.5 LTS (EoS), os seguintes pacotes Python foram incluídos recentemente: asn1crypto, backcall, jedi, kiwisolver, parso e PySocks.

-

Em comparação com Databricks Runtime 5.5 LTS (EoS), os seguintes pacotes Python não estão instalados: ansi2html, brewer2mpl, colorama, configobj, enum34, et-xmlfile, freetype-py, funcsigs, fusepy, ggplot, html5lib, ipaddress, jdcal, Jinja2, llvmlite, lxml, MarkupSafe, mpld3, msgpack-Python, ndg-httpsclient, numba, openpyxl, pathlib2, Pillow, ply, pyasn1, pypng, Python-geohash, scour, simplejson e singledispatch.

-

A função

displaynos objetos Python ggplot não é mais suportada porque o pacote ggplot não é compatível com a versão mais recente do Pandas. -

A configuração de

PYSPARK_PYTHONpara/databricks/python2/bin/pythonnão é compatível porque o site Databricks Runtime 6.0 não é compatível com Python 2. Um clustering com essa configuração ainda pode começar. No entanto, o Python Notebook e o Python comando não funcionarão, ou seja, as células do Python comando falharão com um erro "Canceled" e um erroPython shell failed to startaparecerá no driver logs. -

Se

PYSPARK_PYTHONapontar para um executável Python que esteja em um ambiente gerenciado pelo Virtualenv , esse ambiente será ativado para script de inicialização, sessões SSH e Notebook. O senhor pode usar os comandospythonepipque estão definidos no ambiente ativado diretamente, sem precisar especificar os locais absolutos desses comandos. Em default,PYSPARK_PYTHONé definido como/databricks/python3/bin/python. Assim, por default,pythonaponta para/databricks/python3/bin/pythonepipaponta para/databricks/python3/bin/pippara script de inicialização, sessões SSH e Notebook. Se oPYSPARK_PYTHONapontar para um executável Python que não esteja em um ambiente gerenciado pelo Virtualenv ou se o senhor estiver escrevendo um init script para criar o Python especificado porPYSPARK_PYTHON, será necessário usar caminhos absolutos para acessar ospythonepipcorretos. Quando o isolamento daPython biblioteca é ativado (é ativado por default), o ambiente ativado ainda é o ambiente ao qualPYSPARK_PYTHONestá associado. Recomendamos que o senhor use biblioteca utilidades (dbutils.biblioteca) (legado) para modificar o ambiente isolado associado a um notebook Python.

Scala e para DML comando Java APIs Delta Lake

Agora, o senhor pode modificar os dados nas tabelas Delta usando a programação APIs para excluir, atualizar e merge. Esses APIs espelham a sintaxe e a semântica de seu comando SQL correspondente e são ótimos para muitas cargas de trabalho, por exemplo, operações de dimensões que mudam lentamente (SCD) (SCD), mesclando dados de alteração para replicação e upserts de consultas de transmissão.

Para obter detalhes, consulte O que é Delta Lake na Databricks?

Scala e para utilidades comando Java APIs Delta Lake

Databricks Runtime agora tem APIs programático para as utilidades vacuum e history comando. Esses APIs espelham a sintaxe e a semântica de seus correspondentes SQL comandos disponíveis em versões anteriores do Databricks Runtime.

O senhor pode limpar os arquivos que não são mais referenciados por uma tabela Delta e que são mais antigos do que o limite de retenção, executando vacuum na tabela. Executar o comando vacuum na tabela de forma recursiva vacuum os diretórios associados à tabela Delta. O limite de retenção do site default para os arquivos é de 7 dias. A capacidade de voltar a uma versão anterior ao período de retenção é perdida após a execução do site vacuum. vacuum não é acionado automaticamente.

O senhor pode recuperar informações sobre as operações, o usuário, o registro de data e hora e assim por diante para cada gravação em uma tabela Delta executando o comando history. As operações são retornadas em ordem cronológica inversa. Em default, o histórico da tabela é mantido por 30 dias.

Para obter detalhes, consulte O que é Delta Lake na Databricks?

Armazenamento otimizado usando APIs de arquivos locais

As APIs de arquivos locais são úteis porque permitem que o senhor acesse arquivos do armazenamento de objetos distribuídos subjacente como arquivos locais. No Databricks Runtime 6.0, aprimoramos a montagem do FUSE que permite o arquivo local APIs para atender às limitações do key. O Databricks Runtime 6.0 melhora significativamente a velocidade de leitura e gravação e oferece suporte a arquivos com mais de 2 GB. Se o senhor precisar de leituras e gravações mais rápidas e confiáveis, como no caso do treinamento de modelos distribuídos, esse aprimoramento será particularmente útil. Além disso, você não precisaria carregar dados em um armazenamento local para suas cargas de trabalho, economizando custos e melhorando a produtividade.

Para obter detalhes, consulte O que é DBFS?

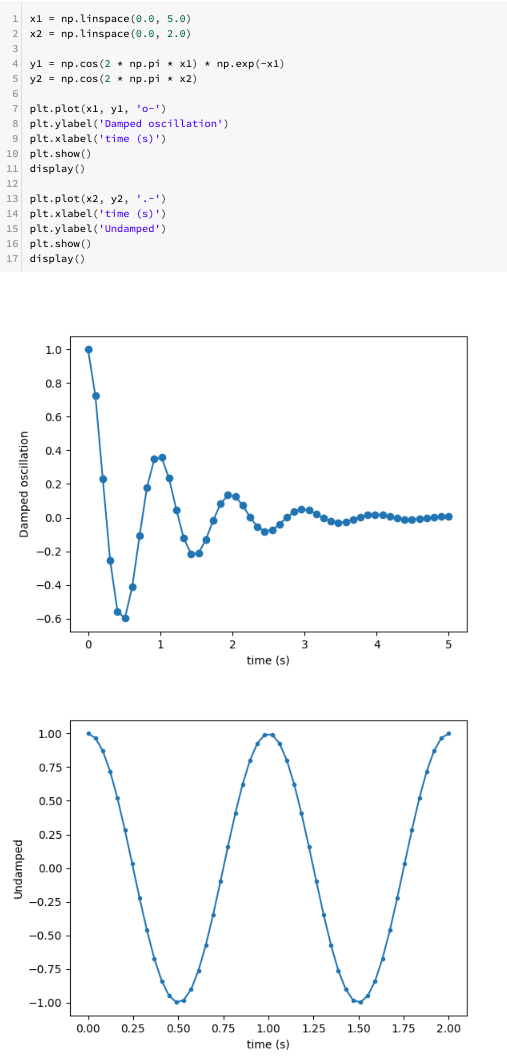

Vários gráficos matplotlib por célula do Notebook

Agora o senhor pode exibir vários gráficos matplotlib por célula do Notebook:

Credenciais de serviço para várias contas Azure Data Lake Storage Gen1

Agora o senhor pode configurar credenciais de serviço para várias contas de armazenamento Azure para uso em uma única sessão Apache Spark. Para fazer isso, adicione account.<account-name> à chave de configuração. Por exemplo, se quiser configurar credenciais para que a conta acesse adl://example1.azuredatalakestore.net e adl://example2.azuredatalakestore.net, o senhor pode fazer isso da seguinte forma:

spark.conf.set("fs.adl.oauth2.access.token.provider.type", "ClientCredential")

spark.conf.set("fs.adl.account.example1.oauth2.client.id", "<application-id-example1>")

spark.conf.set("fs.adl.account.example1.oauth2.credential", dbutils.secrets.get(scope = "<scope-name>", key = "<key-name-for-service-credential-example1>"))

spark.conf.set("fs.adl.account.example1.oauth2.refresh.url", "https://login.microsoftonline.com/<directory-id-example1>/oauth2/token")

spark.conf.set("fs.adl.account.example2.oauth2.client.id", "<application-id-example2>")

spark.conf.set("fs.adl.account.example2.oauth2.credential", dbutils.secrets.get(scope = "<scope-name>", key = "<key-name-for-service-credential-example2>"))

spark.conf.set("fs.adl.account.example2.oauth2.refresh.url", "https://login.microsoftonline.com/<directory-id-example2>/oauth2/token")

Melhorias

- Atualização do AWS SDK para a versão 1.11.596.

- Atualização do SDK de armazenamento do Azure no driver WASB para 7.0.

OPTIMIZEagora fornece um resumo das métricas, como o número de arquivos adicionados, o número de arquivos removidos e o tamanho máximo e mínimo do arquivo. Consulte Otimizar a disposição do arquivo de dados.

Remoção

O Databricks ML Model Export foi removido. Em vez disso, use o mLeap para importar e exportar modelos.

Apache Spark

Este artigo contém referências ao termo escravo , um termo que o site Databricks não usa. Quando o termo for removido do site software, nós o removeremos deste artigo.

O Databricks Runtime 6.0 inclui o Apache Spark 2.4.3. Esta versão inclui todas as correções e melhorias do Spark incluídas no Databricks Runtime 5.5 LTS (EoS), bem como as seguintes correções de bugs e melhorias adicionais feitas no Spark:

- [SPARK-27992][SPARK-28881][Python] Permitir que Python para join com thread de conexão propague erros

- [SPARK-27330][SS]suporte à tarefa abortar no escritor foreach (6.0, 5.x)

- [SPARK-28642][SQL] Ocultar credenciais em SHOW CREATE TABLE

- [SPARK-28699] [CORE] Corrija uma caixa de canto para abortar o estágio indeterminado

- [SPARK-28647][WEBUI] Recover additional métricas recurso

- [SPARK-28766][R][DOC] Corrigir aviso de viabilidade de entrada do CRAN em URL inválido

- [SPARK-28486][CORE][Python] Mapear o arquivo de dados do PythonBroadcast em um BroadcastBlock para evitar a exclusão pelo GC

- [SPARK-25035] [CORE] Evitando o mapeamento de memória na replicação de blocos armazenados em disco

- [SPARK-27234][SS][Python] Usar InheritableThreadLocal para a época atual no EpochTracker (para suportar Python UDFs)

- [SPARK-28638][WEBUI] O resumo da tarefa deve conter apenas as métricas da tarefa bem-sucedida

- [SPARK-28153][Python] Use AtomicReference at InputFileBlockHolder (to support input_file_name with Python UDF)

- [SPARK-28564][CORE] O aplicativo de histórico de acesso tem como padrão o ID da última tentativa

- [SPARK-28260] O clustering pode terminar automaticamente enquanto a consulta do thriftserver ainda está obtendo resultados

- [SPARK-26152][CORE] Sincronizar a limpeza do trabalhador com o desligamento do trabalhador

- [SPARK-28545][SQL] Adicionar o tamanho do mapa de hash ao direcional log do ObjectAggregationIterator

- [SPARK-28489] [SS] Corrige um bug que fazia com que o KafkaOffsetRangeCalculator.getRanges pudesse descartar compensações

- [SPARK-28421][ML] SparseVector.apply otimização de desempenho

- [SPARK-28156][SQL] Self-join should not miss cache view

- [SPARK-28152][SQL] Mapeou ShortType para SMALLINT e FloatType para REAL para MsSqlServerDialect

- [SPARK-28054][SQL] Corrige erro ao inserir dinamicamente uma tabela particionada do Hive em que o nome da partição está em maiúsculas

- [SPARK-27159][SQL] atualize o dialeto do servidor mssql para oferecer suporte ao tipo binário

- [SPARK-28355][CORE][Python] Use Spark conf para limitar a quantidade de com...

- [SPARK-27989] [CORE] Foram adicionadas novas tentativas na conexão com o driver para k8s

- [SPARK-27416][SQL] UnsafeMapData & UnsafeArrayData Kryo serialization ...

- [SPARK-28430][UI] Corrigir a renderização da tabela de estágios quando algumas tarefas' métricas estiverem faltando

- [SPARK-27485] EnsureRequirements.reorder deve lidar com expressões duplicadas normalmente

- [SPARK-28404] [SS] Corrige o valor de tempo limite negativo no RateStreamContinuousPartitionReader

- [SPARK-28378][Python] Remover o uso de cgi.escape

- [SPARK-28371][SQL] Tornar o filtro "StartsWith" do Parquet seguro para nulos

- [SPARK-28015][SQL] Verificar stringToDate() consome toda a entrada para os formatos yyyy e yyyy-[m]m

- [SPARK-28302][CORE] Certifique-se de gerar um arquivo de saída exclusivo para o SparkLauncher no Windows

- [SPARK-28308] [CORE] A parte inferior do CalendarInterval deve ser preenchida antes da análise

- [SPARK-28170][ML][Python] Documentação de vetores uniformes e matrizes

- [SPARK-28160] [CORE] Corrige um bug em que a função de retorno de chamada pode travar quando uma exceção não verificada é perdida

- [SPARK-27839][SQL] Alterar UTF8String.replace() para operar em bytes UTF8

- [SPARK-28157] [CORE] Faça com que o SHS limpe o KVstore LogInfo para as entradas na lista negra

- [SPARK-28128][Python][SQL] Pandas Os UDFs agrupados ignoram partições vazias

- [SPARK-28012][SQL] Hive UDF suporta expressão dobrável do tipo struct

- [SPARK-28164] Corrigir a descrição de uso do começar-slave.sh

- [SPARK-27100][SQL] Use Array em vez de Seq em FilePartition para evitar StackOverflowError

- [SPARK-28154][ML] Correção de GMM com cache duplo

Atualizações de manutenção

Consulte Atualizações de manutenção do Databricks Runtime 6.0.

Ambiente do sistema

- Sistema operacional : Ubuntu 16.04.6 LTS

- Java : 1.8.0_232

- Scala : 2.11.12

- Python : 3.7.3

- R: R versão 3.6.1 (05/07/2019)

- Delta Lake : 0.3.0

Embora o Scala 2.12 esteja disponível como um recurso experimental no Apache Spark 2.4, ele não é compatível com o Databricks Runtime 6.0.

Instalado Python biblioteca

Biblioteca | Versão | Biblioteca | Versão | Biblioteca | Versão |

|---|---|---|---|---|---|

criptomoeda asn1 | 0,24,0 | chamada de volta | 0.1.0 | Boto | 2,49,0 |

boto3 | 1,9.162 | botocore | 1,12.163 | certifi | 2019,3.9 |

caffi | 1.12.2 | chardet | 3.0.4 | criptografia | 2.6.1 |

ciclador | 0.10.0 | Cython | 0,29,6 | decorador | 4.4.0 |

docutils | 0,14 | Índia | 2.8 | ipython | 7.4.0 |

ipython-genutils | 0.2.0 | jedi | 0,13.3 | jmespath | 0.9.4 |

solucionador de kiwi | 1.1.0 | Matplotlib | 3.0.3 | entorpecido | 1.16.2 |

Pandas | 0,24,2 | parso | 0.3.4 | bode expiatório | 0.5.1 |

esperar | 4.6.0 | picles | 0.7.5 | pip | 19,0,3 |

kit de ferramentas de aviso | 2.0.9 | psycopg2 | 2.7.6.1 | processo pty | 0.6.0 |

flecha | 0,13,0 | pycparser | 2,19 | pycurl | 7,43,0 |

Pigmentos | 2.3.1 | Objeto PYG | 3.20.0 | PyOpenSSL | 19.0.0 |

análise de pipa | 2.4.2 | Meias PY | 1.6.8 | Python-apt | 1.1.0.b1+ubuntu0.16.04.5 |

Python-dateutil | 2.8.0 | pytz | 2018,9 | pedidos | 2.21,0 |

transferência s3 | 0.2.1 | scikit-learn | 0,20.3 | pegajoso | 1.2.1 |

marítimo | 0.9.0 | ferramentas de configuração | 40,8,0 | seis | 1.12.0 |

ID de importação ssh | 5.5 | modelos de estatísticas | 0.9.0 | almôndegas | 4.3.2 |

atualizações autônomas | 0,1 | urllib3 | 1.24,1 | ambiente virtual | 16.4.1 |

largura do wc | 0.1.7 | Python wheel | 0,33,1 |

Instalada a R biblioteca

Biblioteca | Versão | Biblioteca | Versão | Biblioteca | Versão |

|---|---|---|---|---|---|

abandam | 1,4-5 | askpass | 1.1 | afirme que | 0.2.1 |

portas traseiras | 1.1.3 | base | 3.6.1 | base64enc | 0,1-3 |

POR | 1,69,0-1 | pouco | 1,1-14 | bit64 | 0,9-7 |

bitops | 1,0-6 | bolha | 1.1.1 | inicialização | 1,3-23 |

fermentar | 1,0-6 | chamador | 3.2.0 | carro | 3,0-2 |

Dados do carro | 3,0-2 | cursor | 6,0-82 | guarda de celas | 1.1.0 |

crono | 2,3-53 | Aula | 7,3-15 | CLIPE | 1.1.0 |

clipe | 0.5.0 | símbolos cli | 1.2.0 | Cluster | 2.1.0 |

ferramentas de código | 0,2-16 | espaço de cores | 1,4-1 | marca comum | 1.7 |

compilador | 3.6.1 | configuração | 0,3 | giz de cera | 1.3.4 |

cacho | 3.3 | data.tabela | 1.12.0 | conjunto de dados | 3.6.1 |

DBI | 1.0.0 | dbplyr | 1.3.0 | desc | 1.2.0 |

ferramentas de desenvolvimento | 2.0.1 | digerir | 0.6.18 | Dom C | 1.3.5 |

dplyr | 0.8.0.1 | reticências | 0.1.0 | fansi | 0.4.0 |

para gatos | 0.4.0 | para cada um | 1.4.4 | estrangeira | 0,8-72 |

forjar | 0.2.0 | fs | 1.2.7 | gbm | 2.1.5 |

genéricas | 0.0.2 | ggplot2 | 3.1.0 | gh | 1.0.1 |

git2r | 0,25,2 | glmnet | 2,0-16 | cola | 1.3.1 |

goleiro | 0.2.0 | gráficos | 3.6.1 | Dispositivos GR | 3.6.1 |

grade | 3.6.1 | Grid Extra | 2.3 | gsubfn | 0,7 |

mesa | 0.3.0 | h2o | 3.22.1.1 | refúgio | 2.1.0 |

HMS | 0.4.2 | ferramentas html | 0.3.6 | widgets html | 1.3 |

httr | 1.4.0 | escritor | 1.3.2 | HWriter Plus | 1,0-3 |

mini | 0.3.1 | ipred | 0,9-8 | iteradores | 1.0.10 |

jsonlite | 1,6 | Kern Smooth | 2,23-15 | rótulo | 0,3 |

treliça | 0,20-38 | lava | 1.6.5 | preguiçoso | 0.2.2 |

mais pequeno | 0.3.7 | lme4 | 1,1-21 | lubrificar | 1.7.4 |

magritter | 1.5 | mapproj | 1.2.6 | mapeia | 3.3.0 |

ferramentas de mapa | 0,9-5 | MASSA | 7,3-51,4 | Matriz | 1,2-17 |

Modelos matriciais | 0,4-1 | memoise | 1.1.0 | métodos | 3.6.1 |

mgcv | 1,8-28 | mímica | 0,6 | mina | 1.2.4 |

Métricas do modelo | 1.2.2 | munsell | 0.5.0 | norma mvt | 1,0-10 |

nome | 3,1-141 | nloptr | 1.2.1 | net | 7,3-12 |

Número Deriv | 2016,8-1 | openssl | 1.3 | openxlsx | 4.1.0 |

paralelo | 3.6.1 | teste pbkr | 0,4-7 | pilar | 1.3.1 |

pkgbuild | 1.0.3 | pkgconfig | 2.0.2 | Gatinho PKG | 0.1.4 |

carregamento de pacotes | 1.0.2 | plogr | 0.2.0 | plyr | 1.8.4 |

elogio | 1.0.0 | unidades bonitas | 1.0.2 | ProC | 1,14.0 |

processa | 3.3.0 | prodlim | 2018,04.18 | progresso | 1.2.0 |

proto | 1.0.0 | ps | 1.3.0 | ronronar | 0.3.2 |

quantreg | 5,38 | R. métodos S3 | 1.7.1 | R.oo | 1,22,0 |

R. utils | 2.8.0 | r2d3 | 0.2.3 | R6 | 2.4.0 |

Floresta aleatória | 4,6-14 | corredeiras | 0.3.1 | rcmdcheck | 1.3.2 |

Cervejaria RColor | 1,1-2 | Rcpp | 1.0.1 | RCP Pegen | 0.3.3.5.0 |

RCPP Roll | 0.3.0 | Curl | 1,95-4,12 | leitor | 1.3.1 |

readxl | 1.3.1 | receitas | 0.1.5 | revanche | 1.0.1 |

controles remotos | 2.0.2 | remodelar 2 | 1.4.3 | rio | 0,5.16 |

rlang | 0.3.3 | RODBC | 1,3-15 | roxigênio2 | 6.1.1 |

rpartem | 4,1-15 | rprojroot | 1,3-2 | Reservar | 1,8-6 |

RSQLite | 2.1.1 | API do estúdio | 0,10 | escala | 1.0.0 |

informações da sessão | 1.1.1 | espião | 1,3-1 | Sparklyr | 1.0.0 |

SparkR | 2.4.4 | SPARSEM | 1,77 | espacial | 7,3-11 |

splines | 3.6.1 | sqldf | 0,4-11 | QUADRADO | 2017,10-1 |

statmod | 1,4,30 | estatísticas | 3.6.1 | estatísticas4 | 3.6.1 |

stringi | 1.4.3 | longarina | 1.4.0 | sobrevivência | 2,44-1,1 |

diz | 3.1 | tcltk | 3.6.1 | Demonstrações de ensino | 2,10 |

teste isso | 2.0.1 | petiscar | 2.1.1 | arrumado | 0,8.3 |

seleção arrumada | 0.2.5 | Hora/Data | 3043,102 | Ferramentas | 3.6.1 |

use isso | 1.4.0 | utf 8 | 1.1.4 | utilidades | 3.6.1 |

Viridis Lite | 0.3.0 | bigode | 0,3-2 | murchar | 2.1.2 |

xml2 | 1.2.0 | xopen | 1.0.0 | yaml | 2.2.0 |

compactar | 2.0.1 |

Instalei Java e Scala biblioteca (versão de clusteringScala 2.11)

ID do grupo | ID do artefato | Versão |

|---|---|---|

chifre | chifre | 2.7.7 |

com.amazonaws | Amazon-kinesis-client | 1.8.10 |

com.amazonaws | aws-java-sdk-autoscale | 1,11.595 |

com.amazonaws | formação de nuvem aws-java-sdk | 1,11.595 |

com.amazonaws | aws-java-sdk-cloudfront | 1,11.595 |

com.amazonaws | aws-java-sdk-cloudhsm | 1,11.595 |

com.amazonaws | aws-java-sdk-cloudsearch | 1,11.595 |

com.amazonaws | aws-java-sdk-cloudtrail | 1,11.595 |

com.amazonaws | aws-java-sdk-cloudwatch | 1,11.595 |

com.amazonaws | métricas aws-java-sdk-cloudwatch | 1,11.595 |

com.amazonaws | aws-java-sdk-codedeploy | 1,11.595 |

com.amazonaws | identidade cognitiva aws-java-sdk | 1,11.595 |

com.amazonaws | aws-java-sdk-cognitosync | 1,11.595 |

com.amazonaws | aws-java-sdk-config | 1,11.595 |

com.amazonaws | aws-java-sdk-core | 1,11.595 |

com.amazonaws | pipeline de dados aws-java-sdk | 1,11.595 |

com.amazonaws | aws-java-sdk-conexão direta | 1,11.595 |

com.amazonaws | diretório aws-java-sdk | 1,11.595 |

com.amazonaws | aws-java-sdk-dynamodb | 1,11.595 |

com.amazonaws | aws-java-sdk-ec2 | 1,11.595 |

com.amazonaws | aws-java-sdk-ecs | 1,11.595 |

com.amazonaws | aws-java-sdk-efs | 1,11.595 |

com.amazonaws | aws-java-sdk-elasticache | 1,11.595 |

com.amazonaws | aws-java-sdk-elasticbeanstalk | 1,11.595 |

com.amazonaws | balanceamento de carga elástico aws-java-sdk | 1,11.595 |

com.amazonaws | transcodificador elástico aws-java-sdk- | 1,11.595 |

com.amazonaws | aws-java-sdk-emr | 1,11.595 |

com.amazonaws | aws-java-sdk-glacier | 1,11.595 |

com.amazonaws | aws-java-sdk-glue | 1,11.595 |

com.amazonaws | aws-java-sdk-iam | 1,11.595 |

com.amazonaws | aws-java-sdk-importação/exportação | 1,11.595 |

com.amazonaws | aws-java-sdk-kinesis | 1,11.595 |

com.amazonaws | aws-java-sdk-kms | 1,11.595 |

com.amazonaws | aws-java-sdk-lambda | 1,11.595 |

com.amazonaws | aws-java-sdk-logs | 1,11.595 |

com.amazonaws | aws-java-sdk - aprendizado de máquina | 1,11.595 |

com.amazonaws | aws-java-sdk-opsworks | 1,11.595 |

com.amazonaws | aws-java-sdk-rds | 1,11.595 |

com.amazonaws | aws-java-sdk-redshift | 1,11.595 |

com.amazonaws | aws-java-sdk-route53 | 1,11.595 |

com.amazonaws | aws-java-sdk-s3 | 1,11.595 |

com.amazonaws | aws-java-sdk-ses | 1,11.595 |

com.amazonaws | aws-java-sdk-simpledb | 1,11.595 |

com.amazonaws | aws-java-sdk - fluxo de trabalho simples | 1,11.595 |

com.amazonaws | aws-java-sdk-sns | 1,11.595 |

com.amazonaws | aws-java-sdk-sqs | 1,11.595 |

com.amazonaws | aws-java-sdk-ssm | 1,11.595 |

com.amazonaws | gateway de armazenamento aws-java-sdk | 1,11.595 |

com.amazonaws | aws-java-sdk-sts | 1,11.595 |

com.amazonaws | suporte aws-java-sdk | 1,11.595 |

com.amazonaws | aws-java-sdk-swf-biblioteca | 1.11.22 |

com.amazonaws | aws-java-sdk-workspace | 1,11.595 |

com.amazonaws | jmespath-java | 1,11.595 |

com.carrotsearch | hppc | 0.7.2 |

com.chuusai | sem forma_2.11 | 2.3.2 |

com.clearspring.analítica | transmissão | 2.7.0 |

com.databricks | Reservar | 1,8-3 |

com.databricks | dbml-local_2.11 | 0.5.0-db8-spark2.4 |

com.databricks | testes dbml-local_2.11 | 0.5.0-db8-spark2.4 |

com.databricks | jets3t | 0.7.1-0 |

com.databricks.scalapb | plugin_2.11 | 0,4.15-9 |

com.databricks.scalapb | scalapb-runtime_2.11 | 0,4.15-9 |

com.esotérico software | crio-sombreado | 4.0.2 |

com.esotérico software | minlog | 1.3.0 |

com.fasterxml | colega de classe | 1.0.0 |

com.fasterxml.jackson.core | jackson-anotação | 2.6.7 |

com.fasterxml.jackson.core | jackson-core | 2.6.7 |

com.fasterxml.jackson.core | vinculação de dados jackson | 2.6.7.1 |

formato de dados com.fasterxml.jackson. | formato de dados jackson-cbor | 2.6.7 |

com.fasterxml.jackson.tipo de dados | jackson-datatype-joda | 2.6.7 |

com.fasterxml.jackson.module | parâmetro do módulo jackson | 2.6.7 |

com.fasterxml.jackson.module | jackson-module-Scala.11 | 2.6.7.1 |

com.github.fommil | descarregador | 1.1 |

com.github.fommil.netlib | abdômen | 1.1.2 |

com.github.fommil.netlib | native_ref-java | 1.1 |

com.github.fommil.netlib | native_ref-java-nativos | 1.1 |

com.github.fommil.netlib | sistema_nativo-java | 1.1 |

com.github.fommil.netlib | native_system-java-natives | 1.1 |

com.github.fommil.netlib | netlib-native_ref-linux-x86_64-natives | 1.1 |

com.github.fommil.netlib | netlib-native_system-linux-x86_64-natives | 1.1 |

com.github.luben | zstd-jni | 1,3.2-2 |

com.github.rwl | jtransforma | 2.4.0 |

com.google.code.findbugs | jsr305 | 2.0.1 |

com.google.code.gson | gson | 2.2.4 |

com.google.goiaba | goiaba | 15,0 |

com.google.protobuf | protobuf-java | 2.6.1 |

com.googlecode.javaewah | Java Ewah | 0.3.2 |

banco de dados com.h2 | h2 | 1,3,174 |

com.jcraft | jsch | 0,1,50 |

com.jolbox | bonecp | VERSÃO 0.8.0. |

com.microsoft.azure | azure-data lake-store-sdk | 2.2.8 |

com.microsoft.azure | armazenamento do azure | 7.0.0 |

com.microsoft.sqlserver | mssql-JDBC | 6.2.2. jre8 |

comendo | comprimir-lzf | 1.0.3 |

com.sun.mail | javax.mail | 1.5.2 |

com.thoughtworks.paranamer | paranâmero | 2.8 |

com.trueaccord.lenses | lentes_2.11 | 0,3 |

com.Twitter | chill-java | 0.9.3 |

com.Twitter | chill_2.11 | 0.9.3 |

com.Twitter | pacote parquet-hadoop | 1.6.0 |

com.Twitter | util-app_2.11 | 6,23,0 |

com.Twitter | util-core_2.11 | 6,23,0 |

com.Twitter | util-jvm_2.11 | 6,23,0 |

com.typesafe | configuração | 1.2.1 |

com.typesafe.Scala-logging | Scala-logging-api_2.11 | 2.1.2 |

com.typesafe.Scala-logging | Scala-logging-slf4j_2.11 | 2.1.2 |

com.univocidade | analisadores de univocidade | 2.7.3 |

com.vlkan | tampões planos | 1,2,0-3f79e055 |

com.zaxxer | HikaricP | 3.1.0 |

folhas de feijão comum | folhas de feijão comum | 1.9.3 |

comum-CLI | comum-CLI | 1.2 |

codec comum | codec comum | 1,10 |

coleções comuns | coleções comuns | 3.2.2 |

configuração comum | configuração comum | 1,6 |

commons-dbcp | commons-dbcp | 1.4 |

digestor comum | digestor comum | 1,8 |

commons-httpclient | commons-httpclient | 3.1 |

commons-io | commons-io | 2,4 |

linguagem comum | linguagem comum | 2.6 |

registro de bens comuns | registro de bens comuns | 1.1.3 |

commons-net | commons-net | 3.1 |

comum-pool | comum-pool | 1.5.4 |

info.ganglia.gmetric4j | gmetric4j | 1.0.7 |

io. airlift | compressor de ar | 0,10 |

io.dropwizard.métricas | núcleo de métricas | 3.1.5 |

io.dropwizard.métricas | métricas-ganglia | 3.1.5 |

io.dropwizard.métricas | métricas-grafite | 3.1.5 |

io.dropwizard.métricas | métricas-healthchecks | 3.1.5 |

io.dropwizard.métricas | métricas-jetty9 | 3.1.5 |

io.dropwizard.métricas | métricas-JSON | 3.1.5 |

io.dropwizard.métricas | métricas-JVM | 3.1.5 |

io.dropwizard.métricas | métricas-log4j | 3.1.5 |

io.dropwizard.métricas | métricas-servlets | 3.1.5 |

io.netty | urtiga | 3.9.9. Final |

io.netty | tudo | 4.1.17.Final |

javax.ativação | ativação | 1.1.1 |

javax.anotação | javax.anotação-api | 1.2 |

javax.el | javax.el-api | 2.2.4 |

javax.jdo | jdo-api | 3.0.1 |

javax.servlet | javax.servlet-api | 3.1.0 |

javax.servlet.jsp | jsp-api | 2.1 |

javax.transaction | jta | 1.1 |

javax.validação | API de validação | 1.1.0. Final |

javax.ws.rs | javax.ws.rs-api | 2.0.1 |

javax.xml.bind | jaxb-api | 2.2.2 |

javax.xml.transmissão | stax-api | 1,0-2 |

javolução | javolução | 5.5.1 |

junte-se | junte-se | 2.14.6 |

hora do dia | hora do dia | 2.9.3 |

unidade | unidade | 4,12 |

log4j | apache-log4j-extras | 1.2.17 |

log4j | log4j | 1.2.17 |

net.hydromatic | propriedades de base própria | 1.1.5 |

net.razorvine | pirolita | 4,13 |

net.sf.jpam | jpam | 1.1 |

net.sf.opencsv | opencsv | 2.3 |

net.sf.supercsv | supercsv | 2.2.0 |

net.snowflake | SDK de ingestão de flocos de neve | 0,9.5 |

net.snowflake | floco de neve-JDBC | 3.6.15 |

net.snowflake | floco de neve faísca_2.11 | 2.4.10-spark_2.4 |

net.sourceforge.f2j | arpack_combined_all | 0,1 |

org.acplt | no CRPC | 1.0.7 |

org.antlr | ST4 | 4.0.4 |

org.antlr | antlr-runtime | 3.4 |

org.antlr | antlr4-runtime | 4.7 |

org.antlr | modelo de string | 3.2.1 |

org.apache.ant | formiga | 1.9.2 |

org.apache.ant | formiga | 1.9.2 |

org.apache.ant | lançador de formigas | 1.9.2 |

org.apache.arrow | formato de seta | 0.10.0 |

org.apache.arrow | memória de seta | 0.10.0 |

org.apache.arrow | vetor de seta | 0.10.0 |

org.apache.avro | AVRO | 1.8.2 |

org.apache.avro | avro-ipc | 1.8.2 |

org.apache.avro | avro-mapred-hadoop2 | 1.8.2 |

org.apache.calcite | calcita-avática | 1.2.0 - incubação |

org.apache.calcite | núcleo de calcita | 1.2.0 - incubação |

org.apache.calcite | calcita-linq4j | 1.2.0 - incubação |

org.apache.commons | compressa comum | 1.8.1 |

org.apache.commons | criptomoeda comum | 1.0.0 |

org.apache.commons | commons-lang3 | 3,5 |

org.apache.commons | commons-math3 | 3.4.1 |

org.apache.curator | curador-cliente | 2.7.1 |

org.apache.curator | estrutura de curador | 2.7.1 |

org.apache.curator | receitas de curadores | 2.7.1 |

org.apache.derby | derby | 10.12.1.1 |

org.apache.directory.api | api-asn1-api | 1,0,0-M20 |

org.apache.directory.api | utilitário de API | 1,0,0-M20 |

org.apache.directory.server | apacheds-i18n | 2,0,0-M15 |

org.apache.directory.server | codec apacheds-kerberos | 2,0,0-M15 |

org.apache.hadoop | hadoop-anotação | 2.7.3 |

org.apache.hadoop | autenticação hadoop | 2.7.3 |

org.apache.hadoop | cliente hadoop | 2.7.3 |

org.apache.hadoop | hadoop-comum | 2.7.3 |

org.apache.hadoop | hadoop-HDFS | 2.7.3 |

org.apache.hadoop | aplicativo cliente hadoop mapreduce | 2.7.3 |

org.apache.hadoop | hadoop-mapreduce-client-common | 2.7.3 |

org.apache.hadoop | núcleo do cliente hadoop-mapreduce | 2.7.3 |

org.apache.hadoop | hadoop-mapreduce-client-jobclient | 2.7.3 |

org.apache.hadoop | hadoop-mapreduce-client-shuffle | 2.7.3 |

org.apache.hadoop | API hadoop yarn | 2.7.3 |

org.apache.hadoop | cliente hadoop-yarn | 2.7.3 |

org.apache.hadoop | hadoop-yarn-common | 2.7.3 |

org.apache.hadoop | servidor hadoop-yarn-comum | 2.7.3 |

org.apache.htrace | htrace-core | 3.1.0 - incubação |

org.apache.httpcomponents | cliente http | 4.5.6 |

org.apache.httpcomponents | httpcore | 4.4.10 |

org.apache.ivy | hera | 2.4.0 |

org.apache.orc | orc-core-no-hive | 1.5.5 |

org.apache.orc | orc-mapreduce-nohive | 1.5.5 |

org.apache.orc | calços de orc | 1.5.5 |

org.apache.parquet | coluna de parquete | 1.10.1.2 - blocos de dados 3 |

org.apache.parquet | parquete comum | 1.10.1.2 - blocos de dados 3 |

org.apache.parquet | codificação de parquet | 1.10.1.2 - blocos de dados 3 |

org.apache.parquet | formato de parquet | 2.4.0 |

org.apache.parquet | parquet-hadoop | 1.10.1.2 - blocos de dados 3 |

org.apache.parquet | parquet-jackson | 1.10.1.2 - blocos de dados 3 |

org.apache.thrift | libfb303 | 0.9.3 |

org.apache.thrift | libthrift | 0.9.3 |

org.apache.xbean | xbean-asm6 sombreado | 4,8 |

org.apache.zookeeper | tratador | 3.4.6 |

org.codehaus.jackson | jackson-core-asl | 1.9.13 |

org.codehaus.jackson | jackson-jaxers | 1.9.13 |

org.codehaus.jackson | jackson-mapper-asl | 1.9.13 |

org.codehaus.jackson | jackson-xc | 1.9.13 |

org.codehaus.janino | compilador common | 3.0.10 |

org.codehaus.janino | janino | 3.0.10 |

org.datanucleus | núcleo de dados-api-jdo | 3.2.6 |

org.datanucleus | núcleo de dados | 3.2.10 |

org.datanucleus | núcleo de dados-rdbms | 3.2.9 |

org.Eclipse.jetty | jetty-client | 9.3.27.v 20190418 |

org.Eclipse.jetty | continuação do cais | 9.3.27.v 20190418 |

org.Eclipse.jetty | jetty-http | 9.3.27.v 20190418 |

org.Eclipse.jetty | jetty-io | 9.3.27.v 20190418 |

org.Eclipse.jetty | jetty-jndi | 9.3.27.v 20190418 |

org.Eclipse.jetty | jetty-plus | 9.3.27.v 20190418 |

org.Eclipse.jetty | jetty-proxy | 9.3.27.v 20190418 |

org.Eclipse.jetty | segurança do cais | 9.3.27.v 20190418 |

org.Eclipse.jetty | servidor jetty-server | 9.3.27.v 20190418 |

org.Eclipse.jetty | jutty-servlet | 9.3.27.v 20190418 |

org.Eclipse.jetty | píer de servlets | 9.3.27.v 20190418 |

org.Eclipse.jetty | jetty-util | 9.3.27.v 20190418 |

org.Eclipse.jetty | aplicativo web jetty- | 9.3.27.v 20190418 |

org.Eclipse.jetty | jetty-xml | 9.3.27.v 20190418 |

org.fusesource.leveldbjni | leveldbjni-tudo | 1,8 |

org.glassfish.hk2 | API hk2 | 2.4.0-b34 |

org.glassfish.hk2 | localizador hk2 | 2.4.0-b34 |

org.glassfish.hk2 | hk2-utils | 2.4.0-b34 |

org.glassfish.hk2 | osgi-recurso-locator | 1.0.1 |

org.glassfish.hk2.external | aopalliance - reembalado | 2.4.0-b34 |

org.glassfish.hk2.external | javax.inject | 2.4.0-b34 |

org.glassfish.jersey.bundles.reembalado | jersey-goiaba | 2.22.2 |

org.glassfish.jersey.containers | servlet de contêiner de camisa | 2.22.2 |

org.glassfish.jersey.containers | jersey-container-servlet-core | 2.22.2 |

org.glassfish.jersey.core | cliente de camisa | 2.22.2 |

org.glassfish.jersey.core | camiseta comum | 2.22.2 |

org.glassfish.jersey.core | servidor de camisa | 2.22.2 |

org.glassfish.jersey.media | jersey-media-jaxb | 2.22.2 |

org.hamcrest | núcleo da hamcrista | 1.3 |

org.hamcrest | biblioteca de hamcrest | 1.3 |

org.hibernate | validador de hibernação | 5.1.1. Final |

org.iq80.snappy | atrevida | 0,2 |

org.javassist | javassist | 3.18.1-GA |

org.jboss.logging | registro de jboss-logging | 3.1.3. GA |

org.jdbi | jdbi | 2.63,1 |

org.joda | conversor de joda | 1.7 |

org.jodd | núcleo nodular | 3.5.2 |

org.json4s | json4s-ast_2.11 | 3.5.3 |

org.json4s | json4s-core_2.11 | 3.5.3 |

org.json4s | json4s-jackson_2.11 | 3.5.3 |

org.json4s | json4s-scalap_2.11 | 3.5.3 |

org.lz4 | lz4-java | 1.4.0 |

org.mariadb.JDBC | cliente mariadb-java | 2.1.2 |

org.mockito | mockito-core | 1,10,19 |

org.objenesis | objênese | 2.5.1 |

org.postgresql | PostgreSQL | 42,14 |

org.roaringbitmap | Mapa de bits estrondoso | 0,7,45 |

org.roaringbitmap | calços | 0,7,45 |

org.rocksdb | rocksdbjni | 6.2.2 |

org.rosuda.rEngine | Motor | 2.1.0 |

org.Scala-lang | Scala-compiler_2.11 | 2.11.12 |

org.Scala-lang | Scala-biblioteca.11 | 2.11.12 |

org.Scala-lang | Scala-reflect_2.11 | 2.11.12 |

org.Scala-lang.modules | Scala-parser-combinators_2.11 | 1.1.0 |

org.Scala-lang.modules | Scala-xml_2.11 | 1.0.5 |

org.Scala-sbt | interface de teste | 1,0 |

org.scalacheck | scalacheck_2.11 | 1,12.5 |

org.scalactic | scalactic_2.11 | 3.0.3 |

org.scalanlp | breeze-macros_2.11 | 0,13.2 |

org.scalanlp | breeze_2.11 | 0,13.2 |

org.scalatest | scalatest_2.11 | 3.0.3 |

org.slf4j | jcl-over-slf4j | 1.7.16 |

org.slf4j | jul-a-slf4j | 1.7.16 |

org.slf4j | slf4j-api | 1.7.16 |

org.slf4j | slf4j-log4j12 | 1.7.16 |

org.spark-project.hive | hive-beeline | 1.2.1. spark2 |

org.spark-project.hive | colmeia-CLI | 1.2.1. spark2 |

org.spark-project.hive | hive-JDBC | 1.2.1. spark2 |

org.spark-project.hive | Hive metastore | 1.2.1. spark2 |

org.spark-project.spark | não utilizado | 1.0.0 |

org.spire-math | spire-macros_2.11 | 0,13,0 |

org.spire-math | spire_2.11 | 0,13,0 |

org.springframework | núcleo de mola | 4.1.4. LANÇAMENTO |

org.springframework | teste de primavera | 4.1.4. LANÇAMENTO |

org.tukaani | xz | 1.5 |

org.typelevel | maquinista_2.11 | 0.6.1 |

org.typelevel | macro-compat_2.11 | 1.1.1 |

org.xerial | sqlite-JDBC | 3.8.11.2 |

org.xerial.snappy | snappy-java | 1.1.7.3 |

org.yaml | snakeyaml | 1,16 |

oro | oro | 2.0.8 |

software.Amazon.ion | ion-java | 1.0.2 |

stax | stax-api | 1.0.1 |

xmlenc | xmlenc | 0,52 |