Configurar compute para o trabalho

Este artigo contém recomendações e recursos para configurar o site compute para LakeFlow Jobs.

As limitações do site serverless compute for Job incluem o seguinte:

- Não há suporte para programação contínua .

- Não há suporte para default ou acionadores de intervalo baseados em tempo na transmissão estruturada.

Para obter mais limitações, consulte limitações do compute sem servidor.

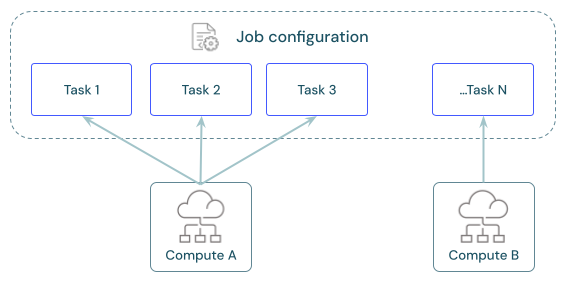

Cada trabalho pode ter uma ou mais tarefas. O senhor define compute recurso para cada tarefa. Várias tarefas definidas para o mesmo trabalho podem usar o mesmo recurso compute.

Qual é a recomendação do site compute para cada tarefa?

A tabela a seguir indica os tipos de compute recomendados e suportados para cada tipo de tarefa.

sem servidor compute for Job tem limitações e não é compatível com todas as cargas de trabalho. Consulte as limitações do compute sem servidor.

Tarefa | Recomendado compute | Com suporte compute |

|---|---|---|

cadernos | Trabalho sem servidor | Job sem servidor, Job clássico, clássico para todos os fins |

Script Python | Trabalho sem servidor | Job sem servidor, Job clássico, clássico para todos os fins |

Python Wheel | Trabalho sem servidor | Job sem servidor, Job clássico, clássico para todos os fins |

SQL | sem servidor SQL warehouse | sem servidor SQL warehouse, pro SQL warehouse |

Pipeline declarativo LakeFlow Spark | sem servidor pipeline | sem servidor pipeline, clássico pipeline |

dbt | sem servidor SQL warehouse | sem servidor SQL warehouse, pro SQL warehouse |

dbt CLI comando | Trabalho sem servidor | Job sem servidor, Job clássico, clássico para todos os fins |

JAR | Trabalho clássico | Trabalho clássico, clássico para todos os fins |

Spark Submit | Trabalho clássico | Trabalho clássico |

Os preços do LakeFlow Jobs estão vinculados ao compute usado para executar a tarefa. Para obter mais detalhes, consulte Databricks preços.

Como configurar o site compute for Jobs?

O trabalho clássico compute é configurado diretamente na interface do usuário do LakeFlow Jobs, e essas configurações fazem parte da definição do trabalho. Todos os outros tipos de compute disponíveis armazenam suas configurações com outros workspace ativos. A tabela a seguir tem mais detalhes:

Tipo de Compute | Detalhes |

|---|---|

Trabalho clássico compute | O senhor configura o compute para o trabalho clássico usando a mesma interface do usuário e as mesmas configurações disponíveis para o compute para todos os fins. Consulte a referência de configuração de computação. |

sem servidor compute para o trabalho | serverless compute for Job é o default para todas as tarefas que o suportam. Databricks gerenciar compute configurações para serverless compute. Veja a execução do seu LakeFlow Jobs with serverless compute for fluxo de trabalho. |

SQL warehouses | serverless e pro SQL warehouse são configurados pelos administradores do workspace ou por usuários com privilégios irrestritos de criação de clustering. O senhor configura a tarefa para execução no site SQL warehouse existente. Consulte Conectar-se a um site SQL warehouse. |

computede pipeline declarativa LakeFlow Spark | Você configura as definições compute para o pipeline declarativo LakeFlow Spark durante a configuração pipeline . Consulte Configurar compute clássica para pipeline. Databricks gerenciando recurso compute para pipeline declarativo LakeFlow Spark serverless . Consulte Configurar um pipeline serverless. |

Compute para todos os fins | Opcionalmente, o senhor pode configurar a tarefa usando o clássico compute. Databricks não recomenda essa configuração para trabalhos de produção. Consulte a referência de configuração de computação e O site compute para todos os fins deve ser usado para trabalhos? |

Compartilhe compute em toda a tarefa

Configure a tarefa para usar o mesmo recurso do Job compute para otimizar o uso do recurso com o Job que orquestra várias tarefas. O compartilhamento compute entre as tarefas pode reduzir a latência associada aos tempos start-up.

O senhor pode usar um único recurso de Job compute para executar todas as tarefas que fazem parte do Job ou vários recursos de Job otimizados para cargas de trabalho específicas. Qualquer tarefa compute configurada como parte de uma tarefa está disponível para todas as outras tarefas da tarefa.

A tabela a seguir destaca as diferenças entre o Job compute configurado para uma única tarefa e o Job compute compartilhado entre tarefas:

Tarefa única | Compartilhado em toda a tarefa | |

|---|---|---|

Iniciar | Quando a execução da tarefa começa. | Quando a primeira execução de tarefa configurada para usar o recurso compute começar. |

Encerrar | Após a execução da tarefa. | Após a tarefa final configurada para usar o recurso compute execução. |

parado compute | Não aplicável. | O cálculo permanece ligado e parado enquanto a tarefa não usa o recurso de execução compute. |

Um clustering de trabalho compartilhado tem o escopo de uma única execução de trabalho e não pode ser usado por outro trabalho ou execução do mesmo trabalho.

biblioteca não pode ser declarado em uma configuração de clustering de trabalho compartilhado. O senhor deve adicionar a biblioteca dependente nas configurações da tarefa.

Revisar, configurar e swap Job compute

A seção de computação no painel de detalhesJob lista todos os compute configurados para tarefa no trabalho atual.

A tarefa configurada para usar um compute recurso é destacada no gráfico da tarefa quando o senhor passa o mouse sobre a especificação compute.

Use o botão de troca para alterar o endereço compute para todas as tarefas associadas a um recurso compute.

O trabalho clássico compute recurso tem uma opção Configure (Configurar ). Outros compute recursos oferecem ao senhor opções para view e modificar compute detalhes de configuração.

Mais informações

Para obter mais detalhes sobre a configuração do trabalho clássico do Databricks, consulte Práticas recomendadas para configurar trabalhos clássicos do LakeFlow.