最適化された LLM サービス エンドポイントをプロビジョニングされたスループットに移行する

important

このドキュメントは廃止されており、更新されない可能性があります。 このコンテンツに記載されている製品、サービス、またはテクノロジはサポートされなくなりました。

この記事では、既存のLLM サービス エンドポイントを、基盤モデルAPI を使用して利用可能なプロビジョニング スループット エクスペリエンスに移行する方法について説明します。

変更点

プロビジョニングされたスループットにより、最適化された LLM サービス エンドポイントを起動するためのエクスペリエンスが簡単になります。 Databricks は、 LLM モデルサービングシステムを次のように変更しました。

- スケールアウト範囲は、同時実行ではなく 1 秒あたりのトークン数など、LLM ネイティブの用語で構成できます。

- お客様は、GPU ワークロードの種類を自分で選択する必要がなくなりました。

新しい LLM サービスエンドポイントは、デフォルトでプロビジョニングされたスループットで作成されます。 GPU ワークロードの種類を引き続き選択する場合、このエクスペリエンスは API を使用してのみサポートされます。

LLM サービングエンドポイントをプロビジョニングされたスループットに移行する

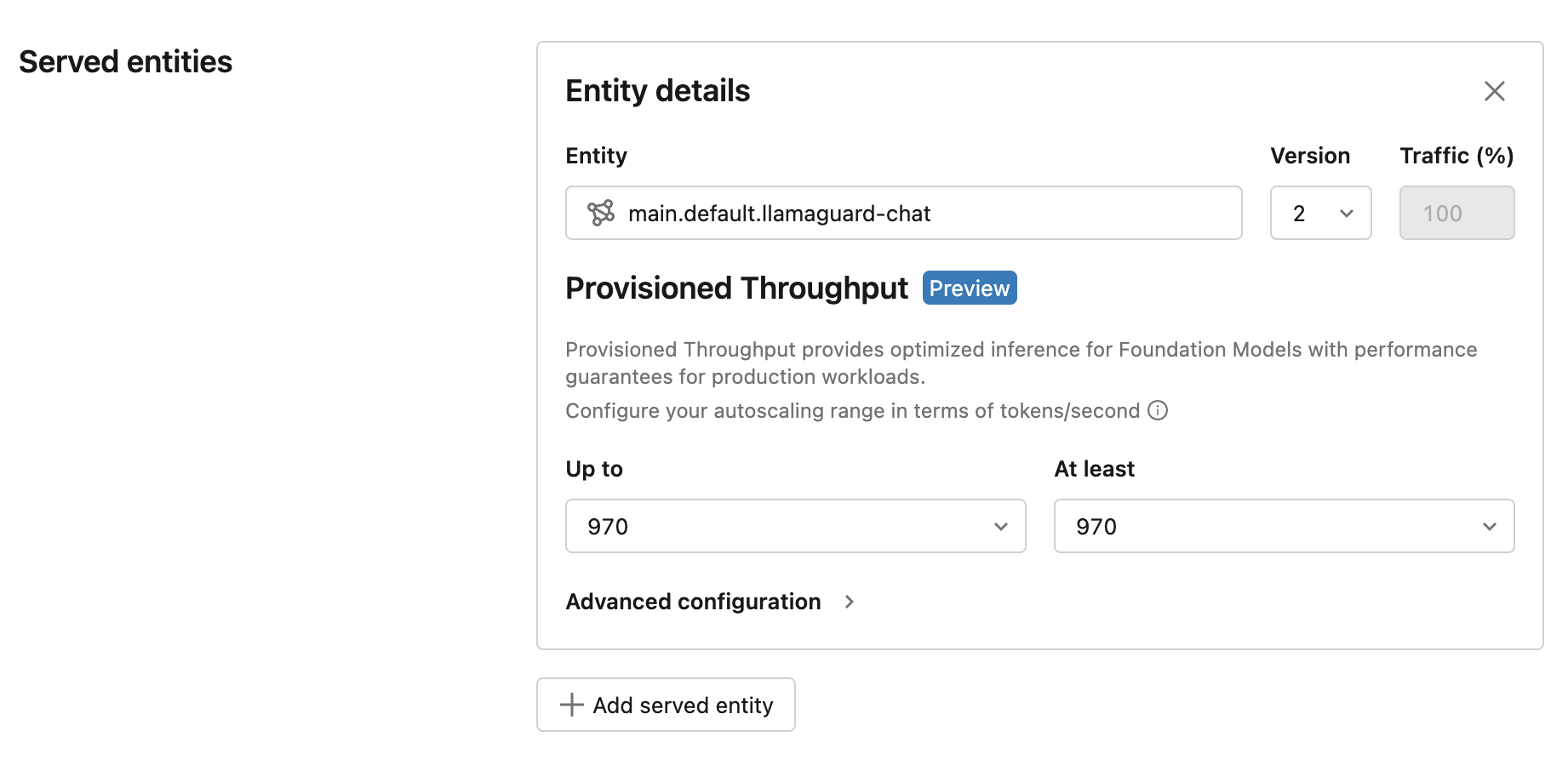

既存のエンドポイントをプロビジョニングされたスループットに移行する最も簡単な方法は、エンドポイントを新しいモデルバージョンで更新することです。 新しいモデルバージョンを選択すると、プロビジョニングされたスループットのエクスペリエンスが UI に表示されます。 UI には、一般的なユースケースの Databricks ベンチマークに基づく 1 秒あたりのトークン範囲が表示されます。

この更新されたオファリングのパフォーマンスは、最適化の改善により厳密に向上し、エンドポイントの価格は変わりません。 製品に関するフィードバックや懸念事項については、 model-serving-feedback@databricks.com にお問い合わせください。