Organize a execução do treinamento com os experimentos do MLflow

Os experimentos são unidades de organização do seu modelo de treinamento execução. Há dois tipos de experimentos: workspace e Notebook.

- O senhor pode criar um experimento workspace na interface do usuário Databricks Mosaic AI ou no site MLflow API. Os experimentos do espaço de trabalho não estão associados a nenhum Notebook, e qualquer Notebook pode log a execução desses experimentos usando o ID do experimento ou o nome do experimento.

- Um experimento de Notebook está associado a um Notebook específico. Databricks cria automaticamente um experimento do Notebook se não houver um experimento ativo quando o usuário inicia a execução usando mlflow.começar().

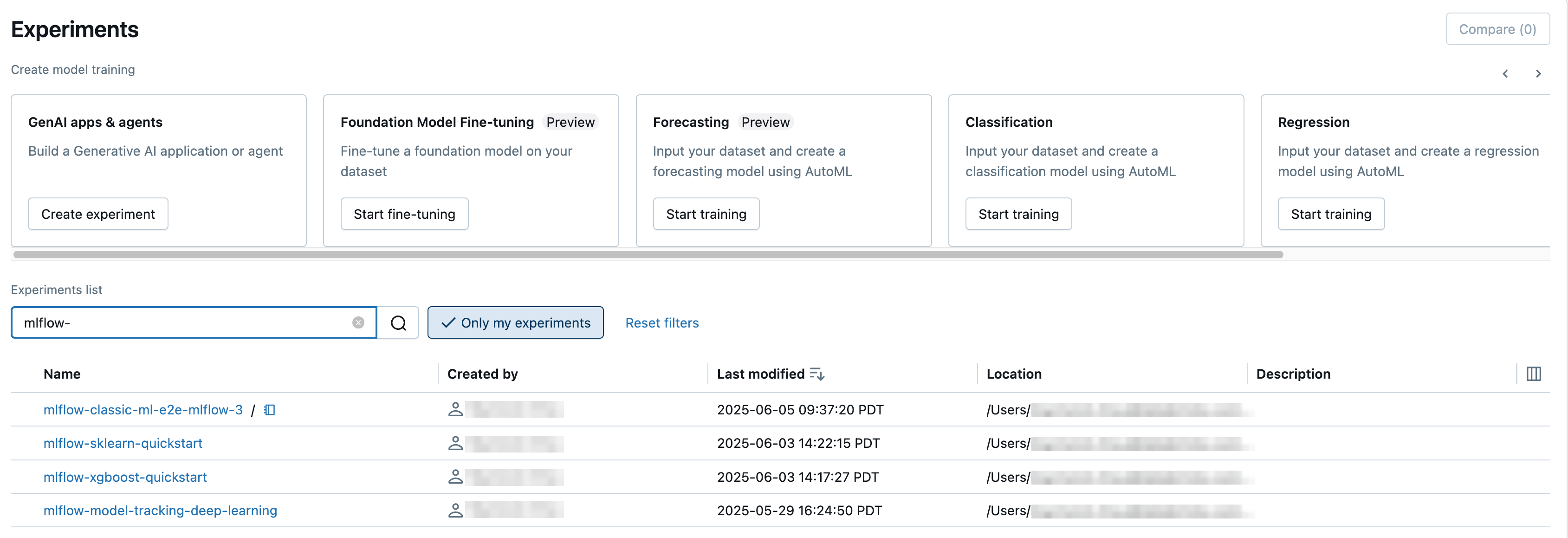

Para ver todos os experimentos em workspace aos quais o senhor tem acesso, selecione Machine Learning > Experiments (Aprendizado de máquina > Experimentos ) na barra lateral.

Crie o experimento workspace

Esta seção descreve como criar um experimento workspace usando a UI Databricks. O senhor pode criar um experimento workspace diretamente no site workspace ou na página Experiments (Experimentos).

O senhor também pode usar a API do MLflow ou o provedor Databricks Terraform com databricks_mlflow_experiment.

Para obter instruções sobre como registrar a execução nos experimentos do workspace, consulte registrar a execução e os modelos em um experimento.

Para GDPR compliance, os experimentos obsoletos são removidos do espaço de trabalho. Para o espaço de trabalho em que a chave de gerenciar o cliente é usada, os experimentos obsoletos só são eliminados quando o gerenciar o cliente key é acessado por Databricks. Consulte Configurar a chave do gerenciador de clientes para criptografia para dar acesso.

Criar experimento a partir do workspace

-

Clique em

workspace na barra lateral.

-

Navegue até a pasta na qual você deseja criar o experimento.

-

Clique com o botão direito do mouse na pasta e selecione Create > MLflow experiment .

-

Na caixa de diálogo Create MLflow Experiment (Criar experimento MLflow), digite um nome para o experimento e um local opcional para o artefato. Se o senhor não especificar um local para o artefato, os artefatos serão armazenados no armazenamento de artefatos do MLflow-gerenciar:

dbfs:/databricks/mlflow-tracking/<experiment-id>.Para o espaço de trabalho habilitado para Unity Catalog, o senhor também pode armazenar artefatos em um volume Unity Catalog. Para armazenar artefatos em seu próprio armazenamento cloud, crie um volume externo Unity Catalog.

Para armazenar artefatos em um volume do Unity Catalog, especifique um caminho de volume no formato

dbfs:/Volumes/catalog_name/schema_name/volume_name/user/specified/pathcomo o local do artefato do experimento MLflow, seja na interface do usuário ou conforme mostrado no código a seguir:Pythonimport mlflow # Storing artifacts in a volume requires MLflow 2.15.0 or above

EXP_NAME = "/Users/first.last@databricks.com/my_experiment_name"

CATALOG = "my_catalog"

SCHEMA = "my_schema"

VOLUME = "my_volume"

ARTIFACT_PATH = f"dbfs:/Volumes/{CATALOG}/{SCHEMA}/{VOLUME}" # can be a managed or external volume

mlflow.set_tracking_uri("databricks")

mlflow.set_registry_uri("databricks-uc")

if mlflow.get_experiment_by_name(EXP_NAME) is None:

mlflow.create_experiment(name=EXP_NAME, artifact_location=ARTIFACT_PATH)

mlflow.set_experiment(EXP_NAME)Se o seu workspace não estiver habilitado para Unity Catalog, ou se o senhor não tiver acesso ao MLflow 2.15.0 ou acima, especifique um caminho neste formato:

dbfs:/path/to/artifacts.A Databricks recomenda o uso de um volume do Unity Catalog para armazenamento de artefatos. Se nem um volume do Unity Catalog nem o DBFS forem uma opção adequada, o senhor também pode armazenar artefatos diretamente no S3 (não recomendado). Para armazenar artefatos em S3, especifique um URI no formato

s3://<bucket>/<path>. MLflow obtém credenciais para acessar S3 do seu cluster's instance profile. Os artefatos armazenados em S3 não aparecem na interface do usuário MLflow; o senhor deve download usá-los usando um cliente de armazenamento de objetos.Os limites de tamanho de arquivo para upload e download são de 5 GB.

Quando você armazena um artefato em um local diferente do MLflow-gerenciar DBFS (default) ou dos volumes Unity Catalog , o artefato não aparece na interface do usuário MLflow . Os modelos armazenados em locais diferentes destes não podem ser registrados no Model Registry.

-

Clique em Criar . A página de detalhes do novo experimento é exibida.

-

Para log executar esse experimento, chame

mlflow.set_experiment()com o caminho do experimento. Para exibir o caminho do experimento, clique no ícone de informaçõesà direita do nome do experimento. Consulte execução de registros e modelos para um experimento para obter detalhes e um exemplo de Notebook.

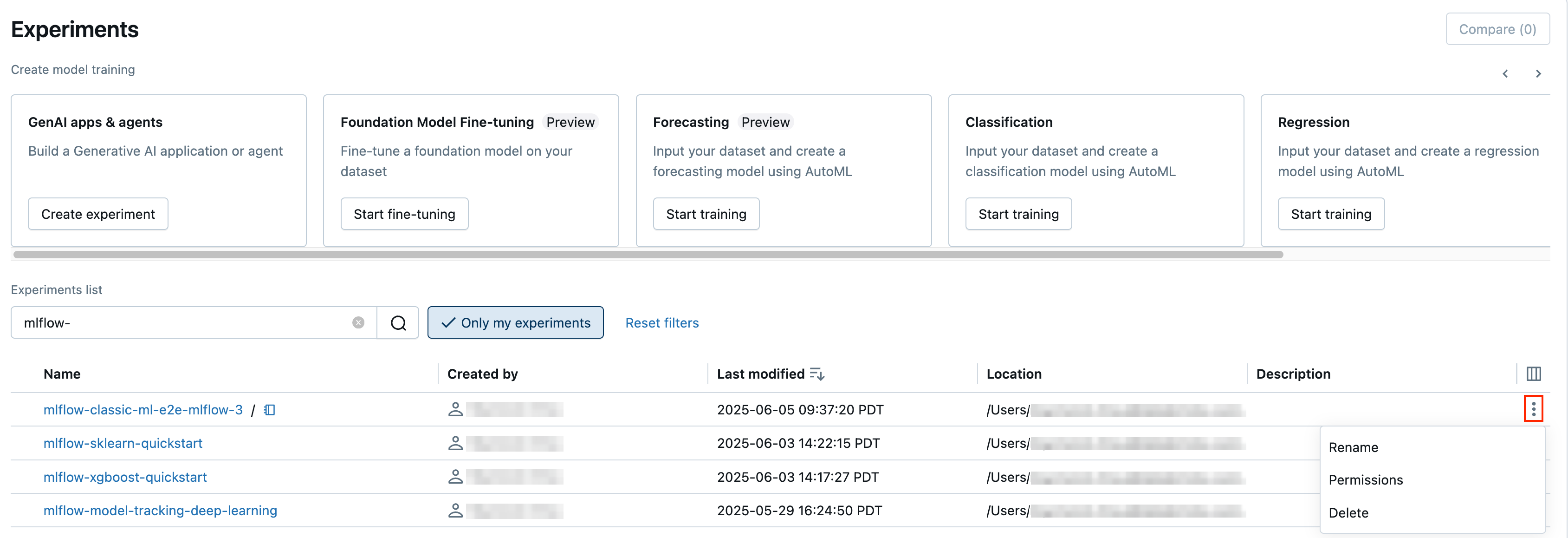

Crie um experimento na página Experimentos

Para criar um experimento de ajuste fino do modelo básico, AutoML ou personalizado, clique em Experiments (Exper imentos) ou selecione New > Experiment (Novo experimento ) na barra lateral esquerda.

Na parte superior da página, selecione uma das seguintes opções para configurar um experimento:

- Ajuste fino do modelo básico . A caixa de diálogo Foundation Model Fine-tuning é exibida. Para obter detalhes, consulte Criar uma execução de treinamento usando a UI de ajuste fino do Foundation Model.

- Previsão . A caixa de diálogo Configurar experimento de previsão é exibida. Para obter detalhes, consulte Configurar o experimento AutoML.

- Classificação . A caixa de diálogo Configurar experiência de classificação é exibida. Para obter detalhes, consulte Configurar experimento de classificação com a interface do usuário.

- Regressão. A caixa de diálogo Configurar experiência de classificação é exibida. Para obter detalhes, consulte Configurar experimento de regressão com a interface do usuário.

- Personalizado . A caixa de diálogo Create MLflow Experiment é exibida. Para obter detalhes, consulte a Etapa 4 em Criar experimento a partir do site workspace.

Criar experimento no Notebook

Quando o senhor usa o comando mlflow.começar() em um Notebook, a execução logs métricas e parâmetros para o experimento ativo. Se nenhum experimento estiver ativo, o site Databricks cria um experimento no Notebook. Um experimento de Notebook compartilha o mesmo nome e ID que seu Notebook correspondente. O ID do Notebook é o identificador numérico no final de um URL e ID doNotebook.

Os usuários que executam MLflow em compute com acesso de grupo dedicado devem verificar se o grupo tem permissão para gravar no diretório em que o Notebook reside ou usar mlflow.set_tracking_uri("<path>") para especificar uma pasta para gravação em MLflow.

Como alternativa, o senhor pode passar um caminho Databricks workspace para um Notebook existente em mlflow.set_experiment() para criar um experimento de Notebook para ele.

Para obter instruções sobre como registrar a execução nos experimentos do Notebook, consulte registrar a execução e os modelos em um experimento.

Se o senhor excluir uma experiência de Notebook usando o endereço API (por exemplo, MlflowClient.tracking.delete_experiment() em Python), o Notebook em si será movido para a pasta Lixeira.

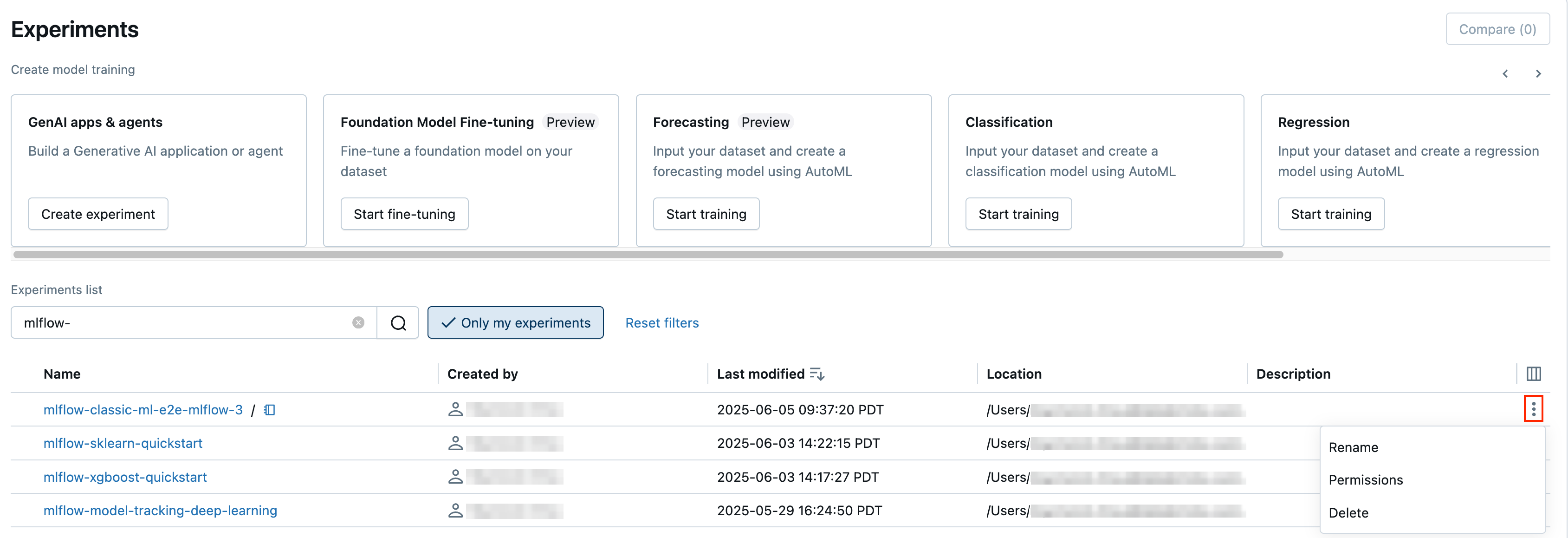

ver experimentos

Cada experimento ao qual você tem acesso aparece na página de experimentos. Nessa página, o senhor pode acessar view qualquer experimento. Clique no nome de um experimento para exibir a página de detalhes do experimento.

Outras formas de acessar a página de detalhes do experimento:

- O senhor pode acessar a página de detalhes de um experimento workspace no menu workspace.

- O senhor pode acessar a página de detalhes do experimento de um experimento do Notebook a partir do Notebook.

Para pesquisar experimentos, digite o texto no campo Filtrar experimentos e pressione Enter ou clique no ícone de lupa. A lista de experimentos muda para mostrar apenas os experimentos que contêm o texto de pesquisa nas colunas Nome ou Local .

Para uso avançado, você pode inserir uma consulta de pesquisa para tags.`mlflow.note.content` para pesquisar com base na coluna Descrição . Para mais detalhes sobre sintaxe, consulte Experimentos de pesquisa. Observe que, diferentemente da busca por Nome ou Local , a busca por tags exige que você construa manualmente a consulta de pesquisa com um identificador e um comparador. Ele não retornará diretamente todos os resultados que contêm o texto da pesquisa.

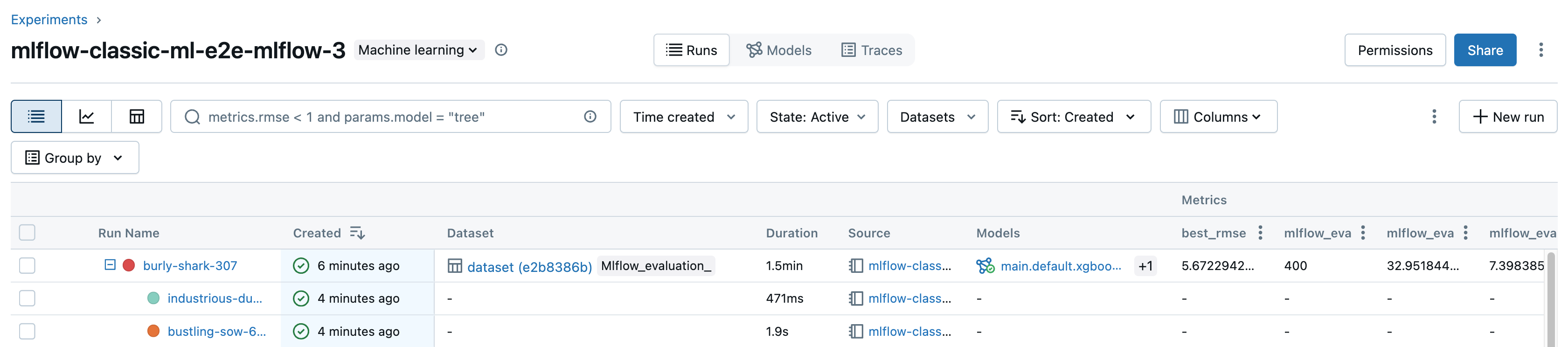

Clique no nome de qualquer experimento na tabela para exibir sua página de detalhes do experimento:

A página de detalhes do experimento lista todas as execuções associadas ao experimento. Na tabela, o senhor pode abrir a página de execução de qualquer execução associada ao experimento clicando no nome da execução. A coluna Fonte lhe dá acesso à versão do Notebook que criou a execução. O senhor também pode pesquisar e filtrar a execução por métricas ou configurações de parâmetros.

Veja o experimento workspace

- Clique em

workspace na barra lateral.

- Vá até a pasta que contém o experimento.

- Clique no nome do experimento.

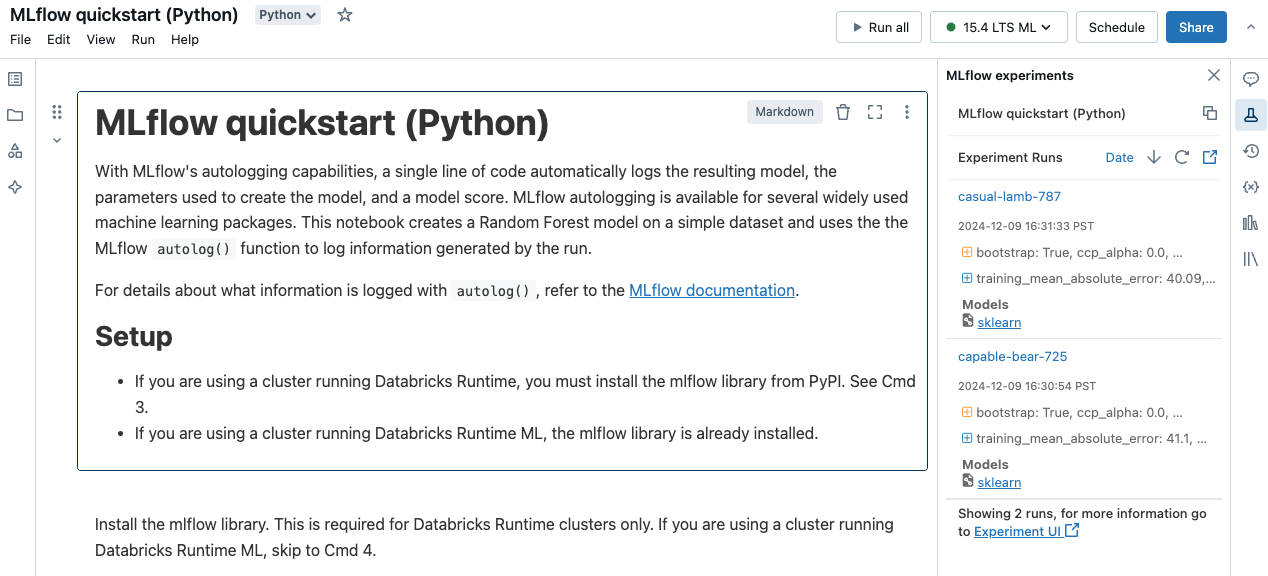

Exibir experimento do Notebook

Na barra lateral direita do Notebook, clique no ícone Experiment (Experiência ) .

A barra lateral de execução do experimento é exibida e mostra um resumo de cada execução associada ao experimento do Notebook, incluindo parâmetros e métricas de execução. Na parte superior da barra lateral está o nome do experimento no qual o Notebook registrou a execução mais recentemente (um experimento do Notebook ou um experimento do workspace ).

Na barra lateral, o senhor pode navegar para a página de detalhes do experimento ou diretamente para uma execução.

- Para view o experimento, clique em

na extrema direita, ao lado de Experiment execution (Execução do experimento ).

- Para exibir uma execução, clique no nome da execução.

gerenciar experimentos

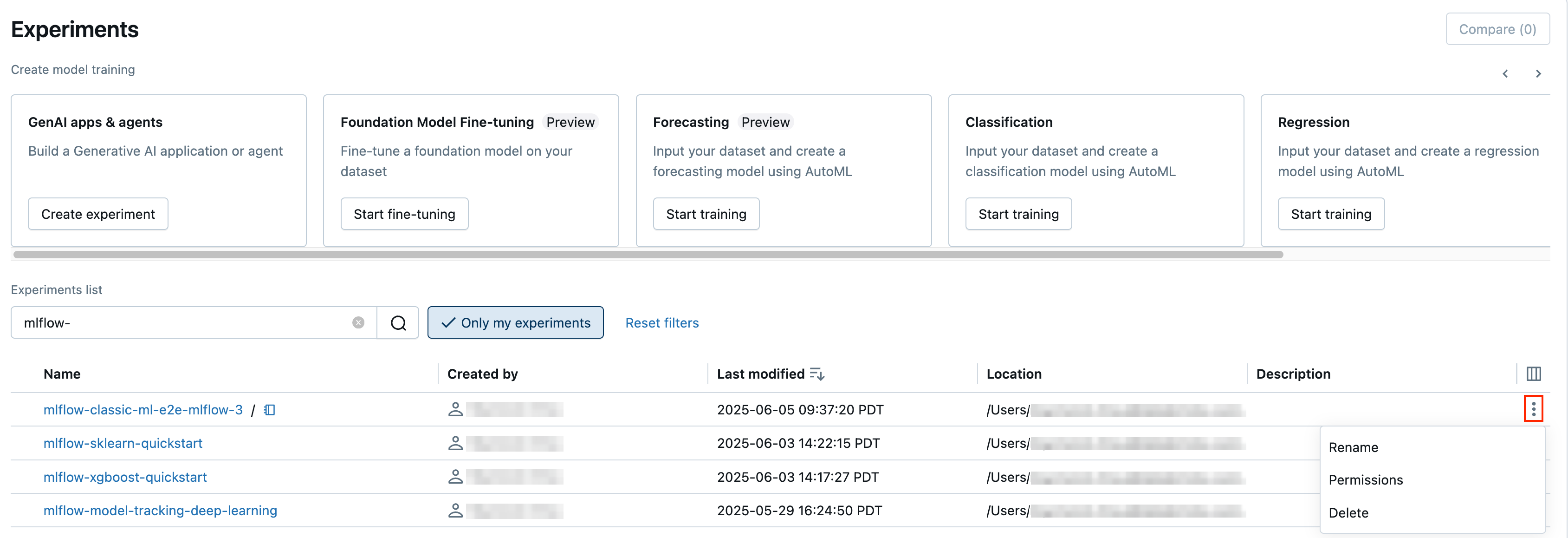

O senhor pode renomear, excluir ou gerenciar as permissões de um experimento de sua propriedade na página de experimentos, na página de detalhes do experimento ou no menu workspace.

O senhor não pode renomear, excluir ou gerenciar permissões diretamente em um experimento MLflow criado por um Notebook em uma pasta Databricks Git . O senhor deve executar essas ações no nível da pasta Git.

Renomear experimento

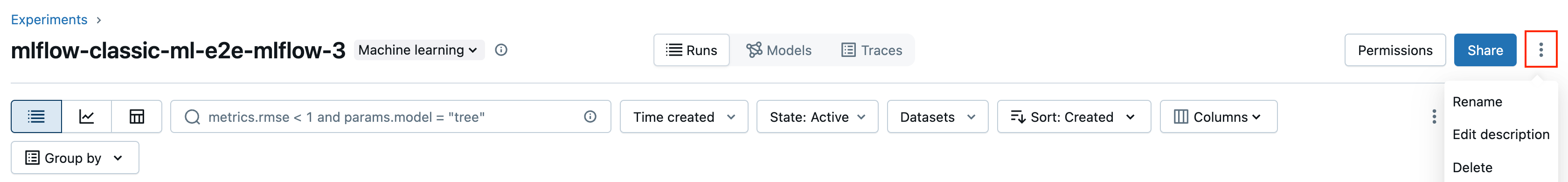

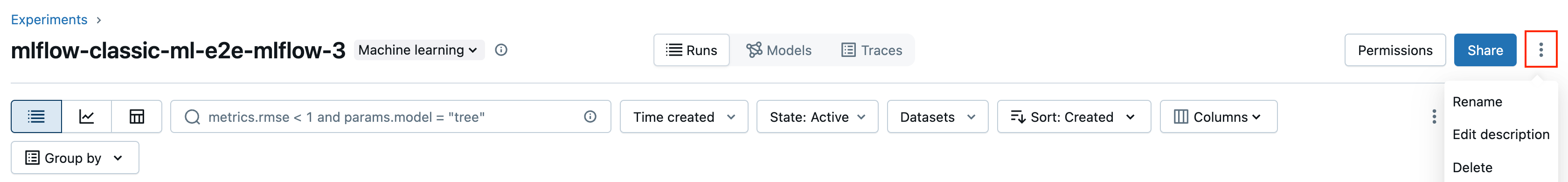

Você pode renomear um experimento que você possui na página Experimentos ou na página de detalhes do experimento desse experimento.

- Na página Experimentos, clique no menu de kebab

na coluna mais à direita e clique em Renomear.

- Na página de detalhes do experimento, clique no menu kebab

ao lado de Permissões e clique em Renomear.

O senhor pode renomear um experimento workspace no site workspace. Clique com o botão direito do mouse no nome do experimento e clique em Renomear .

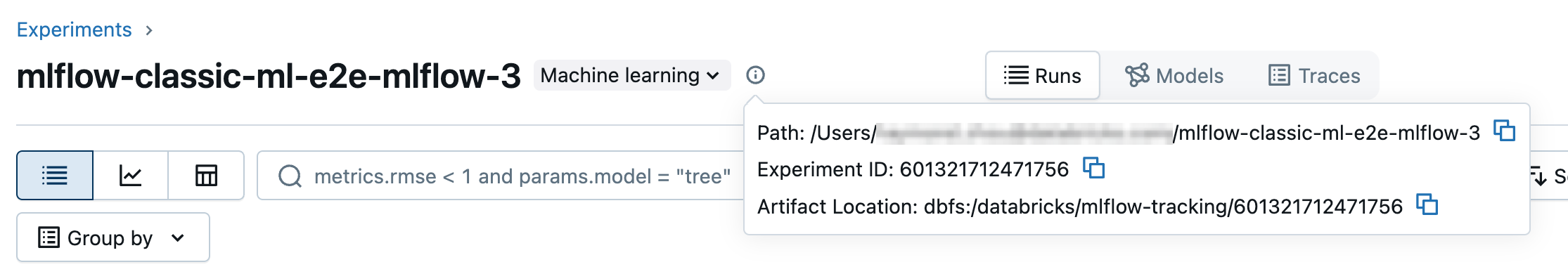

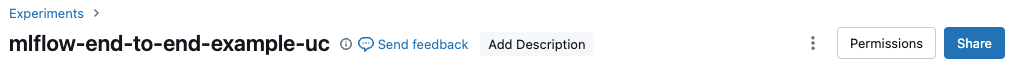

Obtenha o ID do experimento e o caminho para o experimento

Na página de detalhes do experimento, o senhor pode obter o caminho para um experimento do Notebook clicando no ícone de informações à direita do nome do experimento. Aparece uma nota pop-up que mostra o caminho até o experimento, o ID do experimento e a localização do artefato. O senhor pode usar o ID do experimento no comando MLflow

set_experiment para definir o experimento MLflow ativo.

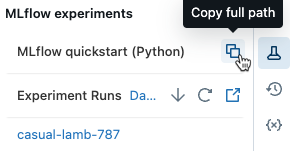

Em um Notebook, o senhor pode copiar o caminho completo do experimento clicando em na barra lateral de experimentos do Notebook.

Excluir experimento do Notebook

Notebook Os experimentos fazem parte do Notebook e não podem ser excluídos separadamente. Quando o senhor exclui um Notebook, o experimento do Notebook associado é excluído. Quando o senhor exclui um experimento de Notebook usando a interface do usuário, o Notebook também é excluído.

Para excluir experimentos do Notebook usando o site API, use o espaço de trabalho API para garantir que o Notebook e o experimento sejam excluídos do site workspace.

Excluir um experimento do workspace ou do Notebook

Você pode excluir um experimento que você possui da página de experimentos ou da página de detalhes do experimento.

Quando o senhor exclui um experimento do Notebook, o Notebook também é excluído.

- Na página Experimentos, clique no menu de kebab

na coluna mais à direita e clique em Excluir.

- Na página de detalhes do experimento, clique no menu de kebab

ao lado de Permissões e clique em Excluir.

O senhor pode excluir um experimento do site workspace do site workspace. Clique com o botão direito do mouse no nome do experimento e clique em Mover para a lixeira .

Alterar as permissões de um experimento

Para alterar as permissões de um experimento na página de detalhes do experimento, clique em Permissões .

Você pode alterar as permissões de um experimento que você possui na página Experimentos. Clique no menu kebab na coluna mais à direita e clique em Permissões.

Para obter informações sobre os níveis de permissão de experimentos, consulte MLflow experiment ACLs.

Copiar experimentos entre espaços de trabalho

Para migrar experimentos do MLflow entre espaços de trabalho, o senhor pode usar o projeto de código aberto orientado pela comunidade MLflow Export-Import.

Com essas ferramentas, você pode:

- Compartilhe e colabore com outros data scientists no mesmo ou em outro servidor de acompanhamento. Por exemplo, o senhor pode clonar um experimento de outro usuário para o seu workspace.

- Copie os experimentos e a execução do MLflow do seu servidor de acompanhamento local para o Databricks workspace.

- Faça backup de experimentos e modelos de missão crítica em outro site Databricks workspace.